基于激光雷达相机融合的3D检测是自动驾驶的一项关键任务。近年来,出现了许多激光雷达相机融合方法,并取得了良好的性能,但是这些方法始终缺乏精心设计和有效监督的融合过程

本文介绍了一种名为SupFusion的新训练策略,它为激光雷达相机融合提供了辅助特征级监督,并显著提高了检测性能。该方法包括Polar Sampling数据增强方法,用于加密稀疏目标并训练辅助模型生成高质量特征进行监督。这些特征用于训练激光雷达相机融合模型,优化融合特征以模拟生成高质量特征。此外,还提出了一种简单而有效的深度融合模块,与之前使用SupFusion策略的融合方法相比,该模块连续获得了优越的性能。本文的方法具有以下优点:首先,SupFusion引入了辅助特征级监督,可以在不增加额外推理成本的情况下提高激光雷达相机的检测性能。其次,所提出的深度融合可以不断提高检测器的能力。提出的SupFusion和深度融合模块是即插即用的,本文通过大量实验证明了它们的有效性。在基于多个激光雷达相机的3D检测KITTI基准测试中,取得了约2%的3D mAP改进!

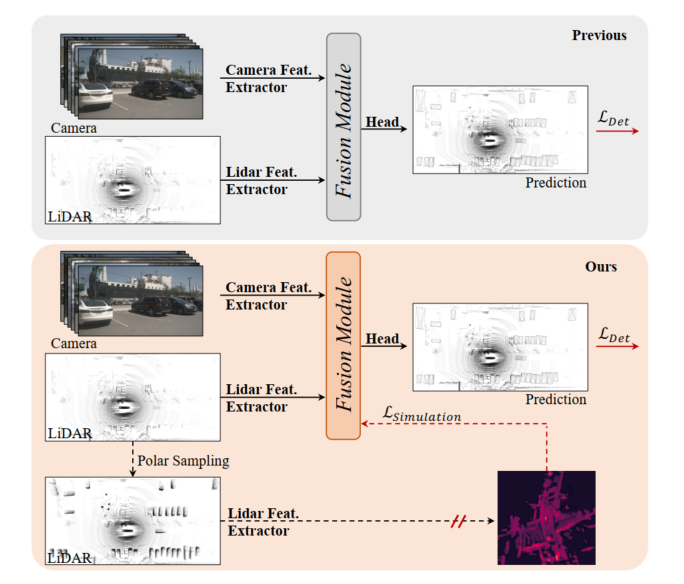

图1:顶部,以前的激光雷达相机3D检测模型,融合模块是通过检测loss进行优化的。底部:本文提出的SupFusion,通过辅助模型提供的高质量特征引入辅助监督。

基于激光雷达相机融合的3D检测是自动驾驶和机器人技术的一项关键且具有挑战性的任务,先前的方法总是通过内参和外参将相机输入投影到激光雷达BEV或体素空间,以对齐激光雷达和相机特征。然后,采用简单的级联或求和来获得用于最终检测的融合特征。此外,一些基于深度学习的融合方法获得了有希望的性能。然而,以往的融合方法总是通过检测损失直接优化3D/2D特征提取和融合模块,这在特征层面缺乏精心设计和有效的监督,限制了其性能。

近年来,蒸馏方式在用于3D检测的特征级监督方面显示出很大的改进。一些方法提供了激光雷达特征,以指导2D主干根据相机输入估计深度信息。此外,一些方法提供了激光雷达相机融合功能,以监督激光雷达主干从激光雷达输入中学习全局和上下文表示。通过模拟更稳健和高质量的特征引入特征级辅助监督,检测器可以促进边际改进。受此启发,处理激光雷达相机特征融合的自然解决方案是提供更强、高质量的特征,并为激光雷达相机3D检测引入辅助监督!

为了提高基于激光雷达相机的融合3D检测性能,本文提出了一种名为SupFusion的监督式激光雷达相机融合方法。该方法通过生成高质量的特征,并为融合和特征提取过程提供有效的监督来实现。首先,我们训练一个辅助模型,以提供高质量的功能。与以往利用较大模型或额外数据的方法不同,我们提出了一种新的数据增强方法,称为Polar Sampling。Polar Sampling可以从稀疏的激光雷达数据中动态增强目标的密度,从而更容易检测并提高特征质量,例如准确的检测结果。然后,我们简单地训练基于激光雷达相机融合的检测器,并引入辅助特征级监督。在这一步中,我们将原始激光雷达和相机输入输入到3D/2D主干和融合模块中,以获得融合特征。融合特征被馈送到检测头中用于最终预测,同时辅助监督将融合特征模拟为高质量特征。这些特征是通过预训练的辅助模型和增强的激光雷达数据获得的。通过这种方式,所提出的特征级监督可以使融合模块生成更稳健的特征,并进一步提高检测性能。为了更好地融合激光雷达和相机的特征,我们提出了一种简单而有效的深度融合模块,该模块由堆叠的MLP块和动态融合块组成。SupFusion可以充分挖掘深度融合模块的能力,并不断提高探测精度!

本文的主要贡献:

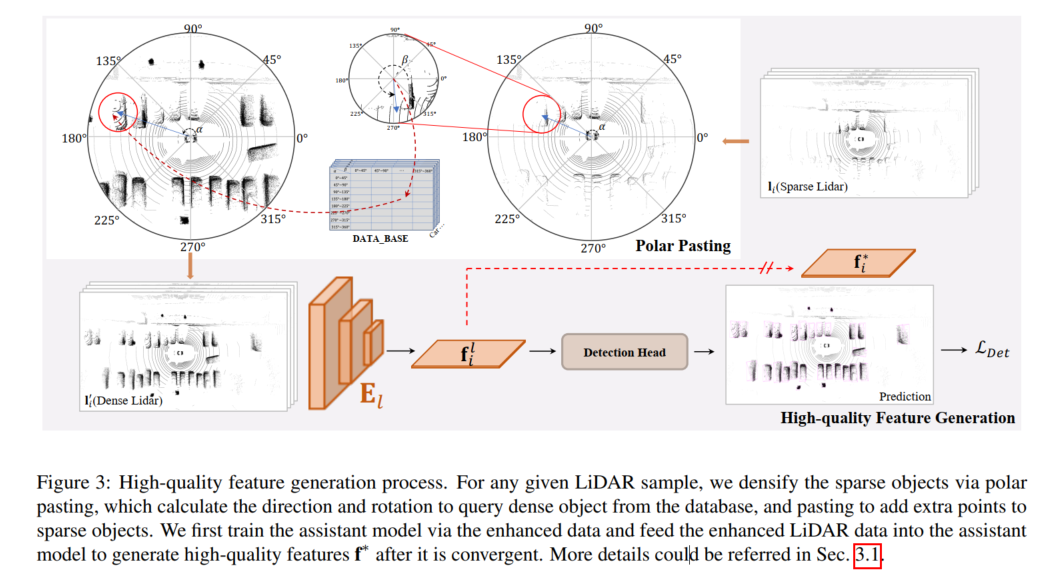

高品質的特徵產生過程如下圖所示,對於任何給定的LiDAR樣本,透過polar pasting貼上來加密稀疏目標,極軸polar pasting計算方向和旋轉以從資料庫中查詢密集目標,並透過pasting為稀疏目標添加額外的點。本文首先透過增強的資料訓練輔助模型,並將增強的雷射雷達資料饋送到輔助模型中,以在其收斂後產生高品質特徵f*。

為了在SupFusion中提供特徵級監督,採用了一個輔助模型來從增強的數據中捕捉高品質的特徵,如圖3所示。首先,訓練一個輔助模型來提供高品質的特徵。對於D中的任何樣本,透過polar pasting來增強稀疏的雷射雷達數據,以獲得增強的數據,該極性粘貼通過極性分組中生成的添加點集來加密備用目標。然後,在輔助模型收斂之後,將增強的樣本輸入到優化的輔助模型中,以捕捉高品質特徵,用於訓練雷射雷達相機3D檢測模型。為了更好地應用於給定的光達相機檢測器並更容易實現,這裡簡單地採用光達分支探測器作為輔助模型!

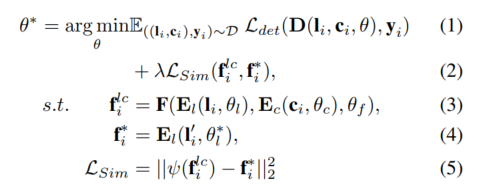

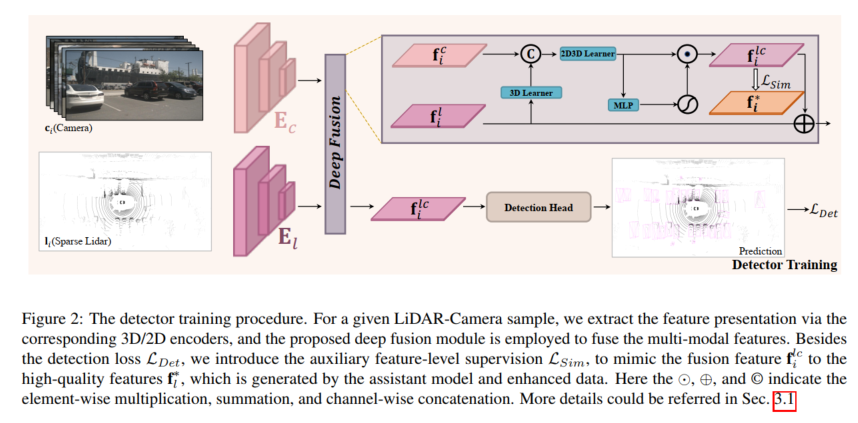

對於任何給定的雷射雷達相機偵測器,在特徵層級使用所提出的輔助監督來訓練模型。給定樣本,的情況下,首先將光達和相機輸入到3D和2D編碼器和中,以捕獲相應的特徵和,這些特徵被輸入到融合模型中以產生融合特徵,並流到檢測頭中進行最終預測。此外,採用所提出的輔助監督來模擬具有高品質特徵的融合特徵,該特徵是由預先訓練的輔助模型和增強的雷射雷達資料產生的。上述過程可以公式化為:

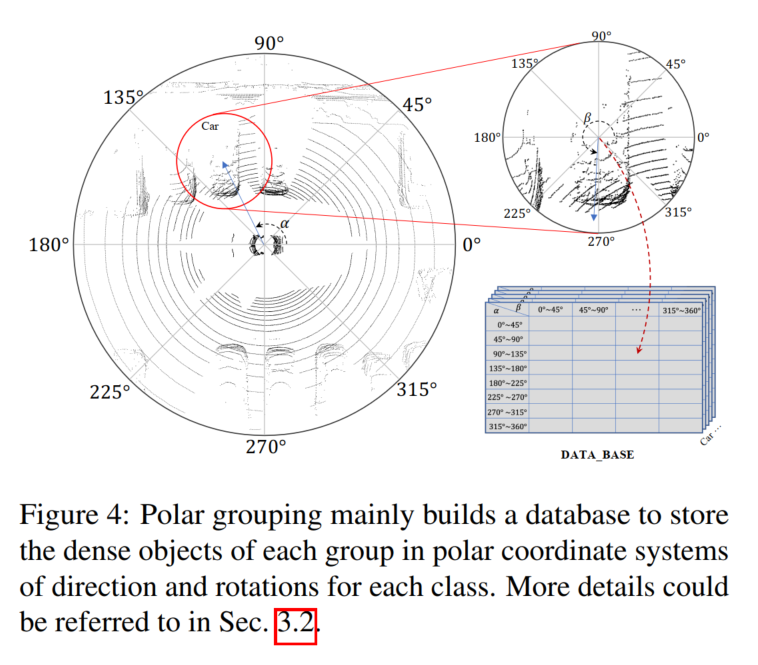

為了提供高品質的特徵,本文在提出的SupFusion中引入了一種名為Polar Sampling的新的資料增強方法,以解決稀疏問題,該問題經常導致檢測失敗。為此,我們對雷射雷達資料中的稀疏目標進行了密集處理,類似於密集目標的處理方式。極坐標採樣由兩個部分組成,即極坐標分組和極坐標粘貼。在極座標分組中,我們主要建立了一個資料庫來儲存密集目標,該資料庫用於極座標粘貼,從而使稀疏目標變得更加密集

考慮到雷射雷達感測器的特性,收集到的點雲資料自然存在特定的密度分佈。例如,物體在表面上有更多的點朝向光達感測器,而在相對兩側的點很少。密度分佈主要受方向和旋轉的影響,而點的密度主要取決於距離。離光達感測器更近的物體具有更密集的點。受此啟發,本文的目標是根據稀疏目標的方向和旋轉,將長距離的稀疏目標與短距離的密集目標進行密度化,以保持密度分佈。我們基於場景中心和特定目標為整個場景以及目標建立極坐標系,並將雷射雷達感測器的正方向定義為0度,以測量相應的方向和旋轉。然後,我們收集具有相似密度分佈(例如,具有相似方向和旋轉)的目標,並為極性分組中的每組生成一個密集目標,並在極坐標粘貼中使用它來密集稀疏目標

如圖4所示,這裡建構了一個資料庫B,根據極性分組中的方向和旋轉來儲存產生的密集物點集l,在圖4中記為α和β!

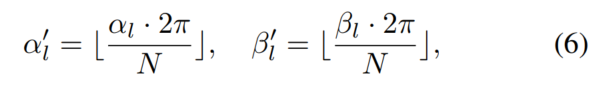

首先,搜尋整個資料集,透過位置計算所有目標的極角,並在基準中提供旋轉。其次,根據目標的極角將它們分成幾組。手動將方向和旋轉劃分為N組,對於任何目標點集l,都可以根據索引將其放入相應的組中:

如圖2所示,利用Polar Pasting來增強稀疏的雷射雷達數據,以訓練輔助模型並產生高質量特徵。給定LiDAR樣本,,,,包含個目標,對於任何目標,都可以計算與分組過程相同的方向和旋轉,並根據標籤和索引從B查詢密集目標,這可以從E.q.6中獲得增強樣本中的所有目標並獲得增強的數據。

為了模擬增強雷射雷達資料產生的高品質特徵,融合模型旨在從相機輸入中豐富的顏色和上下文特徵中提取稀疏目標的缺失資訊。為此,本文提出了深度融合模組,以利用影像特徵並完成光達演示。所提出的深度融合主要由3D學習器和2D-3D學習器組成。 3D學習器是一個簡單的捲積層,用於將3D呈現轉移到2D空間。然後,連接2D特徵和3D呈現(例如,在2D空間中),2D-3D學習器被用來融合LiDAR相機特徵。最後,透過MLP和激活函數對融合特徵進行了加權,將其添加回原始雷射雷達特徵作為深度融合模組的輸出。 2D-3D學習器由深度為K的堆疊MLP塊組成,學習利用相機特徵來完成稀疏目標的雷射雷達表示,以模擬密集雷射雷達目標的高品質特徵。

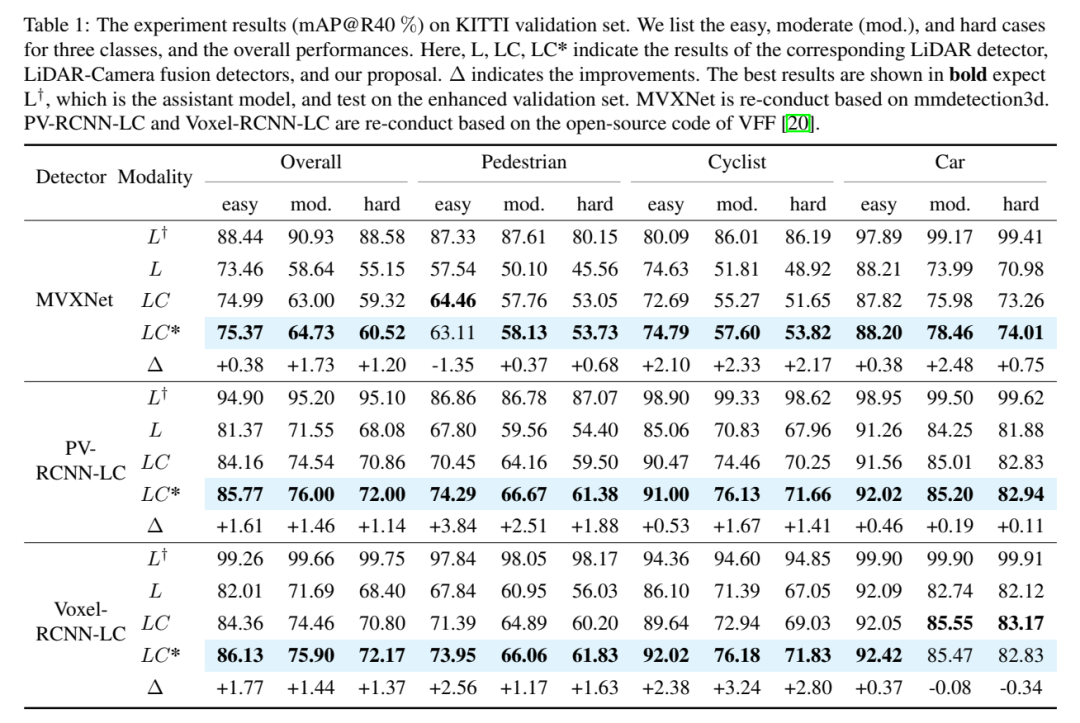

實驗結果(mAP@R40%)。這裡列出了三個類別的簡單、中等(mod.)和困難情況,以及整體表現。這裡L、LC、LC*表示對應的光達偵測器、光達相機融合偵測器和本文提案的結果。 ∆表示改進。最佳結果以粗體顯示,預期L†是輔助模型,並在增強驗證集上進行測試。 MVXNet是基於mmdetection3d重新進行的。 PV-RCNN-LC和Voxel RCNN LC是基於VFF的開源程式碼重新進行的。

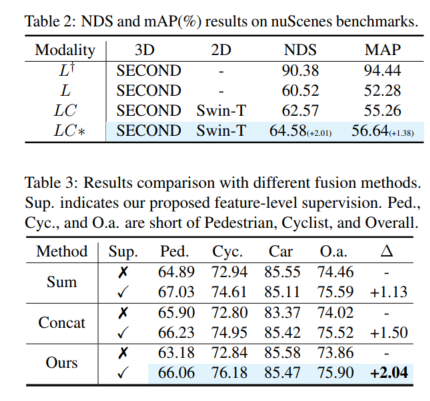

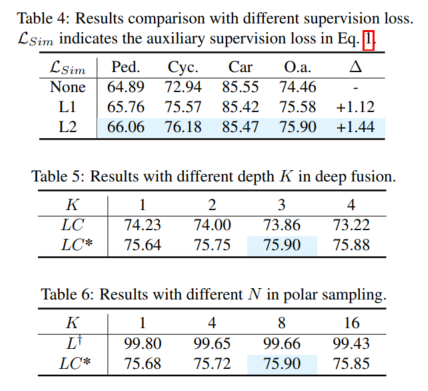

重寫後的內容:整體效能。根據表1的比較結果,3DmAP@R40基於三個偵測器的比較顯示了各個類別和每個難度劃分的整體表現。可以明顯觀察到,透過引入額外的相機輸入,光達相機方法(LC)在性能上優於基於光達的偵測器(L)。透過引入極性採樣,輔助模型(L†)在增強的驗證集上表現出令人欽佩的性能(例如超過90%的mAP)。借助具有高品質特徵的輔助監督和提出的深度融合模組,我們的提案不斷提高檢測精度。例如,與基線(LC)模型相比,我們的提案在中度和難度目標上分別獲得了 1.54%和 1.24%的3D mAP改進。此外,我們也對基於SECOND-LC的nuScenes基準進行了實驗,如表2所示,NDS和mAP分別提高了2.01%和1.38%

class感知改進分析。與基準模型相比,SupFusion和深度融合不僅可以提高整體性能,還可以提高包括Pedestrian在內的每個類別的檢測性能,比較三個類別的平均改善(例如中等情況),可以獲得以下觀察結果:騎自行車的人獲得最大的改善( 2.41%),而行人和汽車分別獲得1.35%和0.86%的改善。原因很明顯:(1) 與行人和騎自行車的人相比,汽車更容易被發現,並獲得最佳效果,因此更難改進。 (2) 與行人相比,騎自行車的人獲得了更多的改進,因為行人是非網格的,生成的密集目標與騎自行車的相比不那麼好,因此獲得的性能改進較低!

請點擊以下連結查看原文內容:https://mp.weixin.qq.com/s/vWew2p9TrnzK256y-A4UFw

以上是SupFusion:探索如何有效監督Lidar-Camera融合的3D偵測網路?的詳細內容。更多資訊請關注PHP中文網其他相關文章!