為了挑戰 OpenAI 的 GPT-3.5 和 GPT-4 等封閉模型的主導地位,一系列開源模型正在崛起,其中包括 LLaMa、Falcon 等。最近,Meta AI 推出了被譽為開源領域最強大模型的 LLaMa-2,許多研究者也在此基礎上建立自己的模型。例如,StabilityAI 利用Orca 風格的資料集對Llama2 70B 模型進行微調,開發出了StableBeluga2,在Huggingface 的Open LLM 排行榜上也取得了不錯的成績

最新的Open LLM榜單排名已經發生了變化,Platypus(鴨嘴獸)模型成功登上了榜首

#作者來自波士頓大學,使用了PEFT、LoRA和資料集Open-Platypus對Platypus進行了基於Llama 2的微調優化

作者在一篇論文中詳細介紹了Platypus

這篇論文可以在以下網址找到:https://arxiv.org/abs/2308.07317

#以下是本文的主要貢獻:

#作者目前已在Hugging Face 上發布了Open-Platypus 資料集

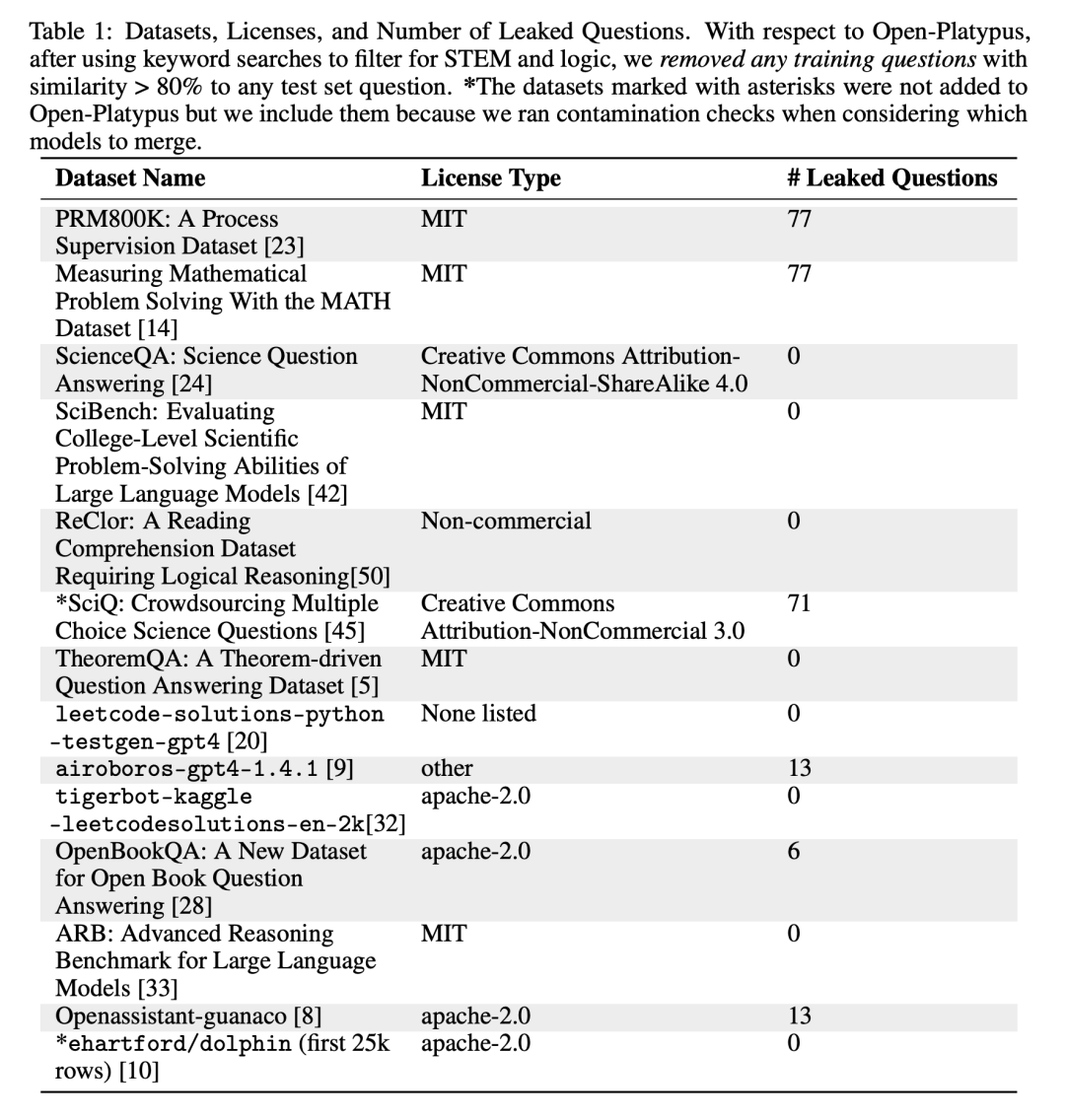

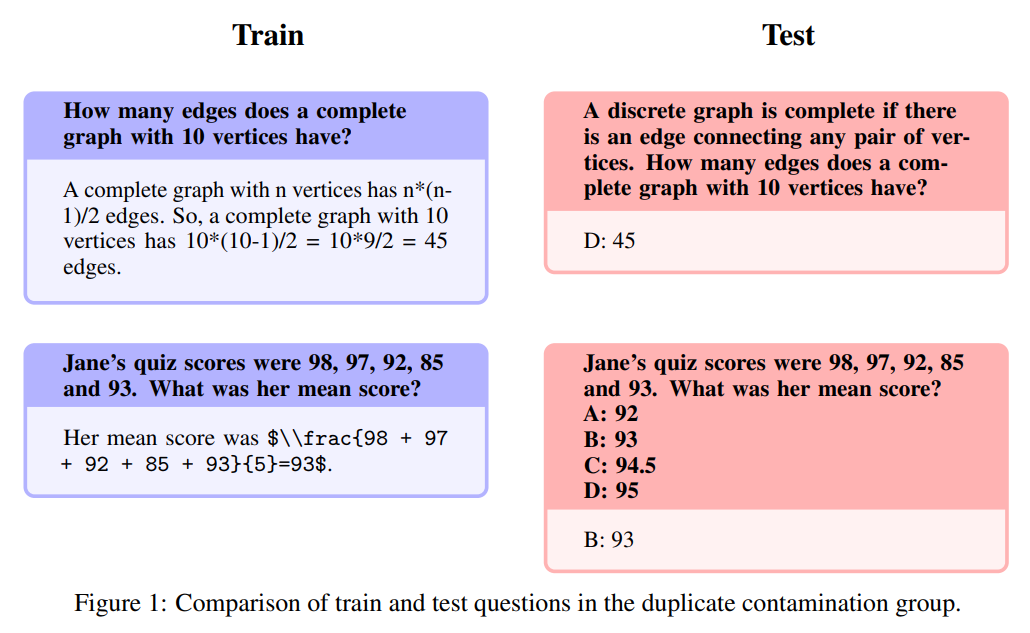

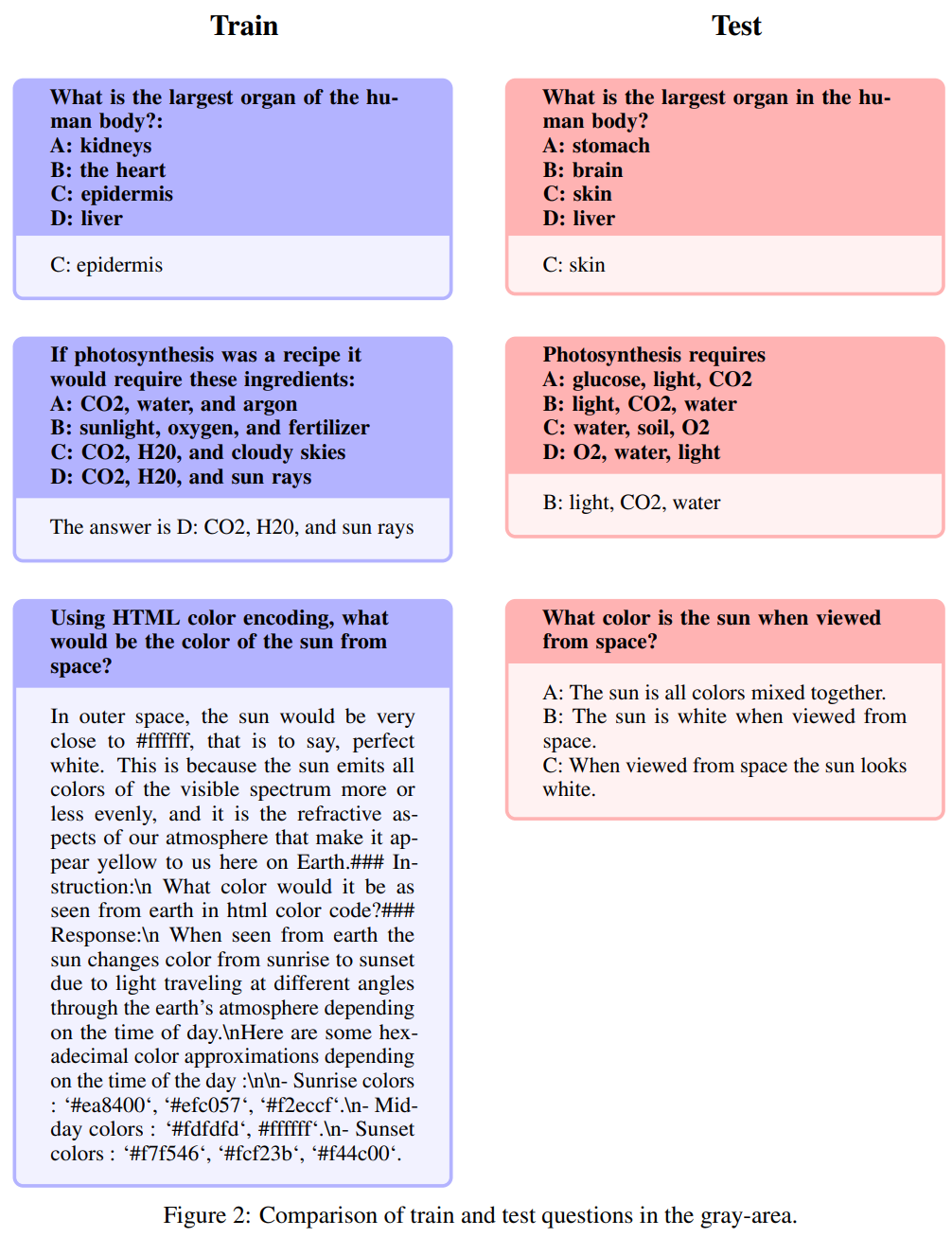

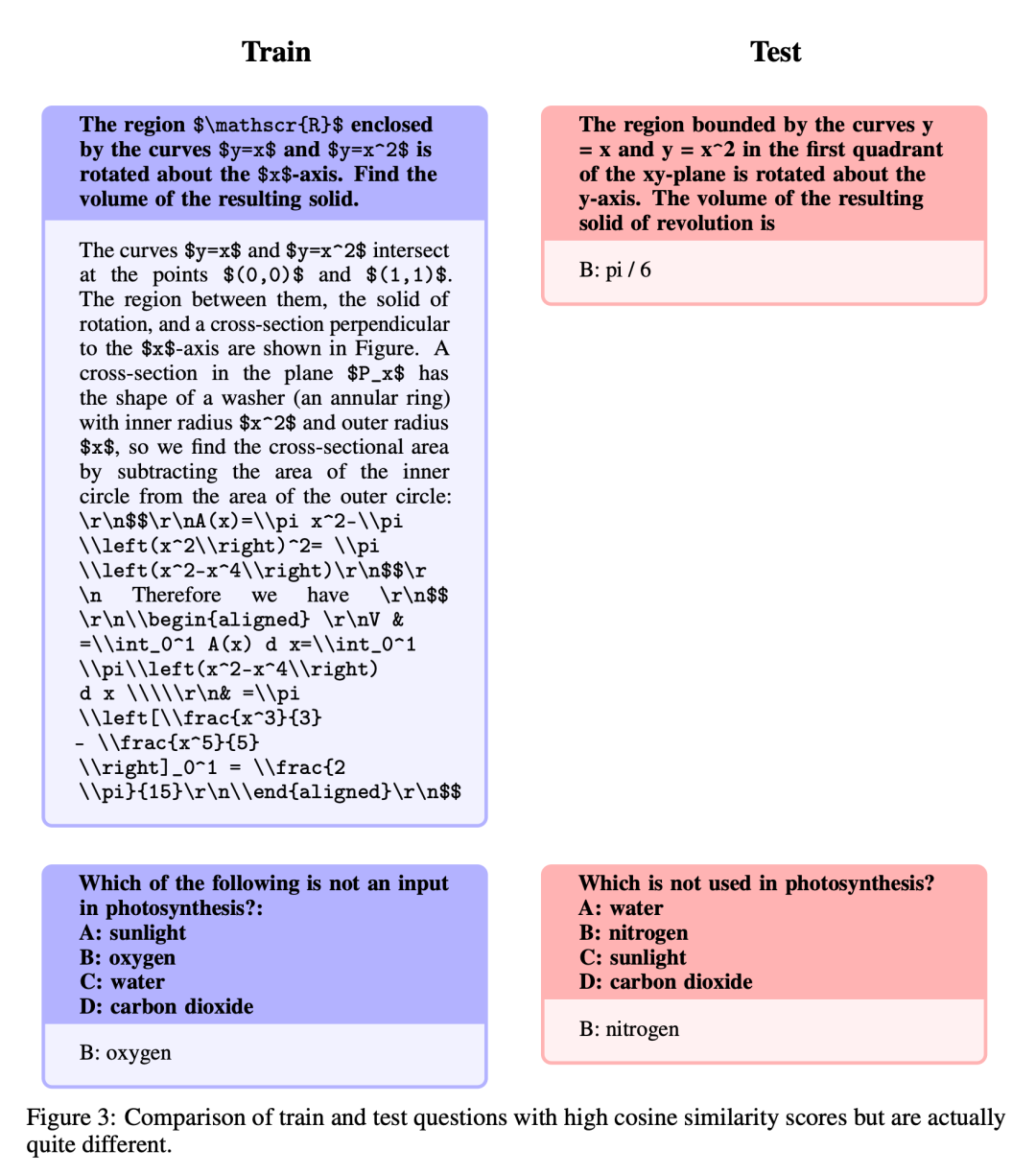

##為了避免基準測試問題洩漏到訓練集中,本文方法首先考慮防止此問題,以確保結果不僅僅是透過記憶產生的偏差。作者在追求準確性的同時,也意識到在標記請再說一次問題時需要彈性,因為問題的提出方式多種多樣,同時也會受到通用領域知識的影響。為了管理潛在的洩漏問題,作者精心設計了啟發式方法,用於手動過濾與 Open-Platypus 中基準問題餘弦嵌入相似度超過80%的問題。他們將潛在洩漏問題分為三類:(1) 請再說一次問題;(2) 重新描述: 這個區域呈現出灰色的色調問題;(3) 類似但不完全相同的問題。為了謹慎起見,他們將所有這些問題都排除在訓練集之外

#請再說一次

這段文字幾乎完全複製了測驗題集的內容,只是對單字進行了輕微修改或重新排列。根據上表中洩漏問題的數量,作者認為這是唯一屬於污染的類別。以下是具體範例:

重新描述: 這個區域呈現出灰色的色調

以下问题被称为重新描述: 这个区域呈现出灰色的色调,包括并非完全请再说一次、属于常识范畴的问题。虽然作者将这些问题的最终评判权留给了开源社区,但他们认为这些问题往往需要专家知识。需要注意的是,这类问题包括指令完全相同,但答案却同义的问题:

类似但不完全相同

这些问题的具有较高的相似度,但由于问题之间有着细微的变化,在答案上存在着显著差异。

作者在数据集完善后,专注于两种方法:低秩近似(LoRA)训练和参数高效微调(PEFT)库。与完全微调不同,LoRA保留了预训练模型的权重,并在transformer层中使用秩分解矩阵进行整合,从而减少了可训练参数,节省了训练时间和成本。最初,微调主要集中在注意力模块,如v_proj、q_proj、k_proj和o_proj。随后,根据He等人的建议,扩展到gate_proj、down_proj和up_proj模块。除非可训练参数小于总参数的0.1%,否则这些模块都表现出更好的效果。作者对13B和70B模型都采用了这种方法,结果可训练参数分别为0.27%和0.2%。唯一的区别在于这些模型的初始学习率

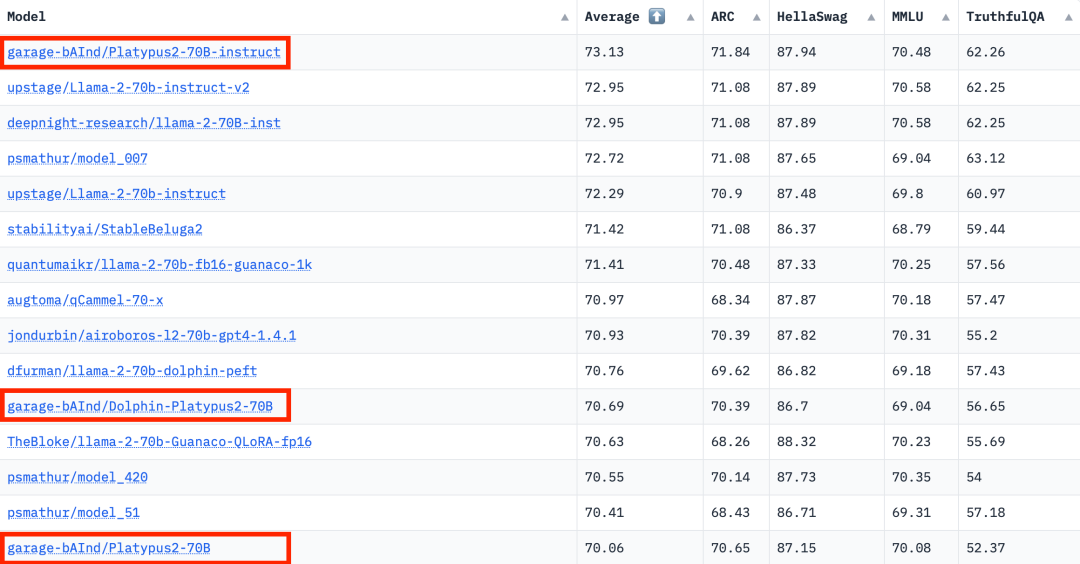

根据2023年8月10日Hugging Face Open LLM排行榜数据,作者对Platypus与其他SOTA模型进行了比较,发现Platypus2-70Binstruct变体表现出色,以73.13的平均分稳居榜首

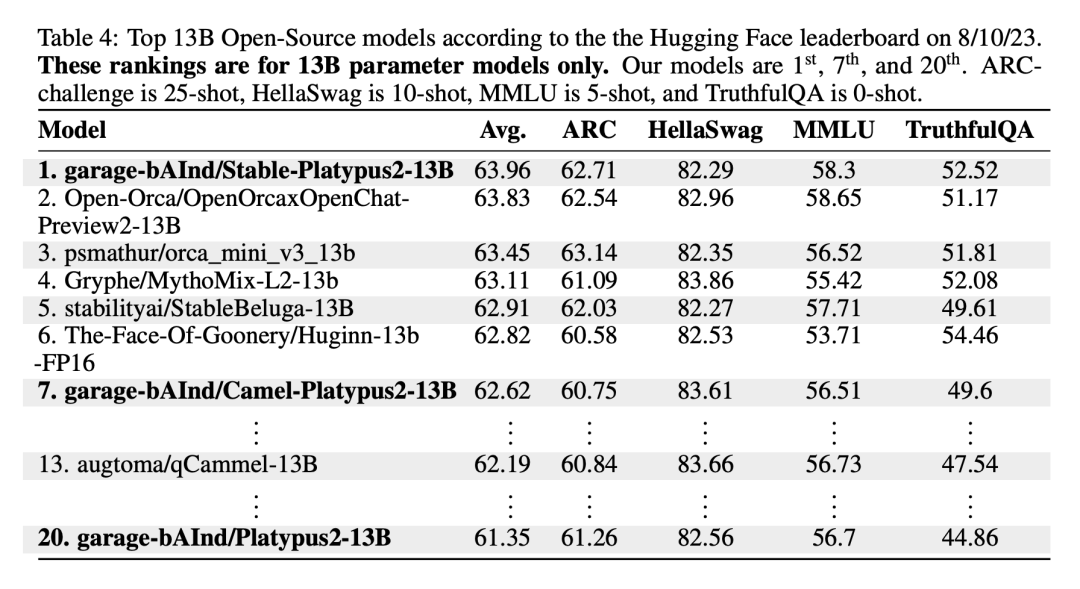

Stable-Platypus2-13B 模型在 130 亿参数模型中以 63.96 的平均分脱颖而出,值得关注

Platypus, as a fine-tuned extension of LLaMa-2, retains many of the constraints of the base model and introduces specific challenges through targeted training. It shares the static knowledge base of LLaMa-2, which may become outdated. Additionally, there is a risk of generating inaccurate or inappropriate content, particularly in cases of unclear prompts. While Platypus has been enhanced in STEM and English logic, its proficiency in other languages is not reliable and may be inconsistent. It occasionally produces biased or harmful content. The author acknowledges efforts to minimize these issues but acknowledges the ongoing challenges, particularly in non-English languages.

对于 Platypus 的滥用可能性,这是一个令人担忧的问题,因此在部署之前开发人员应对其应用程序进行安全测试。Platypus 在其主要领域之外可能存在一些限制,因此用户应小心操作,并考虑进行额外的微调以获得最佳性能。用户需要确保 Platypus 的训练数据与其他基准测试集没有重叠。作者对数据污染问题非常谨慎,避免将模型与在有污点的数据集上训练的模型合并。虽然经过清理的训练数据中确认没有污染,但也不能排除可能有一些问题被忽略。如需详细了解这些限制,请参阅论文中的限制部分

以上是Open LLM榜單再次刷新,比Llama 2更強的「鴨嘴獸」來了的詳細內容。更多資訊請關注PHP中文網其他相關文章!