出品|搜狐科技

作者|鄭松毅

#6月9日,2023智源人工智慧大會在北京舉辦。法國當地時間凌晨四點,被譽為「世界深度學習三巨頭」之一的楊立昆(Yann LeCun)在法國視訊連線北京現場,發表了主題為《走向能夠學習、推理和規劃的大模型》的演講,表達了對於人工智慧的深度思考。

搜狐科技在智源大會現場觀看了這場演講,從楊立昆演講時面露微笑的表情中,可以感受到楊立昆對於人工智慧發展的積極樂觀態度。先前在馬斯克等人聯名簽署聯名信提出人工智慧發展將為人類文明帶來風險時,楊立昆曾公開反駁,認為人工智慧尚未發展到對人類構成嚴重威脅的程度。演講中,楊立昆再次強調人工智慧是可控的,他表示,「恐懼是由對潛在負面結果的預期引起的,而興高采烈是由對積極結果的預測產生的,像這樣由目標驅動的系統,我將之稱為'目標驅動的人工智慧',它會是可控的,因為我們可以透過成本函數為它設定目標,確保這些系統不會想要接管世界,相反,它會屈從於人類和安全。」

楊立昆表示,人工智慧距離人類和動物的能力差距在於邏輯推理和規劃,這是智慧的重要特徵,現在的大模型只能「本能反應」。

「如果你用一萬億或兩萬億個token來訓練它們,機器的性能是驚人的,但最終機器會犯事實錯誤、邏輯錯誤,它們的推理能力是有限的。」

楊立昆強調,基於自我監督的語言模式無法獲得關於真實世界的知識。他認為,與人類和動物相比,機器的學習能力並不是很好。幾十年來,研發系統的方式都是在用監督學習,但監督學習需要太多標籤,學習任何東西都需要進行大量的嘗試,強化學習的結果卻不盡人意,這些系統是脆弱的,會犯愚鈍和錯誤,並不會真正地推理和計劃。

「就像我們在演講時,如何從一個觀點表達到另一個觀點,怎麼解釋事物,大腦裡是有計劃的,而不是一字一句的即興發揮。也許在低層次上,我們在即興發揮,但在高層次上,我們一定是在規劃。所以規劃的必要性是非常明顯的。我的預測是,在相對短的幾年內,理智的人肯定不會再使用自回歸元素(自監督學習方法中的模型之一)。這些系統很快就會被放棄,因為它們是無法修復的。」

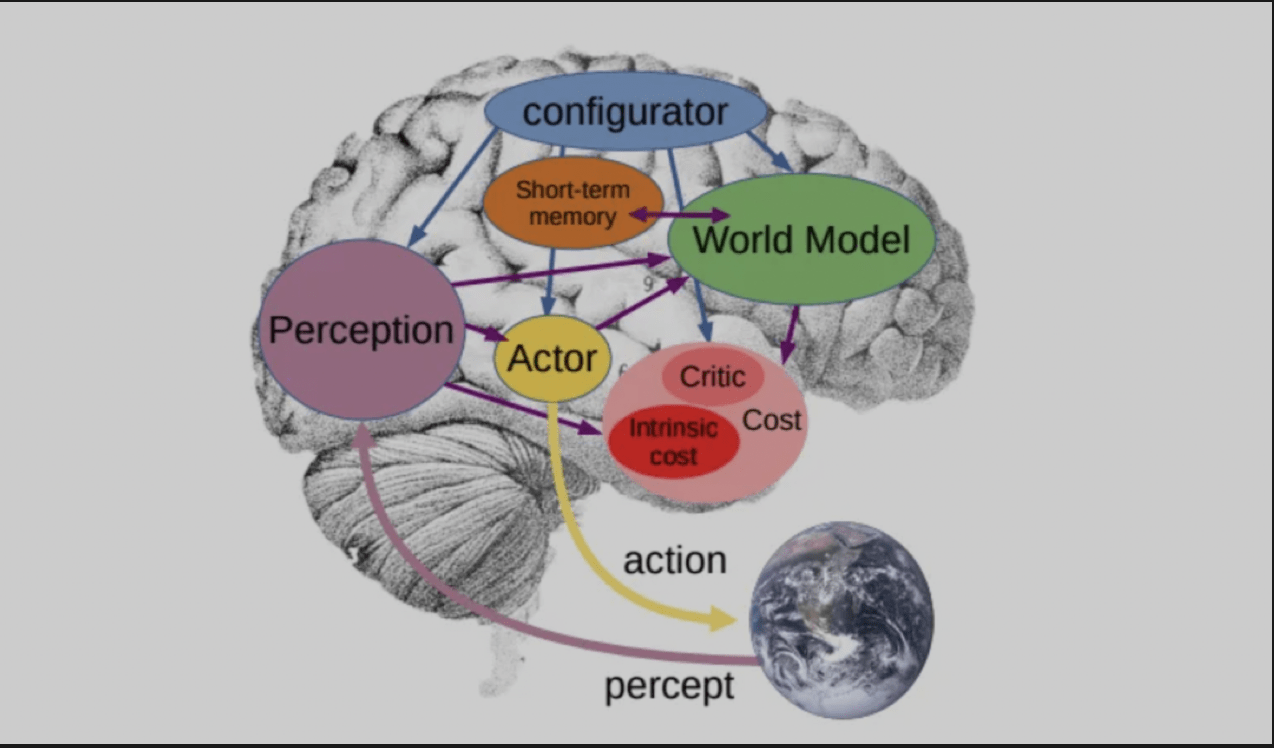

他表示,為了讓語言模型真正理解真實世界的知識,需要一個新的架構來取代,而這個架構就是他在一年前所發表的論文中提出的架構,「自主智能(Autonomous Intelligence) 」。這是由一個配置模組控制整個系統,基於輸入訊息,進行預測、推理、決策的架構。其中的「世界模組」具備估計缺失資訊、預測未來外界狀態的能力。

談到未來幾年AI將面臨的挑戰,楊立昆指出三個方面,其一是學習世界的表徵和預測模型;其二是學習推理,即學習如何有意識、有目的地運用思維去完成任務;最後一個挑戰是如何透過將複雜任務分解成簡單任務,以分層的方式運作來規劃複雜的行動序列。

談到這裡,楊立昆介紹了他發表在論文中的另一個模型“世界模型(World Model)”,該模型可以想像一個場景,並根據場景預測行動結果。目的是找出一系列根據自己的世界模型預測的行動,並最小化一系列成本的行動序列。

當楊立昆在提問環節被問及有關即將參與的一場關於AGI的地位和未來的辯論時,他表示這場辯論將圍繞一個問題展開,即人工智慧系統是否會對人類構成生存風險。 Max Tegmark 和 Yoshua Bengio 將站在「會」的一邊,認為強大的 AI 系統可能對人類構成存在風險。而楊立昆和 Melanie Mitchell 將站在「不」的一邊。

「我們的觀點不是說沒有風險,而是說這些風險雖然存在,但很容易透過精心設計來減輕或抑制。」

楊立昆認為,超智慧系統尚未被研發出來,待其被發明後,再討論「是否能使超智慧系統對人類安全」也來得及。

以上是圖靈獎得主楊立昆:AI的邏輯推理和規劃能力有限,會犯下事實錯誤和邏輯錯誤的詳細內容。更多資訊請關注PHP中文網其他相關文章!