DeepMind新AI登上Nature才一天,GPT-4就來打擂台了!

只透過兩段提示,GPT-4就給出了和AlphaDev如出一轍的排序演算法最佳化方法。

DeepMind稱AlphaDev為“重新創造AlphaGo的神奇”,因其發現了一種可加速排序演算法達70%的方法。

哦豁,這下AlphaDev更尷尬了。

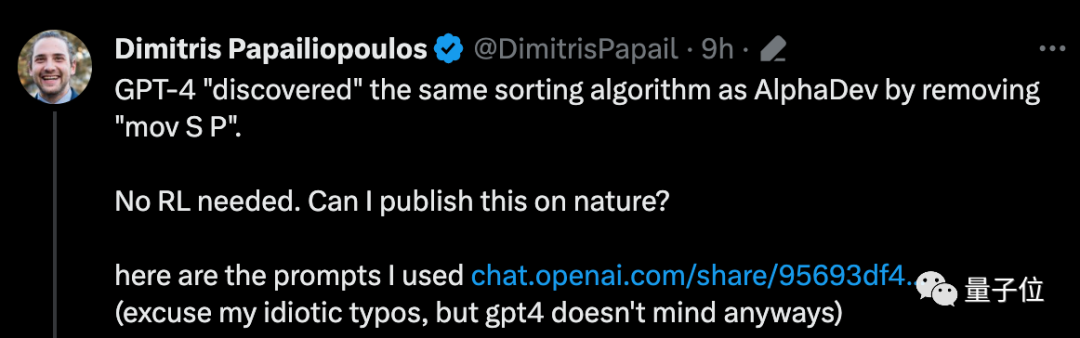

讓GPT-4「發現」同樣操作的老哥直接陰陽:

#完全不需要強化學習。我能將這個發現登在Nature上嗎?

馬斯克“路過看到”,也留下了句“因吹斯聽”。

所以GPT-4怎麼做到的?

帶來這個新發現的是一位來自威斯康辛大學麥迪遜分校的副教授,名叫Dimitris Papailiopoulos(下面簡稱D教授)。

他讓GPT-4實現這一操作的步驟非常簡單,總共就輸入了兩個提示。

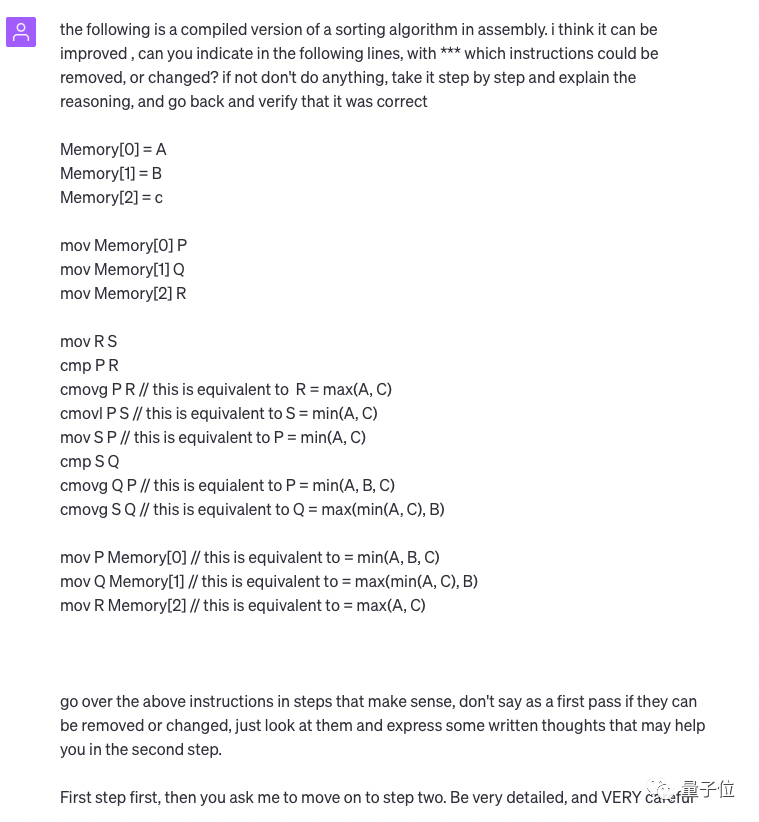

首先,他和GPT-4說:

這有一段排序演算法,我覺得它還能進一步優化。請問需要重寫哪一句話呢? 。一步一步解釋原因,然後回去驗證它是對的。

第一步的時候他還強調說,如果有什麼新發現,先不要做改變,只是“看著”就好,寫出來一些書面改進建議。

要非常詳細、非常小心。

然後GPT-4對給出的程式碼做出了詳細解釋。

然後D教授給了第二個提示:

##繼續。如果你有很大的把握,請按照上面的提示去做。設定溫度為0以確保產生結果確定和一致,並盡量避免混淆。

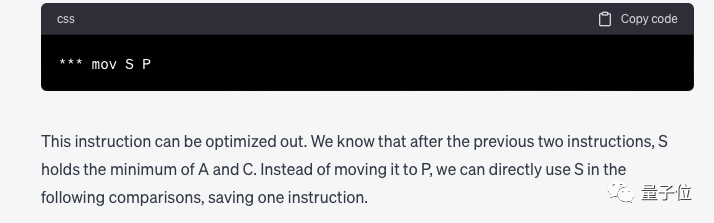

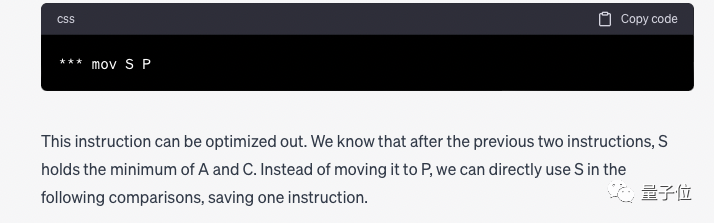

我們發現指令「mov S P」多餘可以去掉,其他指令都是必要的。但刪除之後,應將P替換成S。

據介紹,AlphaDev是一種強化學習演算法、基於AlphaZero打造,它的發現並非基於現有演算法,而是從最底層的彙編指令開始摸索的。

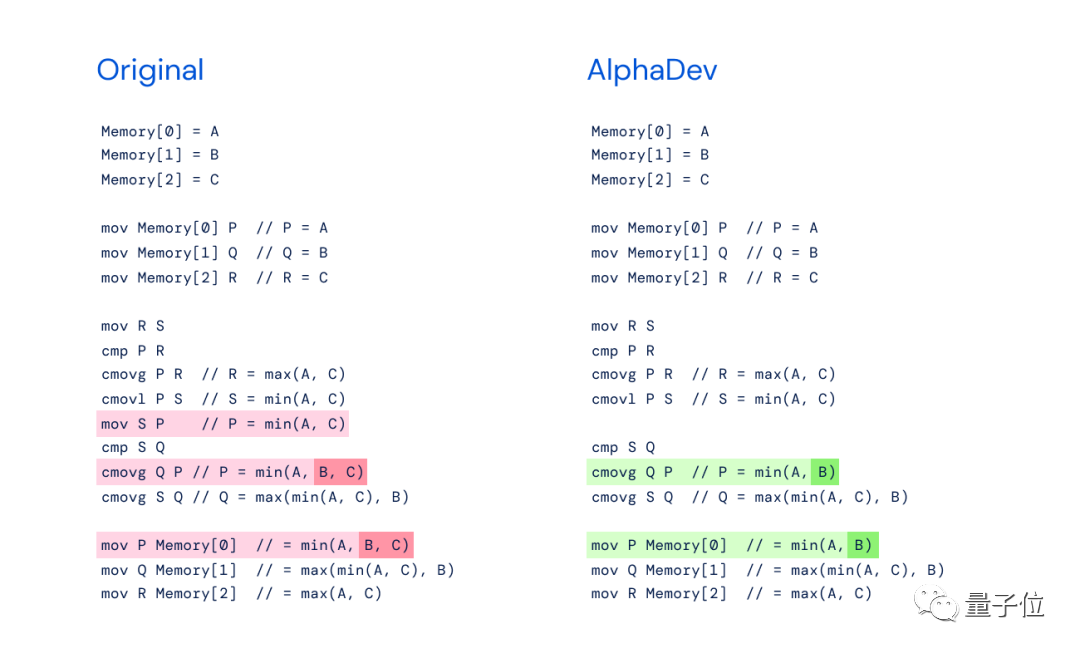

它的創新主要在於兩個指令序列:

(1)AlphaDev Swap Move(交換移動)

(2)AlphaDev Copy Move(複製移動)

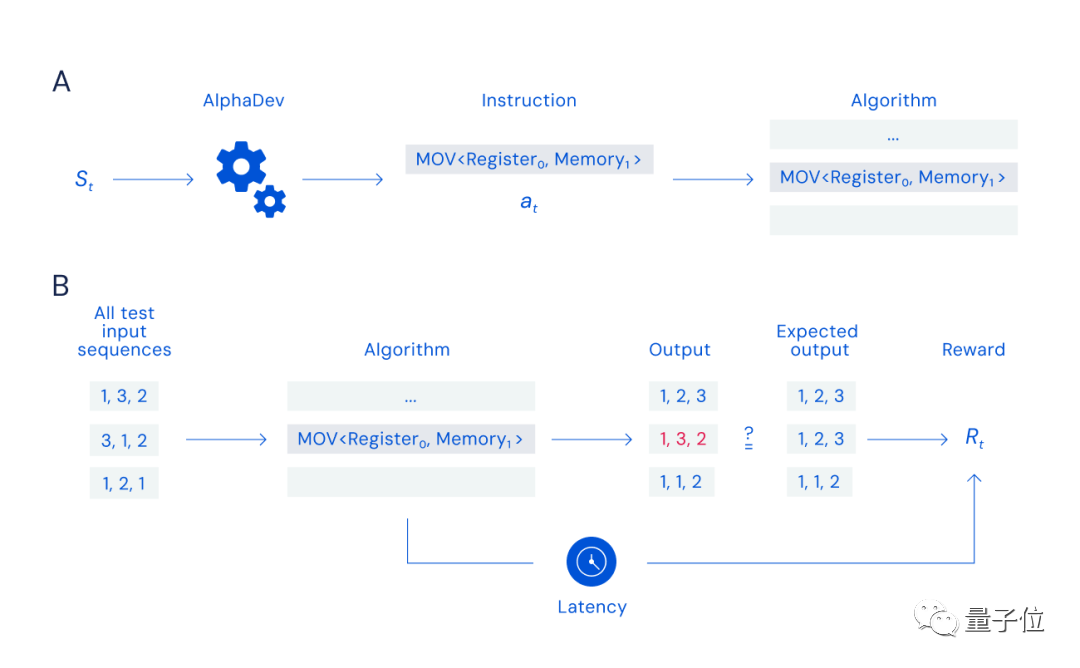

原理上,DeepMind的研究員給它設計了一個單人「組裝」遊戲:

只要能夠搜尋並選擇出合適的指令(下圖A流程),正確且快速地排好數據(下圖B流程),就能獲得獎勵。

但這個遊戲的挑戰不僅在於搜尋空間的大小(可組合指令數相當於宇宙中的粒子數),也在於獎勵函數的性質,因為一條錯誤指令就可能會使整個演算法失效。

對於GPT-4的“騷操作”,有人表示:即便是資深開發者也低估GPT-4了。

有人感慨說,D教授的操作進一步驗證,只要有耐心、懂得提示工程,GPT-4能做到的事還有很多。

也有人提出質疑,表示GPT-4能這麼做會不會是因為它的訓練資料中包含了一些排序演算法的最佳化方法?

不過話說回來,之所以這件事能夠引起這麼大的關注和討論,很大一部分原因是AlphaDev登上Nature存在爭議。

不少人覺得這也不是什麼開創性的研究,DeepMind誇大其詞。

不僅是D教授陰陽說“我是不是也能登Nature”,還有網友說自己十幾歲的時候優化了快排,這也應該發論文的。

當然也有人認為,AlphaDev本身的創新點更在於,它是利用強化學習來發現新演算法的。

你覺得呢?

參考連結:[1]https://chat.openai.com/share/95693df4-36cd-4241-9cae-2173e8fb760c[2]https://twitter.com/DimitrisPapail/status/16668439528241684. ##

以上是GPT-4把DeepMind整尷尬了:你登上Nature的排序優化演算法,我兩段話就找出來了的詳細內容。更多資訊請關注PHP中文網其他相關文章!