影片在當今社群媒體和網路文化中扮演著愈發重要的角色,抖音,快手,B 站等已經成為數以億計用戶的熱門平台。用戶圍繞影片分享自己的生活點滴、創意作品、有趣時刻等內容,與他人互動和交流。

近期,大語言模型展現了令人矚目的能力。我們能否給大模型裝上 “眼睛” 和 “耳朵”,讓它能夠理解視頻,陪著用戶互動呢?

從這個問題出發,達摩院的研究人員提出了 Video-LLaMA,一個具有綜合視聽能力大模型。 Video-LLaMA 能夠感知和理解視訊中的視訊和音訊訊號, 並能理解使用者輸入的指令,完成一系列基於音訊視訊的複雜任務,例如音 / 視訊描述,寫作,問答等。目前論文,代碼,交互 demo 都已開放。另外,在 Video-LLaMA 的專案首頁中,研究團隊也提供了中文版本的模型,讓中文使用者的體驗更絲滑。

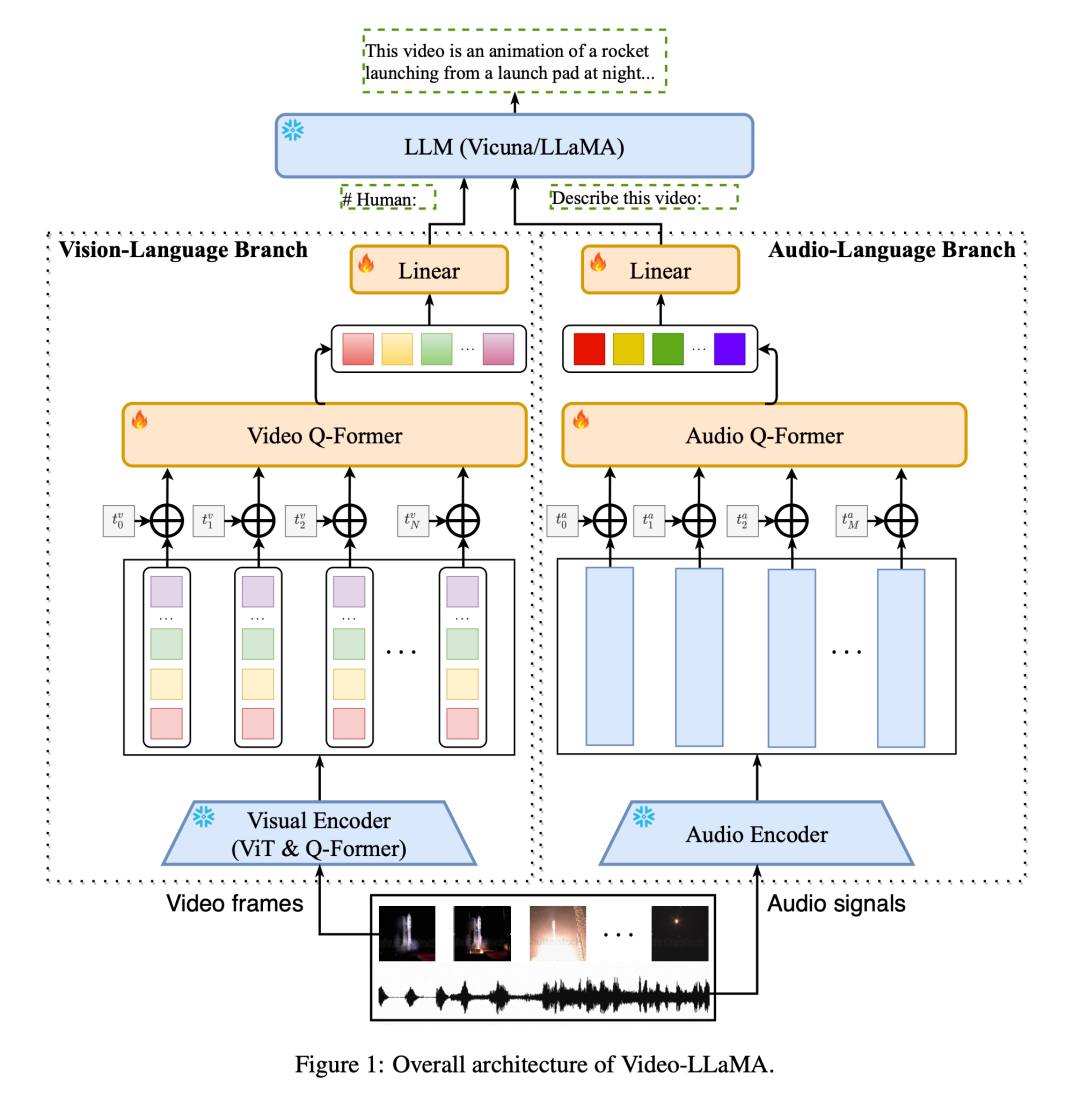

#Video-LLaMA 採用了模組化設計原則,將影片中的視覺和音訊模態資訊會對應到大語言模型的輸入空間中,以實現跨模態指令跟隨的能力。與先前專注於靜態影像理解的大模型研究(MiNIGPT4,LLaVA)不同,Video-LLaMA 面臨著視訊理解中的兩個挑戰:捕捉視覺中的動態場景變化和整合視聽訊號。

為了捕捉影片中的動態場景變化,Video-LLaMA 引入了一個可插拔的視覺語言分支。此分支首先使用BLIP-2 中預先訓練好的圖片編碼器得到每一幀影像的單獨特徵,再與對應的幀位置嵌入結合後,所有影像特徵被送入Video Q-Former,Video Q-Former 將聚合幀級別的影像表示並且產生定長的綜合視訊表徵。最後採用一個線性層將視訊表徵對齊到大語言模型的 embedding 空間。

至於視訊中的聲音訊號,Video-LLaMA 使用音訊 - 語言分支進行處理。首先從原始影片中均勻取樣多個長達兩秒的音訊片段,並將每個片段轉換為 128 維的梅爾頻譜圖。然後,採用強大的 ImageBind 作為音訊編碼器,單獨提取每個聲音片段的特徵。在添加可學習的位置嵌入後,Audio Q-Former 將片段特徵進行整體聚合,並產生固定長度的音訊特徵。與視覺語言分支類似,最後採用線性層將音訊表徵對齊到大語言模型的 embedding 空間。

為了減少訓練成本,Video-LLaMA 凍結了預先訓練好的圖片/ 音訊編碼器,只更新了視覺和音訊分支中的以下參數:Video/Audio Q-Former ,位置編碼層以及線性層(如圖1 所示)。

為了學習視覺和文字的對齊關係,作者們首先利用大規模的影片 - 文字資料集 (WebVid-2M) 和圖像 - 文字資料集(CC-595K)對視覺分支進行預訓練。之後,作者們利用來自 MiniGPT-4,LLaVA 的圖像指令資料集和來自 Video-Chat 的視訊指令資料集來微調,從而達到更好的跨模態指令跟隨能力。

至於音訊 - 文字對齊關係的學習,由於缺乏大規模高品質的音訊 - 文字數據,作者們採用了一種變通策略來達到這一目標。首先,音訊 - 語言分支中可學習參數的目標可以理解為將音訊編碼器的輸出與 LLM 的嵌入空間對齊。而音訊編碼器 ImageBind 具有非常強的多模態對齊能力,它能將不同模態的嵌入對齊到一個共同的空間。因此,作者們使用視覺 - 文字資料來訓練音訊 - 語言分支,將 ImageBind 的公共嵌入空間對齊到 LLM 的文字嵌入空間,從而實現音訊模態到 LLM 文字嵌入空間對齊。透過這種巧妙的方式,Video-LLaMA 能在推理過程中展現出理解音訊的能力,即使從未接受過音訊資料的訓練。

作者展示了 Video-LLaMA 基於視訊 / 音訊 / 影像的對話的一些範例。

(1)下面兩個例子展示了 Video-LLaMA 的視聽綜合感知能力,例子中的會話圍繞著有聲視訊。在例子二中,畫面上僅僅顯示了這個演奏家,但是聲音中是觀眾的歡呼聲和掌聲,如果模型只能接受視覺信號,將無法推測到觀眾的積極響應,音頻中並沒有樂器的聲音,但畫面中出現了薩克斯,如果模型僅能接受聽覺訊號,也將無法得知演奏家演奏了薩克斯風。

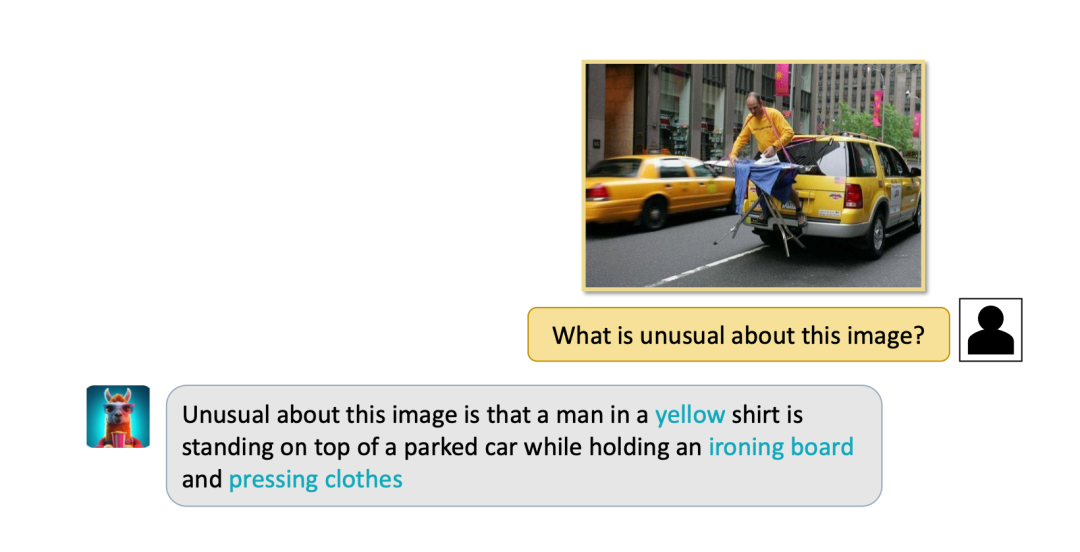

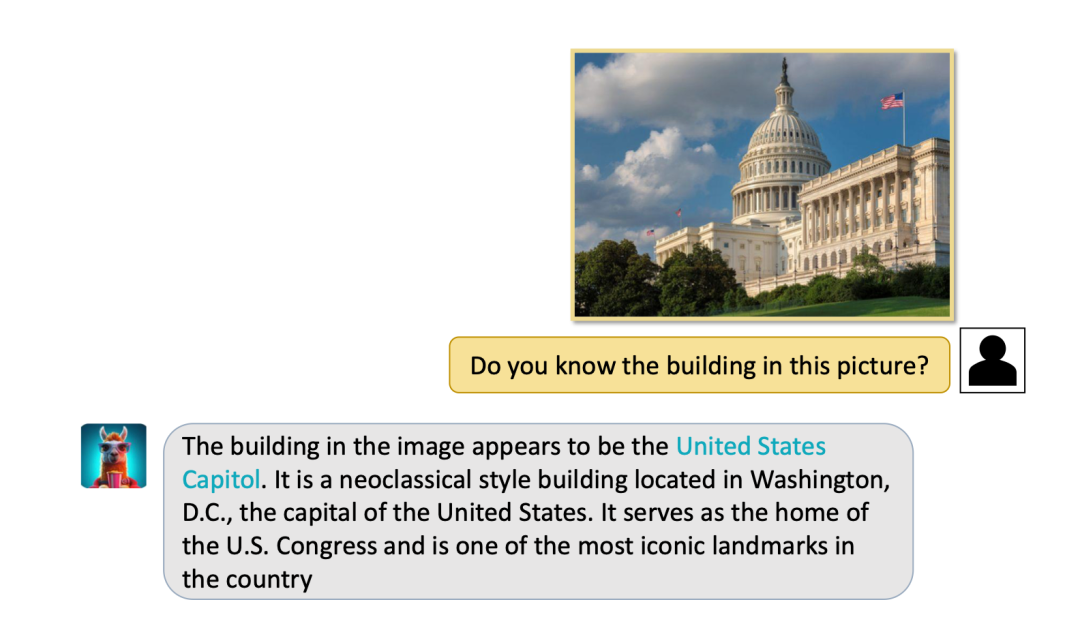

(2)Video-LLaMA 對於靜態影像也有較強的感知理解能力,可以完成圖片描述,問答等任務。

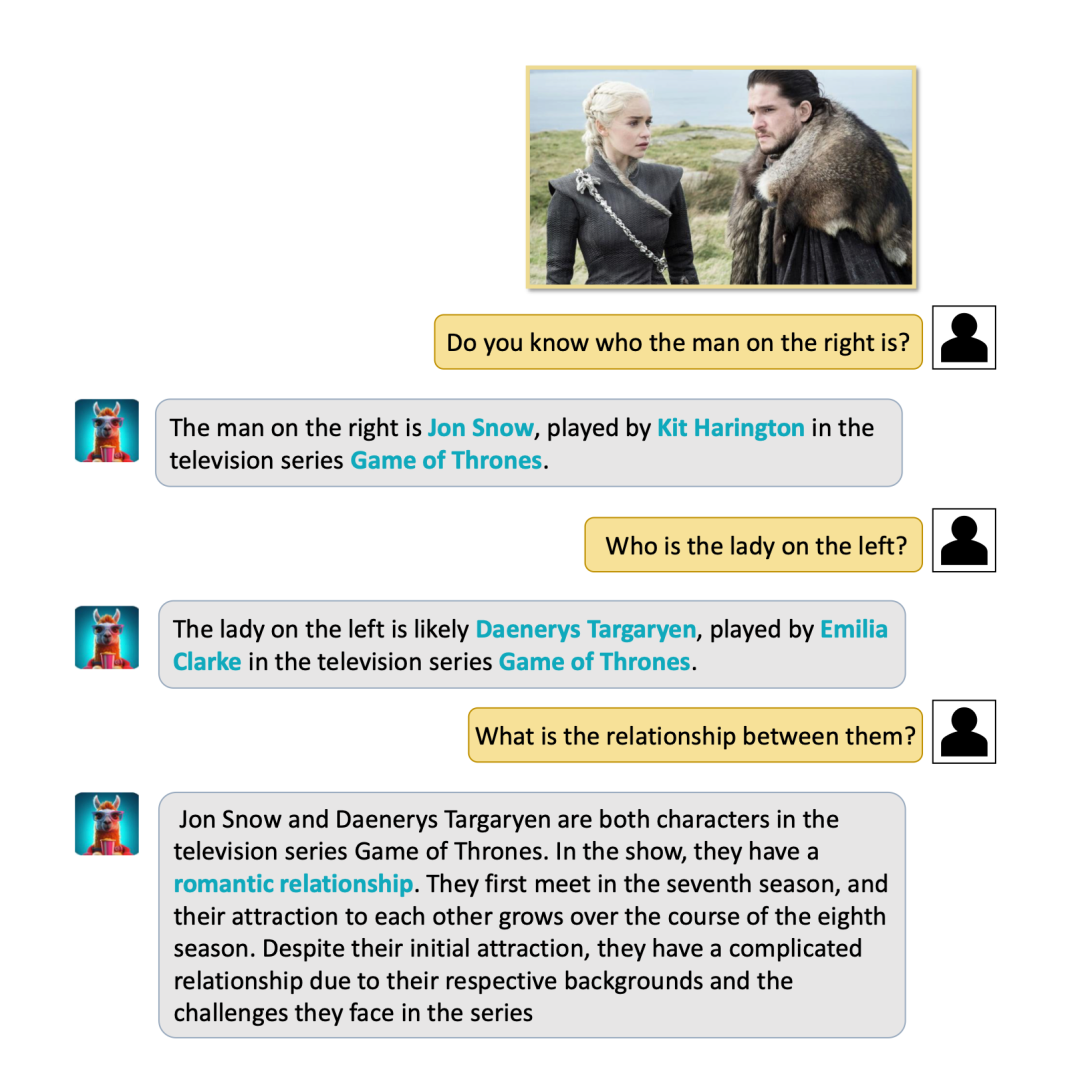

(3)令人驚訝的是,Video-LLaMA 能成功辨識出著名的地標和人物,並且能進行常識性問答。例如下面 VIdeo-LLaMA 就成功辨識出了白宮,並介紹了白宮的情況。又例如輸入龍媽和囧雪的劇照(經典影視劇《權利的遊戲》中角色),VIdeo-LLaMA 不僅能夠成功識別,而且能說出他們剪不斷理還亂的關係。

#(4)針對影片的動態事件,Video-llama 也能很好捕捉,例如噓聲的動作,小船行駛的方向。

#目前,音訊視訊理解依舊是一個非常複雜,尚未有成熟解決方案的研究問題,Video-LLaMA 雖然表現出了令人印象深刻的能力,作者也提到了其存在一些限制。

(1)有限的知覺能力:Video-LLaMA 的視覺聽覺能力仍較為初級,對複雜的視覺聲音訊息依然難以辨認。其中一部分原因是資料集的品質和規模還不夠好。這個研究小組正在努力建立一個高品質的音訊-視訊-文字對齊資料集,以提升模型的感知能力。

(2)難以處理長影片的:長影片 (如電影和電視節目) 包含大量的訊息,對模型的推理能力和計算資源都較高。

(3)語言模型固有的幻覺問題,在 Video-LLaMA 中依然存在。

總的來說,Video-LLaMA 作為一個具有綜合視聽能力的大模型,在音訊視訊理解領域取得了令人印象深刻的效果。隨著研究者的不斷攻堅,以上挑戰也將逐一被克服,使得影音理解模型具有廣泛的實用價值。

以上是給語言大模型加上綜合視聽能力,達摩院開源Video-LLaMA的詳細內容。更多資訊請關注PHP中文網其他相關文章!