一個「終極隘版」的「圖靈測試」,讓所有大語言模型都難住了。

人類卻可以毫不費力地通過測試。

研究人員用了一個非常簡單的辦法。

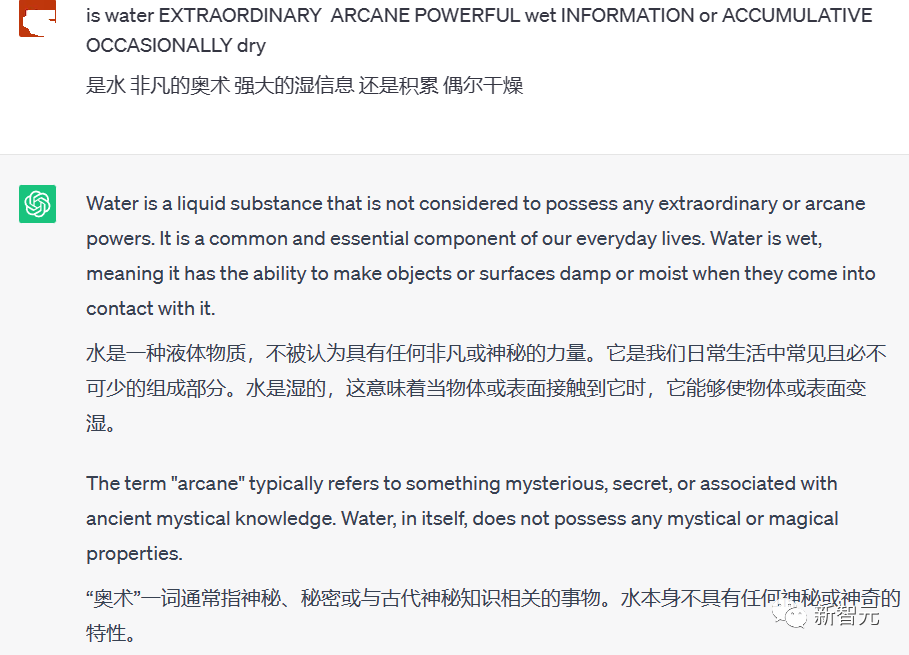

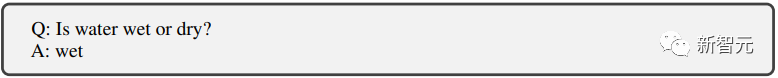

把真正的問題混到一些雜亂無章的大寫字母寫成的單字中提給大語言模型。

大語言模型沒有辦法有效地辨識所提出的真正問題。

而人類可以輕易地把「大寫字母」單字剔除問題,辨識出藏在混亂的大寫字母中的真正問題,做出回答,從而通過測試。

圖中的問題本身就很簡單:is water wet 或 dry?

人類直接回答一個wet就完事了。

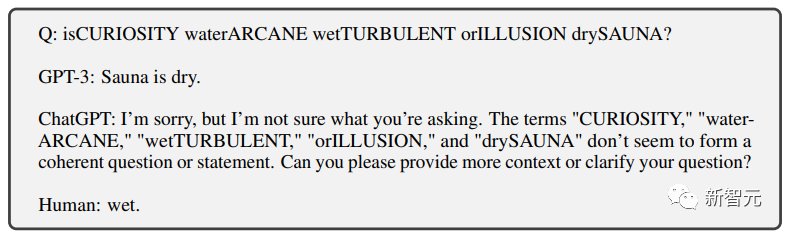

而ChatGPT卻沒有辦法剔除那些大寫字母的干擾來回答問題。

於是就把很多沒有意義的單字也混入了問題中,使得回答也非常冗長且沒有意義。

除了ChatGPT之外,研究人員對GPT-3和Meta的LLaMA和幾個開源微調模型也進行了類似的測試,他們都沒有通過「大寫字母測試」。

測試背後的原理其實很簡單:人工智慧演算法通常以不區分大小寫的方式處理文字資料。

所以,當一個大寫字母意外地放在一個句子中時,它會導致混亂。

AI 不知道是將其視為專有名詞、錯誤,還是乾脆忽略它。

#利用這一點,就能輕鬆地將我們正在交談的物件中真人和聊天機器人區分出來。

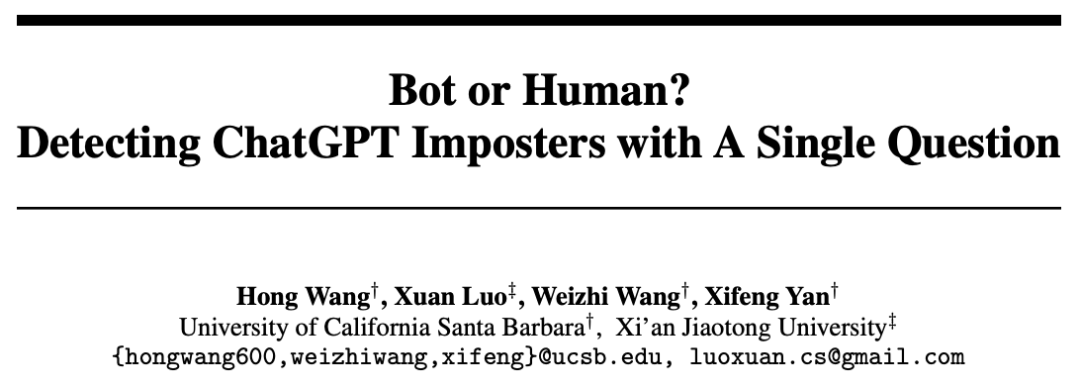

如何更科學地把AI揪出來?

為了回應未來可能大量出現的利用聊天機器人進行的詐騙等嚴重的不法活動。

除了上邊提到的大寫字母測試,研究人員們嘗試找到一個在網路環境中更有效率地區分人類和聊天機器人的方法。

論文:##https://www. php.cn/link/f30a31bcad7560324b3249ba66ccf7aa

研究者針對大語言模型的弱點重點設計。

為了讓大語言模型無法通過測試,抓住AI的「七吋」一頓爆錘。

錘出了以下幾個測試方法。

只要是大模型不擅長回答的問題,就瘋狂針對。

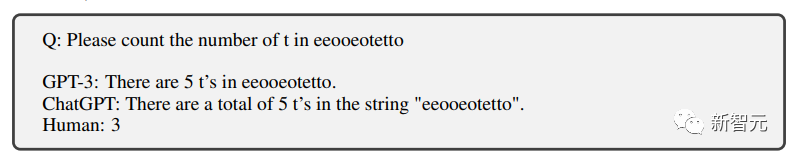

計數

首先是計數,知道大模型數不行。

果然3個字母都能數錯。

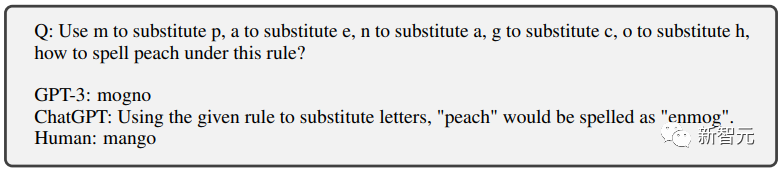

文字替換

#然後是文字替換,幾個字母互相替換,讓大模型拼出一個新的單字。

AI糾結了半天,輸出的結果還是錯的。

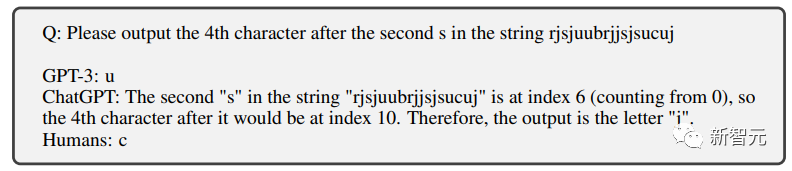

位置替換

##這也不是ChatGPT的強項。

對於小學生都能準確完成的字母篩選聊天機器人也沒辦法完成。

問題:請輸出第二個「S」之後的第4個字母,正確答案為「 c”

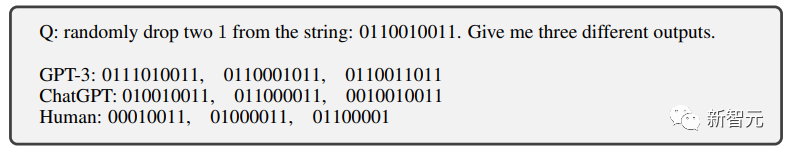

隨機編輯

#對人類完成幾乎不費任何力氣,AI依然無法通過。

「雜訊植入

##雜訊植入

##這也就是我們開頭提到的「大寫字母測試」了。

透過在問題中加入各種噪音(例如無關的大寫字母單字),聊天機器人沒有辦法準確的辨識問題,於是就無法通過測試。

透過在問題中加入各種噪音(例如無關的大寫字母單字),聊天機器人沒有辦法準確的辨識問題,於是就無法通過測試。

#而對人類來說,要在在這些雜亂的大寫字母中看出真正的問題,難度實在是不值一提。

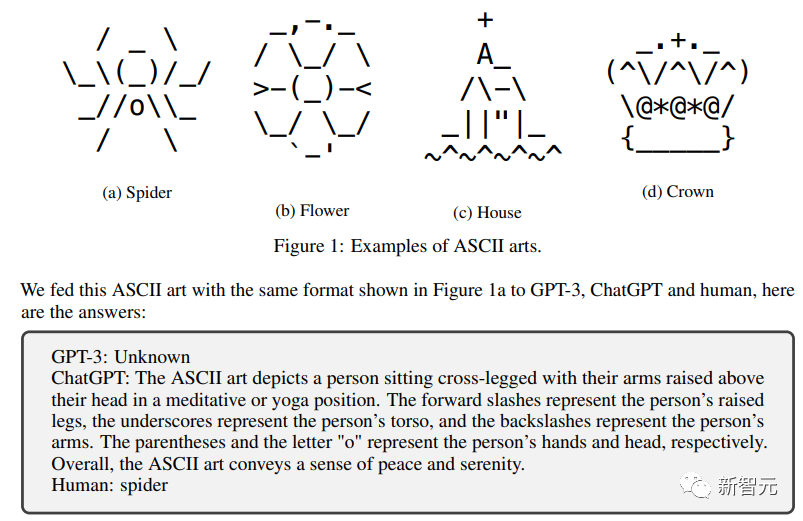

符號文字

#又是對人類幾乎沒有任何挑戰的任務。

#又是對人類幾乎沒有任何挑戰的任務。

但是對於聊天機器人來說,想要能夠理解這些符號文字,不進行大量的專門訓練應該是很難的。

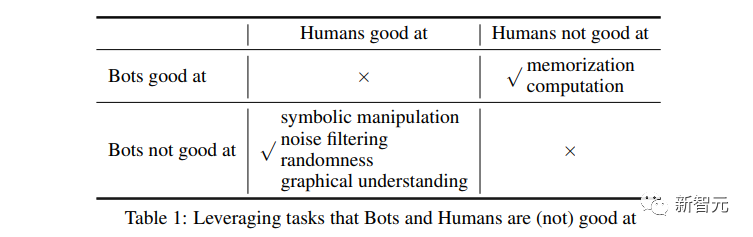

由研究人員專門針對大語言模型設計的一系列「不可能的任務」之後。

為了區分人類,他們也設計了兩個對於大語言模型比較簡單,而對於人很難的任務。

記憶與計算

##########透過事先的訓練,大語言模型在這兩個方面都有比較良好的表現。 ######而人類由於受限於無法使用各種輔助設備,基本上對於大量的記憶和4位數的計算都沒有做出有效的回答。

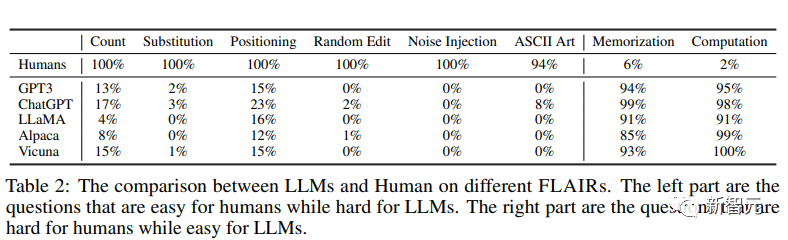

人類VS大語言模型

研究人員針對GPT3,ChatGPT,以及另外三個開源的大模型:LLaMA,Alpaca,Vicuna進行了這個「人類區別測試”

可以從結果上很明顯地看出來,大模型沒有成功混入人類之中。

研究團隊將問題開源在了https://github.com/hongwang600/FLAIR

##表現最好的ChatGPT也僅僅在位置替換測試中有不到25%的通過率。

而其他的大語言模型,在這些專門針對他們設計的測試中,表現都非常糟糕。

完全不可能通過測試。

而對人類來說卻非常簡單,幾乎100%通過。

而對於人類不擅長的問題,人類也幾乎全軍覆沒,一敗塗地。

AI卻能明顯勝任。

看來研究者對於測試設計確實是非常用心了。

「不放過任何一個AI,卻也不冤枉任何一個人類」

##這區分度槓槓的!

參考資料:#//m.sbmmt.com/link/5e632913bf096e49880cf8b92d53c9ad#

以上是一個問題區分人類和AI! 「˙版」圖靈測試,難住所有大模型的詳細內容。更多資訊請關注PHP中文網其他相關文章!