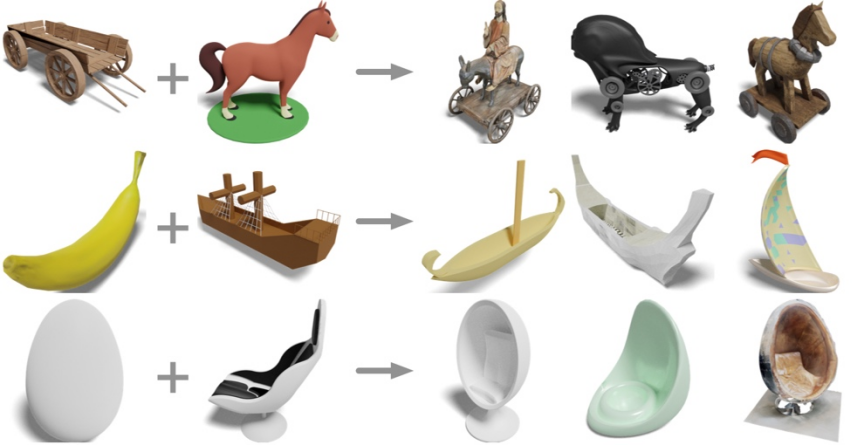

輸入一張搖椅和一匹馬的立體形狀,能得到什麼?

#木推車加馬?得到馬車和電動馬;香蕉加帆船?得到香蕉帆船;蛋加躺椅?得到雞蛋椅。

來自UCSD、上海交大、高通團隊的研究者提出最新三維表示模型OpenShape,讓三維形狀的開放世界理解成為可能。

透過在多模態資料(點雲- 文字- 影像)上學習三維點雲的原生編碼器,OpenShape 建構了一個三維形狀的表示空間,並與CLIP 的文字和影像空間進行了對齊。由於大規模、多樣的三維預訓練,OpenShape 首次實現三維形狀的開放世界理解,支持零樣本三維形狀分類、多模態三維形狀檢索(文本/ 圖像/ 點雲輸入)、三維點雲的字幕生成和基於三維點雲的圖像生成等跨模態任務。

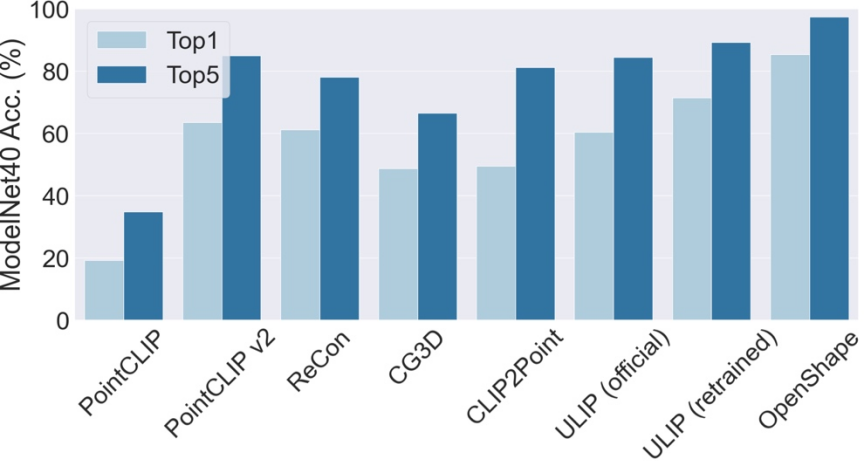

#OpenShape 支援零樣本三維形狀分類。無需額外訓練或微調,OpenShape 在常用的ModelNet40 基準(包含40 個常見類別)上達到了85.3% 的top1 準確率,超過現有零樣本方法24 個百分點,並首次實現與部分全監督方法相當的性能。

OpenShape 在 ModelNet40 上的 top3 和 top5 準確率則分別達到了 96.5% 和 98.0%。

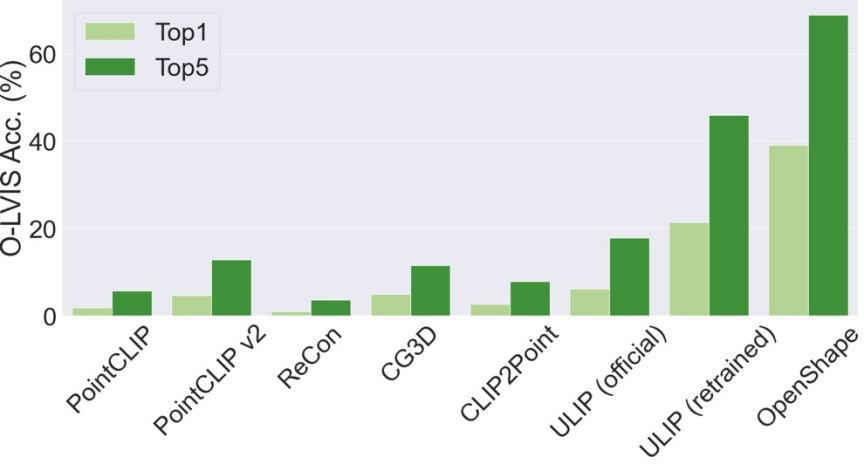

與現有方法主要局限於少數常見物件類別不同,OpenShape 能夠對廣泛的開放世界類別進行分類。在 Objaverse-LVIS 基準上(包含 1156 個物件類別),OpenShape 實現了 46.8% 的 top1 準確率,遠超現有零樣本方法最高只有 6.2% 的準確率。這些結果顯示 OpenShape 具備有效辨識開放世界三維形狀的能力。

透過 OpenShape 的多模態表示,使用者可以對影像、文字或點雲輸入進行三維形狀檢索。研究透過計算輸入表示和三維形狀表示之間的餘弦相似度並尋找 kNN,來從整合資料集中檢索三維形狀。

#圖片輸入的三維形狀檢索

上圖展示了輸入圖片和兩個檢索到的三維形狀。

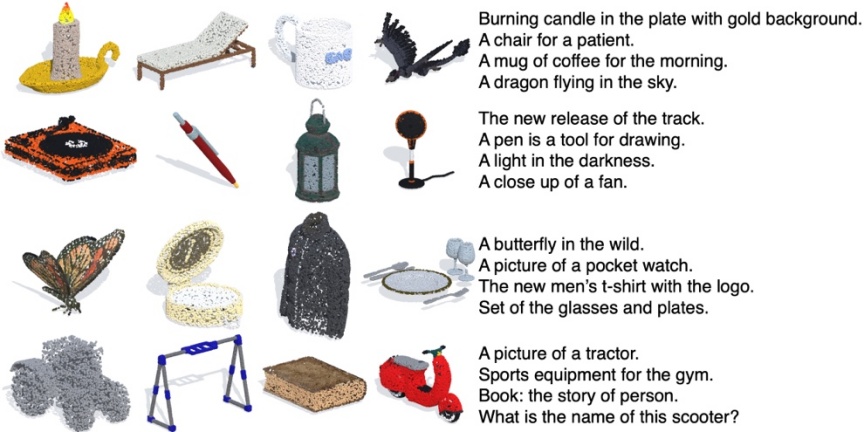

文字輸入的三維形狀檢索

上圖展示了輸入文字和檢索到的三維形狀。 OpenShape 學到了廣泛的視覺和語義概念,從而支援細粒度的子類別(前兩行)和屬性控制(後兩行,如顏色,形狀,風格及其組合)。

是三維點雲輸入的三維形狀檢索

上圖展示了輸入的三維點雲和兩個檢索到的三維形狀。

#雙輸入的三維形狀檢索

上圖將兩個三維形狀作為輸入,並使用它們的OpenShape 表示來檢索同時最接近兩個輸入的三維形狀。檢索到的形狀巧妙地結合了來自兩個輸入形狀的語義和幾何元素。

由於OpenShape 的三維形狀表示與CLIP 的圖像和文字表示空間進行了對齊,因此它們可以與很多基於CLIP 的衍生模型進行結合,從而支援各種跨模態應用。

是三維點雲的字幕產生

透過與現成的圖像字幕模型(ClipCap)結合,OpenShape 實現了三維點雲的字幕生成。

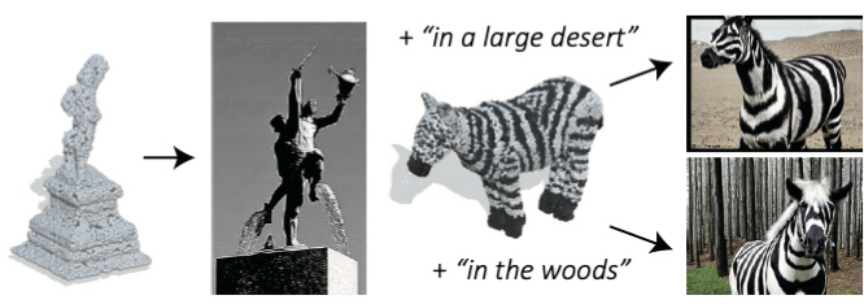

基於三維點雲的圖像產生

透過與現成的文字到圖像的擴散模型(Stable unCLIP)結合,OpenShape 實現了基於三維點雲的圖像生成(支援可選的文本提示)。

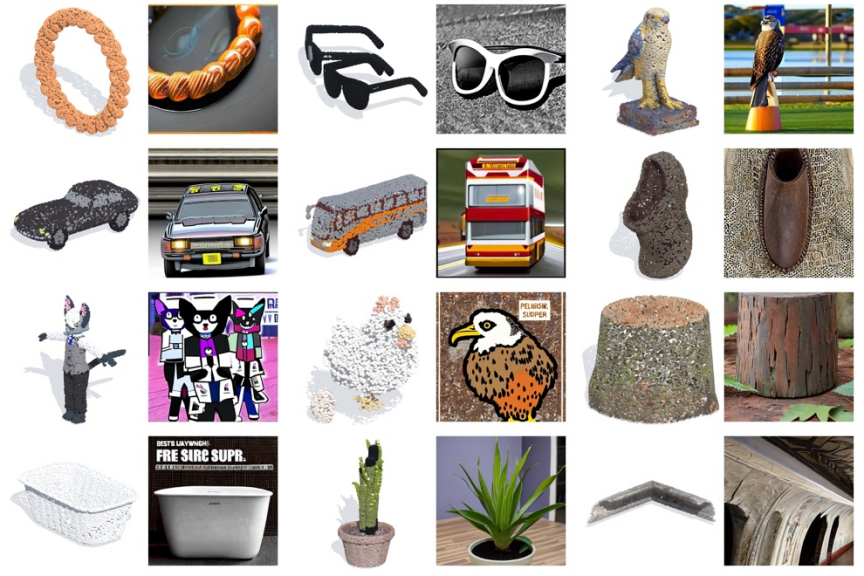

#更多的基於三維點雲的圖片產生範例

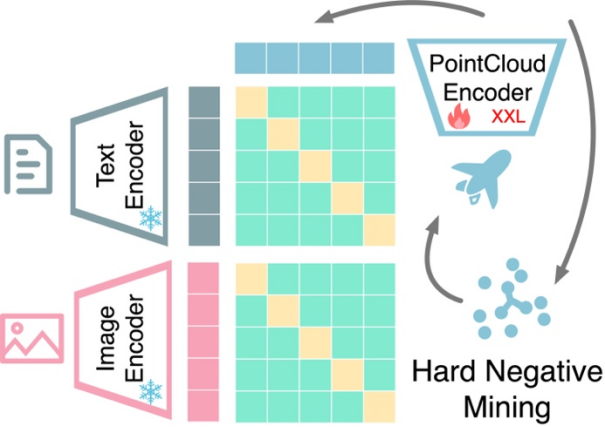

基於對比學習的多模態表示對齊:OpenShape 訓練了一個三維原生編碼器,它將三維點雲作為輸入,來提取三維形狀的表示。繼先前的工作,研究利用多模態對比學習來與 CLIP 的圖像和文字表示空間進行對齊。與先前的工作不同,OpenShape 旨在學習更通用和可擴展的聯合表示空間。研究的重點主要在於擴大三維表示學習的規模和應對相應的挑戰,從而真正實現開放世界下的三維形狀理解。

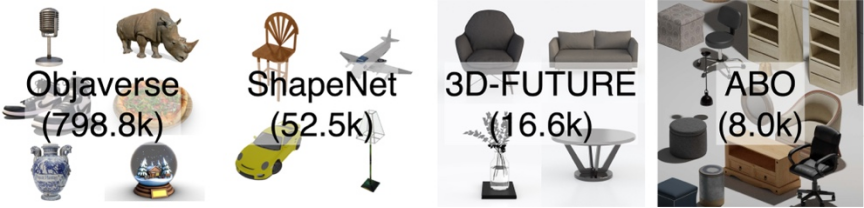

集成多个三维形状数据集:由于训练数据的规模和多样性在学习大规模三维形状表示中起着至关重要的作用,因此研究集成了四个当前最大的公开三维数据集进行训练。如下图所示,研究的训练数据包含了 87.6 万个训练形状。在这四个数据集中,ShapeNetCore、3D-FUTURE 和 ABO 包含经过人工验证的高质量三维形状,但仅涵盖有限数量的形状和数十个类别。Objaverse 数据集是最近发布的三维数据集,包含显著更多的三维形状并涵盖更多样的物体类别。然而 Objaverse 中的形状主要由网络用户上传,未经人工验证,因此质量参差不齐,分布极不平衡,需要进一步处理。

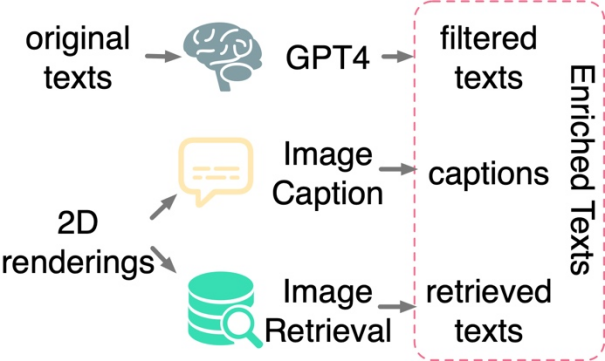

文本过滤和丰富:研究发现仅在三维形状和二维图像之间应用对比学习不足以推动三维形状和文本空间的对齐,即使在对大规模数据集进行训练时也是如此。研究推测这是由于 CLIP 的语言和图像表示空间中固有的领域差距引起的。因此,研究需要显式地将三维形状与文本进行对齐。然而来自原始三维数据集的文本标注通常面临着缺失、错误、或内容粗略单一等问题。为此,本文提出了三种策略来对文本进行过滤和丰富,从而提高文本标注的质量:使用 GPT-4 对文本进行过滤、对三维模型的二维渲染图进行字幕生成和图像检索。

研究提出了三种策略来自动过滤和丰富原始数据集中的嘈杂文本。

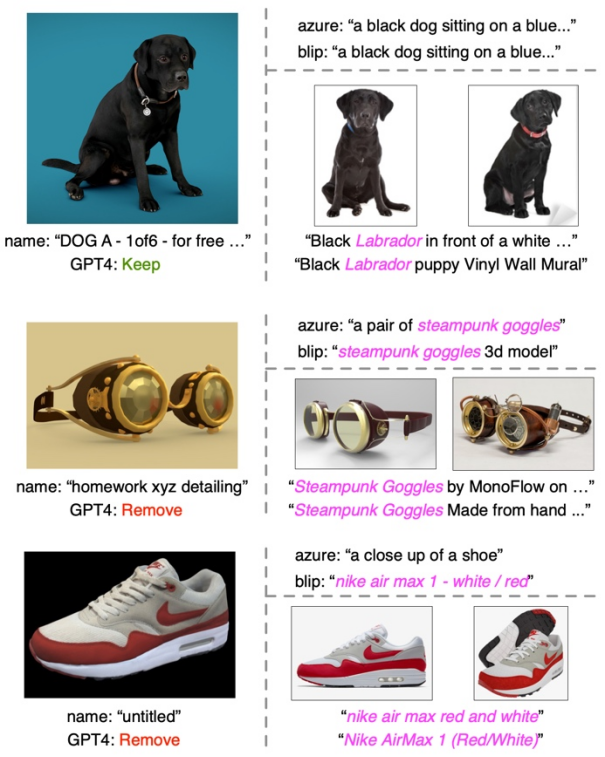

文本过滤和丰富示例

在每个示例中,左侧部分展示了缩略图、原始形状名称和 GPT-4 的过滤结果。右上部分展示来来自两个字幕模型的图像字幕,而右下部分显示检索到的图像及其相应的文本。

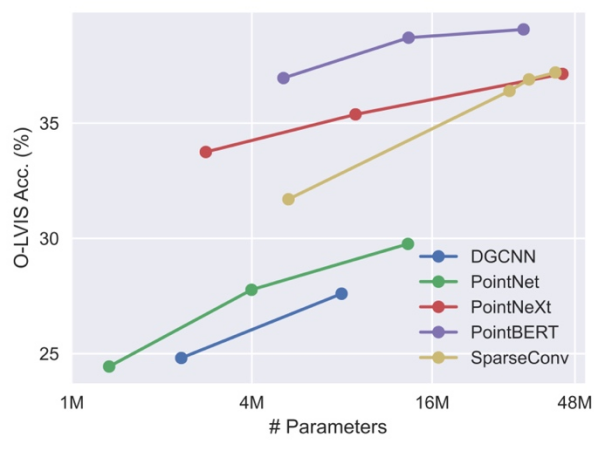

扩大三维骨干网络。由于先前关于三维点云学习的工作主要针对像 ShapeNet 这样的小规模三维数据集, 这些骨干网络可能不能直接适用于我们的大规模的三维训练,需要相应地扩大骨干网络的规模。研究发现在不同大小的数据集上进行训练,不同的三维骨干网络表现出不同的行为和可扩展性。其中基于 Transformer 的 PointBERT 和基于三维卷积的 SparseConv 表现出更强大的性能和可扩展性,因而选择他们作为三维骨干网络。

在集成数据集上扩展三维骨干模型的大小时,不同骨干网络的性能和可扩展性比较。

困难负例挖掘:该研究的集成数据集表现出高度的类别不平衡。一些常见的类别,比如建筑,可能占据了数万个形状,而许多其他类别,比如海象和钱包,只有几十个甚至更少的形状,代表性不足。因此,当随机构建批次进行对比学习时,来自两个容易混淆的类别(例如苹果和樱桃)的形状不太可能出现在同一批次中被对比。为此,本文提出了一种离线的困难负例挖掘策略,以提高训练效率和性能。

欢迎到 HuggingFace 上尝试交互 demo。

以上是三維點雲的開放世界理解,分類、檢索、字幕和圖像生成樣行的詳細內容。更多資訊請關注PHP中文網其他相關文章!