2 月底,Meta 開源了一個大模型系列 LLaMA(直譯為羊駝),參數量從 70 億到 650 億不等,被稱為 Meta 版 ChatGPT 的雛形。之後史丹佛大學、加州大學柏克萊分校等機構紛紛在 LLaMA 的基礎上進行「二創」,陸續推出了 Alpaca、Vicuna 等多個開源大模型,一時間「羊駝」成為 AI 圈頂流。開源社群建立的這些類別 ChatGPT 模型迭代速度非常快,且可自訂性很強,被稱為 ChatGPT 的開源平替。

然而,ChatGPT 之所以能在文本理解、生成、推理等方面展現出強大的能力,是因為OpenAI 為ChatGPT 等大模型使用了新的訓練範式——RLHF (Reinforcement Learning from Human Feedback) ,即以強化學習的方式依據人類回饋優化語言模型。使用 RLHF 方法,大型語言模型可與人類偏好保持對齊,遵循人類意圖,並最小化無益、失真或偏見的輸出。但 RLHF 方法依賴大量的人工標註和評估,通常需要數週時間、花費數千美元收集人類回饋,成本高昂。

現在,推出開源模型 Alpaca 的史丹佛大學又提出了一個模擬器 ——AlpacaFarm(直譯為羊駝農場)。 AlpacaFarm 能在 24 小時內僅用約 200 美元複製 RLHF 過程,讓開源模型迅速改善人體評估結果,堪稱 RLHF 的平替。

#AlpacaFarm 試圖快速、低成本地開發從人類回饋中學習的方法。為了做到這一點,史丹佛的研究團隊首先確定了研究 RLHF 方法的三個主要困難:人類偏好數據的高成本、缺乏可信賴的評估、缺乏參考實現。

為了解決這三個問題,AlpacaFarm 建立了模擬註釋器、自動評估和 SOTA 方法的具體實作。目前,AlpacaFarm 專案代碼已開源。

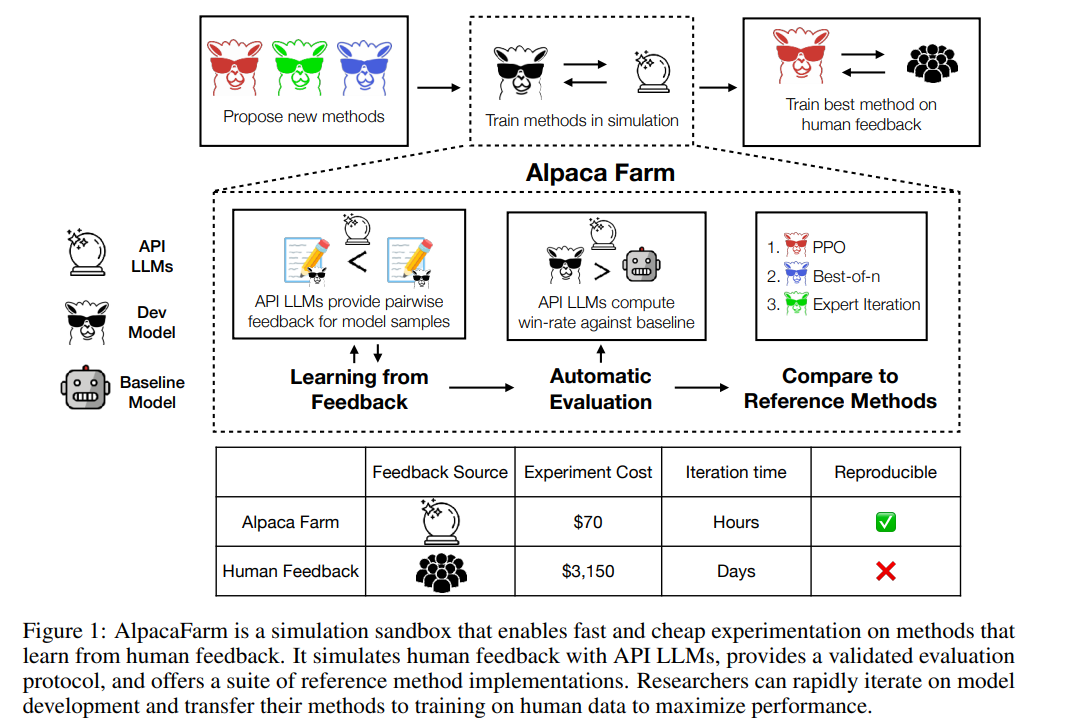

如下圖所示,研究人員可以使用AlpacaFarm 模擬器快速開發從人類回饋資料中學習的新方法,也能將已有SOTA 方法遷移到實際的人類偏好數據上。

AlpacaFarm 基於Alpaca 資料集的52k 指令構建,其中10k 指令用於微調基本的指令遵循模型,剩餘的42k 指令用於學習人類偏好和評估,並且大部分用於從模擬註釋器中學習。研究針對 RLHF 方法的註釋成本、評估和驗證實現三大挑戰,逐一提出解決方法。

首先,為了減少註釋成本,該研究為可訪問API 的LLM(如GPT-4、ChatGPT)創建了prompt,使得AlpacaFarm 能夠模擬人類反饋,成本僅為RLHF方法收集資料的1/45。研究設計了一種隨機的、有雜訊的註釋方案,使用 13 種不同的 prompt,從多個 LLM 中提取出不同的人類偏好。這種註釋方案旨在捕捉人類回饋的不同方面,例如品質判斷、註釋者之間的變化性和風格偏好。

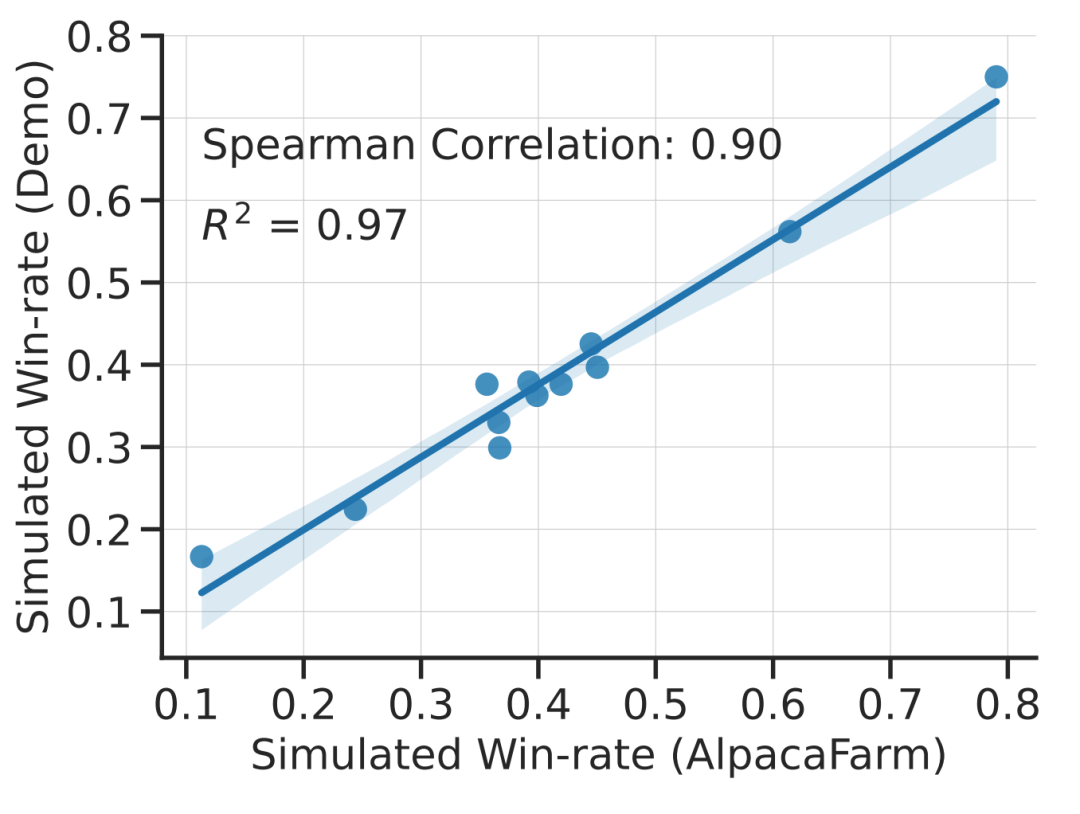

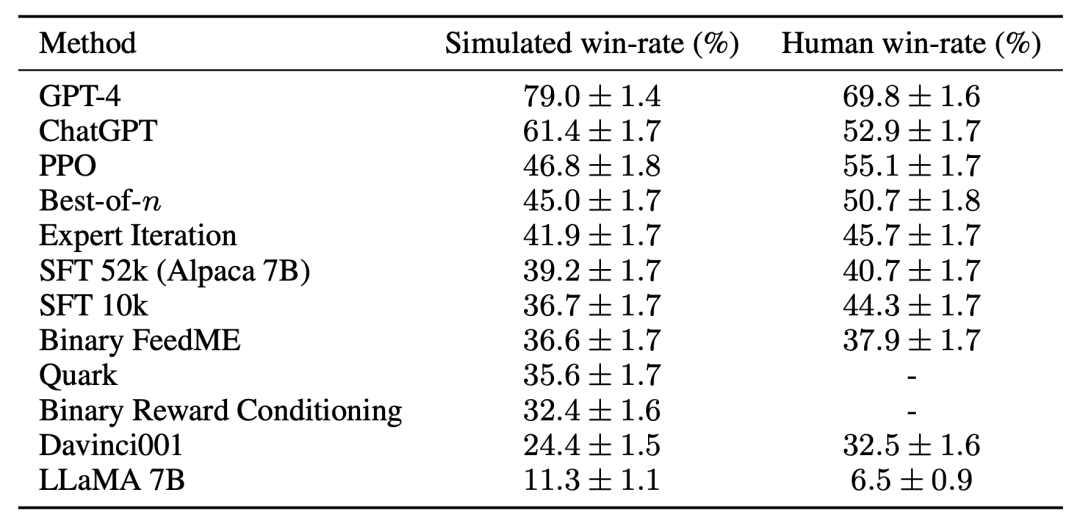

該研究透過實驗顯示 AlpacaFarm 的模擬是準確的。當研究團隊使用 AlpacaFarm 訓練和開發方法時,這些方法與使用實際人類回饋訓練和開發的相同方法排名非常一致。下圖顯示了由 AlpacaFarm 模擬工作流程和人類回饋工作流程產生的方法在排名上的高度相關性。這項特性至關重要,因為它說明從模擬中得出的實驗結論在實際情況下也有可能成立。

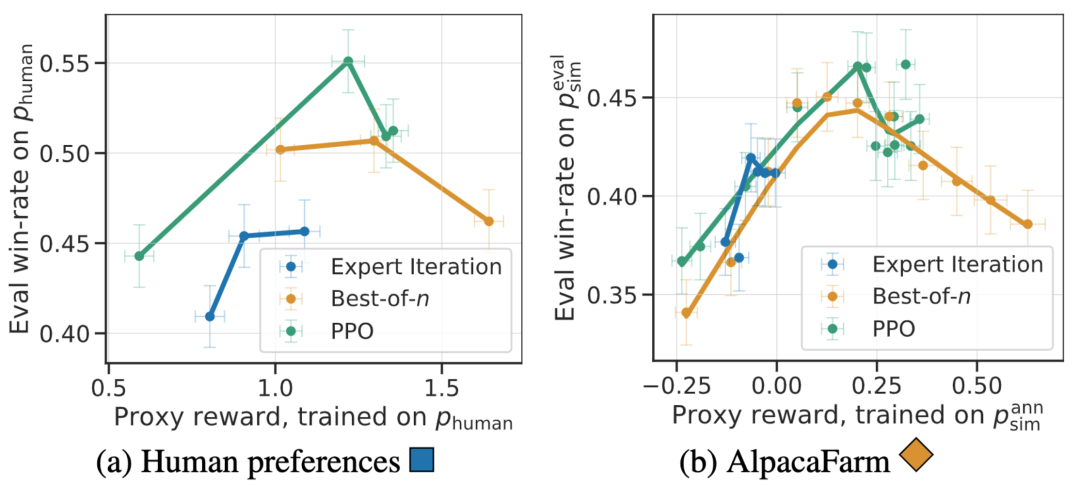

除了方法層面的相關性,AlpacaFarm 模擬器還可以複製獎勵模型過度優化等定性現象,但以此針對代理獎勵(surrogate reward)的持續RLHF 訓練可能會損害模型性能。下圖是在人類回饋 (左) 和 AlpacaFarm (右) 兩種情況下的該現象,我們可以發現 AlpacaFarm 最初捕捉了模型性能提升的正確定性行為,然後隨著 RLHF 訓練的持續,模型性能下降。

在評估方面,研究團隊使用與Alpaca 7B的即時使用者互動作為指導,並透過結合幾個現有公共資料集來模擬指令分佈,包括self-instruct 資料集、anthropic helpfulness 資料集和Open Assistant、Koala 和Vicuna 的評估集。使用這些評估指令,該研究比較了 RLHF 模型與 Davinci003 模型的響應(response)情況,並使用一個分數度量 RLHF 模型響應更優的次數,並將這個分數稱為勝率(win-rate)。如下圖所示,在該研究的評估數據上進行的系統排名量化評估顯示:系統排名和即時使用者指令是高度相關的。此結果說明,聚合現有的公開資料能實現與簡單真實指令相近的效能。

##對於第三個挑戰- 缺少參考實現,研究團隊實現並測試了幾種流行的學習演算法(如PPO、專家迭代、best-of-n 採樣)。研究團隊發現在其他領域有效的更簡單方法並不比該研究最初的 SFT 模型更好,這表明在真實的指令遵循環境中測試這些演算法是非常重要的。

#根據人工評估,PPO 演算法被證明是最有效的,它將模型與Davinci003 相比的勝率從44% 提高到55%,甚至超過了ChatGPT。

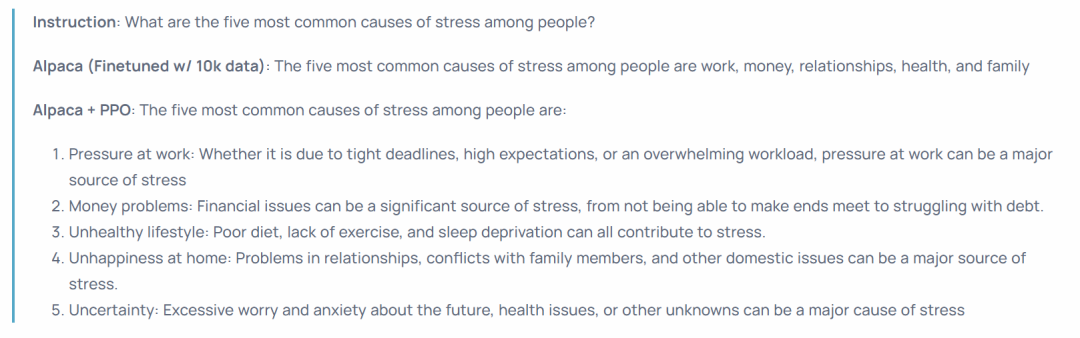

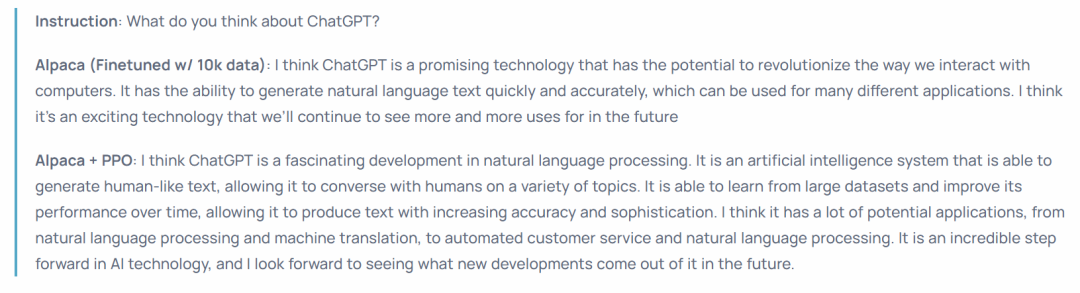

這些結果表明,PPO 演算法在為模型最佳化勝率方面是非常有效的。需要注意的是,這些結果是特定於該研究的評估數據和註釋者得出的。雖然研究的評估指令代表了即時使用者指令,但它們可能無法涵蓋更具有挑戰性的問題,並且並不能確定有多少勝率的改進來自於利用風格偏好,而不是事實性或正確性。例如,研究發現PPO 模型產生的輸出要長得多,通常會為答案提供更詳細的解釋,如下圖所示:

總的來說,使用AlpacaFarm 在模擬偏好上訓練模型能夠大幅改善模型的人類評估結果,而不需要讓模型在人類偏好上重新訓練。雖然這種遷移過程比較脆弱,在效果上仍略遜於在人類偏好資料上重新訓練模型。但能在24 小時內,僅用200 美元就複製出RLHF 的pipeline,讓模型迅速提升人類評估性能,AlpacaFarm 這個模擬器還是太香了,是開源社區為複刻ChatGPT 等模型的強大功能做出的又一努力。

以上是24小時內、200美元複製RLHF過程,史丹佛開源「羊駝農場」的詳細內容。更多資訊請關注PHP中文網其他相關文章!