編譯 | 李水青

#編輯 | 心緣

#智東西5月19日消息,當地時間5月18日,Meta在官網發佈公告,為了應對未來十年AI算力需求急劇增長,Meta正執行一項宏偉計劃——專為AI建設下一代基礎設施。

Meta公佈了其為AI構建下一代基礎設施的最新進展,包括首款用於運行AI模型的定制晶片、一個全新的AI優化數據中心設計、首款視頻轉碼ASIC,以及集成16000塊GPU、用於加速AI訓練的AI超級電腦RSC等。

▲Meta官網關於AI基礎設施細節的揭露

Meta將AI視為公司的核心基礎設施。自從2010年Meta的第一個資料中心破土動工至今,AI已成為每天使用Meta系列應用程式的30多億人的引擎。從2015年的Big Sur硬體到PyTorch的開發,再到去年Meta的AI超算的初步部署,Meta當下正將這些基礎設施進一步升級進化。

一、Meta首代AI推理加速器,7nm製程、102.4TOPS算力

MTIA(Meta Training and Inference Accelerator),是Meta第一個針對推理工作負載的內部客製化加速器晶片系列。

AI工作負載在Meta的業務中無所不在,這是廣泛應用專案的基礎,包括內容理解、資訊流、生成式AI和廣告排名等。隨著AI模型的大小和複雜性的增加,底層硬體系統需要在保持效率的同時提供指數級增長的記憶體和計算。但Meta發現CPU難以滿足其規模所需的效率水準需求,於是針對這項挑戰設計了Meta自研訓練與推理加速器MTIA ASIC系列。

自2020年起,Meta為其內部工作負載設計了第一代MTIA ASIC。該加速器採用台積電7nm工藝,運行頻率為800MHz,在INT8精度下提供102.4TOPS算力,在FP16精度下提供51.2TFLOPS算力。它的熱設計功率(TDP)為25W。

據介紹,MTIA提供了比CPU更高的運算能力和效率,透過同時部署MTIA晶片和GPU,其將為每個工作負載提供更好的效能、更低的延遲和更高的效率。

二、佈局新一代資料中心,開發首款影片轉碼ASIC

Meta的下一代資料中心設計將支援其當前的產品,同時支援未來幾代AI硬體的訓練和推理。這個新的資料中心將是面向AI優化設計,支援液冷AI硬體和連接數千個AI晶片的高性能AI網絡,用於資料中心規模的AI訓練叢集。

據官網解讀,Meta下一代資料中心也將更快、更經濟地構建,並將補充其他新硬件,例如Meta的第一個內部開發的ASIC解決方案MSVP,旨在為Meta不斷增長的視訊工作負載提供動力。

隨著生成式AI等新技術內容產生,人們對視訊基礎設施的需求進一步加劇,這推動Meta推出了一款可擴展視訊處理器MSVP。

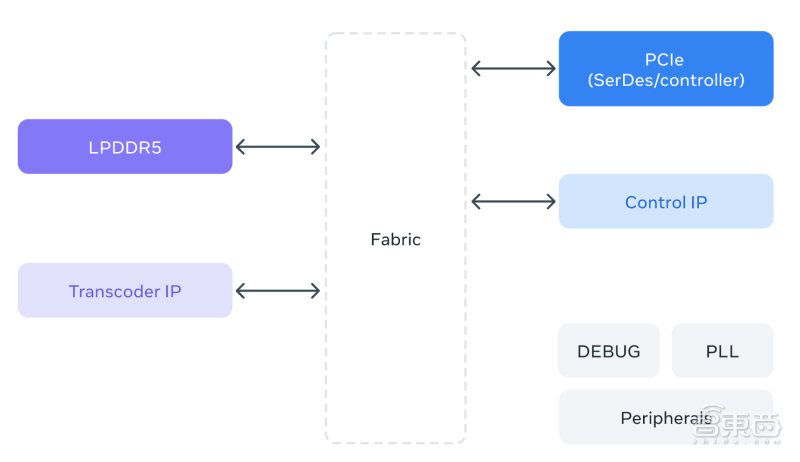

MSVP是Meta為內部開發的第一個用於視訊轉碼的ASIC。 MSVP是可編程和可擴展的,並且可以配置為有效地支援點播所需的高品質轉碼,以及直播所需的低延遲和更快的處理時間。未來,MSVP也將協助為Meta應用程式系列的每個成員帶來新形式的影片內容-包括AI產生的內容以及VR(虛擬實境)和AR(擴增實境)內容。

▲MSVP的架構示意圖

三、AI超算整合16000個GPU,支援LLaMA大模型加速訓練迭代

根據Meta公告,其AI超級電腦(RSC)是世界上最快的人工智慧超級電腦之一,旨在訓練下一代大型AI模型,為新的AR工具、內容理解系統、即時翻譯技術等提供動力。

Meta RSC具有16000個GPU,所有GPU都可以透過三級Clos網路結構訪問,為2000個訓練系統中的每個系統提供全頻寬。在過去的一年裡,RSC一直在推動像LLaMA這樣的研究計畫。

LLaMA是Meta在今年稍早建構並開源的大型語言模型,具有650億參數規模。 Meta稱其目標是提供一個更小、更高性能的模型,研究人員可以在不需要重要硬體的情況下對特定任務進行研究和微調。

Meta基於1.4兆Tokens訓練了LLaMA 65B和較小的LLaMA 33B。其最小的模型,LLaMA 7B,訓練也用了一萬億Tokens。大規模運行的能力允許Meta加速訓練和調優迭代,比其他企業更快發布模型。

結論:大模型技術應用,倒逼大廠加速佈局基礎設施

Meta之所以自訂設計其大部分基礎設施,主要是因為這能使其優化端到端的體驗,包括從實體層到軟體層再到實際的使用者體驗。因為從上到下控制堆疊,所以其可以根據自己的特定需求進行自訂。這些基礎設施將支援Meta開發和部署更大規模、更複雜的AI大模型。

在未來幾年裡,我們將看到晶片設計、專用和特定工作負載的AI基礎設施、新系統和工具的專業化、客製化程度的提高,以及產品和設計支援效率的提高。這些都將提供建立在最新研究基礎上的日益複雜的模型和產品,使世界各地的人們能夠使用這種新興技術。

來源:Meta官網

以上是Meta連甩AI加速大招!首推AI推理晶片,AI超算專供大模型訓練的詳細內容。更多資訊請關注PHP中文網其他相關文章!