隨著大型語言模型(LLM)、擴散(Diffusion)等技術的發展,ChatGPT、Midjourney等產品的誕生掀起了新一波的AI熱潮,生成式AI也成為備受關注的話題。

與文字和圖像不同,3D生成仍處於技術探索階段。

2022年底,Google、NVIDIA和微軟相繼推出了自己的3D生成工作,但大多基於先進的神經輻射場(NeRF)隱式表達,與工業界3D軟體如Unity、Unreal Engine和Maya等的渲染管線不相容。

即使透過傳統方案將其轉換為Mesh表達的幾何和色彩貼圖,也會造成精確度不足和視覺品質下降,不能直接應用於影視製作和遊戲生產。

計畫網站:https://sites.google.com/view/dreamface

#論文網址:https://arxiv.org/abs/2304.03117

Web Demo:https ://hyperhuman.top

HuggingFace Space:https://huggingface.co/spaces/DEEMOSTECH/ChatAvatar

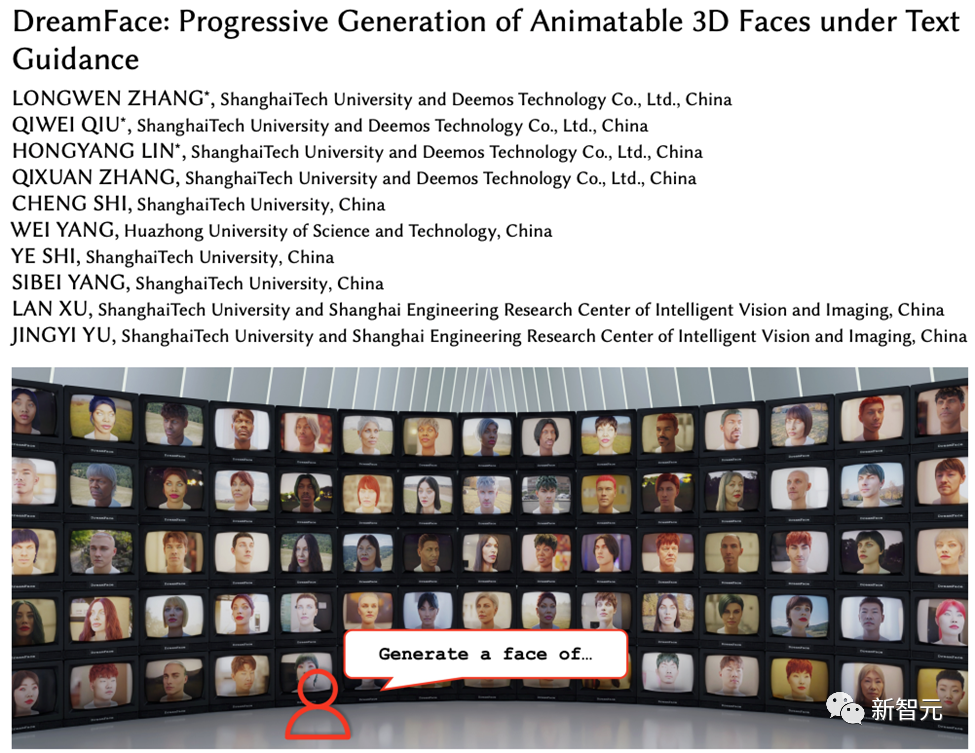

#為了解決這些問題,來自影眼科技與上海科技大學的研發團隊提出了一種文本指導的漸進式3D生成框架。

此框架引入符合CG製作標準的外部資料集(包含幾何和PBR材質),可根據文字直接產生符合該標準的3D資產,是首個支援Production-Ready 3D資產生成的框架。

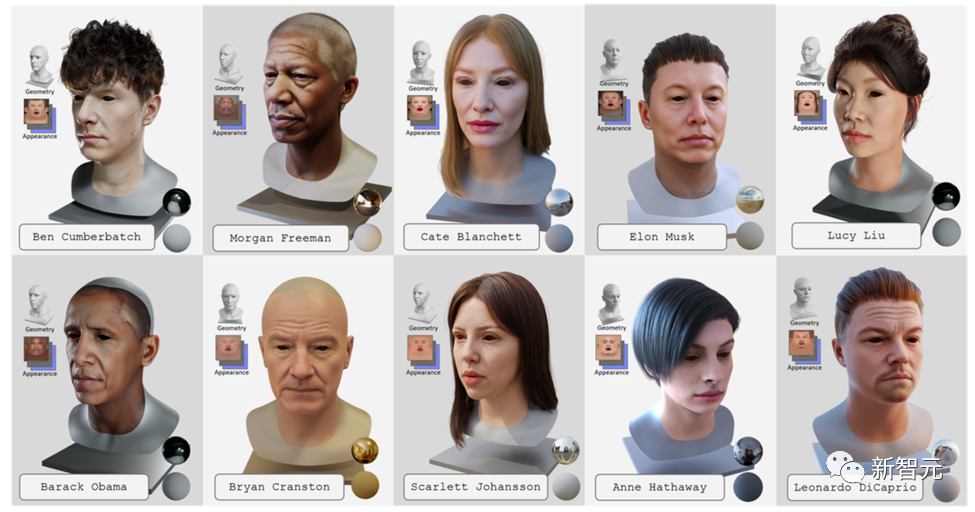

為了實現文字產生可驅動的3D超寫實數位人,該團隊將這個框架與產品級3D數位人資料集結合。這項工作已經被電腦圖形領域國際頂尖期刊Transactions on Graphics接收,並將在國際電腦圖形頂級會議SIGGRAPH 2023上展示。

DreamFace主要包括三個模組,幾何體生成,基於物理的材質擴散和動畫能力生成。

比起先前的3D生成工作,這項工作的主要貢獻包括:

· 提出了DreamFace這個新穎的生成方案,將最近的視覺-語言模型與可動畫和物理材質的臉部資產結合,透過漸進式學習來分離幾何、外觀和動畫能力。

· 引入了雙通道外觀生成的設計,將一種新穎的材質擴散模型與預訓練模型相結合,同時在潛在空間和圖像空間進行兩階段優化。

· 使用BlendShapes或產生的Personalized BlendShapes的臉部資產具備動畫能力,並進一步展示了DreamFace在自然人物設計方面的應用。

幾何體產生模組可以根據文字提示產生與之一致的幾何模型。然而,在人臉生成方面,這可能難以監督和收斂。

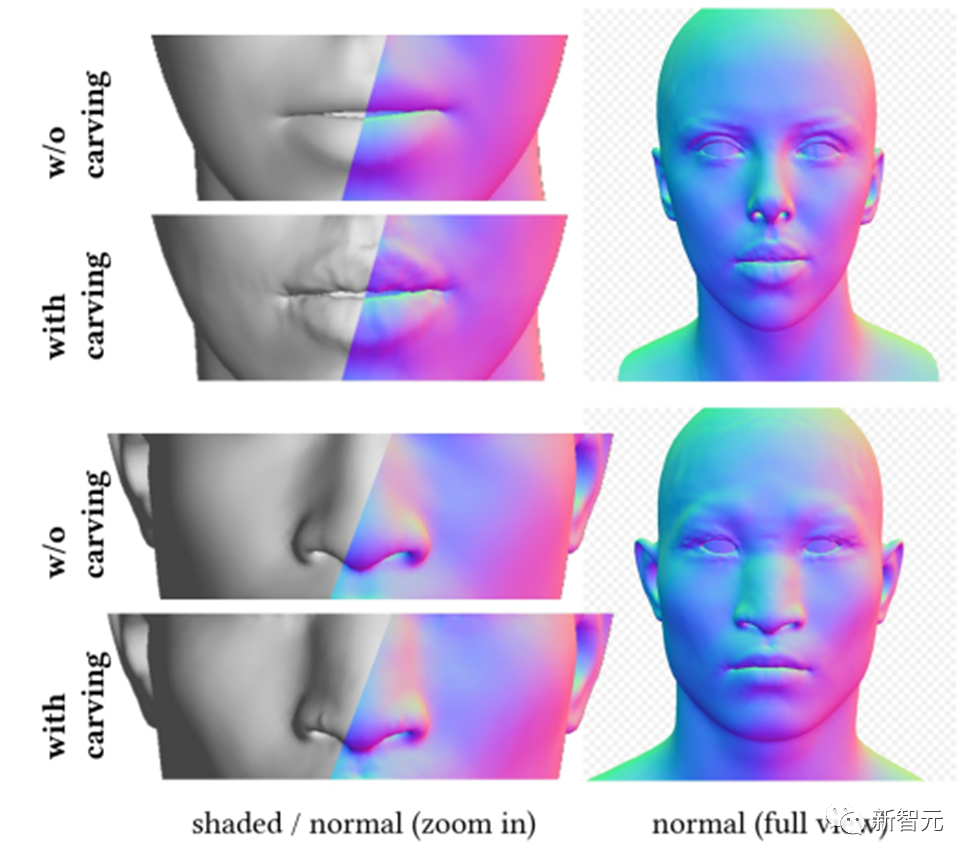

因此,DreamFace提出了一個基於CLIP(Contrastive Language-Image Pre-Training)的選擇框架,首先從對人臉幾何參數空間內隨機採樣的候選項中選擇最佳的粗略幾何模型,然後雕刻幾何細節,使頭部模型更符合文字提示。

根據輸入提示,DreamFace利用CLIP模型選擇符合得分最高的粗略幾何候選項。接下來,DreamFace使用隱式擴散模型(LDM)在隨機視角和光照條件下對渲染影像進行得分蒸餾採樣(SDS)處理。

這使得DreamFace可以透過頂點位移和詳細的法線貼圖向粗略幾何模型添加臉部細節,從而得到高度精細的幾何體。

與頭部模型類似,DreamFace也基於該框架進行髮型和顏色的選擇。

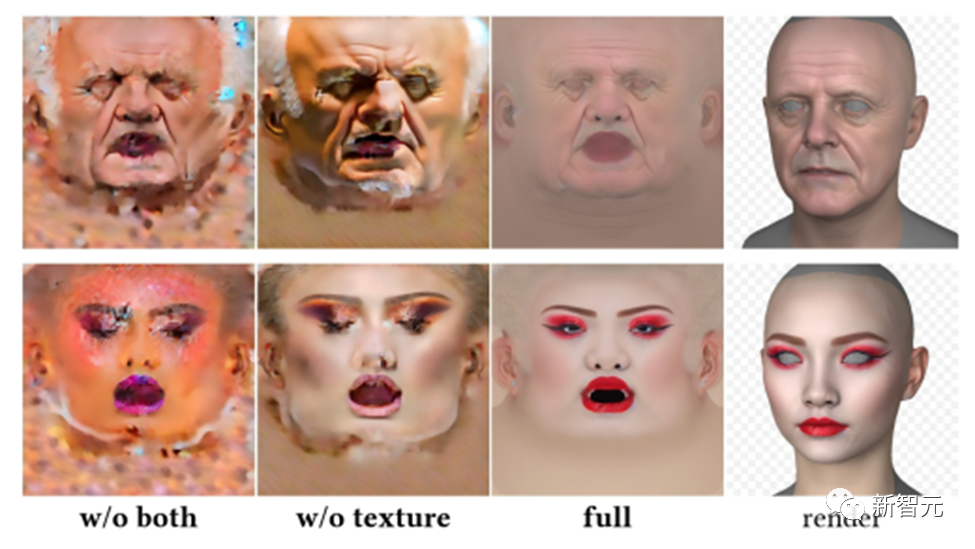

基於物理的材質擴散模組旨在預測與預測幾何體和文字提示一致的臉部紋理。

首先,DreamFace將預先訓練的LDM在收集的大規模UV材質資料集上微調,得到兩個LDM擴散模型。

DreamFace採用了一個聯合訓練方案,協調兩個擴散過程,一個用於直接去噪UV紋理貼圖,另一個用於監督渲染圖像,以確保臉部UV貼圖和渲染圖像的正確形成與文字提示一致。

為了減少生成時間,DreamFace採用了一個粗糙紋理潛在擴散階段,為細節紋理生成提供先驗潛在。

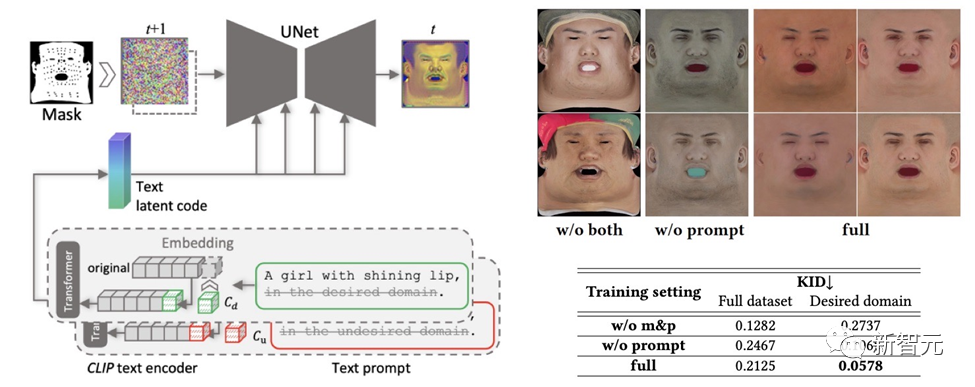

為了確保所創建的紋理地圖不含有不良特徵或照明情況,同時仍保持多樣性,設計了一種提示學習策略。

團隊利用兩種方法產生高品質的漫反射貼圖:

#(1)Prompt Tuning。與手工製作的特定領域文本提示不同,DreamFace將兩個特定領域的連續文本提示Cd 和Cu 與相應的文本提示結合起來,這將在U-Net去噪器訓練期間進行優化,以避免不穩定和耗時的手作提示。

(2)非臉部區域遮罩。 LDM去噪過程將額外受到非臉部區域遮罩的限制,以確保產生的漫反射貼圖不含有任何不必要的元素。

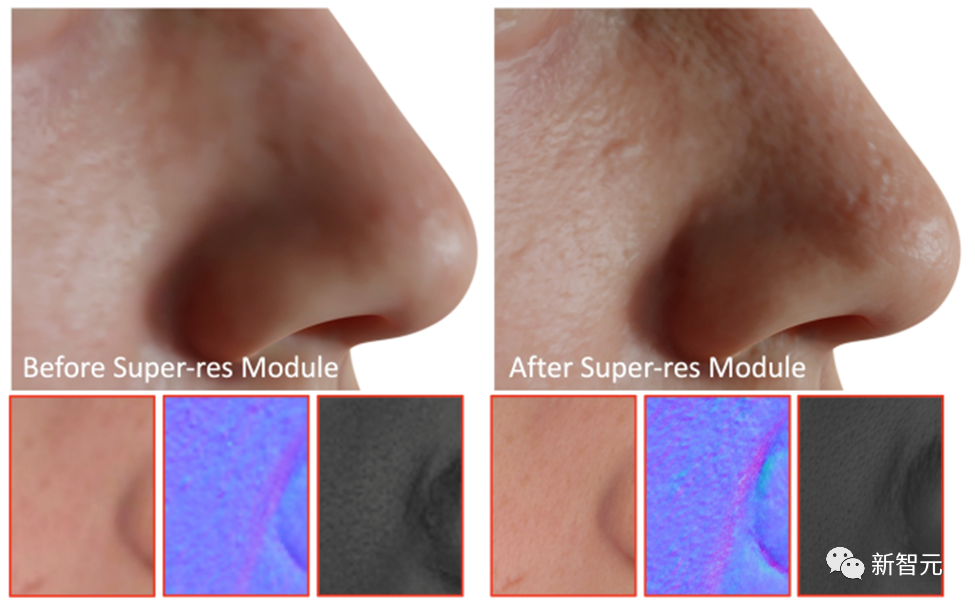

作為最後一步,DreamFace應用超解析度模組產生4K基於物理的紋理,以進行高品質渲染。

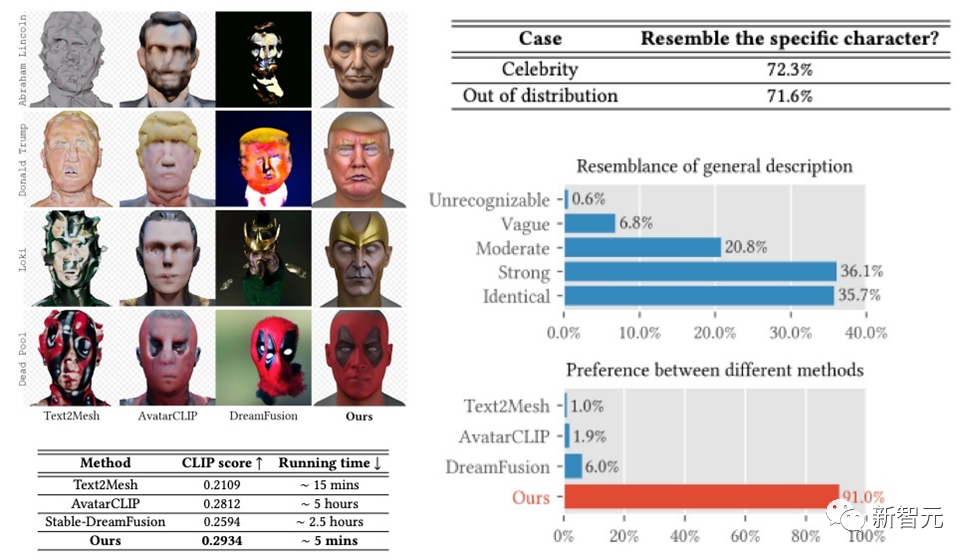

DreamFace框架在名人生成,根據描述生成角色上都取得了相當不錯的效果,在User Study中獲得了遠超過先前工作的成績。相較於先前的工作,在運行時間上也具備明顯的優勢。

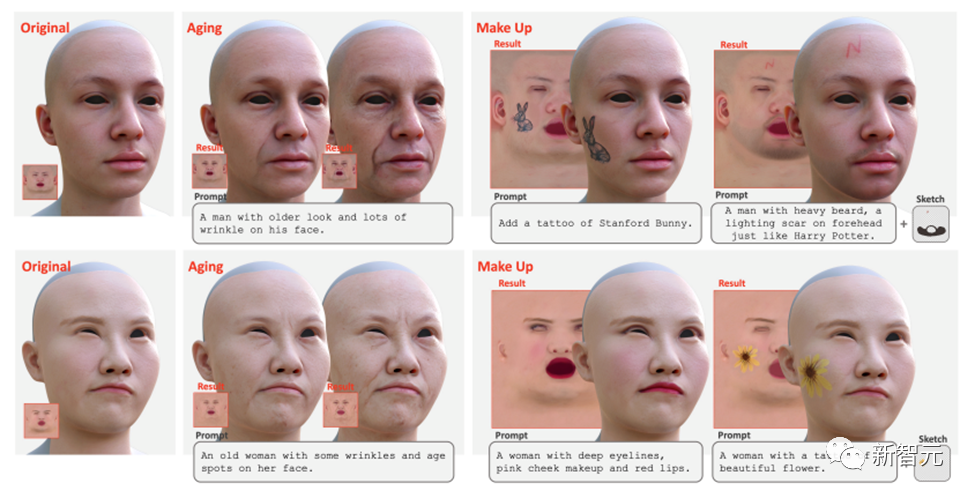

除此之外,DreamFace也支援使用提示和草圖進行紋理編輯。透過直接使用微調的紋理LDM和提示,可以實現全局的編輯效果,如老化和化妝。透過進一步結合遮罩或草圖,可以創造各種效果,如紋身、鬍鬚和胎記。

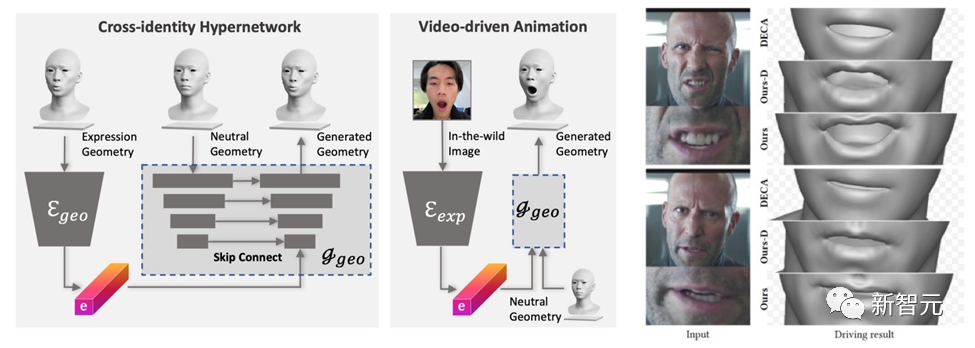

########################################## #DreamFace生成的模式具備動畫能力。與基於BlendShapes的方法不同,DreamFace的神經面部動畫方法透過預測獨特的變形來為生成的靜息(Neutral)模型賦予動畫效果,從而產生個性化的動畫。 ######

首先,訓練一個幾何生成器,學習表情的潛在空間,其中解碼器被擴展為以中性幾何形狀為條件。接著,進一步訓練表情編碼器,從RGB影像中提取表情特徵。因此,DreamFace能夠透過使用單目RGB影像以中性幾何形狀為條件來產生個人化的動畫。

與使用通用BlendShapes進行表情控制的DECA相比,DreamFace的框架提供了細緻的表情細節,並且能夠精細地捕捉表演。

本文介紹了DreamFace,一種文字指導的漸進式3D生成框架,它結合了最新的視覺-語言模型、隱式擴散模型,以及基於物理的材質擴散技術。

DreamFace的主要創新包括幾何體生成、基於物理的材質擴散生成和動畫能力生成。與傳統的3D生成方法相比,DreamFace具有更高的準確性、更快的運行速度和較好的CG管線相容性。

DreamFace的漸進式生成框架為解決複雜的3D生成任務提供了一個有效的解決方案,有望推動更多類似的研究和技術發展。

此外,基於物理的材質擴散生成和動畫能力生成將推動3D生成技術在影視製作、遊戲開發和其他相關行業的應用。

以上是上科大等發表DreamFace:只需文字即可產生「超寫實3D數位人」的詳細內容。更多資訊請關注PHP中文網其他相關文章!