今天看到一篇文章,說是Google洩漏了一份文件《我們沒有護城河,OpenAI也沒有》,描述了某位Google員工(非Google公司)對開源AI的看法,觀點很有意思,大致的意思是這樣的:

ChatGPT大火以後,各大廠商都對LLM趨之若鷯,瘋狂投入。

Google也在努力,希望能翻盤,但大家都無法贏得這場軍備競賽,因為第三者正在悄悄地吃掉這個大蛋糕。

這個第三方就是開源大模型。

開源大模型已經做到了:

1. 在Pixel 6上以每秒5個token的速度運行基礎的模型。

2. 一個晚上就可以在個人電腦上微調個性化的AI:

#雖然OpenAI和Google的模型在品質上有優勢,但是差距正以驚人的速度在縮小:

開源模型更快,可定制,更私密,功能更強。

開源大模型用100美元和13B的參數做事情,幾週內搞定;而Google 在1000萬美元和540B的參數下,在幾個月內苦苦掙扎。

當免費的,不受限制的替代品在質量上和封閉的模型有一拼的時候,人們肯定會拋棄封閉的模型。

這一切都從Facebook開源LLaMA開始,3月初,開源社群得到了這個真正有能力的基礎模型,雖然沒有instruction ,conversation tuning,沒有RLHF,社群立刻就意識到了這個東西的重要性。

隨後的創新簡直是瘋狂的,甚至以天為單位:

2-24 :Facebook 推出LLaMA,此時僅授權給研究機構,政府組織使用

#3-03 :LLaMA在網路上洩露,雖然不允許商用,但是突然之間,任何人都可以玩了。

3-12 :在Raspberry Pi上運行LLaMA,速度很慢,不實用

3-13:史丹佛發布了Alpaca,為LLaMA增加了instruction tuning,更「嚇人」的是,史丹佛的Eric J. Wang 使用一張RTX 4090 顯示卡,只用5 個小時就訓練了一個和Alpaca 水平相當的模型,將這類模型對算力的需求降到了消費級。

3-18:5天以後,Georgi Gerganov使用4位元quantization技術在MacBook CPU 上運行 LLaMA,它是第一個「無 GPU」解決方案。

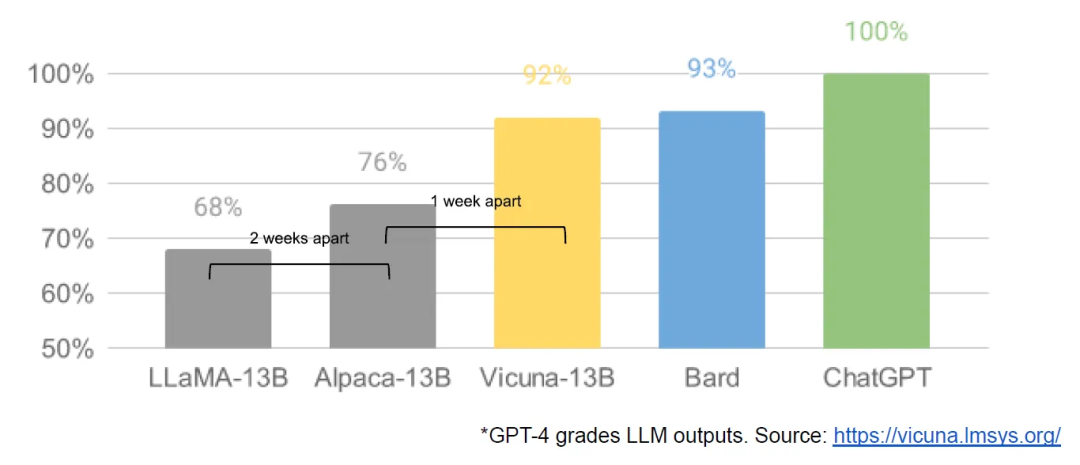

3-19:僅僅過了一天,加州大學柏克萊分校、CMU、史丹佛大學、加州大學聖地牙哥分校的研究人員聯合推出Vicuna,號稱達到了OpenAI ChatGPT 和Google Bard 90% 以上的質量,同時在超過90% 的情況下優於LLaMA 和Stanford Alpaca 等其他模型。

3-25:Nomic 創建了GPT4all,它既是模型,又是一個生態系統,我們第一次看到多個模型聚集在一個地方

......

就在一個月的時間內,instruction tuning、quantization、quality improvements、human evals、multimodality、RLHF等都出現了。

更重要的是,開源社群解決了可擴展的問題,訓練的門檻從大公司降低到了一個人,一個晚上和一台功能強大的個人電腦。

所以作者在最後說:OpenAI也跟我們一樣犯了錯,也頂不住開源的衝擊。我們要建立生態系統,讓開源為Google工作。

Google已經在Android和Chrome上應用了這個範式,並且獲得了巨大的成功。應該讓自己成為大模型開源的領導者,繼續鞏固自己作為思想領袖和領導者的地位。

說實話,這一個多月來大語言模型的發展真是讓人眼花撩亂,目不暇接,每天都處於被轟炸狀態。

這讓我想起了早年網路剛起步的時候,今天冒出一個令人興奮的網站,明天又冒出一個。還有行動網路爆發的時候,今天一個app火了,明天另外一個app又火了...

從我個人來講,我也不希望這些大語言模型被控制在巨頭手中,我們只能「寄生」在這些巨頭模型上,調用一下它的API,開發一點兒應用,這是很不爽的。最好是百花齊放,平民化,讓大家都能建立自己私有的模型。

現在訓練的成本小公司應該可以承受了,如果程式設計師有這個訓練的能力,結合下特定的行業和領域,也許是不錯的機會。

程式設計師要想熟練私有化大模型,除了原理之外,還是得自己動手練,我們星球也有幾十個人在組隊練習,雖然開源社群極大地降低了成本,但是要想訓練出一個有用的模型,這玩意兒對硬體環境要求還是太高,顯示卡很貴,RTX4090怎麼著也得上萬,肉疼,去雲端租一個GPU訓練價格更是不可控,訓練失敗,錢就白白丟掉了,這不像學習語言或框架,下載幾個安裝包就搞定,幾乎是零成本。

希望門檻進一步降低吧!

以上是Google內部文件外洩:開源大模型太可怕了,OpenAI也頂不住!的詳細內容。更多資訊請關注PHP中文網其他相關文章!