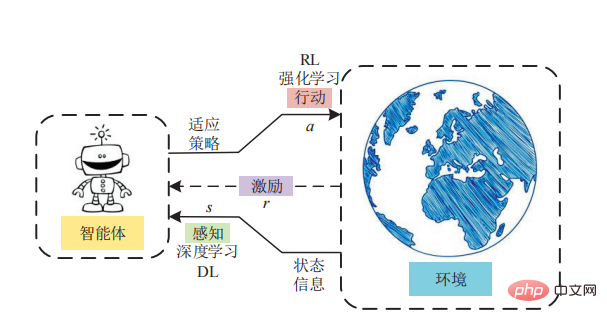

談到強化學習,許多研究人員的腎上腺素便不受控制地飆升!它在遊戲AI系統、現代機器人、晶片設計系統和其他應用中發揮著十分重要的作用。

強化學習演算法有許多不同的類型,但主要分為兩類:「基於模型的」和「無模型的」。

在與TechTalks的對話中,神經科學家、 「智能的誕生」一書的作者Daeyeol Lee分別討論了人類和動物強化學習的不同模式、人工智慧和自然智能,以及未來的研究方向。

19世紀後期,心理學家Edward Thorndike提出的「效果定律」成為了無模型強化學習的基礎。 Thorndike提出,在特定情境中具有正面影響的行為,在該情境中更有可能再次發生,而產生負面影響的行為則不太可能再發生。

Thorndike在一個實驗中探討了這個「效應定律」。 他把一隻貓放在一個迷宮盒子中,並測量貓從盒子中逃脫所需的時間。為了逃脫,貓必須操作一系列小工具,如繩子和槓桿。 Thorndike觀察到,當貓與謎盒互動時,它學會了有助於逃跑的行為。隨著時間的推移,貓逃離盒子的速度越來越快。 Thorndike的結論是,貓可以從其行為提供的獎勵和懲罰中進行學習。 「效應定律」後來為行為主義鋪平了道路。行為主義是心理學的一個分支,試圖從刺激和反應的角度來解釋人類和動物的行為。 「效應定律」也是無模型強化學習的基礎。在無模型強化學習中,透過主體感知世界,然後採取行動,同時衡量獎勵。

在無模型強化學習中,並不存在直接的知識或世界模型。 RL代理必須透過反覆試驗,直接去體驗每個動作的結果。

Thorndike的「效果定律」一直流行到1930年代。當時另一位心理學家Edward Tolman在探索老鼠如何快速學會走迷宮時發現了一個重要的洞見。在他的實驗中,Tolman意識到動物可以在沒有強化的情況下了解他們的環境。

例如,當老鼠在迷宮中被放出來時,它會自由地探索隧道,並逐漸了解環境的結構。如果隨後將這隻老鼠重新放進相同的環境,並提供強化訊號,例如尋找食物或尋找出口,那麼它可以比沒有探索過迷宮的動物更快到達目標。 Tolman稱之為「潛在學習」,這成為基於模型的強化學習的基礎。 「潛在學習」使動物和人類對他們的世界形成一種心理表徵,在他們的頭腦中模擬假設的場景,並預測結果。

基於模型的強化學習的優點是它消除了agent在環境中進行試誤的需要。 值得強調的一點是:基於模型的強化學習在開發能夠掌握國際象棋和圍棋等棋盤遊戲的人工智慧系統方面尤其成功,可能的原因是這些遊戲的環境是確定的。

通常來說,基於模型的強化學習會非常耗時,在對時間極度敏感的時候,可能會發生致命的危險。 Lee說:「在計算上,基於模型的強化學習要複雜得多。首先你必須獲得模型,進行心理模擬,然後你必須找到神經過程的軌跡,再採取行動。不過,基於模型的強化學習不一定就比無模型的RL複雜。」 當環境十分複雜時,倘若可以用一個相對簡單的模型(該模型可以快速獲得)進行建模,那麼模擬就會簡單得多,而且具有成本效益。

其实,无论是基于模型的强化学习还是无模型的强化学习都不是一个完美的解决方案。无论你在哪里看到一个强化学习系统解决一个复杂的问题,它都有可能是同时使用基于模型和无模型的强化学习,甚至可能更多形式的学习。 神经科学的研究表明,人类和动物都有多种学习方式,而大脑在任何特定时刻都在这些模式之间不断切换。 最近几年,人们对创造结合多种强化学习模式的人工智能系统越来越感兴趣。 加州大学圣地亚哥分校的科学家最近的研究表明,将无模型强化学习和基于模型的强化学习结合起来,可以在控制任务中取得卓越的表现。 Lee表示:「如果你看看像AlphaGo这样复杂的算法,它既有无模型的RL元素,也有基于模型的RL元素,它根据棋盘配置学习状态值,这基本上是无模型的 RL,但它同时也进行基于模型的前向搜索。」

尽管取得了显著的成就,强化学习的进展仍然缓慢。一旦RL模型面临复杂且不可预测的环境,其性能就会开始下降。

Lee说:「我认为我们的大脑是一个学习算法的复杂世界,它们已经进化到可以处理许多不同的情况。」

除了在这些学习模式之间不断切换之外,大脑还设法一直保持和更新它们,即使是在它们没有积极参与决策的情况下。

心理学家Daniel Kahneman表示:「维护不同的学习模块并同时更新它们是有助于提高人工智能系统的效率和准确性。」

我们还需要清楚另一件事——如何在AI系统中应用正确的归纳偏置,以确保它们以具有成本效益的方式学习正确的东西。 数十亿年的进化为人类和动物提供了有效学习所需的归纳偏置,同时使用尽可能少的数据。 归纳偏置可以理解为,从现实生活观察到的现象中,总结出规则,然后对模型做一定的约束,从而可以起到模型选择的作用,即从假设空间中选择出更符合现实规则的模型。 Lee说:「我们从环境中获得的信息非常少。使用这些信息,我们必须进行概括。原因是大脑存在归纳偏置,并且存在可以从一小组示例中概括出来的偏置。这是进化的产物,越来越多的神经科学家对此感兴趣。」 然而,虽然归纳偏置在物体识别任务中很容易理解,但在构建社会关系等抽象问题中就变得晦涩难懂。 未来,需要我们了解的还有很多~~~

https://thenextweb.com/news/everything-you-need-to-know-about-model-free-and-model-based-reinforcement-learning

以上是從老鼠在迷宮中行走到AlphaGo戰勝人類,強化學習的發展歷程的詳細內容。更多資訊請關注PHP中文網其他相關文章!