在許多學者看來,具身智能是通往 AGI 的一個非常有前途的方向,而 ChatGPT 的成功也離不開以強化學習為基礎的 RLHF 技術。 DeepMind vs. OpenAI,究竟誰能率先實現 AGI,答案似乎還未揭曉。

我們知道,創建通用的具身智能(即以敏捷、靈巧的方式在物理世界採取行動並像動物或人類一樣進行理解的智能體)是AI 研究者和機器人專家的長期目標之一。從時間上來看,創建具有複雜運動能力的智慧具身智能體可以追溯到很多年前,無論是在模擬還是真實世界中。

近年來進展速度大大加快,其中基於學習的方法發揮了重大作用。 例如深度強化學習已被證明能夠解決模擬角色的複雜運動控制問題,包括複雜、感知驅動的全身控製或多智能體行為。 同時,深度強化學習也越來越常應用於實體機器人。尤其是廣泛使用的高品質四足機器人,它們已經成為了透過學習產生一系列穩健運動行為的演示目標。

不過,靜態環境中的運動只是動物與人類部署其身體與世界互動的眾多方式的一部分,這種運動形態已在許多研究全身控制和運動操縱的工作中得到驗證,尤其是四足機器人。相關運動範例包括攀爬、運球或接球等足球技巧,以及使用腿部進行簡單操作。

其中對於足球運動來說,它展示了人類感覺運動智慧的許多特徵。足球的複雜性要求各種高敏捷和動態動作,包括跑動、轉身、迴避、踢球、傳球、跌倒爬起等。這些動作需要以多種方式進行組合。球員則需要對球、隊友和對方球員做出預測,並根據比賽環境調整動作。這種挑戰的多樣性已在機器人和 AI 社群中得到認可,並誕生了機器人世界盃 RoboCup。

不過應看到,踢好足球所需的敏捷、靈活和迅速反應以及這些要素之間的平滑過渡對於手動設計機器人來說挑戰很大且耗費時間。 近日,DeepMind(現已與Google大腦團隊合併為 Google DeepMind)的新論文探討了利用深度強化學習為雙足機器人學習敏捷的足球技巧。

#論文網址:https://arxiv.org/pdf/2304.13653 .pdf

專案首頁:https://sites.google.com/view/op3-soccer

在這篇論文中,研究者研究了動態多智能體環境中小型類人機器人的全身控制和物件互動。 他們考慮了整個足球問題的一個子集,訓練了一個具有 20 個可控關節的低成本微型類人機器人來玩 1 v1 足球比賽,並觀察本體感覺和比賽狀態特徵。 透過內建的控制器,機器人緩慢笨拙地移動。不過,研究者使用深度強化學習將智能體以自然流暢方式組合起來的動態敏捷的上下文自適應運動技巧(如走、跑、轉身以及踢球和跌倒爬起)合成為了複雜的長期行為。

在實驗中,智能體學會了預測球的運動、定位、阻擋、利用反彈球等。智能體在多智能體環境中出現這些行為得益於技能重複使用、端到端訓練和簡單獎勵的組合。研究者在模擬中訓練智能體並將它們遷移到實體機器人中,證明了即使對於低成本機器人而言,模擬到真實的遷移也是可能的。

用數據說話,機器人的行走速度提升了 156%,起身的時間減少了 63%,踢球的速度也比基準提升了 24%。

在進入技術解讀之前,我們先看一些機器人在 1v1 足球比賽中的精彩時刻。例如射門:

罰點球:

轉向、盤帶和踢球,一氣呵成

#:

#實驗設定

#實驗設定

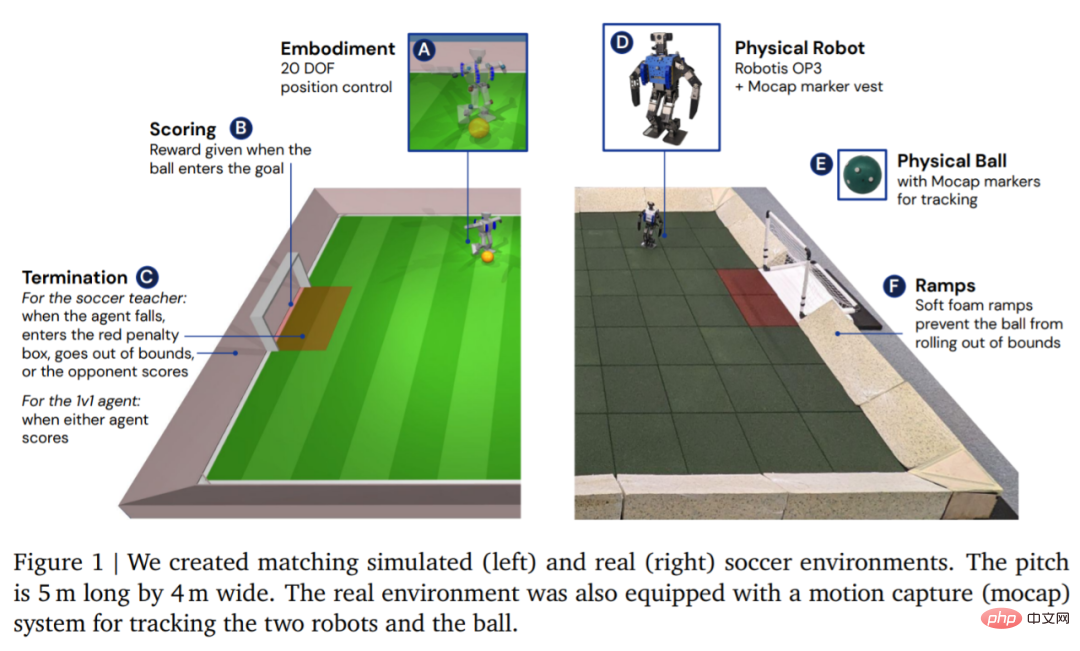

環境方面,DeepMind 首先在自訂的足球環境中模擬訓練智能體,然後將策略遷移到對應的真實環境中,如圖 1 所示。環境包括一個長 5 公尺、寬 4 公尺的足球場,以及兩個球門,每個球門的開口寬度均為 0.8 公尺。在模擬和真實環境中,球場都以坡道為界,確保球在界內。真正的球場上舖有橡膠地磚,以減少摔倒損壞機器人的風險並增加地面摩擦。

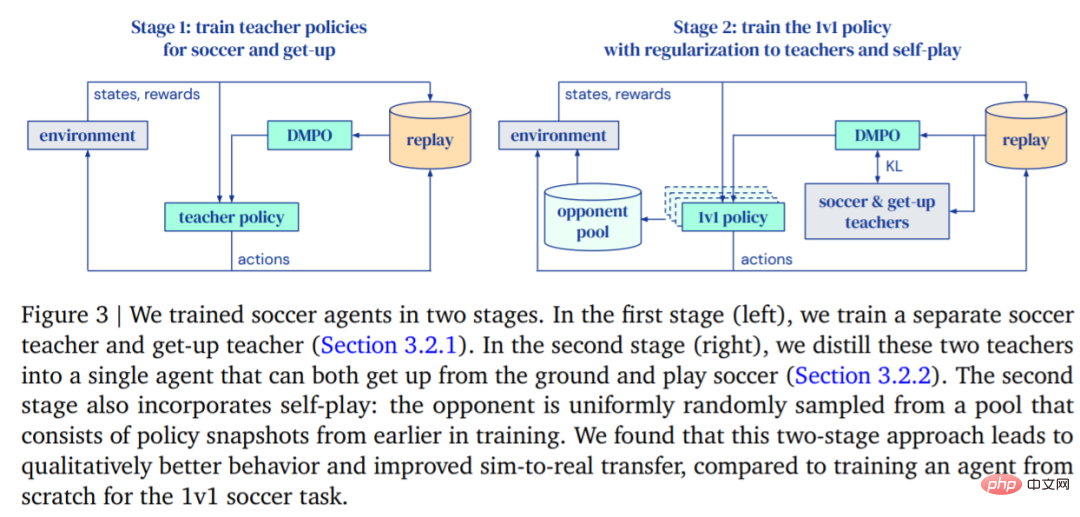

#DeepMind 的目標是訓練可以走路、踢球、起身、防守、懂得如何得分的智能體,然後再將這些功能遷移到真正的機器人身上。 DeepMind 將訓練分成兩個階段進行,如圖 3 所示。

在第一階段,DeepMind 針對兩種特定技能訓練教師策略,這兩種技能包括智能體從地面上站起來和得分。

在第一階段,DeepMind 針對兩種特定技能訓練教師策略,這兩種技能包括智能體從地面上站起來和得分。

在第二階段,第一階段的教師策略被用來規範智能體,同時智能體學會有效對抗越來越強大的對手。

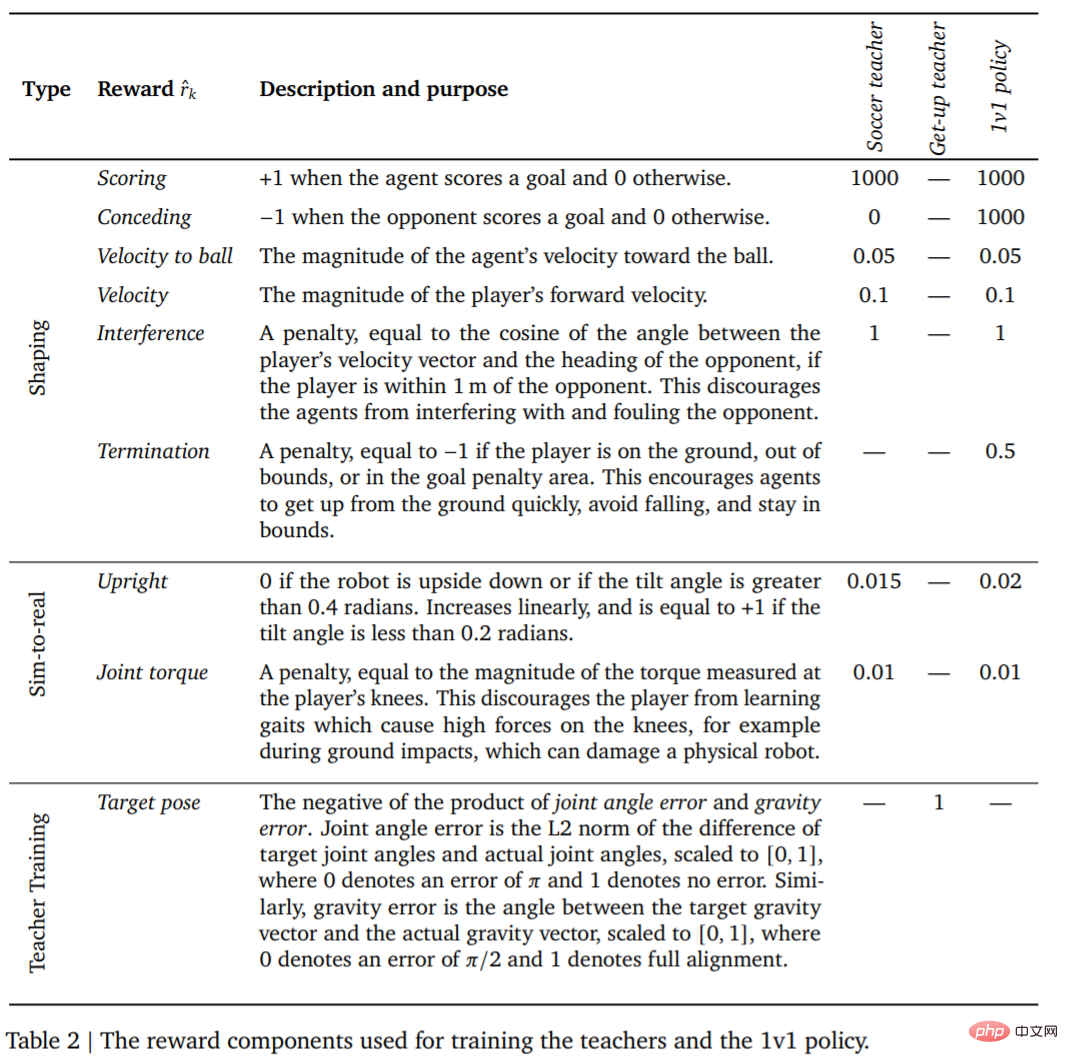

#####################訓練#########首先是教師訓練。教師需要接受盡可能多的進球訓練。當智能體摔倒、出界、進入禁區 (圖 1 中以紅色標記) 或對手得分時,這一回合(Episodes)終止。在每一回合的開始,對智能體、另一方和球在球場上的隨機位置和方向進行初始化。雙方都初始化為預設站姿。對手使用未經訓練的策略進行初始化,因此,智能體在這個階段學會避開對手,但不會發生進一步複雜的互動。此外,每個訓練階段的獎勵及其權重如表 2 所示。 ###########################接著智能體與越來越強大的對手競爭,同時將其行為規範到教師策略。這樣一來智能體能夠掌握一系列足球技能:行走、踢球、起身、得分和防守。當智能體出界或在球門禁區內時,它會在每個時間步受到固定的懲罰。 ######智能體訓練好後,接下來就是將訓練好的踢球策略零樣本遷移到真實機器人。為了提高零樣本遷移成功率,DeepMind 透過簡單的系統識別減少了模擬智能體與真實機器人的差距,透過訓練期間的領域隨機化和擾動提高了策略的穩健性,以及包括塑造獎勵策略以獲得不太可能損害機器人的行為。

1v1 比賽:足球智能體可以處理多種緊急行為,包括靈活的運動技能,例如從地面起身、快速從跌倒中恢復、奔跑和轉身。在遊戲過程中,智能體以流暢的方式在所有這些技能之間轉換。

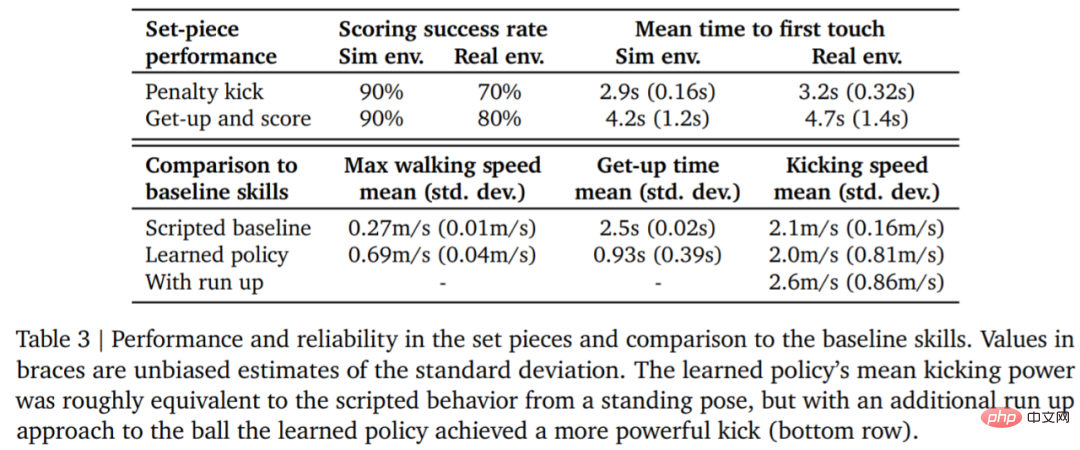

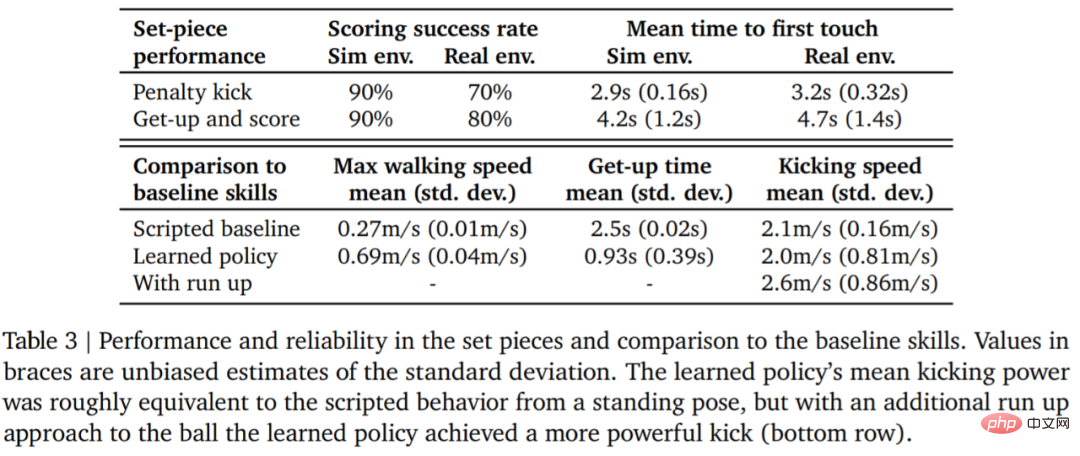

下表 3 為量化分析結果。從結果可以看出強化學習策略比專門的人工設計的技能表現更好,智能體的行走速度快了 156%,起身時間少了 63%。

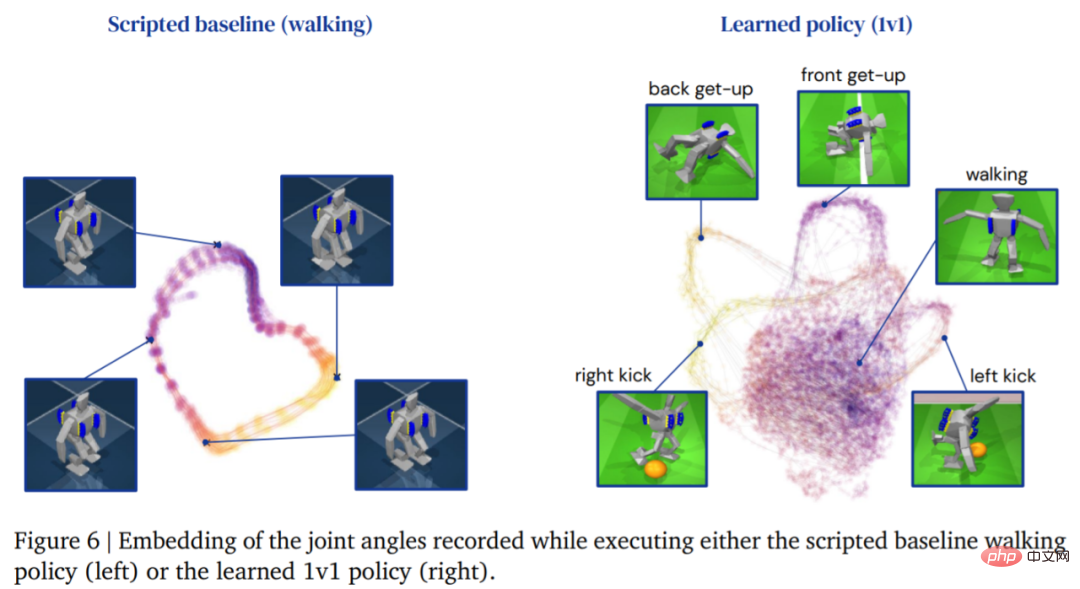

下圖為智能體的行走軌跡,相較之下,由學習策略產生的智能體軌跡結構更豐富:

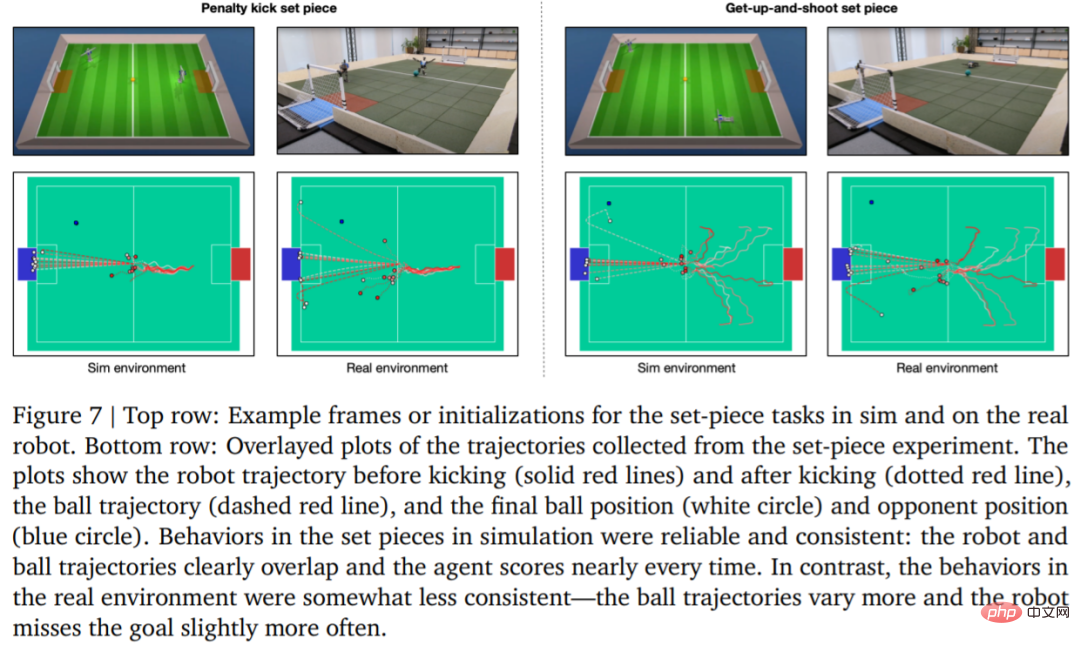

為了評估學習策略的可靠性,DeepMind 設計了點球和起跳射門定位球,並在模擬環境和真實環境中實現。初始配置如圖 7 所示。

在真實環境中,機器人在罰球任務中10 次中了7 次(70%),在起射任務中10 次中了8 次(80%)。而在模擬實驗中,智能體在這兩項任務中的得分較為一致,顯示智能體的訓練策略遷移到真實環境(包括真實機器人、球、地板表面等),表現略有下降,行為差異有所增加,但機器人仍然能夠可靠地起身、踢球和得分。結果如圖 7 和表 3 所示。

以上是DeepMind為何缺席GPT盛宴?原來在教小機器人踢足球的詳細內容。更多資訊請關注PHP中文網其他相關文章!