「上得廳堂,下得廚房」,這句對理想型賢內助的讚許,以後很可能要對谷歌的機器人說了。

自備大型語言模型,會自學的機器人,看過嗎?不會做?可以學! 現在不會沒關係,過一會兒學完了就會了。

比起波士頓動力酷炫無比的上刀山,下火海,翻山越嶺,如履平地的「鐵面金剛」,這次谷歌搞的「會學習的機器人」更像是身邊貼心的小助手。 我說什麼,你做什麼,是一般的機器人執行指令的套路。谷歌這次的新研究,讓機器人不只按指令,自己也能動手做。

這是Google首次將語言大模型和機器人結合,教導機器人做人類一樣的事情。

論文網址:https://arxiv.org/pdf/2204.01691.pdf用Google論文的題目說就是:「Do as I can,not as I say」。

大概是這個意思:「你已經是個成熟的機器人了,我做的,你也能做,不會的可以學,不熟的可以練! 」 谷歌為這個機器人取名為PaLM-SayCan。 在《華盛頓郵報》的報導中,記者見到了研究人員讓機器人用塑膠玩具原料作漢堡。 看起來這個機械手臂知道在放肉之後、放生菜之前,要加點番茄醬,但目前這位廚師認為,「加番茄醬」是把整顆番茄醬的瓶子放在漢堡裡。

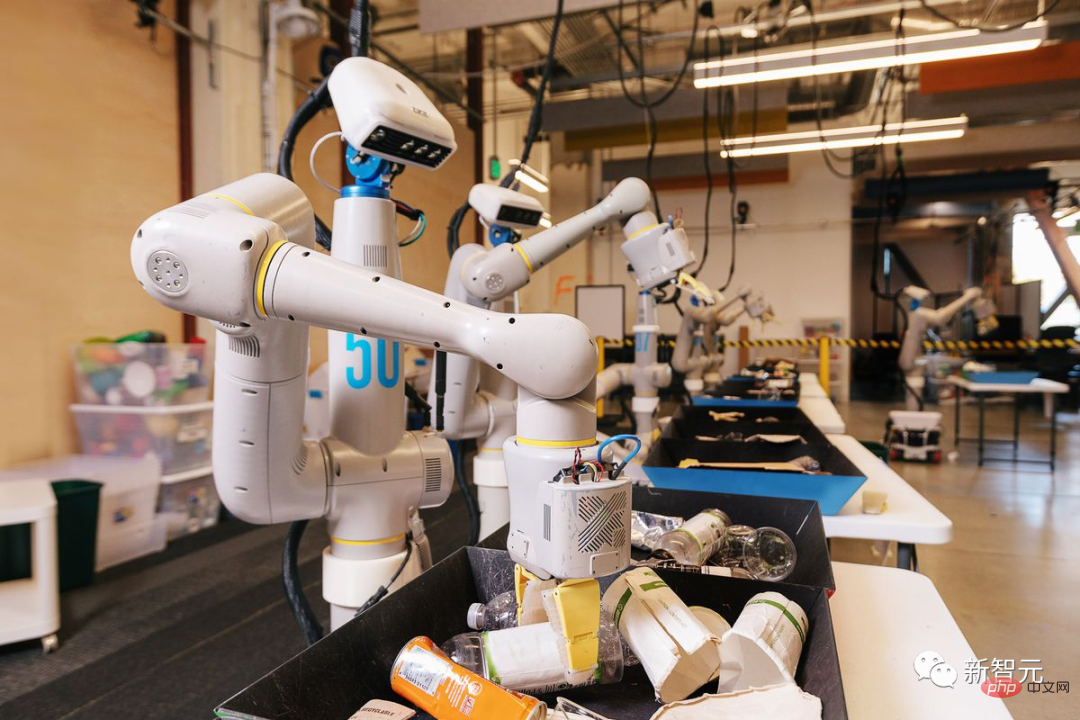

雖然目前這個機器人主廚還不合格,不過Google相信,在大語言模型的訓練下,學會做漢堡只是早晚的事。 這個機器人還能辨識七喜和可口可樂的罐子,打開抽屜並找到一袋薯片。憑藉PaLM的抽象能力,它甚至可以理解黃色、綠色和藍色的碗可以分別比喻為沙漠、叢林和海洋。

和以前的機器人不同,過去也有機器人做漢堡、做炒麵、做披薩,但實際上完成的是單一動作的明確指令的組合,例如「右臂左移三格」、「翻個面」等。 現在Google的目的是,讓機器人能聽懂並執行「來為我做個漢堡」、「我餓了,去給我買個麵包」、「出去陪我打個球」這種指令。 就跟和人說話一樣。

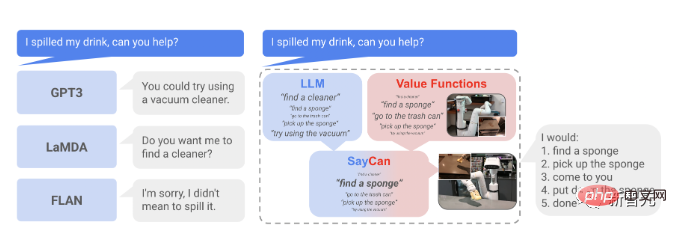

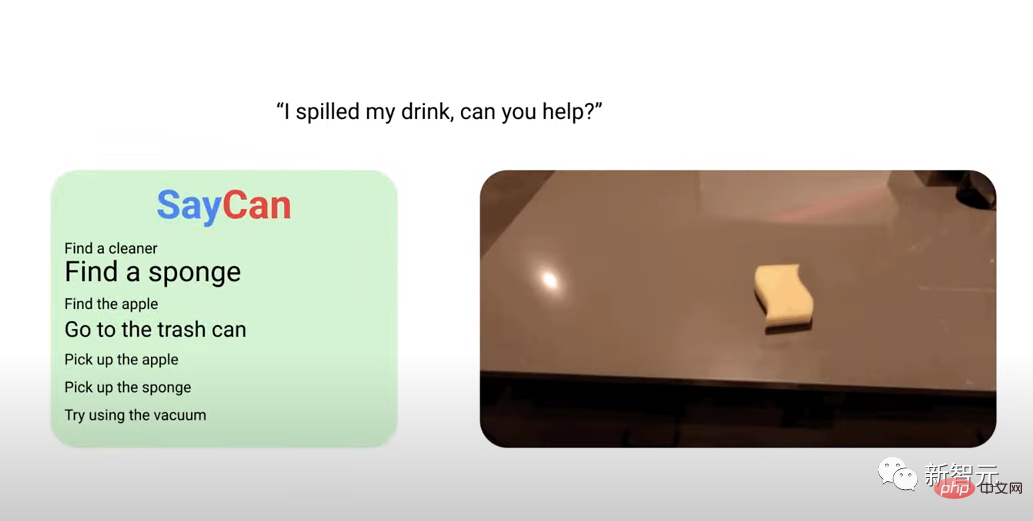

例如,當Google人工智慧研究員對PaLM-SayCan機器人說:「我的飲料灑了,你能幫忙嗎?」 它在Google辦公大樓的廚房裡用輪子滑行,用數位相機的視覺發現櫃檯上的海綿,用電動臂抓住它,並把它帶回來。

Google的布萊恩·伊克特(Brian Ichter)說:「這從根本上說是一種不同的模式」。他是最近發布的一篇描述這類機器人新進展的論文的作者之一。

目前,機器人已經不算稀罕物了。數以百萬計的機器人在世界各地的工廠工作,但它們遵循特定的指令,通常只專注於一兩項任務。 而要打造一個能夠完成一系列任務,還能邊幹邊學的機器人,則要複雜得多。多年來,大大小小的科技公司都在努力建造這種「通用型機器人」。

近年來大火的大語言模式讓Google找到了「通用機器人」的研發靈感。 大型語言模式利用網路上的大量文本,訓練AI軟體,以猜測某些問題或評論之後可能出現的反應類型。

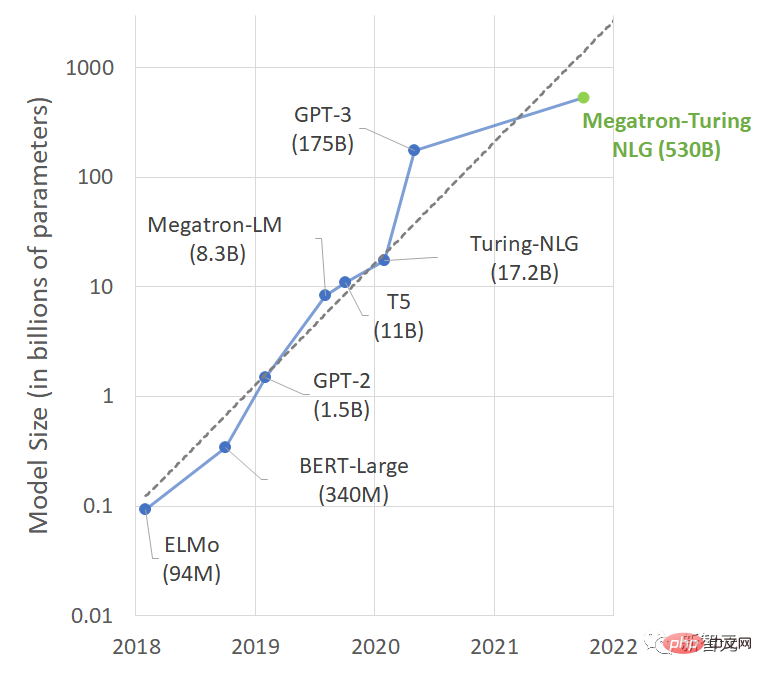

從BERT到GPT-3,再到後來的MT-NLP,隨著參數數量的突飛猛進,這些模型已經非常善於預測正確的反應,以至於與模型打交道往往感覺像是在與一個知識淵博的人對話。 掌握這麼多知識,光陪人聊個天豈不是可惜?能對話,就能工作,從聊天機器人,到助手機器人,Google的研究想法可以說算是「水到渠成」了。

這次,Google AI與Google母公司Alphabet的登月計畫X團隊推出的Everyday Robot計畫合作,提出了一種方法。 即透過預先訓練在大型語言模式(LLM)中提取知識,讓機器人遵循高階文字指令完成物理任務。

Everyday Robot專案已經進行了多年,許多與GoogleAI合作的團隊成員在2015年或2016年加入了Alphabet。 他們的想法是,讓機器人利用攝影機和複雜的機器學習演算法來查看周圍世界並向之學習,而無需教導它們可能遇到的每一種潛在情況。

#Google的想法是: 大型語言模式可以編碼豐富的關於世界的語意知識,這些知識對於旨在執行以自然語言任務機器人非常有用。 而LLM的明顯缺點是「缺乏真實世界的經驗」,在實驗室裡表現完美,到了現實生活中可能就一無是處。

因此研究人員建議「透過預訓練技能提供現實世界的基礎」,用於約束模型完成符合環境的自然語言動作。

機器人可以充當語言模型的“手和眼睛”,而語言模型則提供有關任務的高級語義知識/現實經驗。

Google使用了一台巨大的6144個處理器的機器來訓練PaLM(Pathways Language Model)。訓練資源包括在微軟GitHub網站上發現的大量多語言網路檔案、書籍、維基百科文章、對話和程式碼。 這樣訓練出的AI智能體,可以解釋笑話、完成句子、回答問題並依照自己的思考鏈進行推理。

接下來問題來了,如果把這個智能體用於機器人,如何提取和利用大型語言模型(LLM)的知識來完成物理任務呢? 例如,我的飲料灑了,GPT-3會說你可以用吸塵器,LaMDA會說你需要我幫你找清潔器嗎? (就很迷)

大型語言模型由於並未與現實環境交互,因此無法對這項操作反應。 而基於LLM的SayCan透過預訓練模型形成的價值判斷能力,可以處理複雜、真實環境下的指令。

受這個例子的啟發,我們研究瞭如何在LLM中提取知識以使機器人能夠遵循高級文字指令的問題。 該機器人配備了一系列學習技能,用於能夠進行低階視覺運動控制的「原子」行為。 除了要求LLM簡單地解釋指示外,我們還可以使用它來評估個人技能在完成高級指令方面取得進展的可能性。

#假設每個技能都有一個可供量函數,那麼就可以量化它從當前狀態成功的可能性(例如學習價值函數),而這個值則可以衡量技能的可能性。 這樣LLM就完成了每個技能對完成指令貢獻機率的描述。

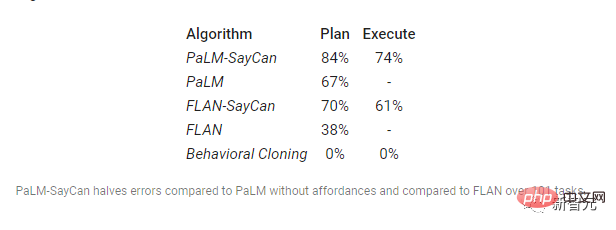

研究者使用兩個指標來評估系統的表現:

(1)計畫成功率,顯示機器人是否為指令選擇了正確的技能;

(2)執行成功率,顯示它是否成功執行了指令。

資料顯示,PaLM-SayCan的指令執行率在所有模型中也是最高的。

想法很頂,不過這項工作也不是毫無風險。 大型語言模式的訓練語料庫來自互聯網,一些語言模式已經表現出種族主義或性別歧視等不良傾向,有時會被誘導發表仇恨言論或說謊。 這個模型如果用來訓練聊天機器人,結果也就是出了個會罵街、會嚼舌根的語音助手,但如果是訓練機器人,它有手有腳的,去乾壞事怎麼辦?

而且,比這更危險的是,萬一這樣訓練出的機器人有了意識,事情可能就會失控了(類似的科幻電影可不少了)。

今年7月,Google一名員工聲稱軟體是有生命的員工。人工智慧專家的共識是,這些模型不是有生命的,但許多人擔心它們會表現出偏見,因為它們是在大量未經過濾的、由人類產生的文本上訓練的。

儘管如此,Google仍在不斷努力,現在,研究人員已經不需要為機器人的每項任務編碼具體的技術指令,而是可以更簡單地用日常語言與它們交談。 更重要的是,新軟體可以幫助機器人自行解析複雜的多步驟指令。

現在,機器人可以解釋它們從未聽過的指令,並自己想出有意義的反應和行動。

也許對機器人來說,新的大門才剛打開,未來或許仍是一個漫長的過程。多年來,神經網路和強化學習等人工智慧技術已被用於訓練機器人。目前有了一些突破,但進展仍然緩慢。

Google的機器人還遠遠沒有準備好用於現實世界,研究人員一再表示,目前這個機器人還處於實驗室階段,還沒有推向商業化的計畫。

以上是有事您說話!谷歌機器人「吃了」語言大模型後,會自學思考了的詳細內容。更多資訊請關注PHP中文網其他相關文章!