ChatGPT 的發布,攪動了整個 AI 領域,各大科技公司、新創公司以及大學團隊都在跟進。近段時間,機器之心通報了多家新創公司、大學團隊的研究成果。

昨日,又一國產AI 對話大模型重磅登場:由清華技術成果轉化的公司智譜AI 基於GLM-130B 千億基座模型的ChatGLM 現已開啟邀請制內測。

值得一提的是,此次智譜 AI 也開源了中英雙語對話模型 ChatGLM-6B,支援在單張消費級顯示卡上進行推理使用。

#內測申請網址:chatglm.cn

據了解,ChatGLM 目前版本模型的能力提升主要來自獨特的千億基座模型GLM-130B。它是不同於 BERT、GPT-3 以及 T5 的架構,是一個包含多目標函數的自回歸預訓練模型。

2022 年8 月,清華大學聯合智譜AI 向研究界和工業界開放了擁有1300 億參數的中英雙語稠密模型GLM-130B,該模型有一些獨特的優點:

如今, 參考ChatGPT 的設計思路,ChatGLM 在千億基座模型GLM-130B 中註入了代碼預訓練,透過有監督微調(Supervised Fine-Tuning)等技術實現人類意圖對齊。

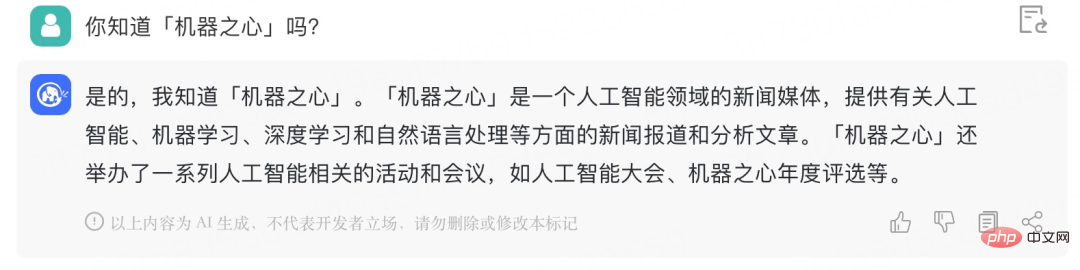

機器之心獲得了內測邀請碼,這裡簡單和ChatGLM 進行了對話,效果如下:

它能夠理解「站CP」的實際涵義:

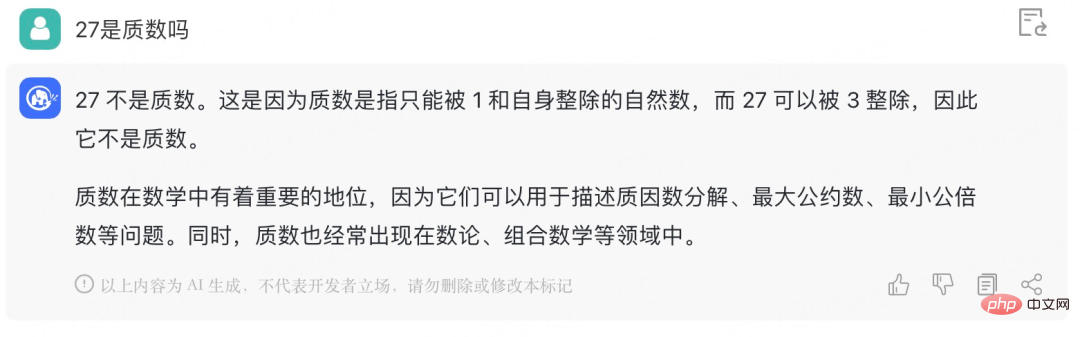

#給ChatGLM 一個數學問題試試:

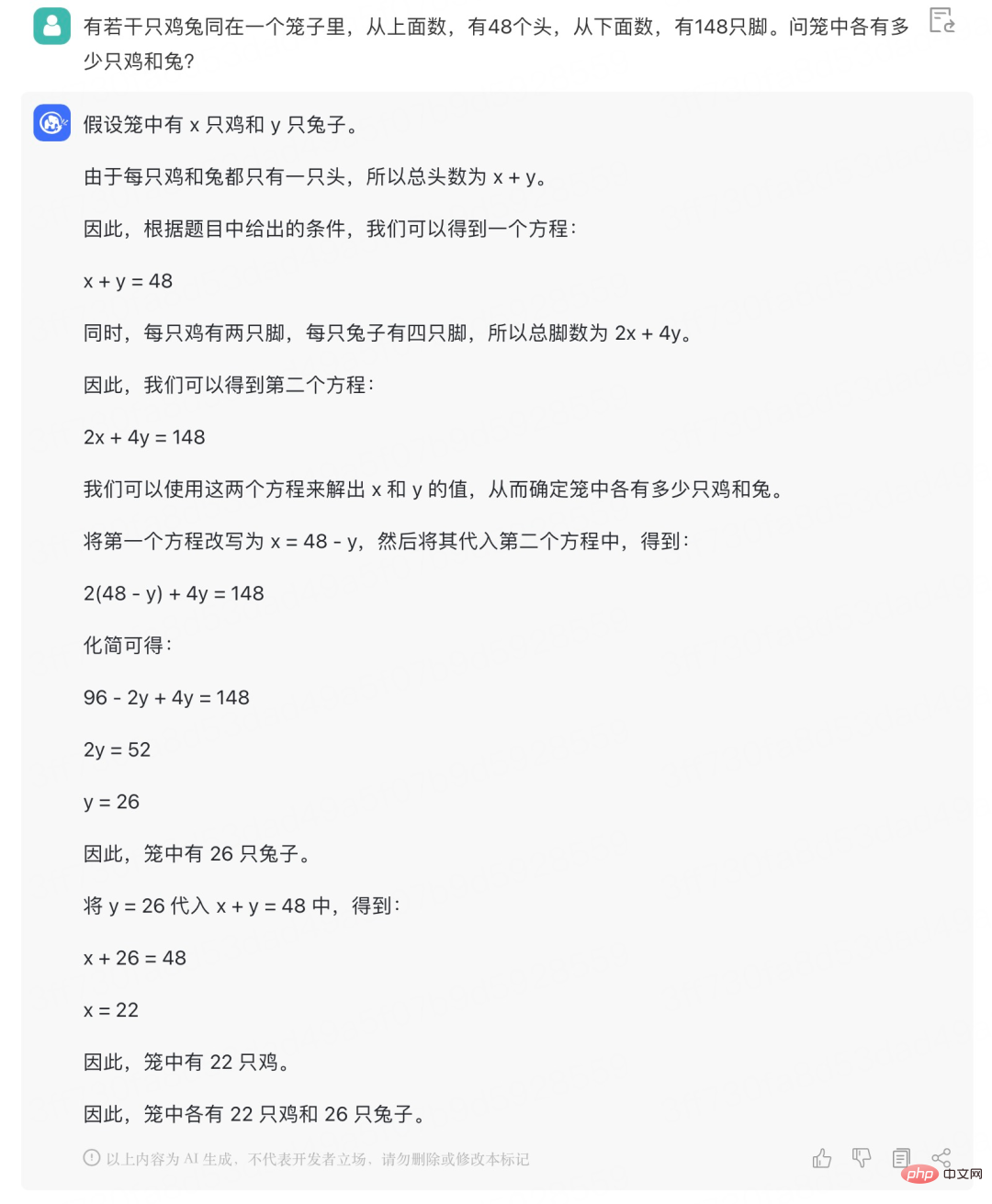

自從學會了二元一次方程,像這種基礎的「雞兔同籠」問題就再也難不倒它了:

ChatGLM-6B 是一個開源的、支援中英雙語問答的對話語言模型,並針對中文進行了最佳化。該模型基於 General Language Model (GLM) 架構,具有 62 億參數。結合模型量化技術,使用者可以在消費級的顯示卡上進行本地部署(INT4 量化等級下最低只需 6GB 記憶體)。 ChatGLM-6B 使用了和 ChatGLM 相同的技術,針對中文問答和對話進行了最佳化。經過約1T 標識符的中英雙語訓練,輔以監督微調、反饋自助、人類反饋強化學習等技術的加持,62 億參數的ChatGLM-6B 雖然規模不及千億模型,但大大降低了推理成本,提升了效率,並且已經能產生相當符合人類偏好的回答。

模型開源位址:https://github.com/THUDM/ChatGLM-6B

具體來說,ChatGLM-6B 具備以下特點:

不過由於ChatGLM-6B 模型的容量較小,不可避免的存在一些限制和不足,包括:

GLM 團隊表示,ChatGLM 距離國際頂尖大模型研究和產品仍有一定差距,未來將持續研發並開源更新版本的 ChatGLM 和相關模型。 GLM 團隊也歡迎大家下載 ChatGLM-6B,基於它進行研究和(非商用)應用程式開發。

以上是清華系千億基座對話模型ChatGLM啟動內測,開源單卡版模型的詳細內容。更多資訊請關注PHP中文網其他相關文章!