2022年底OpenAI推出ChatGPT,其爆火程度一直持續到今天,這個模型簡直就是行走的流量,所到之處必將引起一番討論狂潮。

各大科技公司、機構、甚至是個人,紛紛加緊研發類ChatGPT產品。同時,微軟將ChatGPT接入必應,幾乎前後腳,Google發布Bard為搜尋引擎提供動力。英偉達 CEO 黃仁勳對ChatGPT給與了一個很高的評價,他表示,ChatGPT 是人工智慧領域的 iPhone 時刻,也是運算領域有史以來最偉大的技術之一。

很多人對對話式AI已經到來深信不疑,但這類模型真的完美無缺嗎?不見得,在它們身上總會出現一些荒誕的時刻(uncanny moments),例如隨意發表不受約束的言論,或者喋喋不休地說出接管世界的計劃等。

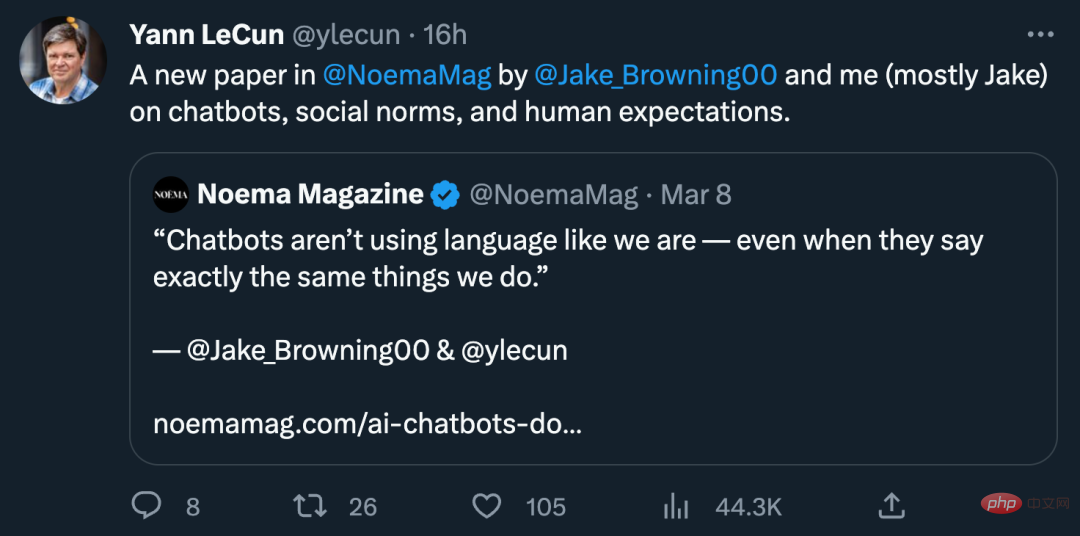

為了理解對話式AI這些荒誕時刻,由深度學習三巨頭之一的Yann LeCun以及紐約大學計算機科學系博士後Jacob Browning等人聯合撰寫了一篇文章《AI Chatbots Don't Care About Your Social Norms》,文中討論了對話式AI的三個面向:聊天機器人、社會規範和人類期望。

文中談到,人類非常善於避免口誤,不讓自己做出失誤和失禮的言行。相比之下,聊天機器人卻常常犯錯。因此理解為什麼人類擅長避免出錯,可以更好的幫助我們理解目前聊天機器人為何不能被信任。

對GPT-3來說,犯錯的方式包括模型統計不準確。 GPT-3比較依賴使用者提示,它對情境、情境等的理解只關注從使用者的提示中可以得到什麼。 ChatGPT也是如此,不過後者以一種新穎而有趣的方式稍作修改。除了統計學外,模型的反應也被人類評估員強化了。對於系統的輸出,人類評估員會進行強化,使其輸出良好的反應。最終結果是,這個系統不僅會說一些看似合理的東西,而且(理想情況下)還會說一些人類會判斷為合適的東西——即便是模型說錯了話,至少不會冒犯別人。

但這種方法給人的感覺太機械。在人類對話中,有無數種方法可以說錯話:我們可以說一些不恰當的、不誠實的、令人困惑的或只是愚蠢的事情。我們甚至在說正確的事情時,由於說的語氣或語調不對而受到指責。我們在與他人打交道的過程中,會穿越無數的「對話雷區」。控制自己不說錯話不僅僅是對話的重要部分,它往往比對話本身更重要。有時,閉上嘴巴可能是唯一正確的行動方案。

這就引出兩個問題:我們該如何駕馭模型這種不說錯話的危險局面?以及為什麼聊天機器人不能有效地控制自己不說錯話?

人類對話可以涉及任意話題,就像腳本化了一樣:餐廳點餐,閒聊,為遲到道歉等等。不過這些不是文字腳本,中間充滿了即興創作,所以人類的這種對話模型才是比較一般的模式,規則也沒有那麼嚴格。

人類這種腳本化的言行不受文字制約。即使你不懂語言,同樣的腳本也能發揮作用,例如打一個手勢就知道對方想要什麼。社會規範支配這些腳本,幫助我們駕馭生活。這些規範規定了每個人在某些情況下的行為方式,為每個人分配了角色,並對如何行動給予了廣泛的指導。遵循規範是有用的:它透過標準化和流程化來簡化我們的交互,使彼此更容易預測對方意圖。

人類已經制定了慣例和規範來管理我們社會生活的每個方面,從使用什麼叉子到在按喇叭之前應該等待多長時間。這對在數十億人的世界中生存至關重要,在這個世界上,我們遇到的大多數人都是完全陌生的人,他們的信仰可能與我們不一致。將這些共同的規範落實到位不僅可以使對話成為可能,而且會富有成果,列出我們應該談論的內容——以及我們不應該談論的所有事情。

人類傾向於制裁那些違反規範的人,有時會公開,有時會秘密進行。社會規範使得評估一個陌生人變得非常簡單,例如,在第一次約會時,透過對話以及提問等方式,雙方會評估對方的行為,如果對方違反了其中一條規範——例如,如果他們表現得粗魯或不恰當——我們通常會評判他們並拒絕第二次約會。

對人類來說,這些評判不僅是基於冷靜的分析,更進一步的是基於我們對世界的情感反應。我們小時候接受的部分教育是情緒訓練,以確保我們在對話中在正確的時間給出正確的情緒:當有人違反禮儀規範時感到憤怒,當有人說出冒犯性的話時感到厭惡,當我們說謊時感到羞恥。我們的道德良知使我們能夠在對話中對任何不恰當的事情做出快速反應,並預測其他人將如何對我們的言論做出反應。

但不只如此,一個違反了簡單規範的人,他的整個性格都會被質疑。如果他在一件事情上撒了謊,那麼會不會在其他事情上說謊呢?因此,公開是為了讓對方感到羞恥,並在過程中迫使對方為自己的行為道歉(或至少為自身行為辯護)。規範也得到了加強。

簡而言之,人類應該嚴格遵守社會規範,否則說出的話有很高的風險。我們要為自己所說的任何事情負責,所以要謹慎地選擇說話,並希望周圍的人也是如此。

人類對話的高風險揭示了什麼讓聊天機器人如此令人不安。透過僅僅預測對話如何進行,它們最終鬆散地遵守人類的規範,但它們不受這些規範的約束。當我們與聊天機器人隨意交談或測試它們解決語言難題的能力時,它們通常會給出一些似是而非的答案,並表現得像人類一樣正常。有人甚至可能會將聊天機器人誤認為人。

但是,如果我們稍微更改prompt或使用不同的腳本,聊天機器人會突然吐出陰謀論、種族主義長篇大論或胡說八道。這可能是因為它們接受了陰謀論者、噴子等 Reddit和其他平台上寫的內容的訓練。

我們中的任何人都有可能說出像噴子一樣的話,但我們不應該說,因為噴子的話充斥著胡說八道、冒犯性言論、殘忍和不誠實。我們大多數人不說這些話,也是因為自己不相信它們的。體面的規範已經將冒犯性行為推向了社會邊緣,所以我們中的大多數人也不敢這樣的話。

相比之下,聊天機器人不會意識到有些話是它們不應該說的,無論這些話在統計上的可能性有多大。它們意識不到定義了該說與不該說之間界線的社會規範,也察覺不到影響我們使用語言的深層社會壓力。即使聊天機器人承認搞砸並道歉了,它們也不明白為什麼。如果我們指出它們錯了,聊天機器人甚至會道歉以獲得正確的答案。

這闡明了更深層的問題:我們希望人類說話者能夠忠實於他們所說的話,並且要求他們對此負責。我們不需要檢查他們的大腦或了解任何心理學來做到這一點,只需要知道他們一貫可靠、遵守規範和行為上尊重他人,則會相信他們。聊天機器人的問題不在於「黑盒子」或技術不熟悉,而是因為長期以來不可靠和令人反感,並且沒有努力改進甚至沒有意識到存在問題。

開發人員當然知道這些問題。他們以及希望自身AI技術被廣泛應用的公司擔心自己的聊天機器人的聲譽,並花大量時間重組系統以避免對話困難或消除不當回答。雖然這有助於使聊天機器人更安全,但開發人員需要竭力走到試圖破壞它們的人的前面。因此,開發人員的方法是被動的,而且總是落後:有太多的錯誤方式無法預測。

這不應該讓我們自鳴得意人類有多聰明,聊天機器人有多笨。相反,它們無所不談的能力展現了對人類社會生活和整個世界的深刻(或膚淺)的了解。聊天機器人非常聰明,至少能在測驗中取得好成績或提供有用資訊的參考。聊天機器人在教育工作者中引起的恐慌足以說明它們在書本知識學習上令人印象深刻。

但問題在於聊天機器人不在乎(care)。它們沒有任何想要透過對話實現的內在目標,也不受他人想法或反應的激勵。它們不會因說謊而感到難過,它們的誠實也不會得到回報。它們在某種程度是無恥的,甚至連川普都非常關心自己的聲譽,至少聲稱自己是誠實的。

因此,聊天機器人的對話是無意義的。對人類來說,對話是獲得我們想要的東西的一種方式,例如建立聯繫、在專案上獲得幫助、打發時間或了解一些東西。對話要求我們對對話的人感興趣,理想情況下應該要關心對方。

即使我們不關心對話的人,至少在乎對方對自己的看法。我們深深意識到,人生的成功(例如擁有親密關係、做好工作等)取決於擁有好的聲譽。如果我們的社會地位下降,就可能失去一切。對話塑造了他人對我們的看法,許多人透過內心獨白塑造對自己的認知。

但是聊天機器人沒有自己的故事可以講述,也沒有聲譽可以捍衛,它們不像我們一樣能感受到負責任行動的吸引力。聊天機器人可以並且在許多高度腳本化的情況下發揮作用,從玩地下城主、撰寫合理的副本或幫助作者探索思路,等等。不過它們缺乏對自己或他人的了解,無法成為值得信賴的社會代理人,也就是我們大多數時候希望與之交談的那類人。

如果不了解有關誠實和體面的規範,也不關心自己的聲譽,那麼聊天機器人的用處就會受限,依賴它們也會帶來真正的危險。

因此,聊天機器人並不是以人類的方式對話,而且它們永遠不可能僅透過統計學上似乎可信的談話達到目的。如果缺少對社會世界的真正了解,這些AI系統就只是無聊的話癆罷了,無論表現得多麼機智或雄辯。

這有助於闡明為什麼這些AI系統只是非常有趣的工具以及為什麼人類不應該將它們擬人化。人類不僅是冷靜的思考者或演說者,在本質上還是遵守規範的生物,透過共同的、強制性的期望在情感上相互建立聯繫。人類的思維和言語源自於自身的社會性。

單純的對話脫離了廣泛的世界參與,與人類沒有什麼共同之處。聊天機器人不是像我們一樣使用語言,即使它們有時說的話與我們完全相同。可歸根到底,它們不懂我們為什麼這樣說話,這是顯而易見的。

以上是Yann LeCun:不在乎社會規範,ChatGPT離真正的人還差得遠的詳細內容。更多資訊請關注PHP中文網其他相關文章!