ChatGPT紅遍網絡,其背後的AI模型訓練也廣受關注。 IBM研究部門日前宣布,其開發的雲端原生超級電腦Vela可以快速部署並用於訓練基礎AI模型。自2022年5月以來,該公司數十名研究人員一直在使用這款超級電腦訓練具有數百億參數的AI模型。

基礎模型是基於大量未標記資料訓練的AI模型,它們的通用性意味著只需微調即可用於一系列不同的任務。它們的規模非常龐大,需要大量且成本高昂的運算能力。因此正如專家表示,運算能力將成為開發下一代大規模基礎模型的最大瓶頸,訓練它們需要花費大量算力和時間。

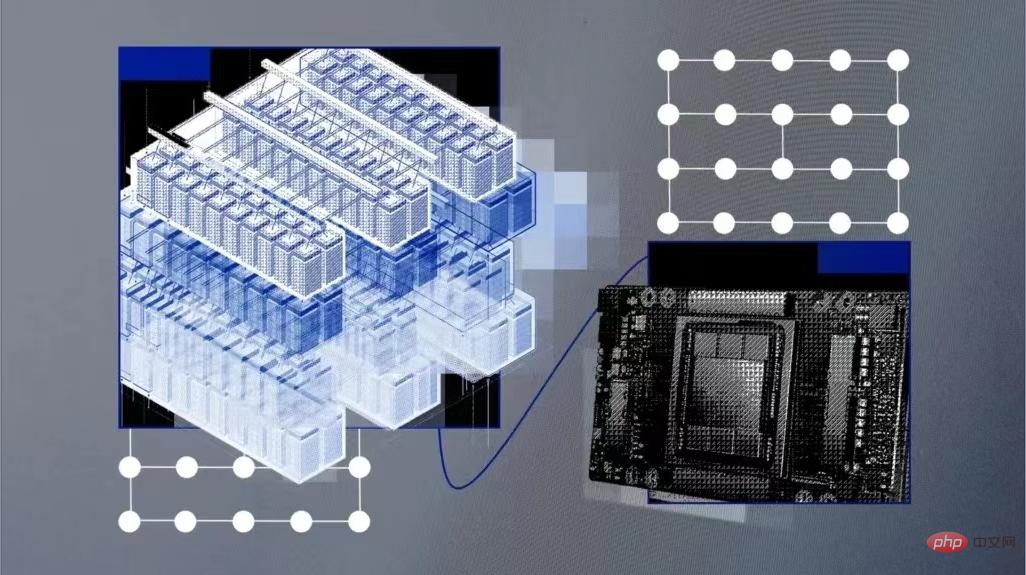

訓練可以運行數百億個或數千億個參數的模型,需要採用高效能的運算硬件,包括網路、平行檔案系統和裸機節點等。這些硬體很難部署,運作成本也很高。微軟於2020年5月為OpenAI建造了AI超級計算機,並託管在Azure雲端平台中。但IBM表示,它們是由硬體驅動的,這增加了成本,並限制了靈活性。

雲端AI超級電腦

因此,IBM創建了名為Vela的「專門專注於大規模AI」的系統。

Vela可以根據需要部署到IBM的任何一個雲端資料中心中,它本身就是一個「虛擬雲」。與構建物理的超級電腦相比,雖然這種方法在計算能力方面有所下降,但創造了一個更靈活的解決方案。雲端運算解決方案透過API介面為工程師提供資源,更方便地存取廣泛的IBM雲端生態系統以進行更深入的集成,並能夠根據需要擴展效能。

IBM工程師解釋說,Vela能夠存取IBM雲端物件儲存上的資料集,而不是建立自訂儲存後端。以往這些基礎設施必須單獨建置到超級電腦中。

任何AI超級電腦的關鍵組成部分都是大量的GPU以及連接它們的節點。 Vela其實是將每個節點配置為虛擬機器(而不是裸機),這是最常見的方法,也被廣泛認為是AI訓練最理想的方法。

Vela是如何建構的?

雲端虛擬電腦的弊病之一是效能無法保證。為了解決效能下降問題,並在虛擬機器內部提供裸機效能,IBM工程師找到了一種釋放全部節點效能(包括GPU、CPU、網路和儲存),並將負載損耗降低到5%以下的方法。

這涉及到為虛擬化配置裸機主機,支援虛擬機擴展、大型頁面和單根IO虛擬化,以及真實地表示虛擬機內的所有設備和連接;還包括網卡與CPU和GPU匹配,以及它們彼此之間如何橋接起來。完成這些工作後,他們發現虛擬機器節點的效能「接近裸機」。

此外,他們還致力於設計具有大型GPU記憶體和大量本地儲存的AI節點,用於快取AI訓練資料、模型和成品。在使用PyTorch的測試中,他們發現透過優化工作負載通訊模式,與超級運算中使用的類似Infiniband的更快的網路相比,他們還能夠彌補乙太網路相對較慢的瓶頸。

配置方面,每個Vela都採用了8個80GB A100 GPU、兩個第二代Intel Xeon可擴展處理器、1.5TB內存和四個3.2TB NVMe硬碟驅動器,並能夠以任何規模部署到IBM在全球的任何一個雲端資料中心。

IBM的工程師表示:「擁有合適的工具和基礎設施是提高研發效率的關鍵因素。許多團隊選擇遵循為AI構建傳統超級電腦的可靠路徑…我們一直在研究一種更好的解決方案,以提供高效能運算和高階用戶生產力的雙重好處。」

########以上是IBM開發雲端原生AI超級電腦Vela 可靈活部署並訓練數百億參數模型的詳細內容。更多資訊請關注PHP中文網其他相關文章!