人工智慧一個重要的目標是發展泛化能力強的模型。在自然語言處理(NLP)領域中,預訓練語言模型在這方面取得了重大進展。這類模型往往透過微調來適應新的任務。

近日,來自Google的研究者分析了多種指令微調方法,包括擴展對指令微調的影響。實驗表明,指令微調確實可以根據任務數量和模型大小實現良好的擴展,最大到 5400 億參數的模型都能明顯受益,未來的研究應該進一步擴大任務的數量和模型的大小。此外,研究也分析了微調對模型執行推理能力的影響,結果都是很吸引人的。

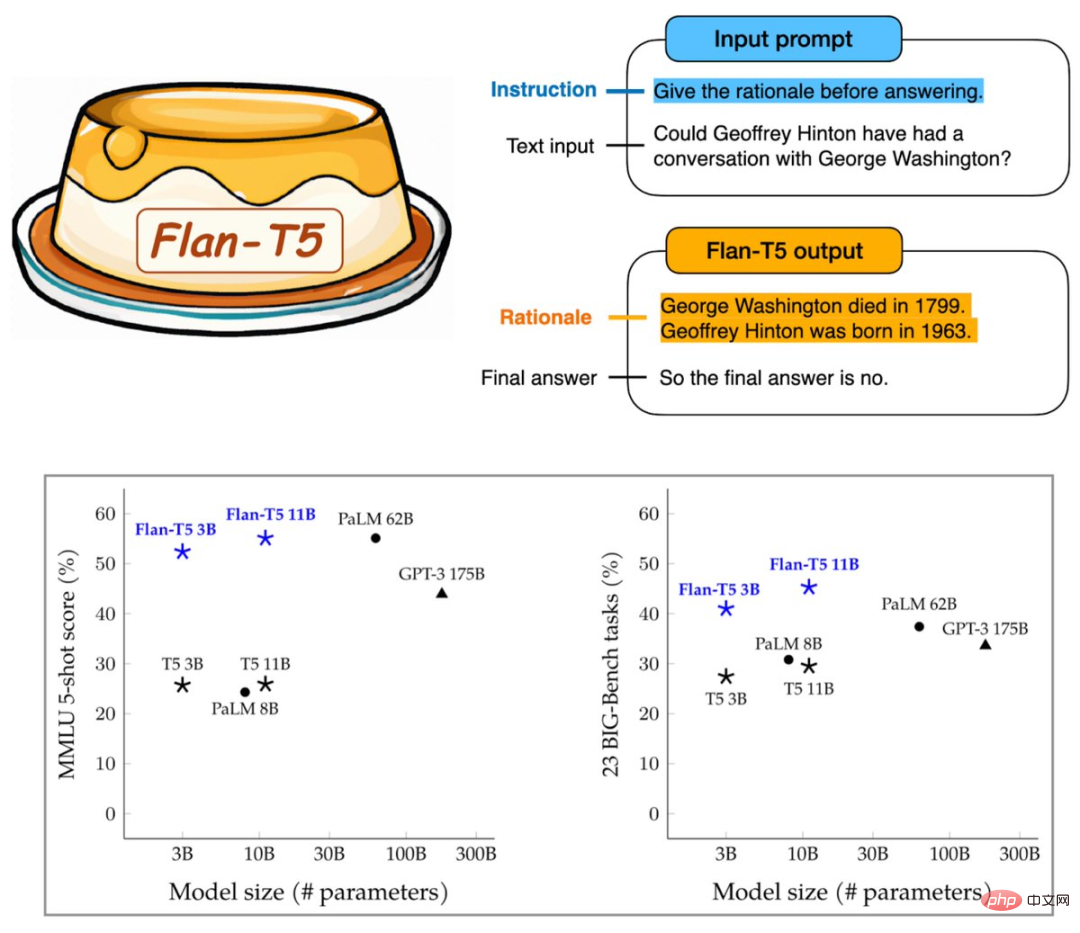

由此產生的Flan-T5 對1800 餘種語言任務進行了指令微調,明顯提高了提示和多步驟推理能力,30 億參數跑基準就能超過GPT- 3 的1750 億參數。

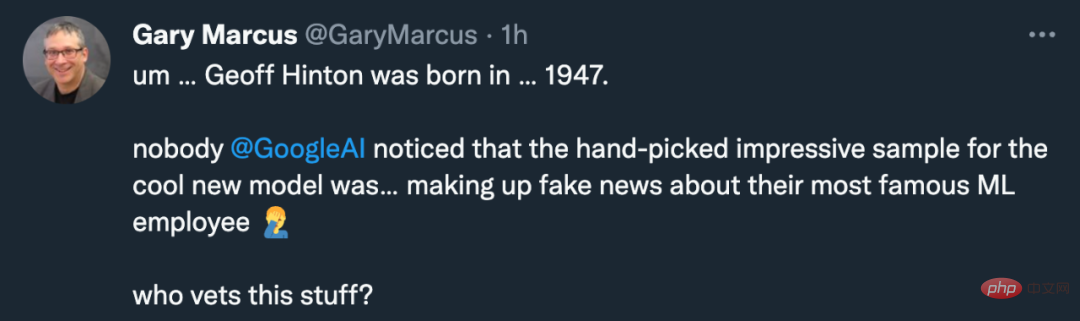

看起來Google又為大模型找到了一個能力提升的方向。不過這項研究不僅引來了機器學習社群的歡迎,也有Gary Marcus 的吐槽:

Google的模型為什麼要把谷歌自己的著名科學家Geoffrey Hinton 的出生日期搞錯了?人家明明是 1947 年出生的老前輩。

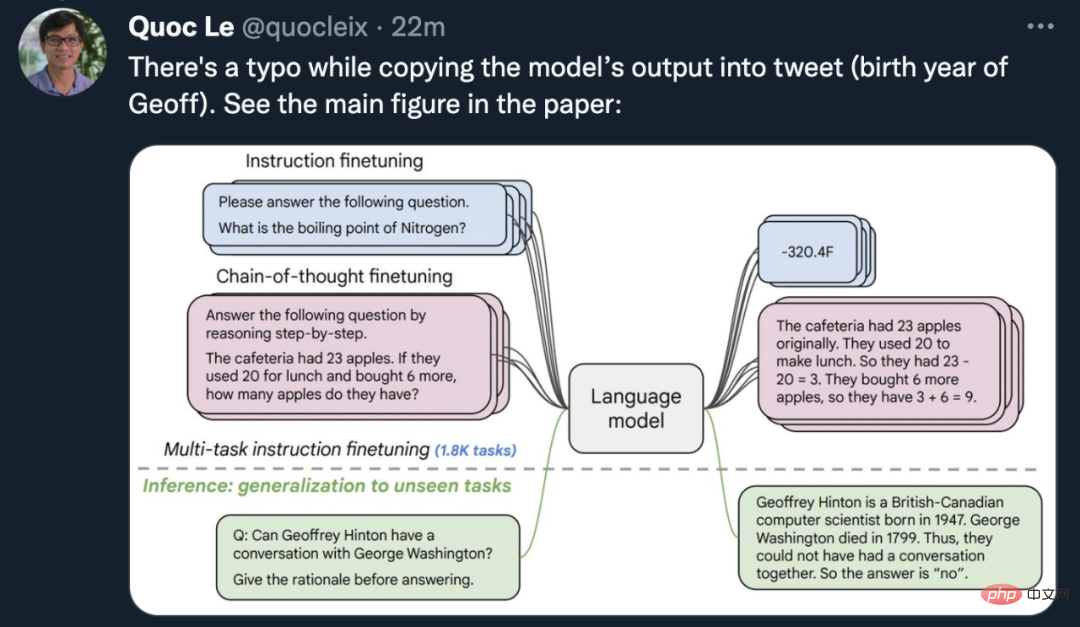

論文作者之一的Google大腦首席科學家Quoc Le 趕緊出來圓場:是臨時工圖片做錯了,在論文裡Flan-T5 模型其實沒有把Geoff 的出生年月搞錯,有圖為證。

順便說一句,出生於 1963 年的著名 AI 學者是 Jürgen Schmidhuber。

既然出錯的不是 AI 模型,讓我們來看看Google的新方法究竟能為預訓練模型帶來哪些改變吧。

論文:Scaling Instruction-Finetuned Language Models

論文網址:https://arxiv.org/abs/2210.11416

論文網址:https://arxiv.org/abs/2210.11416

公開模式:https:/ /github.com/google-research/t5x/blob/main/docs/models.md#flan-t5-checkpoints

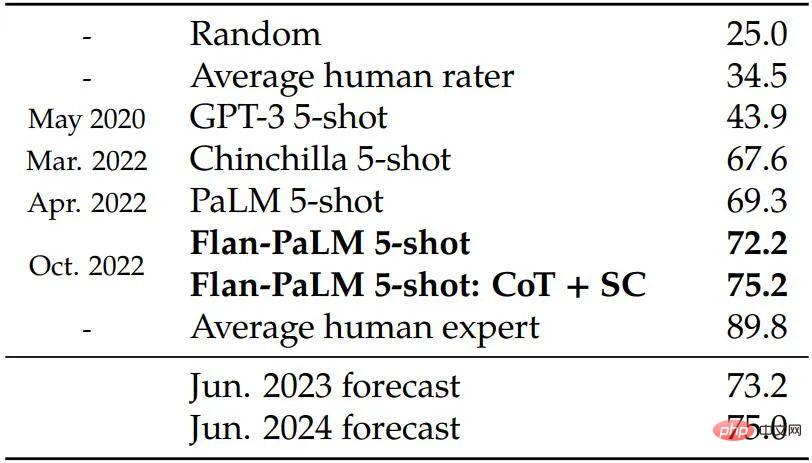

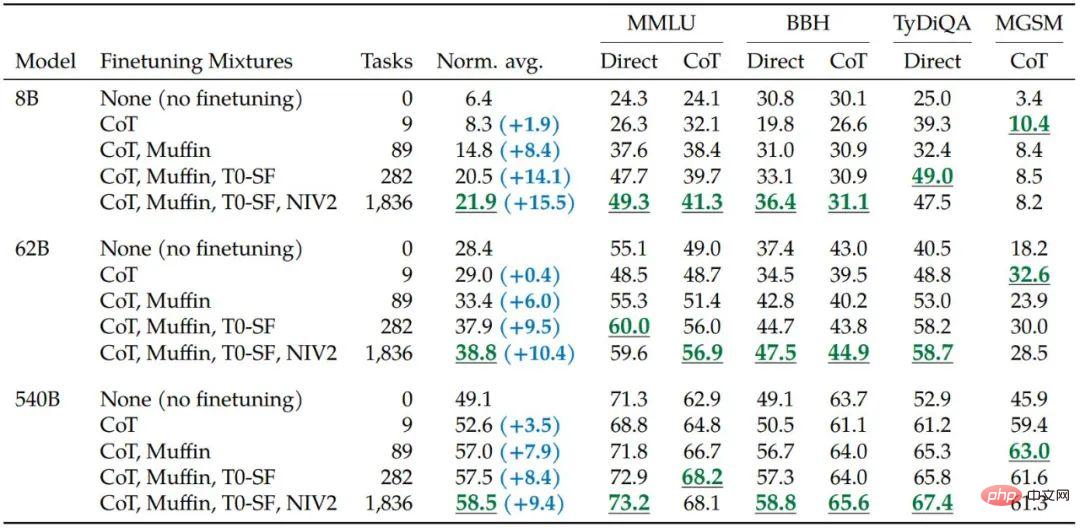

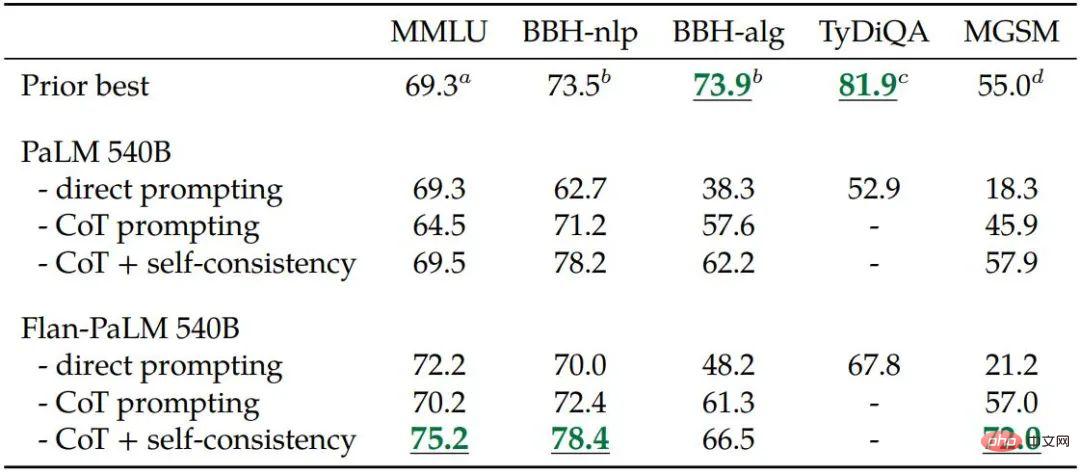

該研究使用540B 參數模型訓練Flan-PaLM,將微調任務的數量增加到1800 個以上,並包含思維鏈(CoT;Wei et al., 2022b)資料。經過訓練後的 Flan-PaLM 優於 PaLM,在多個基準測試中達到了新的 SOTA。在推理能力方面,Flan-PaLM 能夠利用CoT 和自洽性(self-consistency;Wang et al., 2022c)在大規模多任務語言理解(MMLU; Hendrycks et al., 2020)上實現75.2% 的準確率。

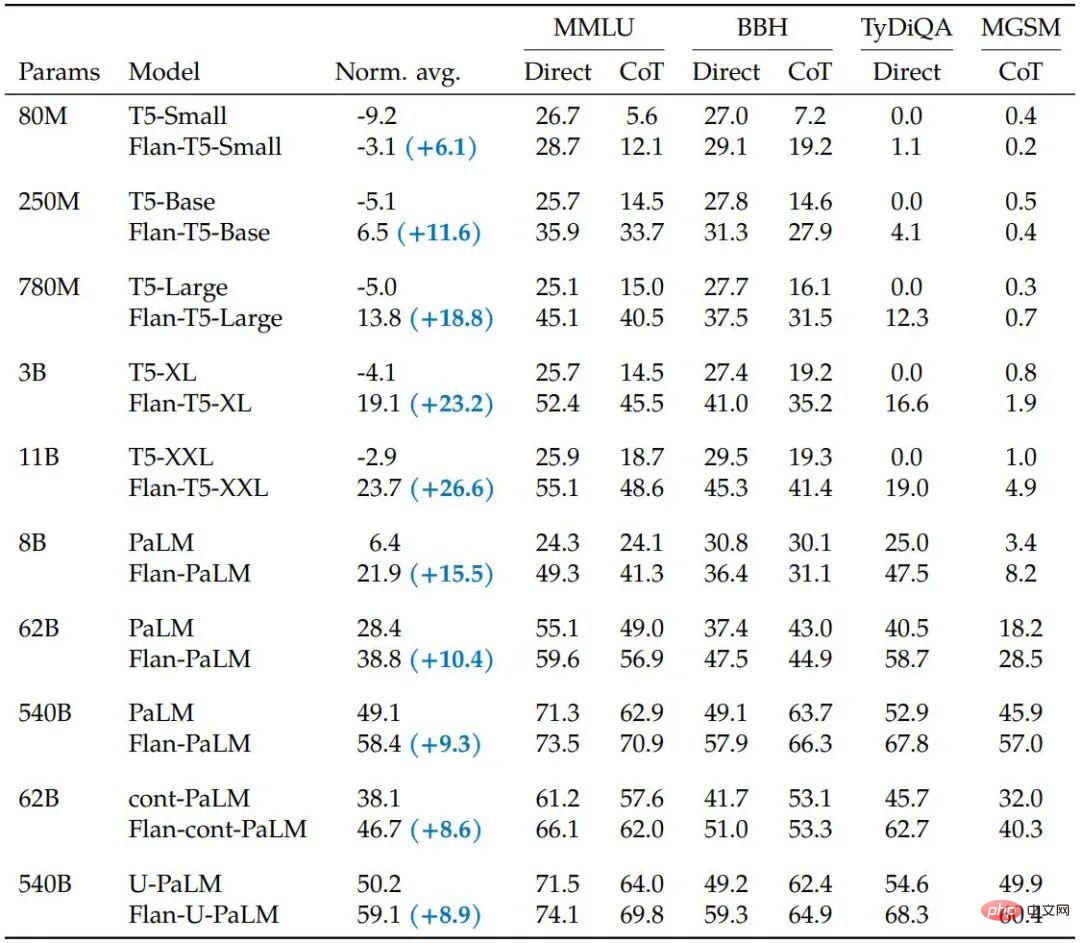

############此外,在一組具有挑戰性的開放式生成問題上,Flan-PaLM 的表現明顯優於 PaLM,可用性大幅提高。 ############總體而言,Google的這項研究闡明了使用指令微調來提高模型效能的具體方法。 #########方法#########具體來說,研究主要關注影響指令微調的幾個方面,包括:(1)擴展任務數量,(2)擴展模型大小,以及(3)對思維鏈資料進行微調。 ######该研究发现具有上述方面的指令微调显著改进了各种模型类(PaLM、T5、U-PaLM)、prompting 设置(零样本、少样本、CoT)和评估基准(MMLU、BBH、 TyDiQA、MGSM、开放式生成)。例如,在 1.8K 任务上进行指令微调的 Flan-PaLM 540B 大大优于 PALM 540B(平均 9.4%)。Flan-PaLM 540B 在几个基准测试中实现了最先进的性能,例如在五次 MMLU 上达到 75.2%。

研究者还公开了 Flan-T5 检查点,即使与更大的模型(例如 PaLM 62B)相比,它也能实现强大的少样本性能。总体而言,指令微调是提高预训练语言模型的性能和可用性的通用方法。

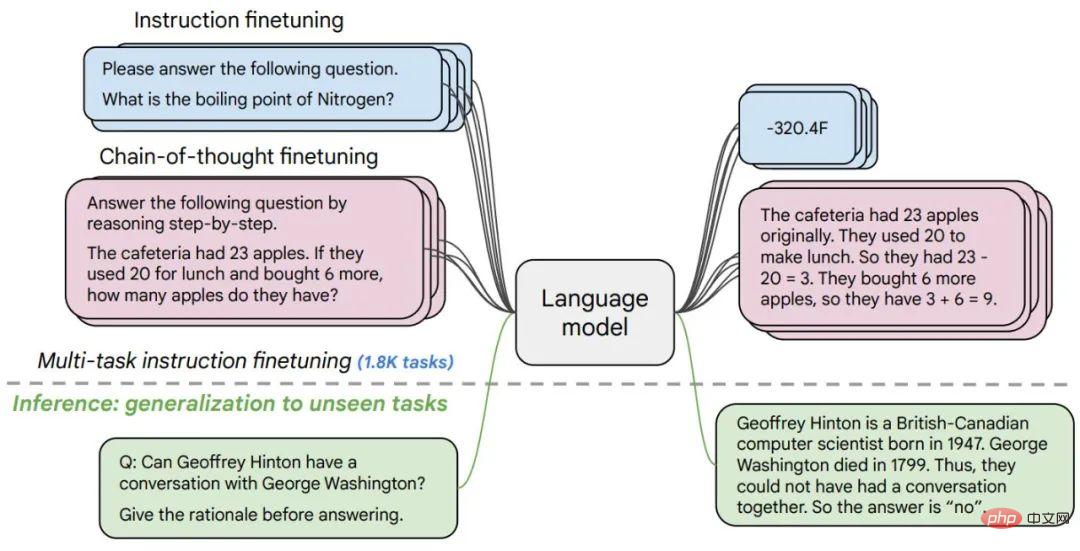

图 1. 研究人员在 1800 余个任务中对各种语言模型进行了微调,在有 / 缺乏样本(零样本和少样本)以及有 / 没有思维链的情况下进行微调,从而能够在一系列评估场景中进行泛化。

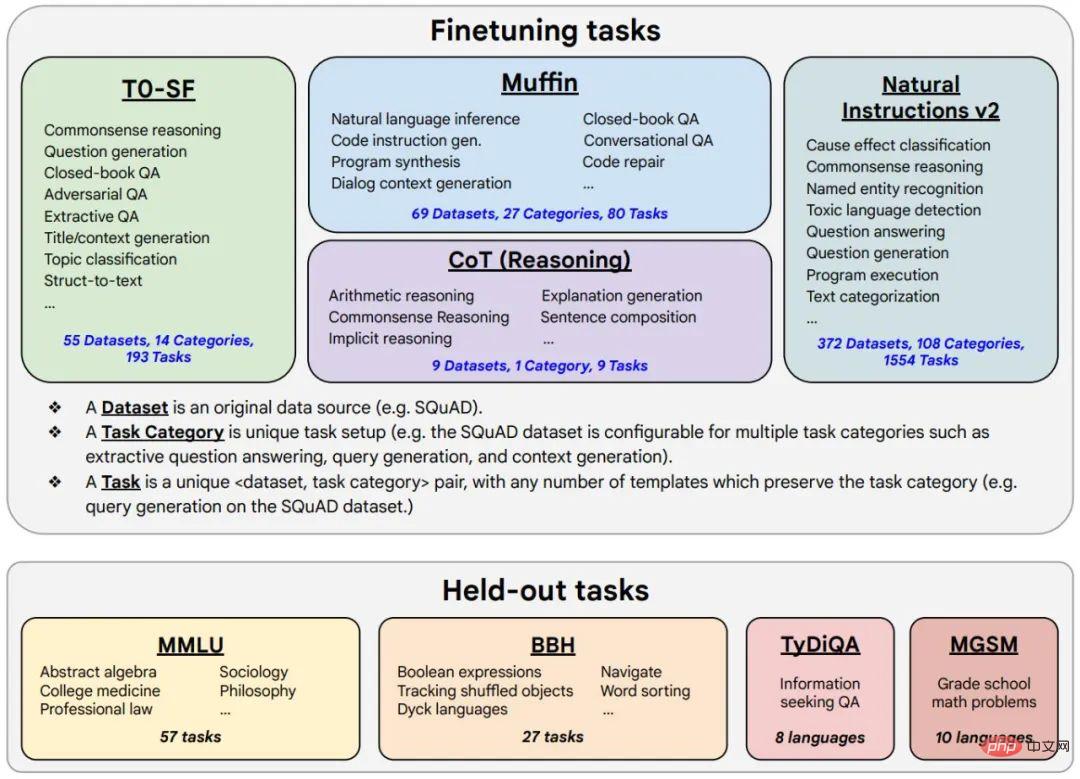

图 2. 微调数据包括 473 个数据集、146 个任务类别和共计 1836 个任务。

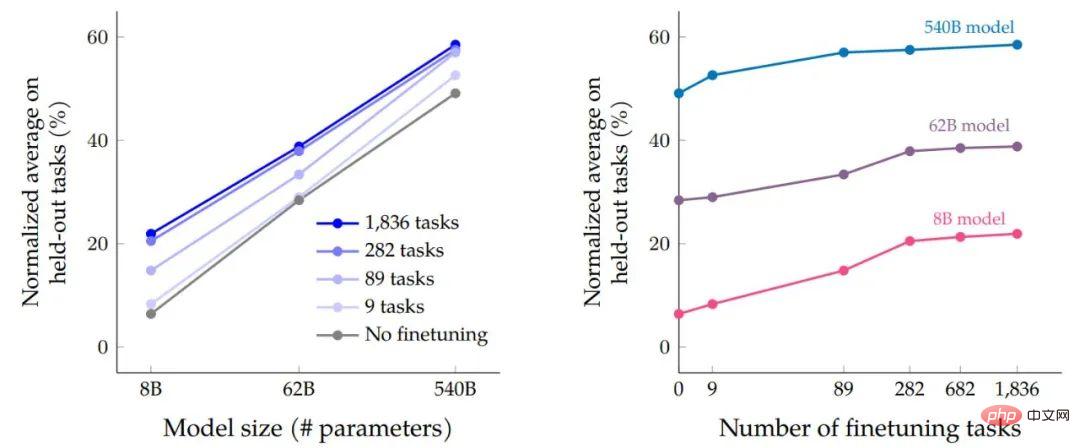

在数据微调和程序微调过程完成后,研究者根据模型大小对任务的性能来对比规模扩展的影响。首先,对于所有三种模型大小,多任务指令微调与没有微调相比性能有很大提高,增益范围从 9.4% 到 15.5%。其次,增加微调任务的数量可以提高性能。

最后,我们可以看到将模型规模增加一个数量级(8B → 62B 或 62B → 540B)可以明显提高微调和未微调模型的性能。

多任务指令微调相对于模型大小(参数量)和微调任务数量及规模扩展对准确率的影响。

增加微调数据中的任务数量可以提高 Flan-PaLM 在大多数评估基准上的性能。

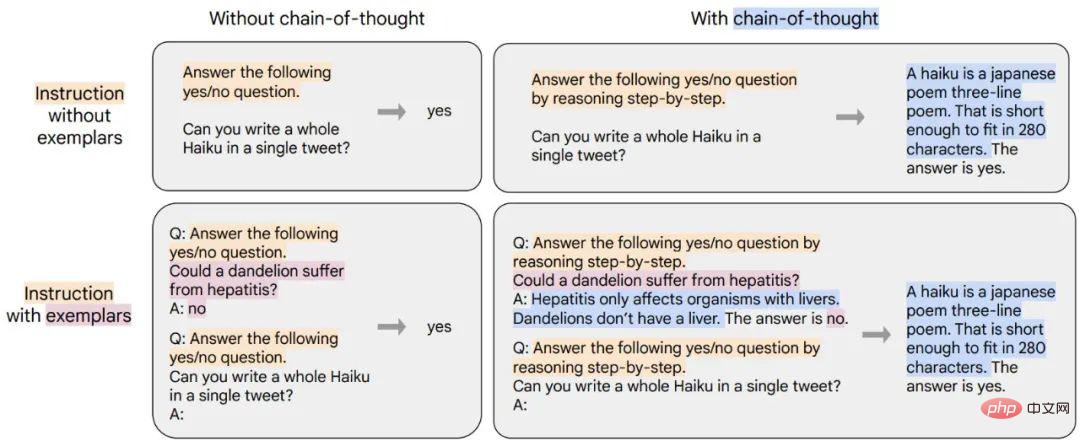

研究人员证明了在微调混合中包含九个带有思维链 (CoT) 注释的数据集可以提高推理能力。下表显示 Flan-PaLM 的 CoT 提示能力在四个保留的评估基准上优于 PaLM。

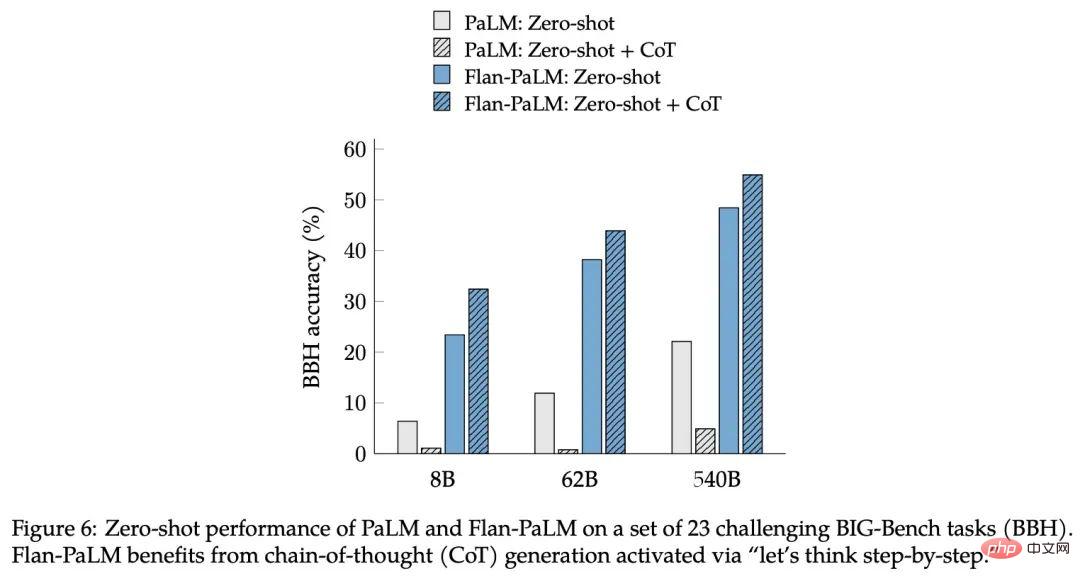

该研究发现对 CoT 数据进行指令微调的另外一个好处是可以实现零样本(zero-shot)推理,模型在没有针对 CoT 的少量样本的情况下就自行产生了推理能力,这可能需要大量工程调教才能正确实现。

图 6:PaLM 和 Flan-PaLM 在一组 23 个具有挑战性的 BIG-Bench 任务 (BBH) 上的 zero-shot 性能。Flan-PaLM 需要通过「让我们一步一步思考」指令激活的思想链 (CoT) 生成。

為了展示新方法的通用性,Google訓練了 T5、PaLM 和 U-PaLM,涵蓋了從 8,000 萬到 5,400 億參數的模型體積範圍,發現所有模型都能大幅提升效能。

表 5. 指令微調 (Flan) 在其他持續預訓練方法之上提高了效能。

經過測試,指令微調大大提高了所有模型類型的歸一化平均性能,與非微調模型相比,T5 模型從指令微調中受益最多。這些結果對於某些基準測試來說是相當強的——例如,Flan-T5-XL 只有 30 億參數,就達到了 47.6% 的 MMLU 分數,超過了 GPT-3 1750 億參數的 43.9% 分數。

除了 NLP 基準之外,語言模型還能夠為開放式問題請求產生長格式答案。在這一方面,標準的 NLP 基準和用於評估它們的自動指標不足以衡量人類的偏好。研究人員對此進行了評估,創建了一個包含 190 個範例的評估集。此評估集包括以零樣本方式向模型提出的問題,涉及五個具有挑戰性的類別,每個類別 20 個問題:創造力、上下文推理、複雜推理、計劃和解釋。

對於其中的60 個範例(來自複雜的推理、計劃和解釋類別),該研究創建了一個帶有思維鏈觸發短語(例如,「讓我們一步一步思考」)的變體,作為微調是否進行的另一個評估在CoT 上啟用zero-shot。除了上述 160 個零樣本輸入之外,研究中還包括 30 個用於測試少樣本能力的輸入,這些沒有指令微調的強語言模型已被證明在這些方面表現良好。

研究人員認為,指令微調和規模擴展都可以持續提升大語言模型效能,而微調對於推理能力至關重要,其還能泛化模型能力。透過指令微調與其他模型適應技術(例如 UL2R)結合,Google在這項工作中提出了最強模型 Flan-U-PaLM。

重要的是,指令微調並不像模型規模擴展一樣會大幅增加計算成本,例如對於PaLM 540B,指令微調只需要0.2% 的預訓練計算,但卻可以將跨評估基準的歸一化平均值提高9.4%。使用指令微調的小型模型有時可以勝過沒有微調的大模型。

基於這些原因,研究人員建議對幾乎所有預先訓練的語言模型都進行指令微調。

以上是30億跑贏GPT-3的1750億,Google新模型引熱議,然而卻把Hinton年齡搞錯了的詳細內容。更多資訊請關注PHP中文網其他相關文章!