论文链接:https://arxiv.org/pdf/2302.06476.pdf

大型语言模型(LLM)已经被证明能够解决各种自然语言处理(NLP)任务,而且对于给定的下游任务,它们不依赖任何训练数据,借助适当的 prompt 就能实现模型调整。这种根据指令执行新任务的能力可以被视为迈向通用人工智能的重要一步。

尽管目前的 LLM 在某些情况下取得了不错的性能,但在 zero-shot 学习中仍然容易出现各种错误。此外,prompt 的格式可以产生实质性的影响。例如,在 prompt 中添加「Let’s think step by step」,模型性能就能得到显著提升。这些限制说明当前的 LLM 并不是真正的通用语言系统。

近日,OpenAI 发布的 ChatGPT LLM 在 NLP 社区引发极大关注。ChatGPT 是通过「人类反馈强化学习(RLHF)」训练 GPT-3.5 系列模型而创建的。RLHF 主要包括三个步骤:使用监督学习训练语言模型;根据人类偏好收集比较数据并训练奖励模型;使用强化学习针对奖励模型优化语言模型。通过 RLHF 训练,人们观察到 ChatGPT 在各个方面都具有令人印象深刻的能力,包括对人类输入生成高质量的响应、拒绝不适当的问题以及根据后续对话自我纠正先前的错误。

虽然 ChatGPT 显示出强大的对话能力,但与现有的 LLM 相比,NLP 社区仍然不清楚 ChatGPT 是否获得了更好的 zero-shot 泛化能力。为了填补这一研究空白,研究者们通过在涵盖 7 个代表性任务类别的大量 NLP 数据集上对 ChatGPT 进行评估,系统地研究了它的 zero-shot 学习能力。这些任务包括推理(reasoning)、自然语言推断(natural language inference)、问答(阅读理解)、对话、摘要、命名实体识别和情感分析。借助广泛的实验,研究者旨在回答以下问题:

为了回答这些问题,作者根据实验结果比较了 ChatGPT 和最先进的 GPT-3.5 模型 (text-davinci-003) 的性能。此外,他们还报告了 FLAN、T0 和 PaLM 等近期工作的 zero-shot、微调或 few-shot 微调结果。

主要结论

作者表示,据他们所知,这是第一次有人对 ChatGPT 在各种 NLP 任务上的 zero-shot 能力进行研究,旨在提供 ChatGPT 的初步概况。他们的主要发现如下:

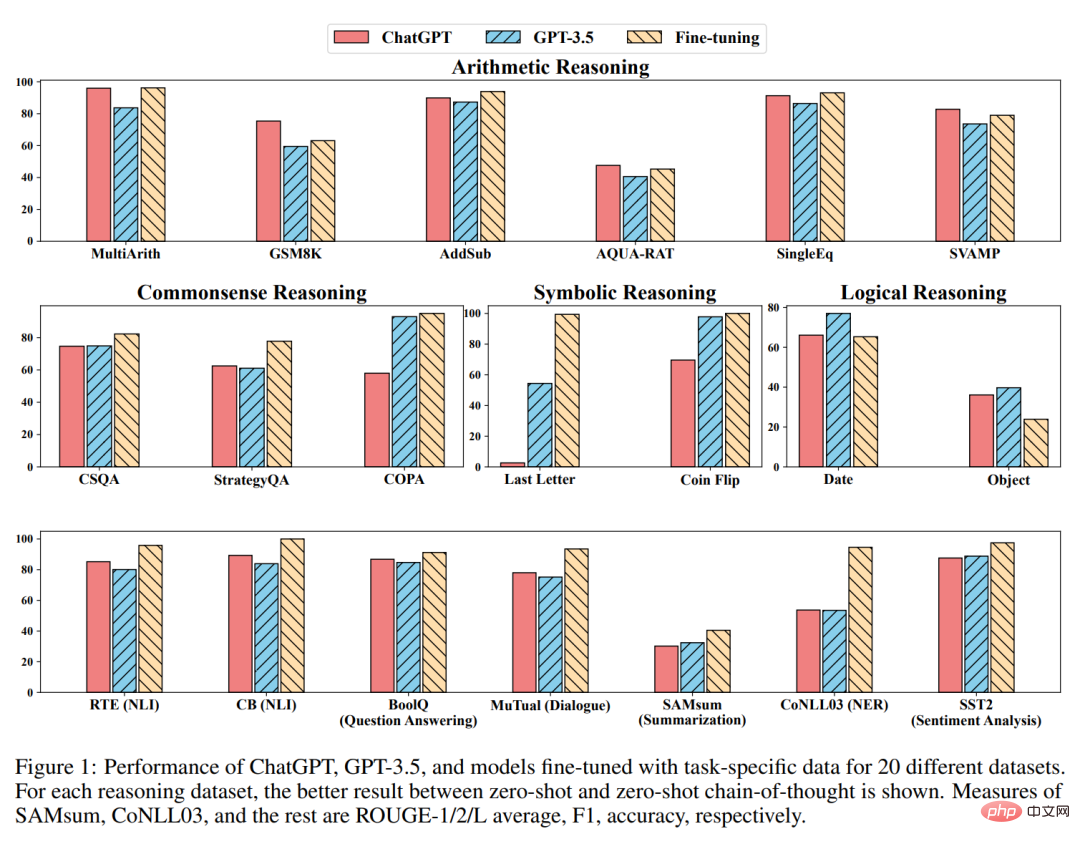

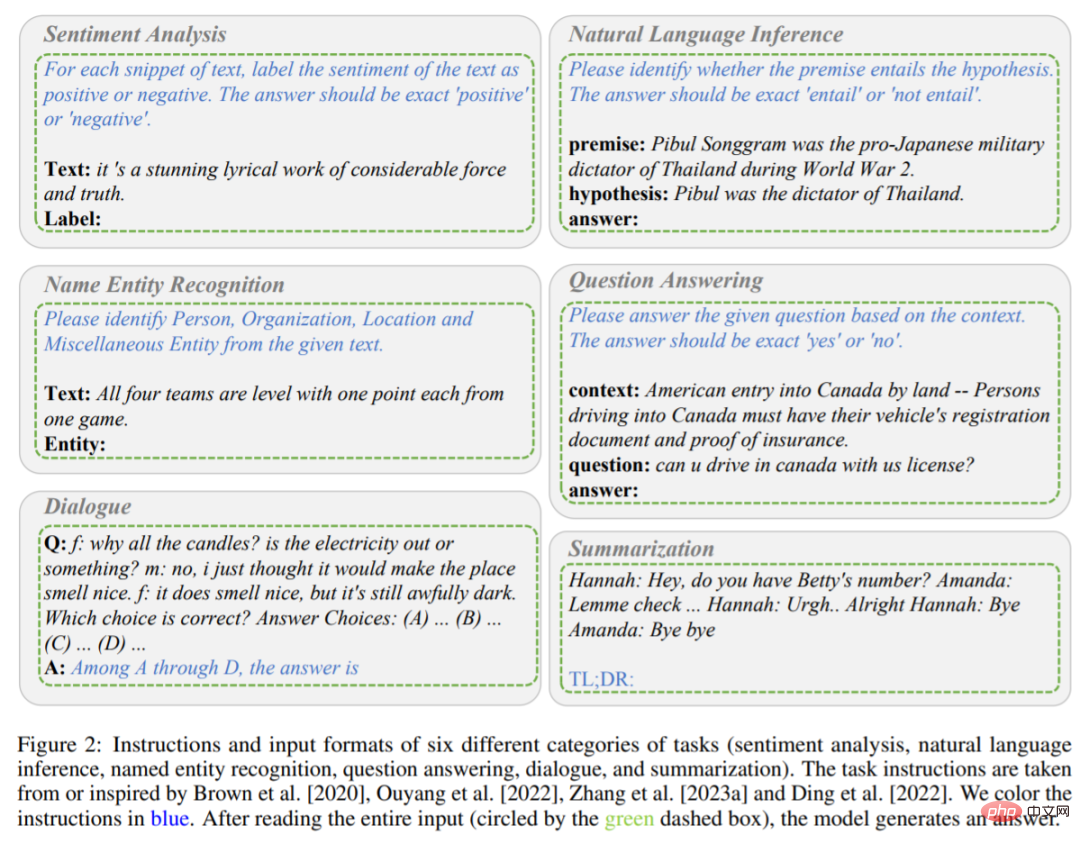

#如前所述,該研究主要比較了ChatGPT 和GPT-3.5 (textdavinci-003) 在不同任務下的zero-shot 學習表現。具體而言,他們將任務指令 P 和測試問題 X 作為輸入,模型以 f 表示,然後產生目標文字 Y = f (P, X) 來解決測試問題。不同任務的指令和輸入格式如圖 2 和圖 3 所示。

#包含六種任務(情緒分析、自然語言推理、命名實體辨識、問答、對話和摘要)的指示和輸入格式。指令為藍色字體。

#推理任務說明。

舉例來說,當模型執行情緒分析任務時,任務指令P 將文字所包含的情緒標記為正面或消極,則輸出的答案為積極或消極。當模型在閱讀了指令 P 和輸入內容 X(內容為一部具有相當力量和真實性的令人驚嘆的抒情作品)後,該模型經過判斷,有望輸出 Y 積極。

與上述單階段 prompting 方法不同的是,研究使用兩階段 prompting(Kojima 等人提出),來完成 zero-shot-CoT。

第一階段採取「讓模型一步一步思考(Let’s think step by step)」,指令 P_1 誘導模型產生基本原理 R。

第二階段採用第一步產生的基本原理 R 以及原始輸入 X 和指令 P_1 作為新的輸入,引導模型產生最終答案。

之後一個新的指令 P_2 作為提取答案的觸發語句。所有任務指令均取自 Brown、Ouyang、Zhang 等人研究,或受其啟發。最後要注意的是,每次對 ChatGPT 進行新的查詢時,都要提前清除對話,以避免前面範例的影響。

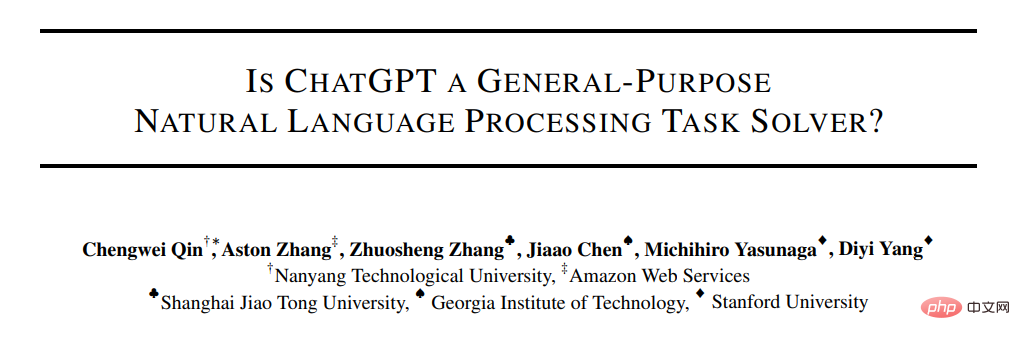

實驗用 20 個不同的資料集來評估 ChatGPT 和 GPT-3.5,涵蓋 7 個類別任務。

算術推理

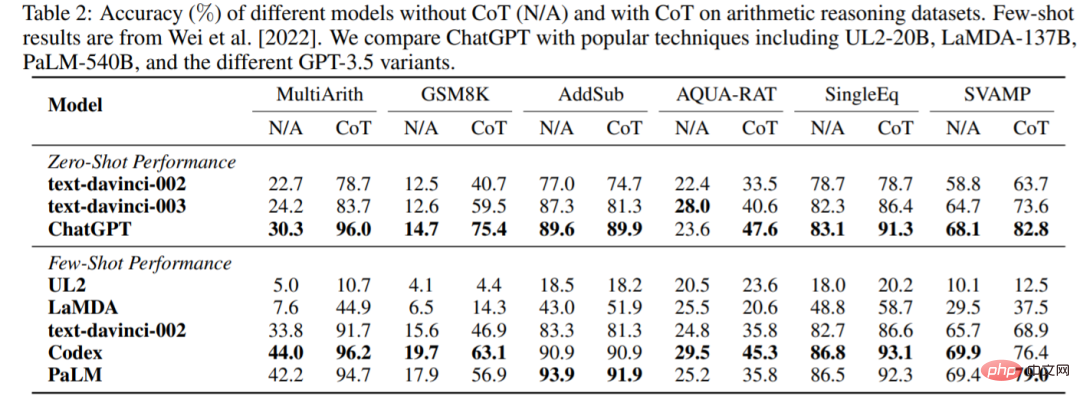

ChatGPT 和 GPT-3.5 在沒有或有 CoT 的情況下,在六個算術推理資料集上的準確率如表 2 所示。在沒有 CoT 的實驗中,ChatGPT 在其中 5 個資料集上的表現優於 GPT-3.5,顯示了其強大的算術推理能力。

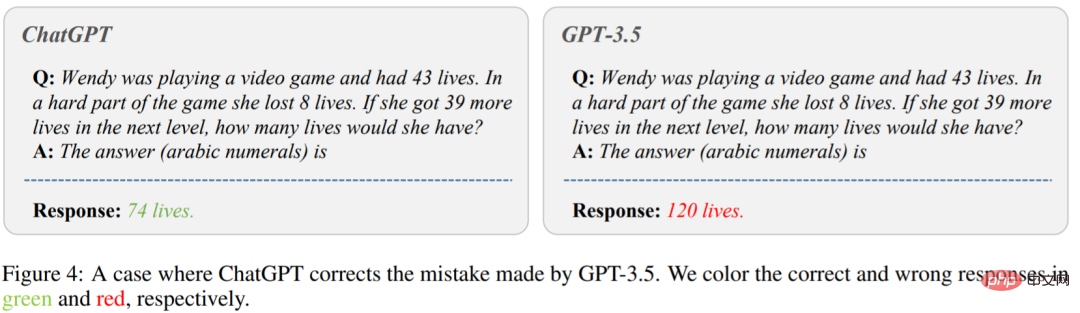

圖 4 顯示了 GPT-3.5 給出錯誤答案的情況。在圖的左側,問「溫迪在玩電子遊戲,有43 條命。在遊戲的艱難部分,她失去了8 條生命。如果她在下一關多得到39 條命,她會有多少條命?」ChatGPT 給了正確答案。然而,GPT-3.5 產生了一個錯誤的答案。可以看出,在使用 CoT 時,ChatGPT 的表現都比 GPT-3.5 好得多。

#常識、符號與邏輯推理

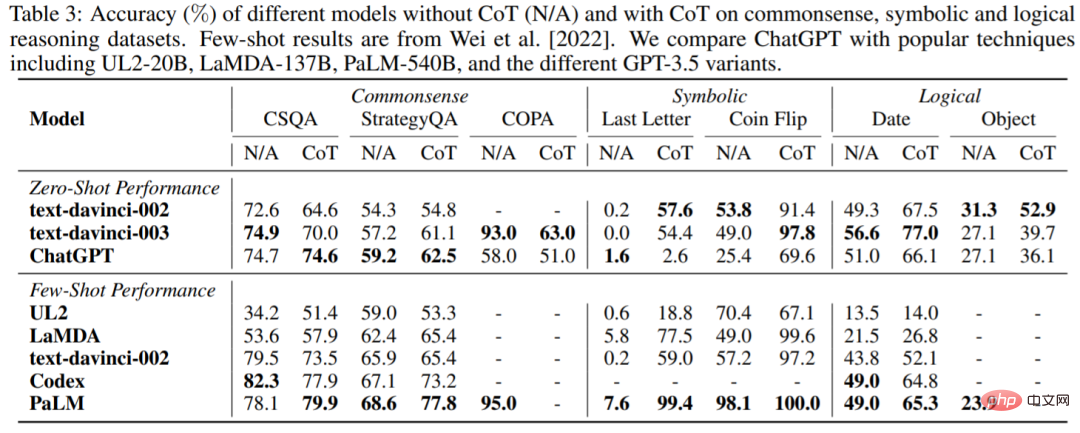

#表3 報告了ChatGPT 與流行LLM 在常識、符號和邏輯推理資料集上的準確率。可以得到如下觀察結果:首先,使用 CoT 可能並不總是在常識推理任務中提供更好的性能,常識推理任務可能需要更細粒度的背景知識。其次,與算術推理不同,ChatGPT 在許多情況下的表現都比 GPT-3.5 差,顯示 GPT-3.5 的相應能力更強。

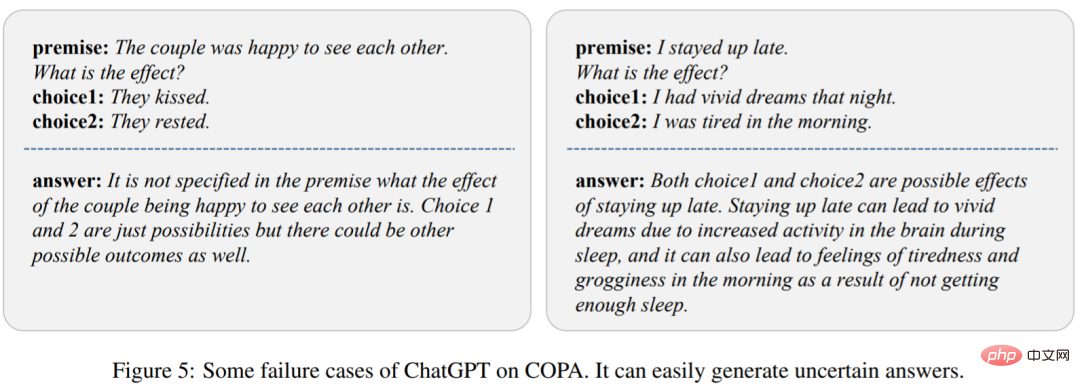

為了分析原因,研究在圖 5 中展示了 ChatGPT 的幾個失敗案例。我們可以觀察到 ChatGPT 很容易產生不確定的反應,導致表現不佳。

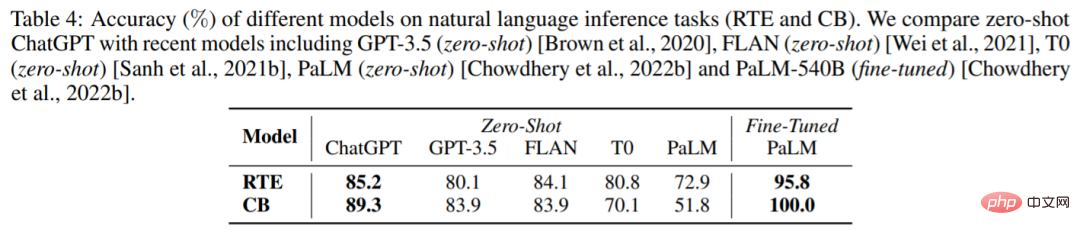

#自然語言推理

表4 展示了不同模型在兩個自然語言推理任務上的結果:RTE 和CB。我們可以看到,在 zero-shot 設定下,ChatGPT 可以取得比 GPT-3.5、FLAN、T0 和 PaLM 更好的效能。這證明 ChatGPT 在 NLP 推理任務中,具有較好的 zero-shot 表現。

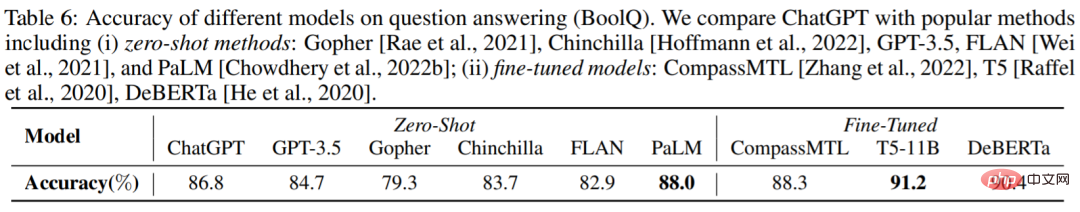

#問答

表6 報告了不同模型在BoolQ 資料集的準確率,ChatGPT 優於GPT-3.5 。這表明 ChatGPT 可以更好地處理推理任務。

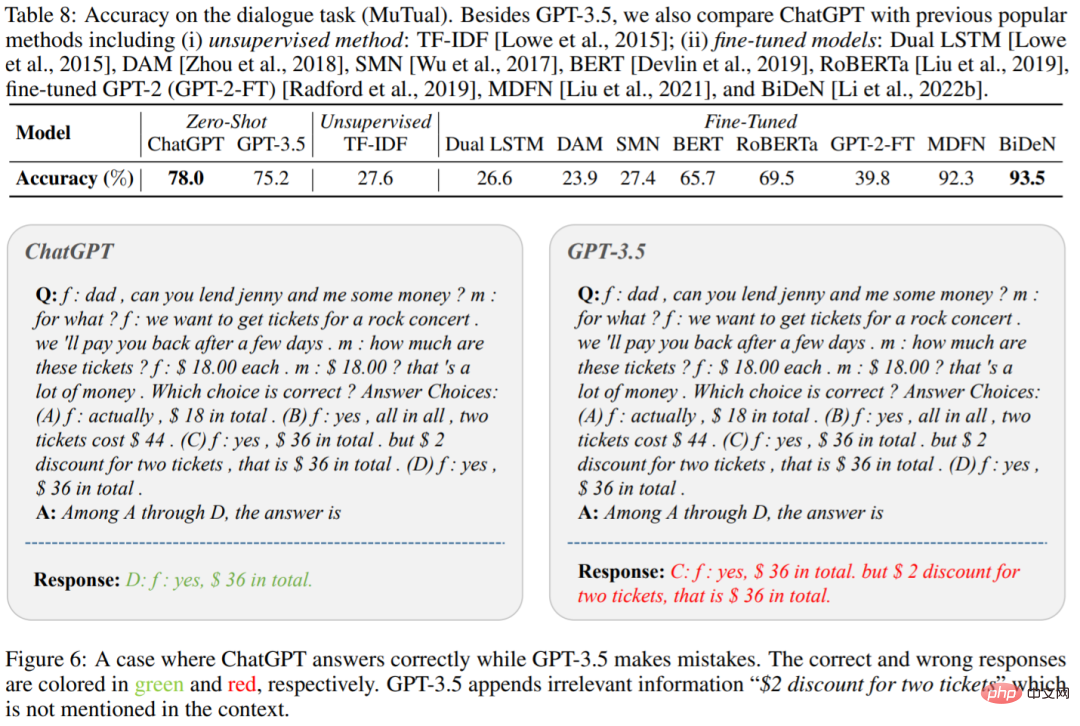

#對話

#表8 中顯示了ChatGPT 和GPT-3.5 在MuTual 資料集(多輪對話推理)上的準確率。正如預期的那樣,ChatGPT 大大優於 GPT-3.5。

圖 6 為一個具體的範例,我們可以看到 ChatGPT 能夠更有效地對給定的上下文進行推理。這再次印證了 ChatGPT 超強的推理能力。

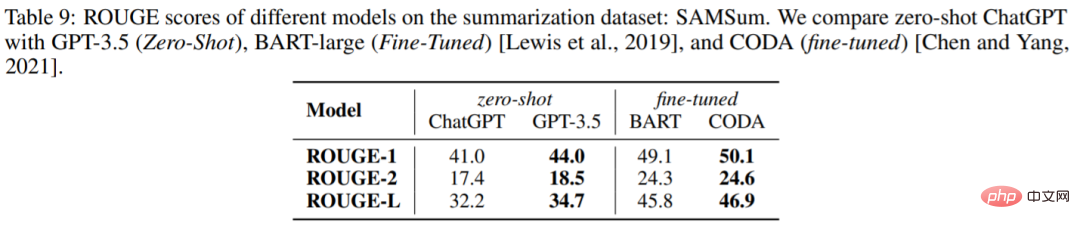

#產生摘要##

表 9 報告 ChatGPT 和 GPT-3.5 在 SAMSum 資料集上的 ROUGE 得分,令人驚訝的是,ChatGPT 在所有指標上都不如 GPT-3.5。

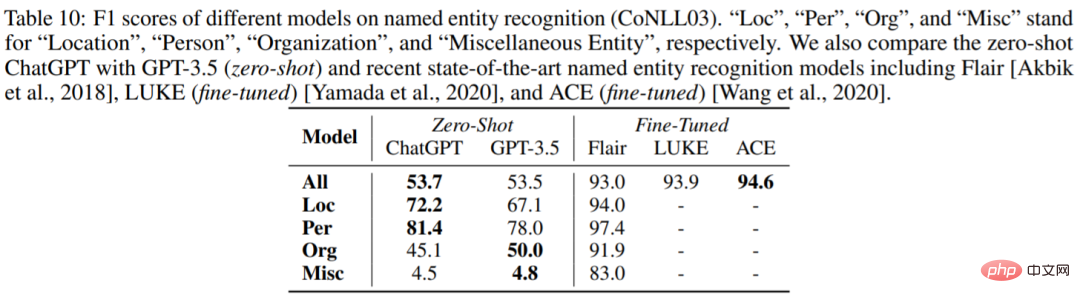

#命名實體識別

表10 報告了ChatGPT 和GPT-3.5 在CoNLL03 上的zero-shot 效能。我們可以看到 ChatGPT 和 GPT-3.5 的整體表現非常相似。

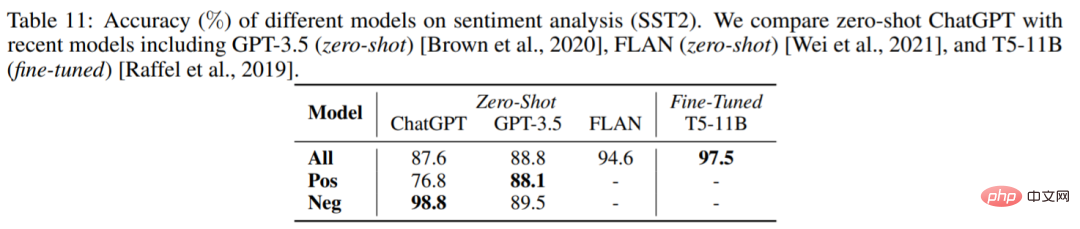

#情緒分析

#表11 比較了不同模型在情緒分析資料集SST2 上的準確率。令人驚訝的是,ChatGPT 的表現比 GPT-3.5 差了約 1%。

#如需了解更多內容,請參考原論文。

以上是ChatGPT真的是「通才」嗎?楊笛一等人給它來了個摸底考試的詳細內容。更多資訊請關注PHP中文網其他相關文章!