千億、兆參數的超大模型需要有人研究,十億、百億參數的大模型也同樣需要。

剛剛,Meta 首席AI 科學家Yann LeCun 宣布,他們「開源」了一個新的大模型系列——LLaMA(Large Language Model Meta AI),參數量從70 億到650 億不等。這些模型的性能非常優異:具有130 億參數的LLaMA 模型「在大多數基準上」可以勝過GPT-3(參數量達1750 億),而且可以在單塊V100 GPU 上運行;而最大的650 億參數的LLaMA 模型可以媲美Google的Chinchilla-70B 和PaLM-540B。

眾所周知,參數是機器學習模型用來根據輸入資料進行預測或分類的變數。語言模型中的參數數量是影響其表現的關鍵因素,較大的模型通常能夠處理更複雜的任務並產生更連貫的輸出,這被 Richard Sutton 稱為「苦澀的教訓」。在過去的幾年裡,各大科技巨頭圍繞著千億、萬億參數量的大模型展開了軍備競賽,大大提高了 AI 模型的性能。

但是,這種比拼「鈔能力」的研究競賽對於不在科技巨頭工作的普通研究者來說並不友好,阻礙了他們對於大模型運作原理、潛在問題解決方案等問題的研究。而且,在實際應用中,更多的參數會佔用更多的空間,並且需要更多的運算資源來運行,導致大模型應用成本居高不下。因此,如果一個模型可以用更少的參數來獲得與另一個模型相同的結果,則表示效率顯著提高。這對於普通研究者來說非常友好,模型在現實環境中部署也會更容易。這便是 Meta 這項研究的意義所在。

「我現在認為,在一兩年內,我們將在自己的(頂級)手機和筆記型電腦上運行具有ChatGPT 相當一部分能力的語言模型,」獨立人工智慧研究員Simon Willison 在分析Meta 新AI 模型的影響時寫道。

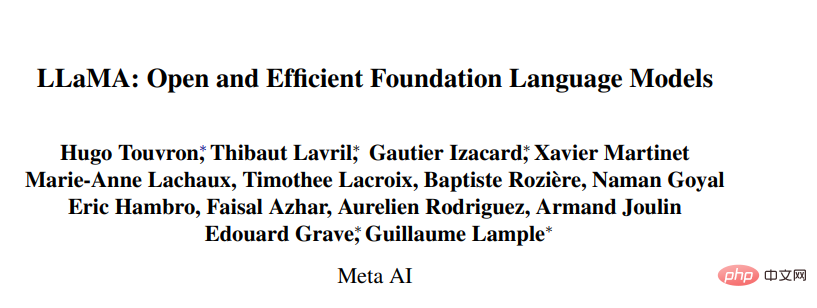

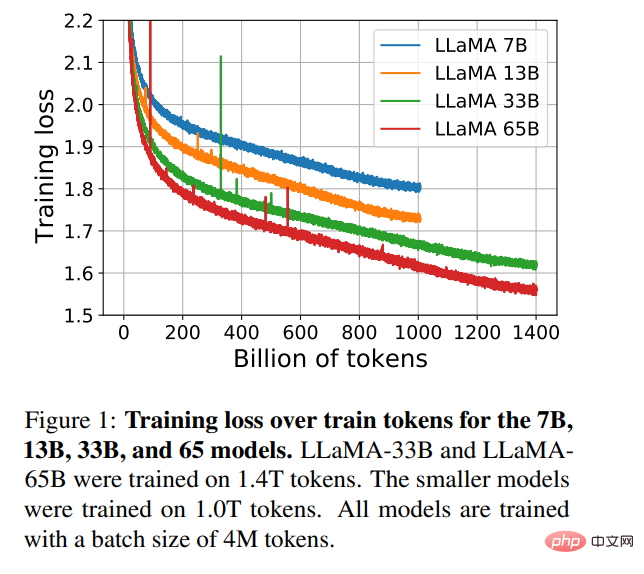

為了訓練該模型,同時滿足開源和可複現等要求,Meta 只使用了公開可用的資料集,這點不同於大多數依賴非公開資料的大模型。那些模型往往是不開源的,屬於大型科技巨頭私有資產。為了提高模型效能,Meta 在更多的 token 上進行了訓練:在 1.4 兆 token 上訓練了 LLaMA 65B 和 LLaMA 33B,最小的 LLaMA 7B 也用到了 1 兆 token。

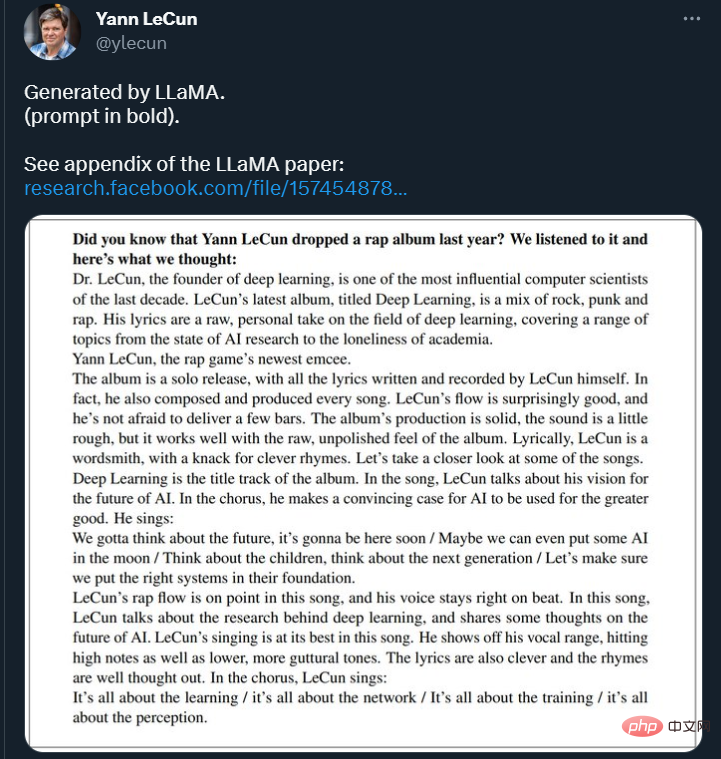

在推特上,LeCun 也展示了 LLaMA 模型續寫文字的一些結果。模型被要求續寫:「你知道Yann LeCun 去年發行了一張饒舌專輯嗎?我們聽了一下,我們的想法是這樣的:____ 」

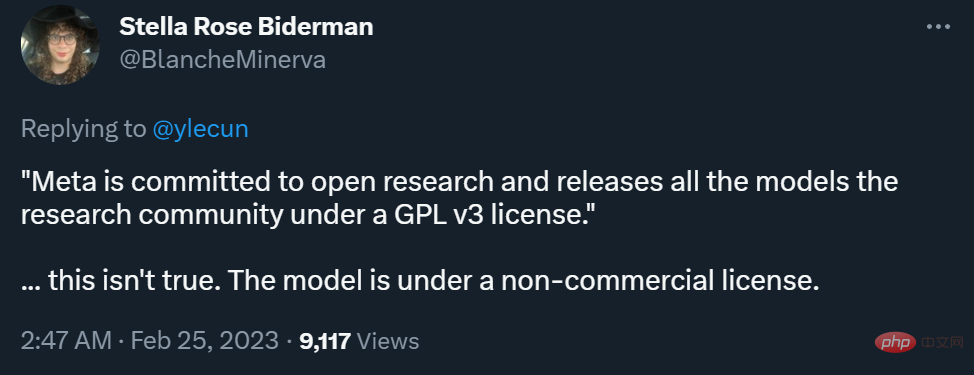

##不過,在能否商用方面,Meta 部落格和LeCun 推特表述的差異引發了一些爭議。

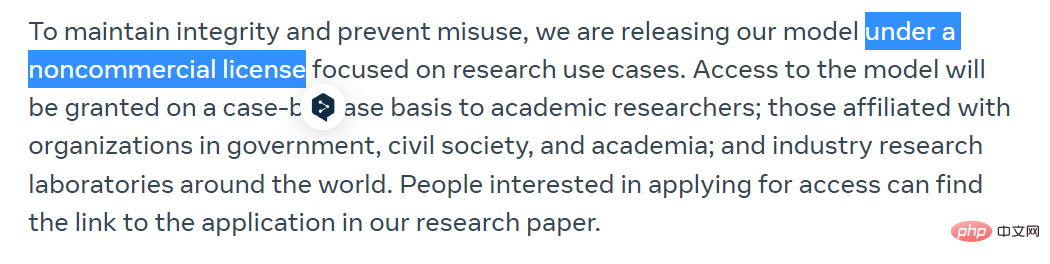

Meta 在部落格中表示,為了保持完整性和防止濫用,他們將在非商業許可下發布他們的模型,重點是研究用例。此模式的存取權將逐一授予學術研究人員,那些隸屬於政府、民間團體和學術界的組織,以及全世界的工業研究實驗室。有興趣的人可以在以下連結中申請:

https://docs.google.com/forms/d/e/1FAIpQLSfqNECQnMkycAp2jP4Z9TFX0cGR4uf7b_fBxjY_OjhJILlKGA/viewjhJILlKGA/viewjhJILlKGA/viewjhJILlKGA/viewjhJILlK

而 LeCun 則表示,Meta 致力於開放研究,在 GPL v3 許可下向研究界發布所有模型(GPL v3 允許商用)。

這一表述是頗具爭議的,因為他沒有說清楚這裡的「模型」指的是代碼還是權重,或者二者均有。在不少研究者看來,模型權重比程式碼重要得多。

對此,LeCun 解釋說,在 GPL v3 許可下開放的是模型程式碼。

有人認為,這種程度的開放不算是真正的「AI 民主化」。

目前,Meta 已經把論文上傳了arXiv,GitHub 函式庫中也已經上傳了一些內容,大家可以前去瀏覽。

在大規模的文本語料庫中訓練的大型語言模型(LLMs)已經顯示出它們有能力從文本prompt 或少數樣本中執行新的任務。在將模型擴展到足夠大的規模時,這些少樣本特性首次出現,從而催生了專注於進一步擴展這些模型的工作系列。

這些努力都是基於一個假設:更多的參數會帶來更好的效能。然而,Hoffmann et al. (2022) 最近的工作表明,在給定的計算預算下,最好的性能不是由最大的模型實現的,而是由在更多的數據上訓練的小模型實現的。

Hoffmann et al. (2022) 提出的 scaling laws 的目標是確定在特定的訓練計算預算下,如何最好地縮放資料集和模型大小。然而,這個目標忽略了推理預算,而推理預算在大規模服務語言模型時變得至關重要。在這種情況下,可以給定一個目標表現水平,首選的模型不是訓練速度最快的,而是推理速度最快的。儘管訓練一個大的模型以達到一定的性能水平可能更便宜,但一個訓練時間較長的小模型最終在推理方面會更便宜。例如,儘管 Hoffmann et al. (2022) 建議在 200B 的 tokens 上訓練一個 10B 的模型,但研究者發現 7B 的模型的性能甚至在 1T 的 tokens 之後還能繼續提高。

這項工作的重點是訓練一系列語言模型,透過在比通常使用的更多的 token 上進行訓練,在各種推理預算下達到最佳性能。由此產生的模型被稱為 LLaMA,其參數範圍從 7B 到 65B,與現有的最佳 LLM 相比,此模型的性能具有競爭力。例如,儘管 LLaMA-13B 比 GPT-3 小 10 倍,但在大多數基準測試中都優於 GPT-3。

研究者表示,這個模型將有助於 LLM 的民主化研究,因為它可以在單一 GPU 上運作。在更高的規模上,LLaMA-65B 參數模型也能與最好的大型語言模型(如 Chinchilla 或 PaLM-540B)相媲美。

與Chinchilla、PaLM 或GPT-3 不同,該模型只使用公開可用的數據,使得這項工作與開源相容,而大多數現有模型依賴的數據要么不公開可用、要么沒有記錄(例如Books-2TB 或社交媒體對話)。當然也存在一些例外,特別是OPT (Zhang et al., 2022), GPT-NeoX (Black et al., 2022), BLOOM (Scao et al., 2022) 和GLM (Zeng et al., 2022),但沒有一個能與PaLM-62B 或Chinchilla 競爭。

本文的其餘部分概述了研究者對 transformer 架構的修改以及訓練方法。然後介紹了模型性能,並在一組標準基準上與其他大型語言模型進行了比較。最後,研究者使用了負責任的人工智慧社群的一些最新基準,展示了模型中的偏見和毒性。

研究者所使用的訓練方法與(Brown et al., 2020)、(Chowdhery et al., 2022) 等先前工作中所描述的方法相似,並受到Chinchilla scaling laws (Hoffmann et al., 2022) 的啟發。研究者使用了一個標準的優化器在大量的文字資料上訓練大型 transformer。

預訓練資料

#如表1 所示,本研究的訓練資料集是幾個來源的混合物,涵蓋了不同的領域。在大多數情況下,研究者重新使用了已經被用來訓練其他大型語言模型的資料來源,但此處的限制是只能使用公開可用的數據,並與開放資源相容。資料的混合情況以及它們在訓練集中所佔的百分比如下:

整個訓練資料集在 token 化之後大約包含 1.4T 的 token。對於大多數訓練數據,每個 token 在訓練期間只使用一次,但維基百科和 Books 域除外,我們在這兩個域上執行大約兩個 epoch。

架構

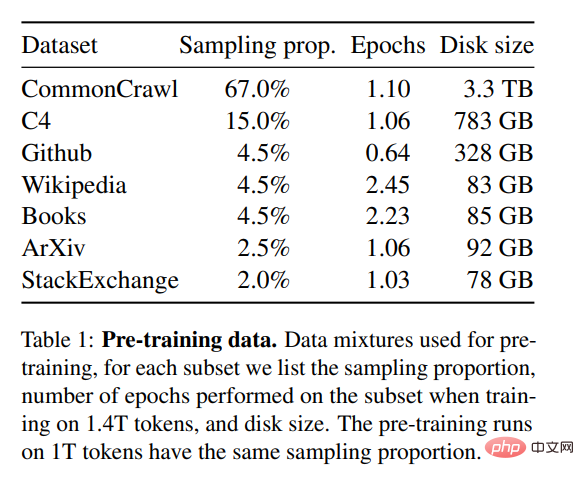

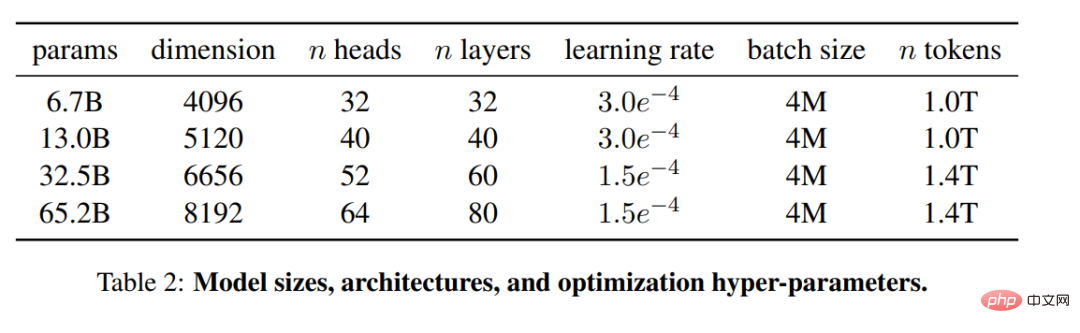

#基於最近關於大型語言模型的工作,這項研究同樣使用了 transformer 架構。研究者藉鑒了隨後提出並在不同的模型中使用的各種改進,例如 PaLM。在論文中,研究者介紹了與原始架構的主要差異:

預歸一化 [GPT3]。為了提高訓練的穩定性,研究者對每個 transformer 子層的輸入進行歸一化,而不是對輸出進行歸一化。他們使用了 Zhang and Sennrich (2019) 提出的 RMSNorm 歸一化函數。 SwiGLU 激活函數 [PaLM]。研究者以了 Shazeer (2020) 提出的 SwiGLU 活化函數取代了 ReLU 非線性以提高性能。他們分別使用 2D、3D、4D 的維度,而不是 PaLM 中的 4D。

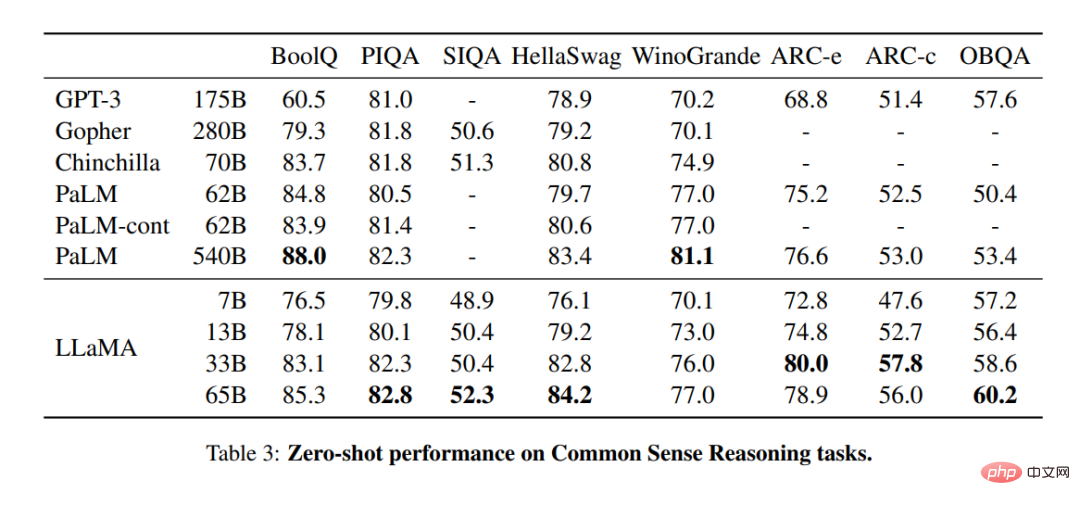

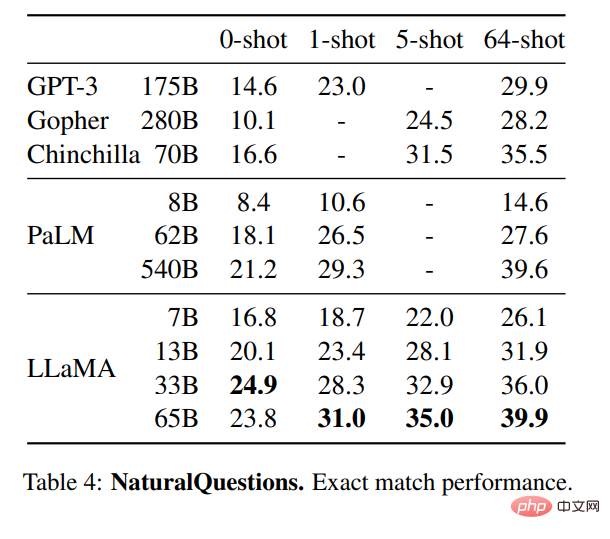

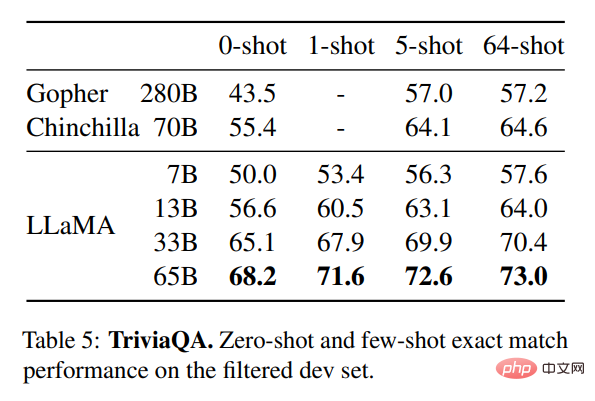

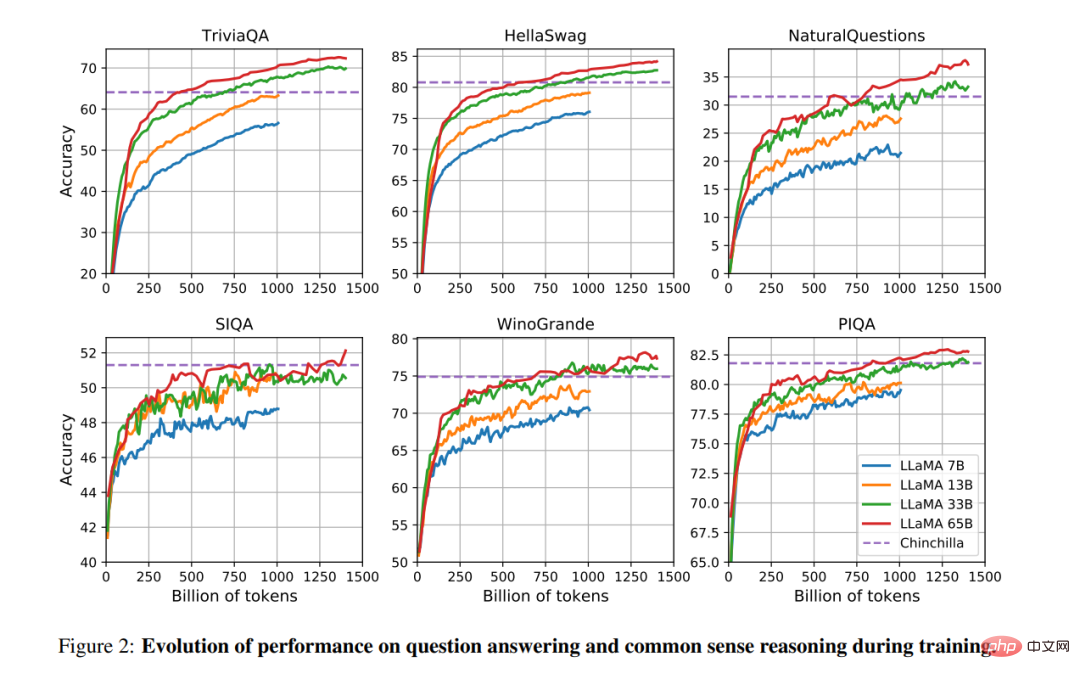

#########旋轉嵌入 [GPTNeo]。研究者刪除了絕對位置嵌入,在網路的每一層增加了 Su et al. (2021) 提出的旋轉位置嵌入(RoPE)。不同模型的超參數細節可見表 2。 ###########################實驗結果############常識性推理###### ##########在表3 中,研究者與現有的各種規模的模型進行比較,並報告了相應論文中的數字。首先,LLaMA-65B 在所有報告的基準上都超過了 Chinchilla-70B,除了 BoolQ。同樣,除了在 BoolQ 和 WinoGrande 上,這個模型在任何方面都超過了 PaLM540B。 LLaMA-13B 模型在大多數基準上也超過了 GPT-3,儘管其體積小了 10 倍。 ##############################結束卷答案#########表 4 展示了 NaturalQuestions 的性能,表 5 展示了 TriviaQA 的性能。在這兩項基準測試中,LLaMA-65B 在零樣本和少樣本設定中都達到了最先進的效能。更重要的是,儘管 LLaMA-13B 是 GPT-3 和 Chinchilla 的五分之一到十分之一,但在這些基準測試中也同樣備競爭力。該模型的推理過程是在單一 V100 GPU 上運行的。

閱讀理解

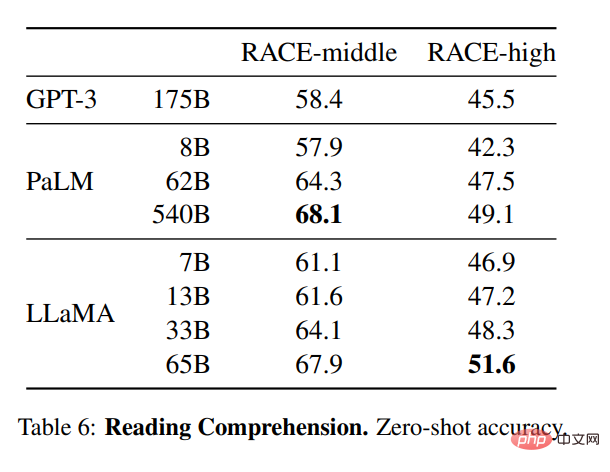

研究者也在RACE 閱讀理解基準(Lai et al., 2017) 上評估了模型。此處遵循 Brown et al. (2020) 的評估設置,表 6 展示了評估結果。在這些基準上,LLaMA-65B 與 PaLM-540B 具有競爭力,而且,LLaMA-13B 比 GPT-3 還高出幾個百分點。

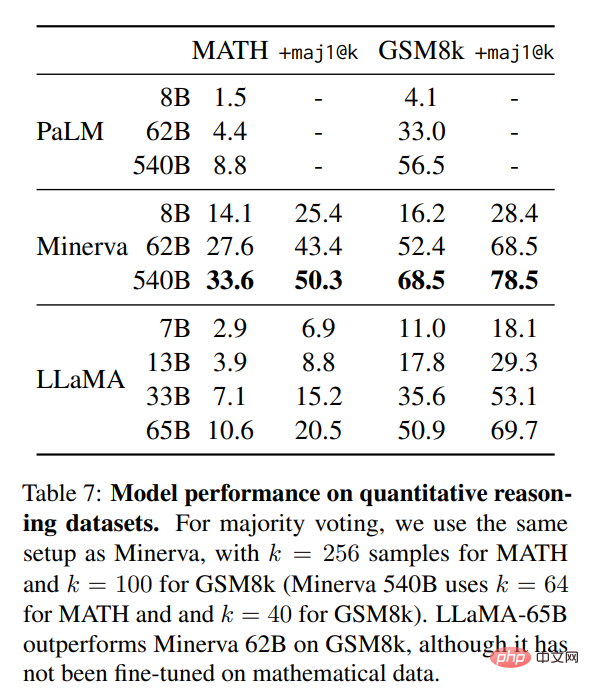

數學推理

#數學推理

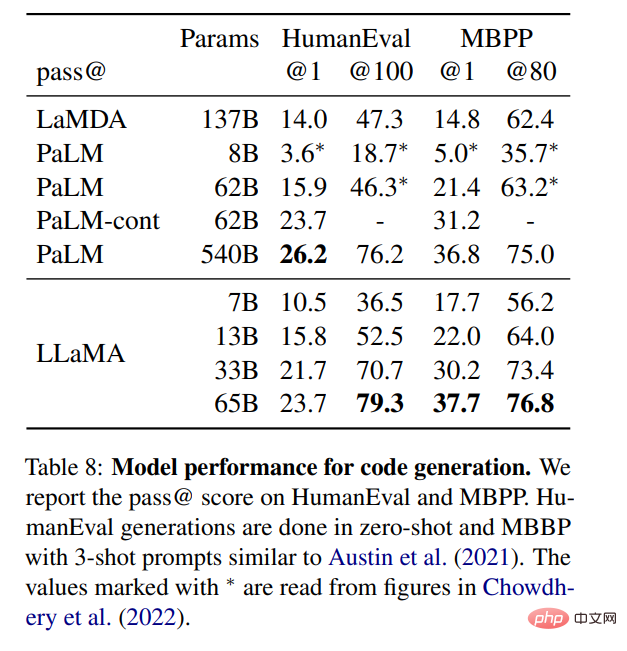

程式碼產生

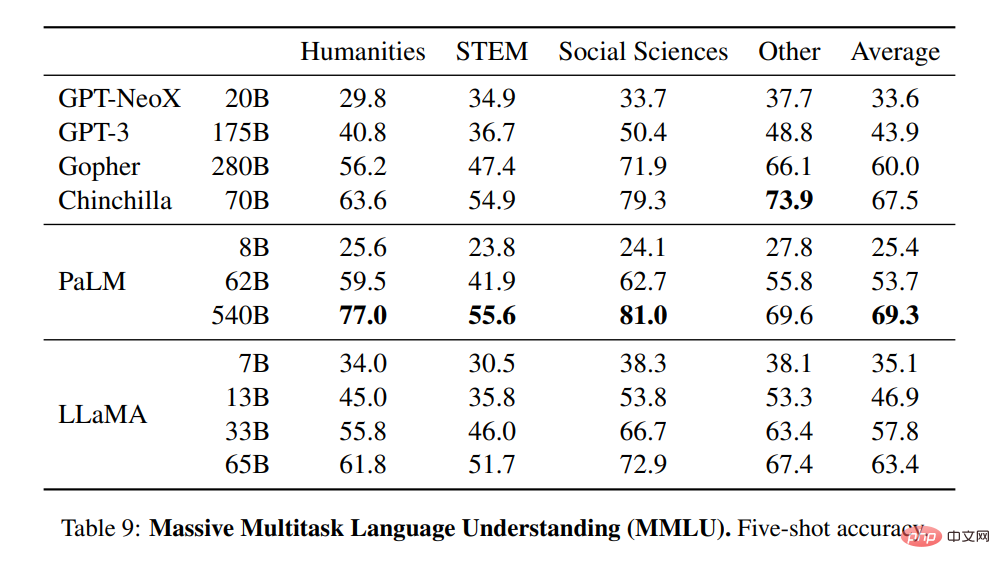

大規模多任務語言理解

訓練期間的效能變化

以上是這是Meta版ChatGPT雛型?開源、一塊GPU就能跑,1/10參數量打敗GPT-3的詳細內容。更多資訊請關注PHP中文網其他相關文章!