隨著Stable Diffusion的開源,用自然語言進行圖像生成也逐漸普及,許多AIGC的問題也暴露了出來,例如AI不會畫手、無法理解動作關係、很難控制物體的位置等。

其主要原因還是在於「輸入介面」只有自然語言,無法做到對畫面的精細控制。

最近來自威斯康辛大學麥迪遜分校、哥倫比亞大學和微軟的研究熱源提出了一個全新的方法GLIGEN,以grounding輸入為條件,對現有「預訓練文本到圖像擴散模型”的功能進行擴展。

論文連結:https://arxiv.org/pdf/2301.07093.pdf

#專案首頁:https://gligen.github.io/

##體驗連結:https: //huggingface.co/spaces/gligen/demo

為了保留預訓練模型的大量概念知識,研究人員沒有選擇對模型進行微調,而是透過門控機制將輸入的不同grounding條件注入新的可訓練層中,以實現對開放世界圖像生成的控制。

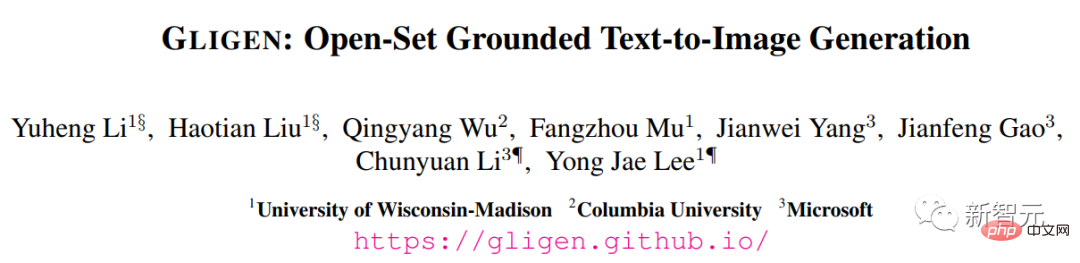

目前GLIGEN支援四種輸入。

(左上)文字實體box (右上)圖片實體box

#(左上)文字實體box (右上)圖片實體box

(左下)圖像風格文字box (右下)文字實體關鍵點

實驗結果也顯示,GLIGEN 在COCO 和LVIS上的zero-shot性能大大優於目前有監督layout-to-image基線。

可控影像生成在擴散模型之前,生成對抗網路(GANs)一直是影像生成領域的一哥,其潛空間和條件輸入在“可控操作”和“生成”方面得到了充分的研究。

文字條件自回歸和擴散模型表現出驚人的影像品質和概念覆蓋率,得益於其更穩定的學習目標和對網路影像-文字配對資料的大規模訓練,並迅速出圈,成為輔助藝術設計和創作的工具。

但現有的大規模文字-圖像生成模型不能以「文字以外」的其他輸入模式為條件,缺乏精確定位概念或使用參考圖像來控制生成過程的能力,限制了訊息的表達。

比如說,使用文字很難描述一個物體的精確位置,而邊界框(bounding

boxes)或關鍵點(keypoints )則可以很容易實現。

boxes)或關鍵點(keypoints )則可以很容易實現。

現有的一些工具如inpainting, layout2img產生等可以利用文字以外的模態輸入,但卻很少將這些輸入結合起來用於可控的text2img生成。

此外,先前的生成模型通常是在特定任務的資料集上獨立訓練的,而在影像辨識領域,長期以來的範式是透過從「大規模影像資料」或「圖像-文字對」上預先訓練的基礎模型開始建立特定任務的模型。

擴散模型已經在數十億的圖像-文字對上進行了訓練,一個很自然的問題是:我們能否在現有的預訓練的擴散模型的基礎上,賦予它們新的條件輸入模式?

由於預訓練模型所具有的大量概念知識,可能能夠在其他生成任務上取得更好的性能,同時獲得比現有文本-圖像生成模型更多的可控性。

GLIGEN#########基於上述目的和想法,研究人員提出的GLIGEN模型仍然保留文字標題作為輸入,但也啟用了其他輸入模態,如grounding概念的邊界框、grounding參考影像和grounding部分的關鍵點。 ######這裡面的關鍵難題是在學習注入新的grounding資訊的同時,也保留預訓練模型中原有的大量概念知識。

為了防止知識遺忘,研究人員提出凍結原來的模型權重,並增加新的可訓練的門控Transformer層以吸收新的grouding輸入,下面以邊界框為例。

指令輸入

#每個grouding文字實體都被表示為一個邊界框,包含左上角和右下角的座標值。 要注意的是,現有的layout2img相關工作通常需要一個概念字典,在評估階段只能處理close-set的實體(如COCO類別),研究人員發現使用編碼圖像描述的文字編碼器即可將訓練集中的定位資訊泛化到其他概念上。

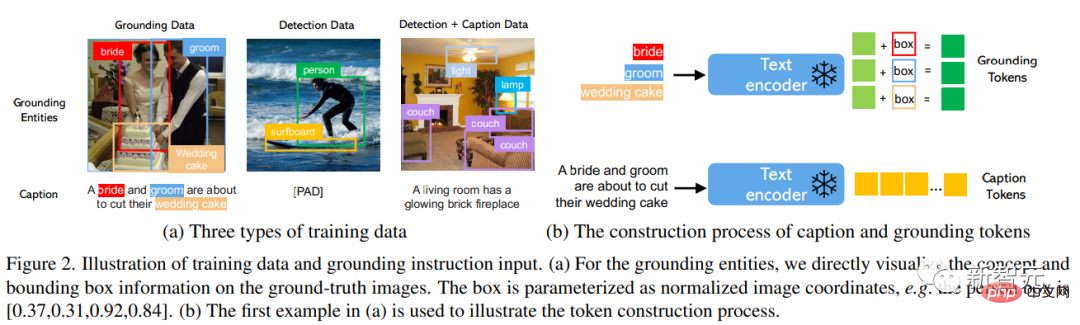

訓練資料

用於產生grounding影像的訓練資料需要文字c和grounding實體e作為條件,在實踐中可以透過考慮更靈活的輸入來放鬆對資料的要求。

主要有三種類型的資料

1. grounding資料

每張圖片都與描述整張圖片的標題相關聯;名詞實體從標題中提取,並標上邊界框。

由於名詞實體直接取自自然語言的標題,它們可以涵蓋更豐富的詞彙,有利於開放世界詞彙的grounding生成。

2. 偵測資料Detection data

#名詞實體是預先定義的close-set類別(例如COCO中的80個物件類別),選擇使用classifier-free引導中的空標題token作為標題。

偵測資料的數量(百萬級)大於基礎資料(千級),因此可以大幅增加整體訓練資料。

3. 偵測與標題資料Detection and Caption data

名詞實體與偵測資料中的名詞實體相同,而圖像是單獨用文字標題描述的,可能存在名詞實體與標題中的實體不完全一致的情況。 例如標題只給了客廳的高層次描述,沒有提到場景中的物體,而偵測標註則提供了更精細的物體層次的細節。

門控注意力機制

#大型擴散模型已經在網路規模的圖像文字上進行了預訓練,以獲得基於多樣化和複雜的語言指令合成現實圖像所需的知識,由於預訓練的成本很高,性能也很好,在擴展新能力的同時,在模型權重中保留這些知識是很重要的,可以通過調整新的模組來逐步適應新能力。

###############在訓練過程中,使用門控機制逐漸將新的grounding資訊整合到預訓練的模型中,這種設計使生成過程中的取樣過程具有靈活性,以提高品質和可控性。 ############實驗中也證明了,在採樣步驟的前半部分使用完整的模型(所有層),在後半部分只使用原始層(沒有門控Transformer層),生成的結果能夠更準確反映grounding條件,同時具有較高的影像品質。 ######

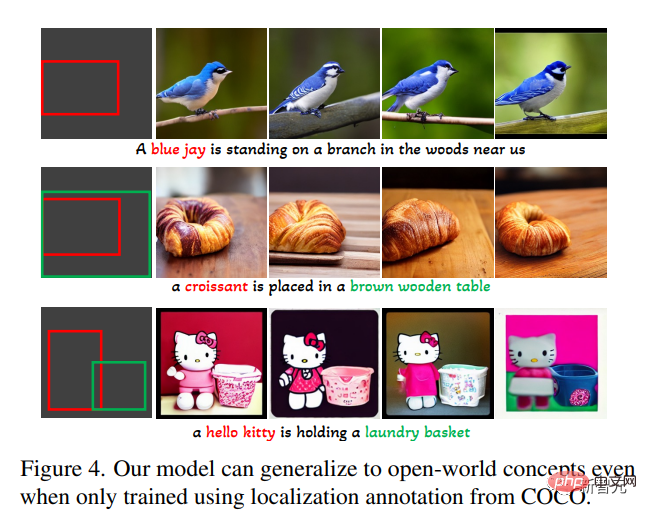

在開放集合grounded文字到影像產生任務中,首先只用COCO(COCO2014CD)的基礎標註進行訓練,並評估GLIGEN是否能產生COCO類別以外的基礎實體。

可以看到,GLIGEN可以學會新的概念如「藍鴉」、「羊角麵包」,或新的物件屬性如“棕色木桌”,而這些資訊並沒有出現在訓練類別中。

研究人員認為這是因為GLIGEN的門控自註意力學會了為接下來的交叉注意力層重新定位與標題中的接地實體相對應的視覺特徵,並且由於這兩層中的共享文字空間而獲得了泛化能力。

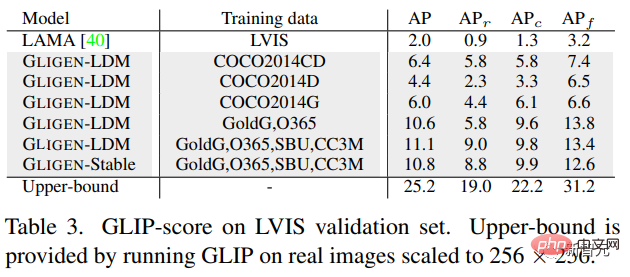

實驗中也定量評估了該模型在LVIS上的zero-shot產生效能,該模型包含1203個長尾物件類別。使用GLIP從生成的圖像中預測邊界框併計算AP,並將其命名為GLIP得分;將其與為layout2img任務設計的最先進的模型進行比較,

可以發現,儘管GLIGEN模型只在COCO標註上進行了訓練,但它比有監督的基線要好得多,可能因為從頭開始訓練的基線很難從有限的標註中學習,而GLIGEN模型可以利用預訓練模型的大量概念知識。

總的來說,這篇論文:

##1.提出了一種新的text2img生成方法,賦予了現有text2img擴散模型新的grounding可控性;

2. 透過保留預訓練的權重和學習逐漸整合新的定位層,該模型實現了開放世界的grounded text2img生成與邊界框輸入,即綜合了訓練中未觀察到的新的定位概念;

3. 此模型在layout2img任務上的zero-shot性能明顯優於先前的最先進水平,證明了大型預訓練生成模型可以提高下游任務的性能

以上是Diffusion+目標偵測=可控制影像生成!華人團隊提出GLIGEN,完美控制物件的空間位置的詳細內容。更多資訊請關注PHP中文網其他相關文章!