所有的成功都有跡可循,ChatGPT 也不例外。

前不久,因為對 ChatGPT 的評價過於苛刻,圖靈獎得主 Yann LeCun 被送上了熱搜。

在他看來,「就底層技術而言,ChatGPT 並沒有什麼特別的創新,」也不是「什麼革命性的東西」。許多研究實驗室正在使用同樣的技術,進行同樣的工作。更重要的是,ChatGPT 及其背後的 GPT-3 在許多方面都是由多方多年來開發的多種技術組成的,是不同的人數十年貢獻的結果。因此,LeCun 認為,與其說 ChatGPT 是一個科學突破,不如說它是一個像樣的工程實例。

「ChatGPT 是否具有革命性」是個充滿爭議的話題。但毋庸置疑,它確實是在先前累積的多項技術的基礎上建構起來的,例如核心的 Transformer 是谷歌在幾年前提出來的,而 Transformer 又受到了 Bengio 關於注意力概念的工作的啟發。如果再往前追溯,我們還能連結到更古的幾十年前的研究。

當然,大眾可能體會不到這種循序漸進的感覺,畢竟不是誰都會一篇一篇去看論文。但對於技術人員來說,了解這些技術的演進過程還是非常有幫助的。

在最近的一篇綜述文章中,來自密西根州立大學、北京航空航天大學、理海大學等機構的研究者仔細梳理了該領域的幾百篇論文,主要聚焦在文本、圖像和圖學習領域的預訓練基礎模型,非常值得一讀。杜克大學教授、加拿大工程院院士裴健,伊利諾大學芝加哥分校電腦科學系特聘教授俞士綸(Philip S. Yu) ,Salesforce AI Research 副總裁熊蔡明都是論文作者之一。

論文連結:https://arxiv.org/pdf/2302.09419.pdf

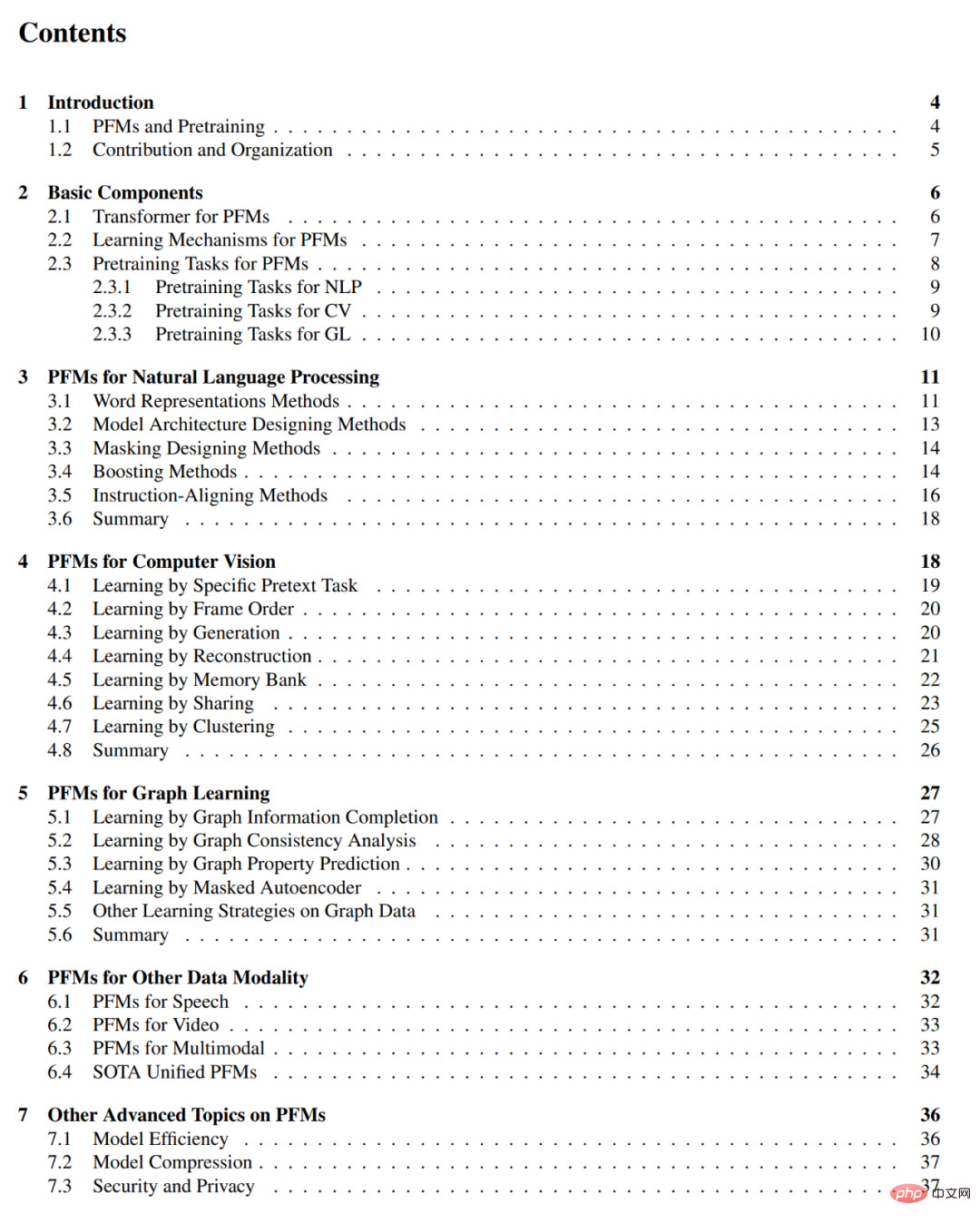

#論文目錄如下:

#在海外社群平台上,DAIR.AI 聯合創始人Elvis S.推薦了這篇綜述並獲得了一千多的讚量。

預訓練基礎模型(PFM)是大數據時代人工智慧的重要組成部分。 「基礎模型」的名字來自 Percy Liang、李飛飛等人發布的一篇綜述 ——《On the Opportunities and Risks of Foundation Models》,是一類模型及其功能的總稱。在 NLP、CV 和圖學習領域,PFM 已經被廣泛研究了。在各種學習任務中,它們表現出了強大的特徵表示學習潛力,如文字分類、文字生成、圖像分類、目標偵測和圖分類等任務。無論是使用大型資料集在多個任務上訓練,還是在小規模任務上進行微調,PFM 都表現出了優越的效能,這使其快速啟動資料處理成為可能。

PFM 和預訓練

#PFM 是基於預訓練技術,目的是利用大量的資料和任務來訓練一個通用模型,該模型可以在不同的下游應用中輕鬆進行微調。

預訓練的想法起源於 CV 任務中的遷移學習。但看到該技術在 CV 領域的有效性後,人們也開始利用該技術來提高其他領域的模型效能。

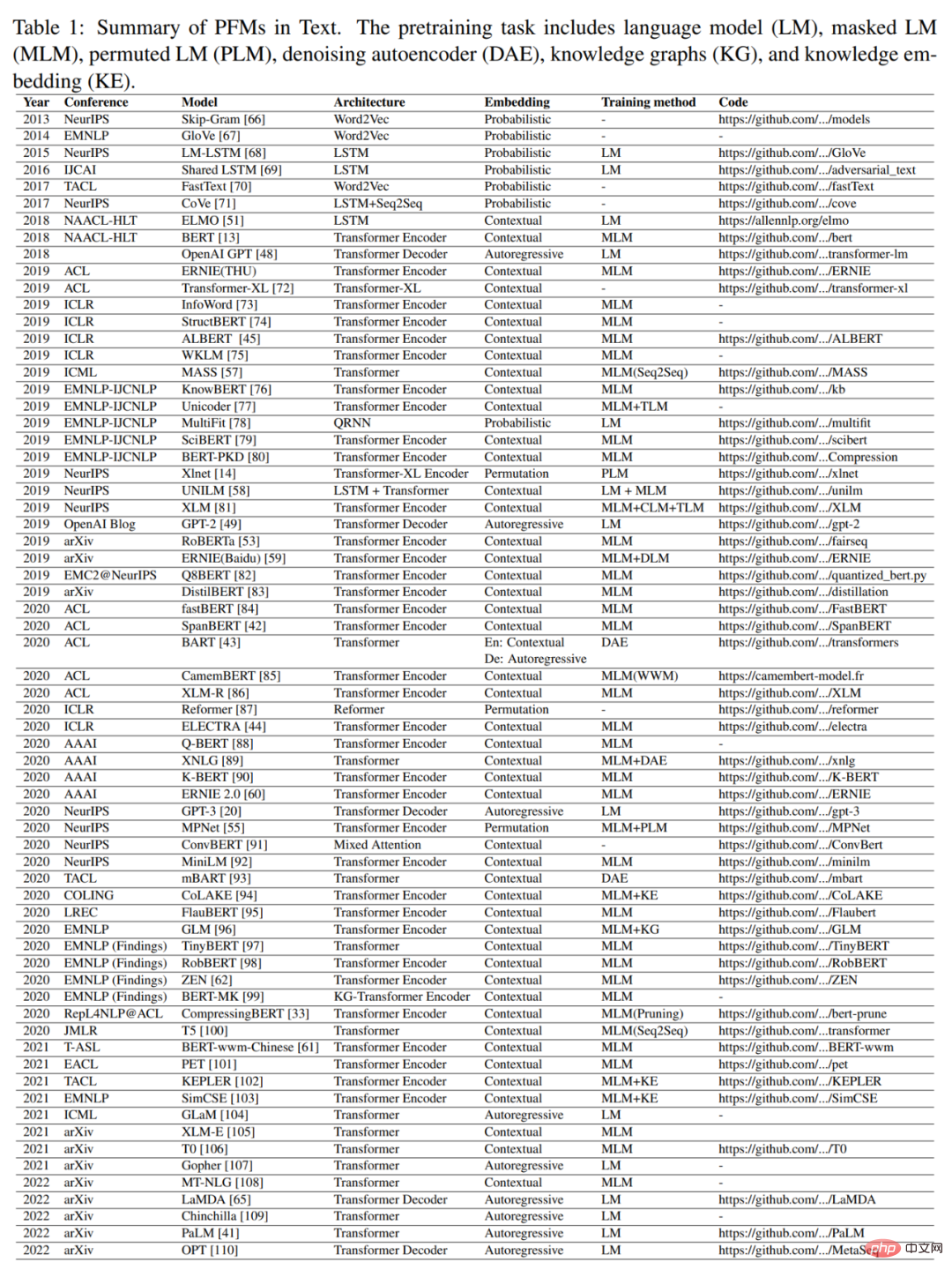

當預訓練技術應用於 NLP 領域時,經過良好訓練的語言模型可以捕捉到對下游任務有益的豐富知識,如長期依賴關係、層次關係等。此外,預訓練在 NLP 領域的顯著優勢是,訓練資料可以來自任何未標記的文字語料庫,也就是說,幾乎存在著無限量的訓練資料可以用於預訓練過程。早期的預訓練是一種靜態技術,如 NNLM 和 Word2vec,但靜態方法很難適應不同的語意環境。因此,人們提出了動態預訓練技術,如 BERT、XLNet 等。圖 1 描述了 PFM 在 NLP、CV 和 GL 領域的歷史和演變。基於預訓練技術的 PFM 使用大型語料庫來學習通用語意表徵。隨著這些開創性工作的引入,各種 PFM 已經出現,並被應用於下游的任務和應用。

最近走紅的 ChatGPT 是 PFM 應用的典型案例。它是從生成性預訓練 transformer 模型 GPT-3.5 中微調出來的,該模型利用了大量本文和程式碼進行訓練。此外,ChatGPT 還應用了來自人類回饋的強化學習(RLHF),這已經成為讓大型 LM 與人類意圖保持一致的一種有希望的方式。 ChatGPT 卓越的表現表現可能會為每種類型的 PFM 的訓練範式帶來轉變,例如指令對齊技術、強化學習、prompt tuning 和思維鏈的應用,從而走向通用人工智慧。

本文將聚焦在文字、圖像和圖領域的 PFM,這是一個相對成熟的研究分類方法。對於文字來說,它是一個多用途的 LM,用於預測序列中的下一個單字或字元。例如,PFM 可用於機器翻譯、問答系統、主題建模、情緒分析等。對於圖像,它類似於文字上的 PFM,使用巨大的資料集來訓練一個適合許多 CV 任務的大模型。對於圖來說,類似的預訓練想法也被用來獲得 PFM,這些 PFM 被用於許多下游任務。除了針對特定資料域的 PFM,本文也回顧並闡述了其他一些先進的 PFM,例如針對語音、視訊和跨域資料的 PFM,以及多模態 PFM。此外,一場能夠處理多模態任務的的 PFM 的大融合正在出現,這就是所謂的 unified PFM。作者首先定義了 unified PFM 的概念,然後回顧了最近研究中達到 SOTA 的 unified PFM(如 OFA、UNIFIED-IO、FLAVA、BEiT-3 等)。

根據上述三個領域現有的 PFM 的特點,作者得出結論,PFM 有以下兩大優勢。首先,要提高在下游任務中的效能,模型只需要進行很小的微調。其次,PFM 已經在品質方面得到了審查。我們可以將 PFM 應用於任務相關的資料集,而不是從頭開始建立模型來解決類似的問題。 PFM 的廣闊前景激發了大量的相關工作來關注模型的效率、安全性和壓縮等問題。

論文貢獻與結構

#在這篇文章發布之前,已經有幾篇綜述回顧了一些特定領域的預訓練模型,如文字生成、視覺transformer、目標偵測。

《On the Opportunities and Risks of Foundation Models》總結了基礎模型的機會和風險。然而,現有的工作並沒有實現不同領域(如 CV、NLP、GL、Speech、Video)PFM 在不同方面的全面回顧,如預訓練任務、效率、效力和隱私。在這篇綜述中,作者詳細闡述了 PFM 在 NLP 領域的演變,以及預訓練如何遷移到 CV 和 GL 領域並被採用。

與其他綜述相比,本文並未對所有三個領域的現有 PFM 進行全面的介紹和分析。與先前預訓練模型的回顧不同,作者總結了現有的模型,從傳統模型到 PFM,以及三個領域的最新工作。傳統模型強調的是靜態特徵學習。動態 PFM 對結構進行了介紹,這是主流的研究。

作者進一步介紹了 PFM 的一些其他研究,包括其他先進和統一的 PFM、模型的效率和壓縮、安全以及隱私。最後,作者總結了未來的研究挑戰和不同領域的開放問題。他們也在附錄 F 和 G 中全面介紹了相關的評價指標和資料集。

總之,本文的主要貢獻如下:

各章節的主要內容如下:

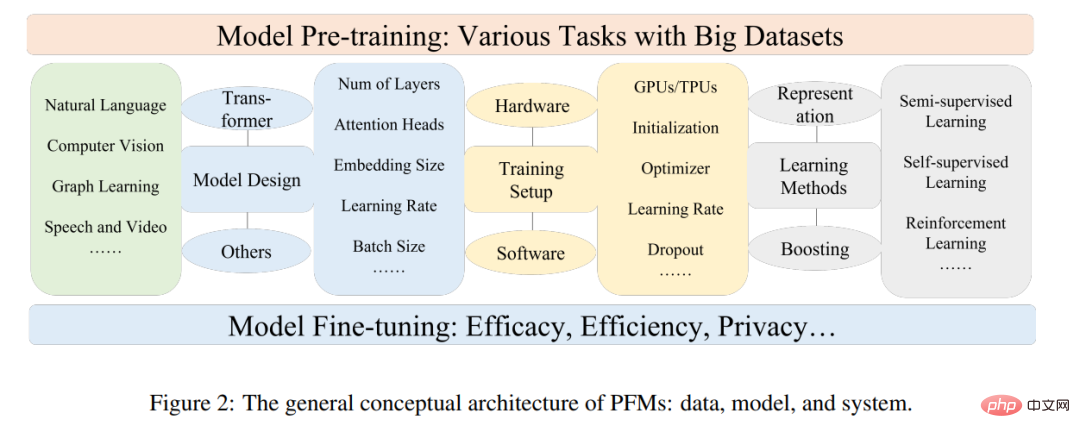

論文第2 章介紹了PFM 的一般概念架構。

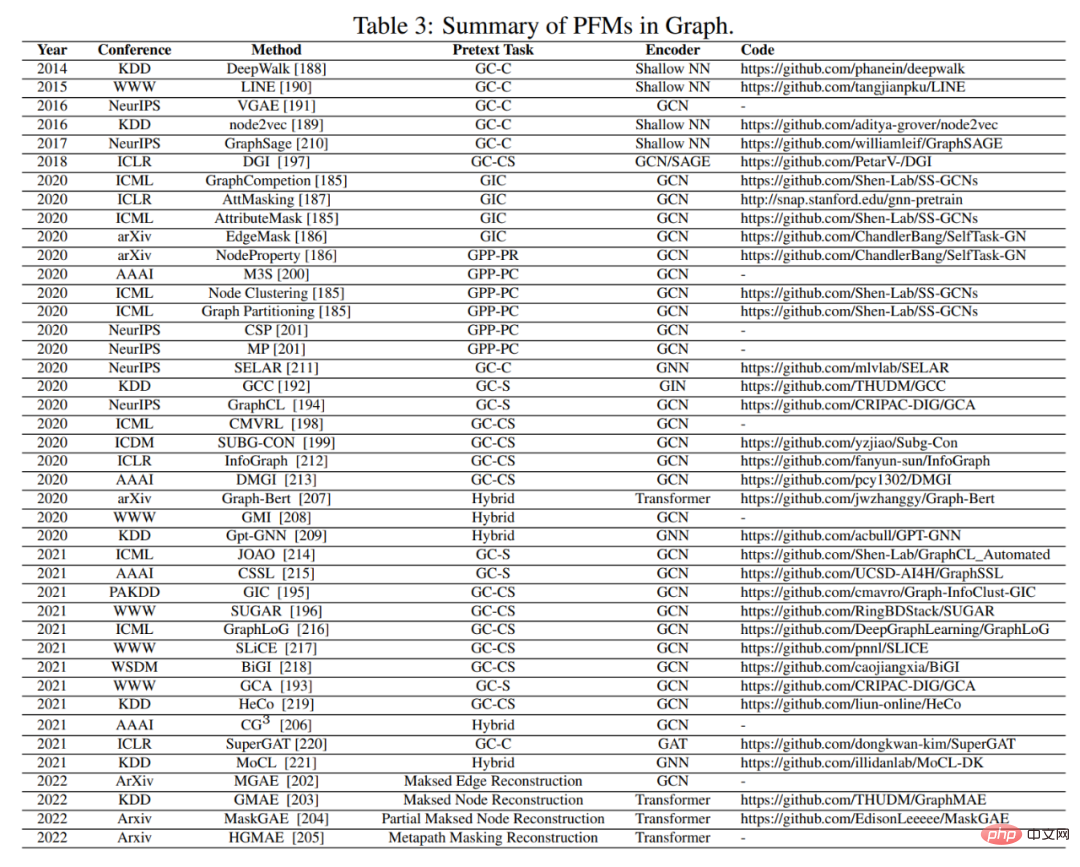

第 3、4、5 章分別總結了 NLP、CV 和 GL 領域中現有的 PFM。

第6、7 章介紹了PFM 的其他前沿研究,包括前沿和統一的PFM、模型效率和壓縮,以及安全和隱私。

###第 8 章總結了 PFM 的主要挑戰。第 9 章對全文進行了總結。 ######以上是從BERT到ChatGPT,百頁綜述梳理預訓練大模型演變史的詳細內容。更多資訊請關注PHP中文網其他相關文章!