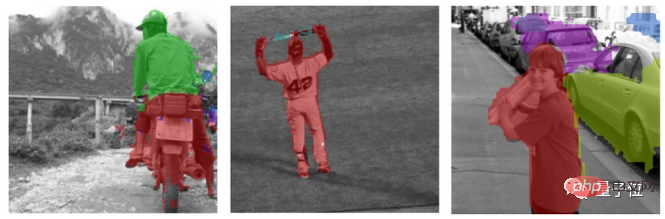

從來沒有見過的新物體,它也能被很好地分割。

這是DeepMind研究出的一個新的學習框架:目標發現和表示網絡(Object discovery and representation networks,簡稱Odin)

以往的自我監督學習(SSL)方法能夠很好地描述整個大的場景,但是很難區分出單一的物體。

現在,Odin方法做到了,而且是在沒有任何監督的情況下做到的。

區分出影像中的單一物體可不是很容易的事,它是怎麼做到的呢?

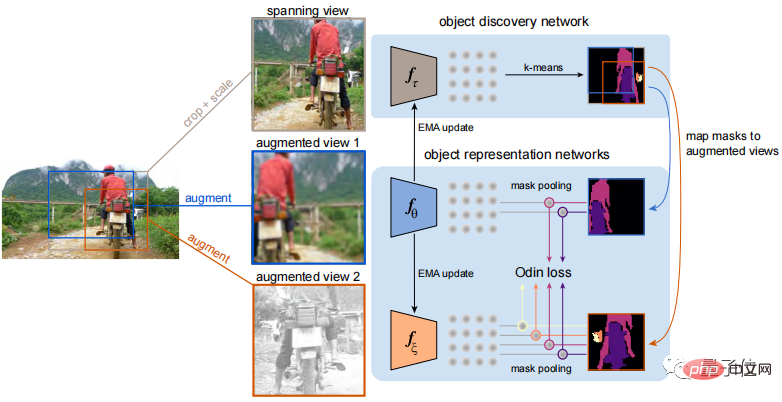

能夠很好地區分出影像中的各個物體,主要歸功於Odin學習框架的「自我循環」。

Odin學習了兩組協同工作的網絡,分別是目標發現網絡和目標表示網絡。

目標發現網路以影像的一個裁剪部分作為輸入,裁剪的部分應該包含影像的大部分區域,而這部分影像並沒有在其他方面進行增強處理。

接著對輸入影像產生的特徵圖進行聚類分析,根據不同的特徵對影像中各個物體的進行分割。

目標表示網路的輸入視圖是目標發現網路中所產生的分割影像。

視圖輸入之後,分別對它們進行隨機預處理,包括翻轉、模糊和點級色彩轉換等。

這樣就能夠獲得兩組掩模,它們除了剪裁之外的差異,其他資訊都和底層圖像內容相同。

而後兩個掩模會透過對比損失,進而學習能夠更好地表示影像中物體的特徵。

具體來說,就是透過對比偵測,訓練一個網路來辨識不同目標物體的特徵,同時還有許多來自其他不相干物體的「負面」特徵。

然後,最大化不同掩模中同一目標物體的相似性,最小化不同目標物體之間的相似性,進而更好地進行分割以區別不同目標物體。

同時,目標發現網路會定期根據目標表示網路的參數進行對應的更新。

最終的目的是確保這些物件層級的特性在不同的視圖中大致不變,換句話說就是將影像中的物件分隔開來。

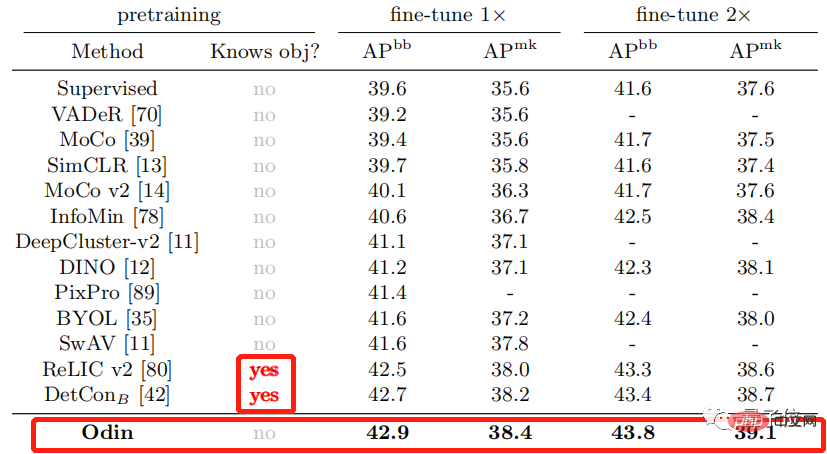

那麼Odin學習框架的效果究竟如何呢?

Odin方法在場景分割時,沒有先驗知識的情況下遷移學習的效能也很強大。

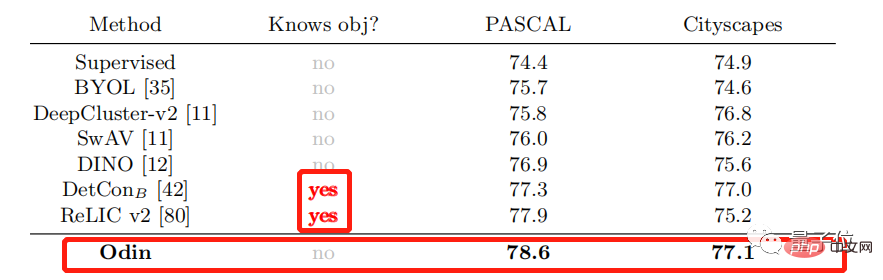

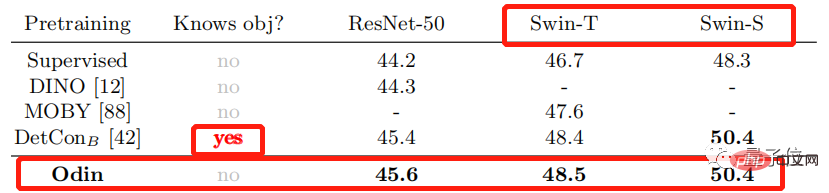

首先,使用Odin方法在ImageNet資料集上進行預訓練,然後評估其在COCO資料集以及PASCAL和Cityscapes語意分割上的效果。

已經知道目標物體,也就是獲得先驗知識的方法在進行場景分割時,效果要明顯優於其他未獲得先驗知識的方法。

而Odin方法即使未獲得先驗知識,其效果也要優於獲得先驗知識的DetCon和ReLICv2。

除此之外,Odin方法不僅可以應用在ResNet模型中,還可以應用到更複雜的模型中,如Swim Transformer。

在資料上,Odin框架學習的優勢很明顯,那在視覺化的影像中,Odin的優勢在何處體現了呢?

將使用Odin產生的分割影像與隨機初始化的網路(第3列),ImageNet監督的網路(第4列)中獲得的分割影像進行比較。

第3、4列都未能清楚地描繪出物體的邊界,或缺乏現實世界物體的一致性與局部性,而Odin所產生的影像效果很明顯較好。

參考連結:

[1] https://twitter.com/DeepMind/status/1554467389290561541

[2] https://arxiv.org/abs/2203.08777

以上是未知物體也能輕易辨識分割,效果可遷移的詳細內容。更多資訊請關注PHP中文網其他相關文章!