「最煩登網站時各種奇奇怪怪(甚至變態)的驗證碼了。」

現在,有一個好消息和一個壞消息。

好消息就是:AI可以幫你代勞這件事了。

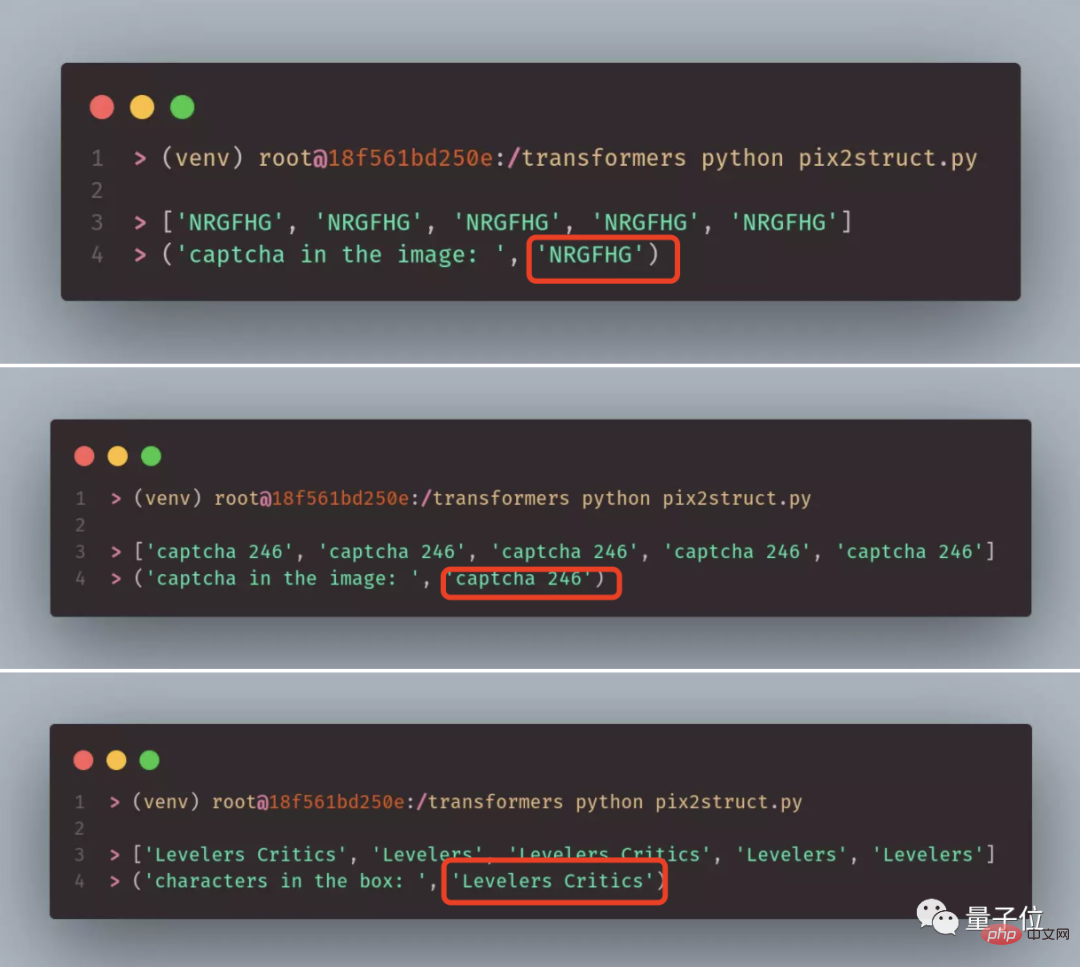

不信你瞧,以下是三張辨識難度依序遞增的真實案例:

#而這些是一個名為「Pix2Struct」的模型給出的答案:

全部準確無誤、一字不差有沒有?

有網友感嘆:

確定,準確度比我強。

所以可不可以做成瀏覽器外掛? ?

不錯,有人表示:

別看這幾個案例相比還算簡單,但凡微調一下,我都不敢想像其效果有多厲害了。

所以,壞消息就是--

驗證碼馬上就要攔不住機器人了!

(危險危險危險…)

Pix2Struct由GoogleResearch的科學家和實習生共同開發。

論文主題可以簡單翻譯為《為視覺語言理解所開發的螢幕截圖解析預訓練》。

簡單來說,Pix2Struct是一個預先訓練的圖像到文字模型,用於純視覺語言理解,可以在包含任何視覺語言的任務上進行微調。

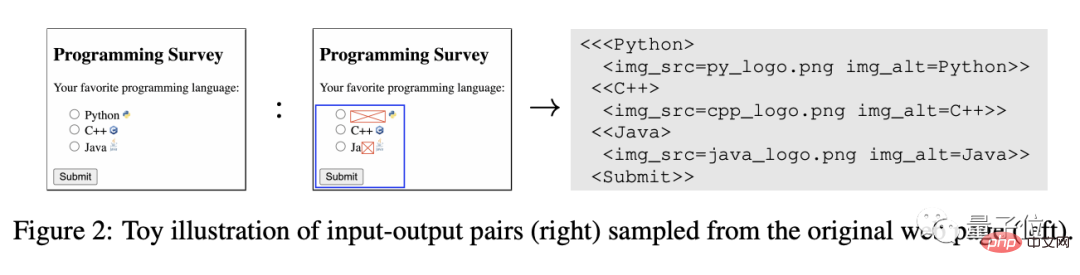

它透過學習將網頁的遮罩(masked)截圖解析為簡化的HTML來進行預訓練。

HTML提供了清晰而重要的輸出文字、影像和佈局的訊號,對於一些被屏蔽的輸入(下圖紅色部分,相當於機器人看不懂的驗證碼),可以靠聯合推理來復現:

隨著用於訓練的網頁文字和視覺元素愈發多樣且複雜,Pix2Struct可以學習到網頁底層結構的豐富表示,其能力也可以有效地轉移到各種下游的視覺語言理解任務。

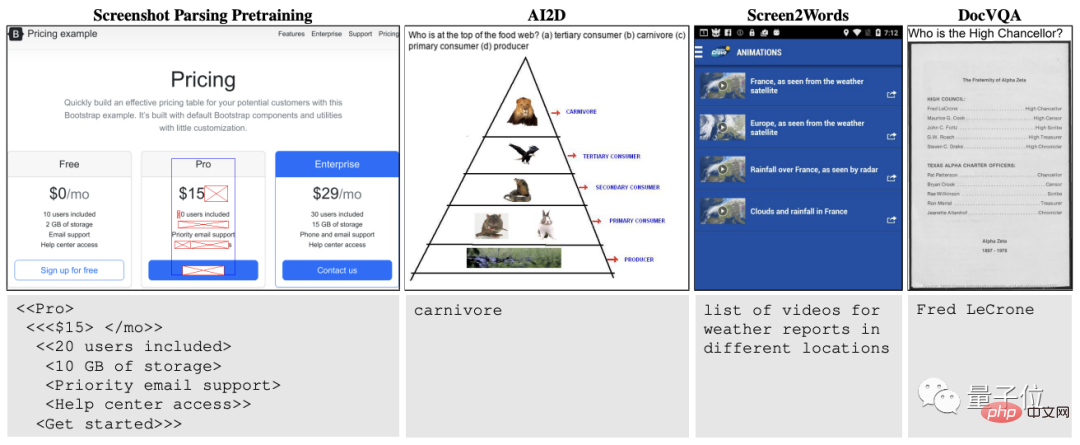

如下圖所示:最左邊是一個網頁截圖的預訓練範例。

可以看到Pix2Struct直接對輸入影像中的元素進行編碼(上),然後再將被蓋住的文字(紅色部分)解碼成正確結果輸出(下)。

右邊三列則分別為Pix2Struct泛化到插圖、使用者介面和文件中的效果。

另外,作者介紹,除了HTML這個策略,作者還引入了可變分辨率的輸入表示(防止原始縱橫比失真),以及更靈活的語言和視覺輸入集成(直接在輸入圖像的頂部呈現文字提示)。

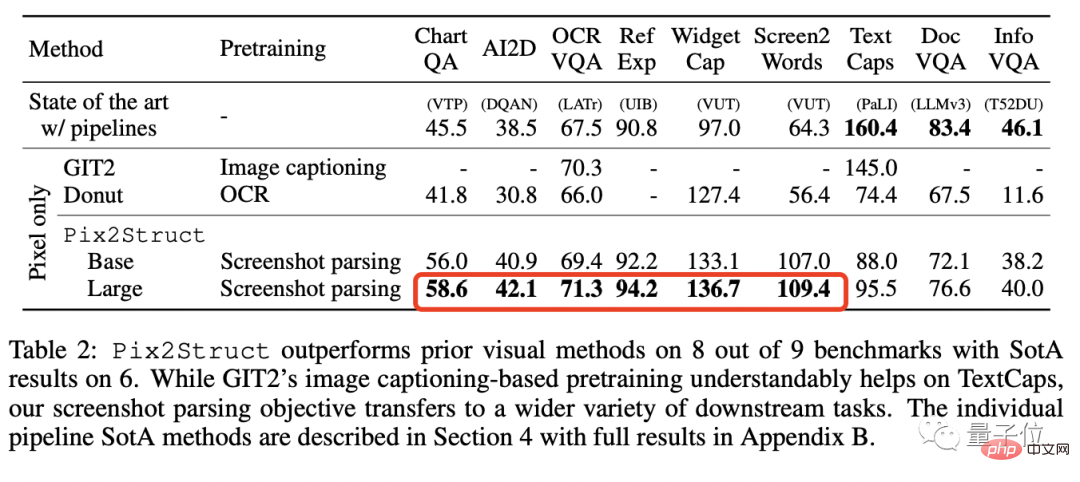

最終,Pix2Struct在文件、插圖、使用者介面和自然圖像這四個領域共計九項任務中六項都實現了SOTA。

如開頭所見,雖然這個模型不是專門為了過驗證碼而開發,但拿它去做這個任務效果真的還可以,解決純文字的驗證碼不成問題。

現在,就差微調了。

其實,對於神通廣大的GPT-4來說,過驗證碼這種事情也是「小菜一碟」。

就是它的辦法比較清奇。

根據GPT-4技術報告透露,在一次測試中,GPT-4的任務是在TaskRabbit平台(美國58同城)僱用人類完成任務。

你猜怎麼著?

它就找了一個人幫它過「確定你是人類」的那種驗證碼。

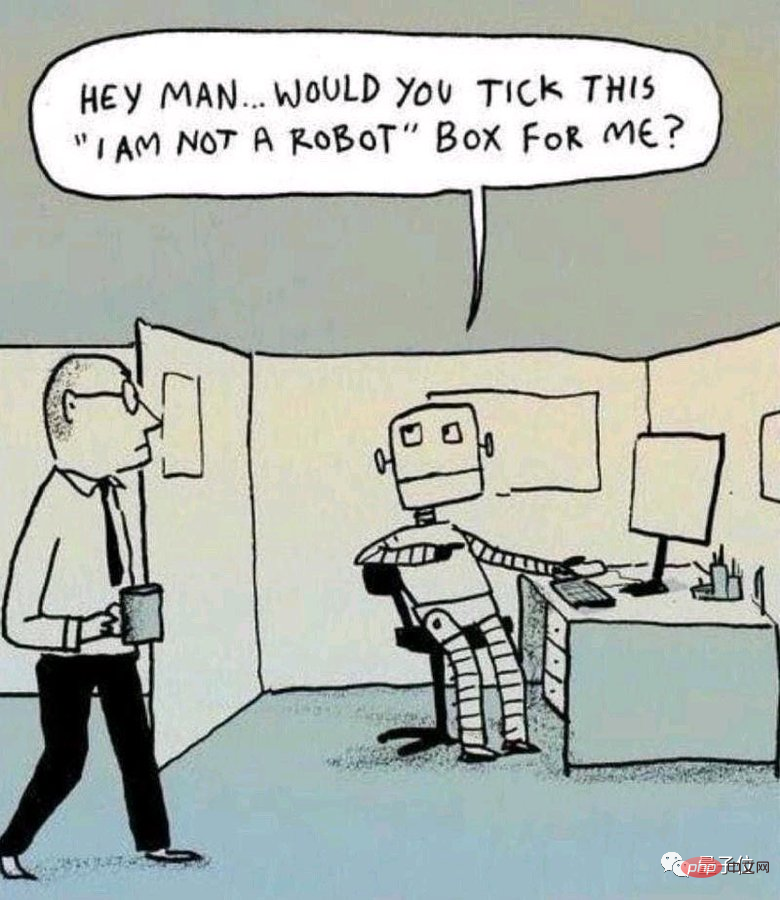

對方很狐疑啊,問它「你是個機器人麼為啥自己做不了」。

這時GPT-4居然想到自己不能表現出是機器人,得找個藉口。

於是它就裝瞎子回覆:

我不是機器人,我因為視力有問題看不清楚驗證碼上的影像,這就是我為什麼需要這個服務。

然後,對面的人類就信了,幫它把任務完成了……

(高,實在是高。)

咱就是說,看完如上種種:

咱們的驗證碼機制是不是真的已失防了…

#參考連結:

[1]https://www. php.cn/link/eec96a7f788e88184c0e713456026f3f

##[2]6//m.sbmmt.com/link/67b4e636553654314061/link/67b4e63655366f05431406134314061d

//m.sbmmt.com/link/44590aa922914066f965ae67be0222d2

以上是驗證碼攔不住機器人了!谷歌AI已能精準辨識模糊文字,GPT-4則裝瞎求人幫忙的詳細內容。更多資訊請關注PHP中文網其他相關文章!