在今天的人工智慧領域,AI 寫作神器層出不窮,技術和產品可謂日新月異。

如果說OpenAI 兩年前發布的GPT-3 在文筆上還稍欠火候,那麼前段時間的ChatGPT 的生成結果可以算是「文筆華麗、情節飽滿、邏輯自洽兼而有之」。

有人說,AI 要是動起筆來,那真是沒人類什麼事了。

但不管是人類還是 AI,一旦把「字數要求」提高,文章就會變得更難「駕馭」。

近日,華人 AI 研究科學家田淵棟和其他幾位研究者最近一起發布了一個新的語言模型——Re^3,這項研究也入選了 EMNLP 2022。

論文連結:https://arxiv.org/pdf/2210.06774.pdf

田淵棟曾在知乎上介紹這個模型:

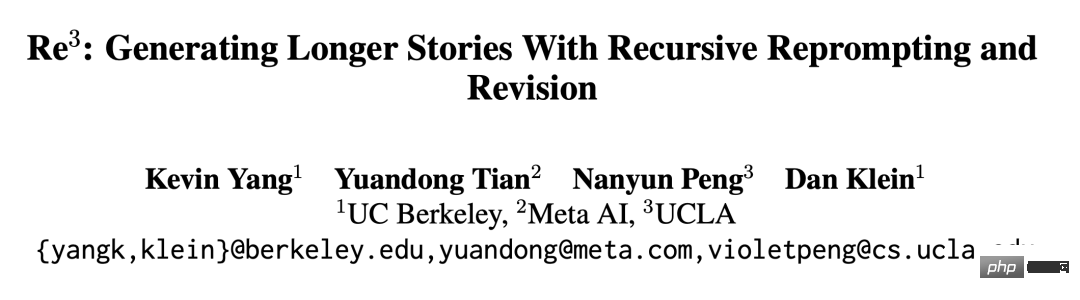

Re^3 的想法極為簡單,透過設計prompt 讓它產生一致性強的故事,完全不需要微調大模型。我們跳出語言模型的逐詞生成的線性邏輯,改用層次化生成方式:先在Plan 階段生成故事角色,角色的各種屬性和大綱,然後在Draft 階段給定故事大綱和角色,反復生成具體的段落,這些具體段落由Rewrite 階段篩選,挑出與前一段落高度相關的生成段落,而丟棄關係不大的(這需要訓練一個小模型),最後在Edit 階段修正一些明顯的事實錯誤。

Re^3 的想法是透過遞歸 Reprompt 和調整產生更長的故事,這更符合人類作家的創作過程。 Re^3 將人類寫作過程分解為規劃、草稿、改寫和編輯 4 個模組。

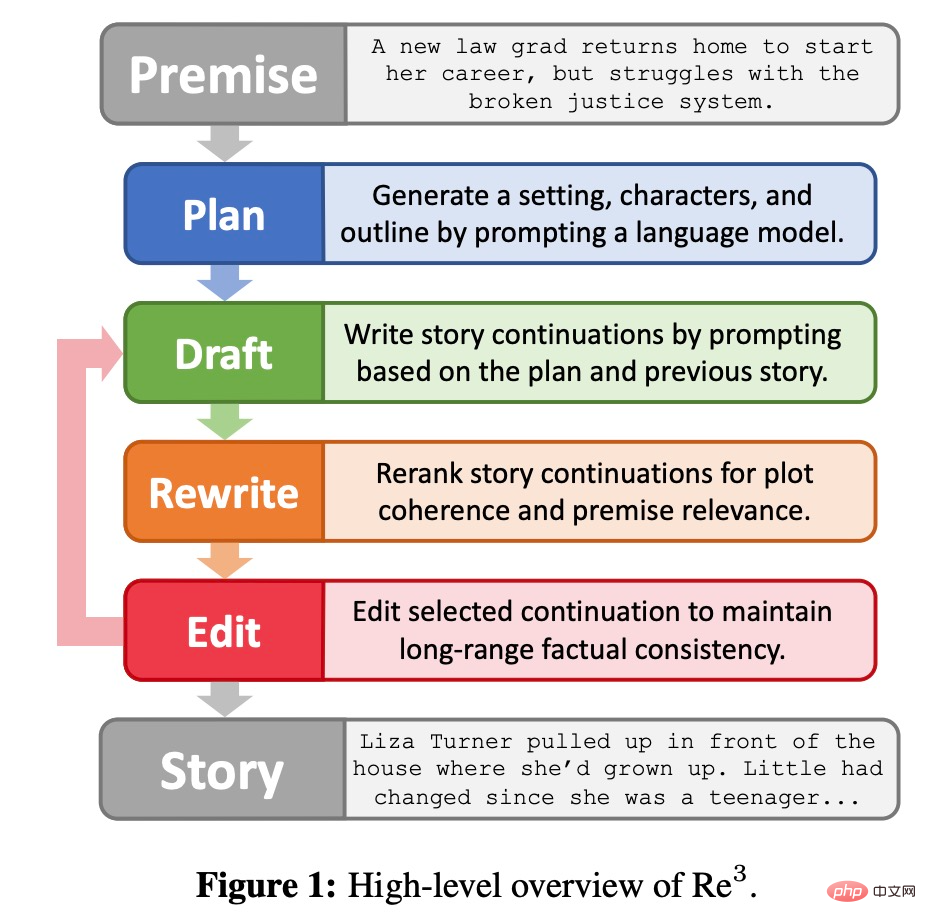

規劃(Plan)模組

如下圖2 所示,規劃模組會將故事前提(Premise)擴展為背景、人物角色和故事大綱。首先,背景是故事前提簡單的一句話擴展,使用GPT3-Instruct-175B (Ouyang et al.,2022) 獲得;然後,GPT3-Instruct175B 再生成角色名稱,並根據前提和背景生成角色描述;最後,該方法prompt GPT3-Instruct175B,以編寫故事大綱。規劃模組中的元件是透過 prompt 自己產生的,將會重複使用。

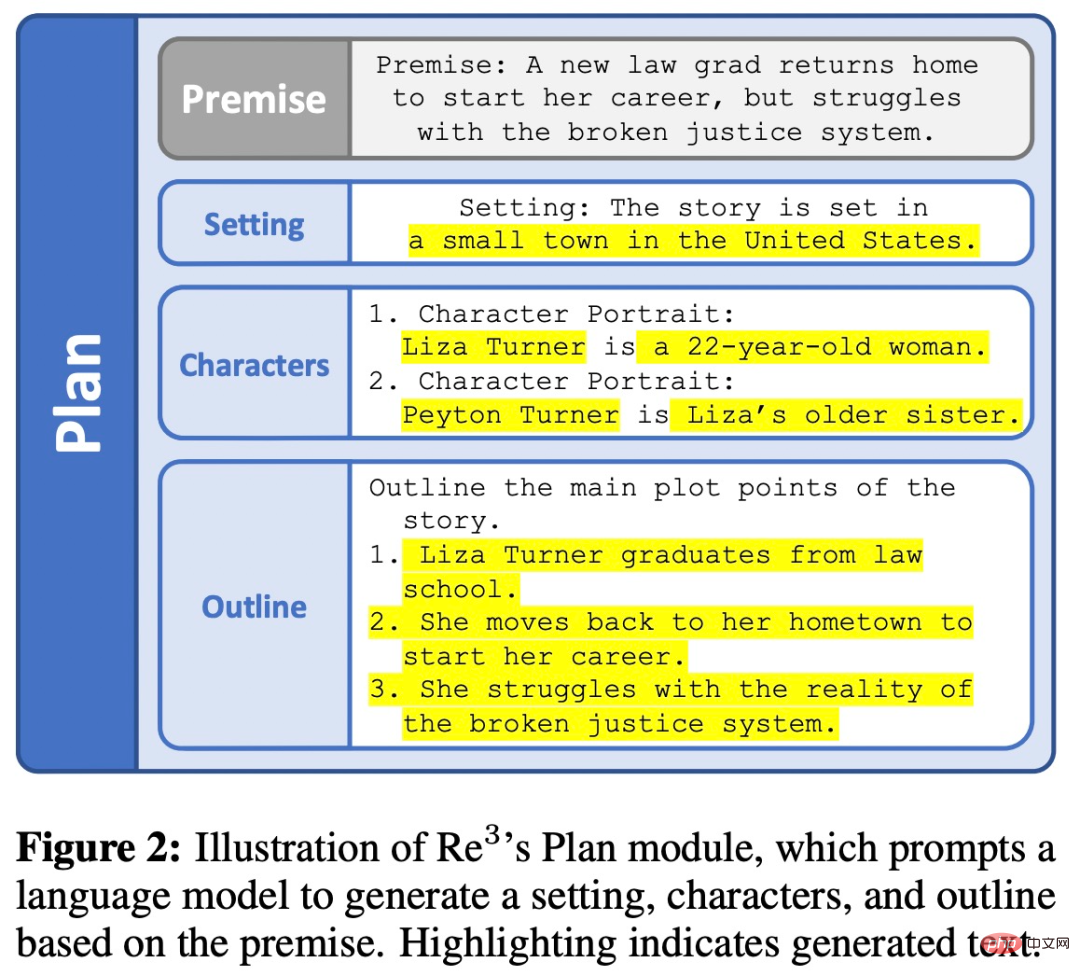

草稿(Draft)模組

針對規劃模組所得到的每一條大綱,草稿模組會繼續產生幾個故事段落。每個段落都是從結構化 prompt 產生的固定長度續寫,結構化 prompt 由遞歸 reprompt 形成,草稿模組如下圖 3 所示。

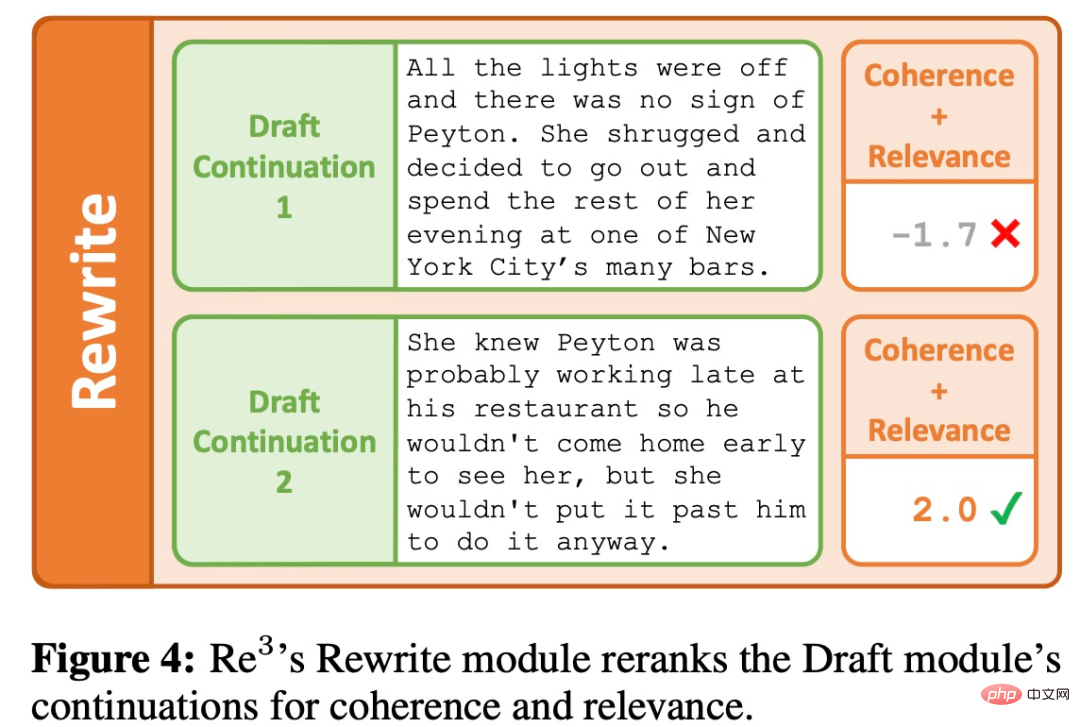

改寫(Rewrite)模組

產生器的第一個輸出通常是低品質的,就像人們完成的初稿,二稿可能需要在回饋的基礎上改寫一篇文章。

改寫模組透過根據與先前段落的連貫性和與當前大綱點的相關性對草稿模組輸出重新排序來模擬改寫過程,如下圖 4 所示。

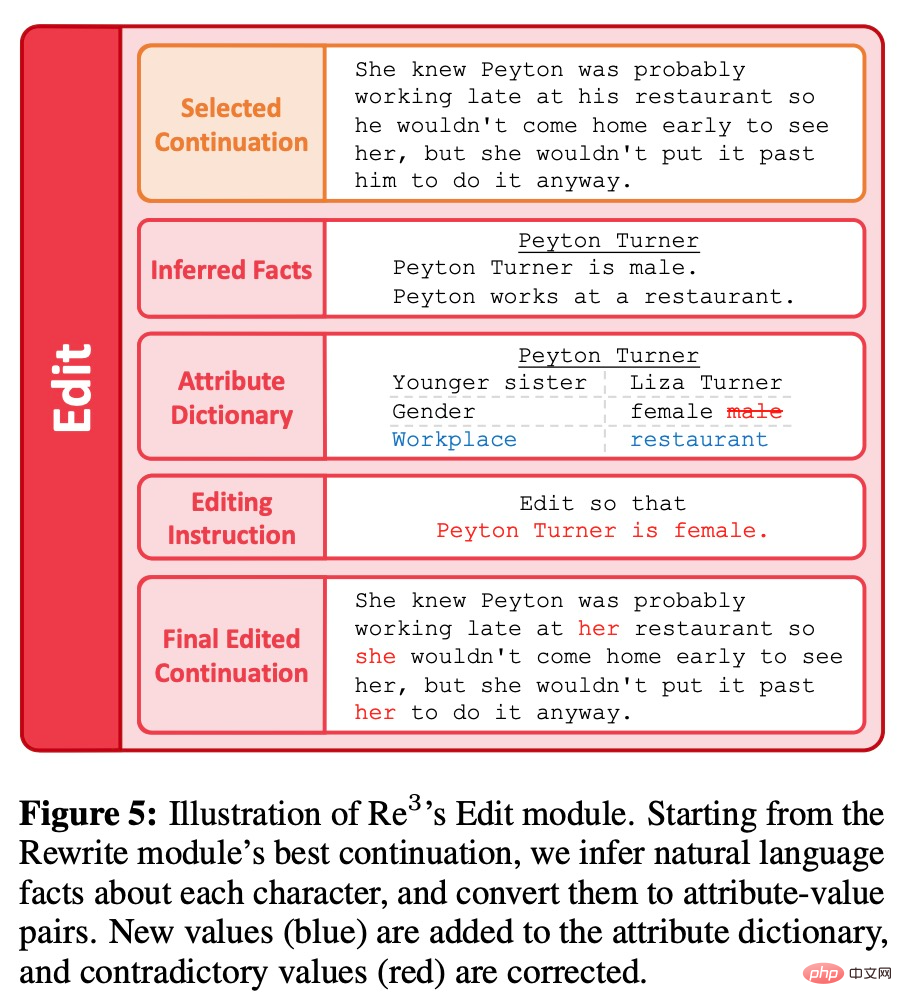

編輯(Edit)模組

與大幅改寫不同的是,編輯模組是對透過規劃、草稿和改寫模組產生的段落的局部編輯,進一步完善生成內容。具體來說,目標是消除長序列的事實不一致。當人們在校對時發現一個小的事實不連續,可能只是簡單地編輯一下有問題的細節,而不是對高層次的文章規劃進行重大修改或進行實質性的改寫。編輯模組透過兩個步驟來模仿人類創作的這個過程:檢測事實的不一致,並加以修正,如下圖 5 所示。

在評估環節,研究者將任務設定為在一個簡短的初始前情下生成一個故事。由於「故事」很難用基於規則的方式來定義,研究者沒有對可接受的輸出施加任何基於規則的約束,而是透過幾個人為註釋的指標來評估。為了產生初始前提,研究者以 GPT3-Instruct-175B 進行了 prompt,以獲得 100 個不同的前情。

Baseline

#由於先前的方法與Re^3 相比更側重於短故事,所以很難直接比較。於是研究者使用了以下兩個基於GPT3-175B 的基線:

1. ROLLING,透過GPT3-175B 一次產生256 個token,使用前情和所有先前生成的故事文字作為prompt,如果超過768 個token,則左截斷prompt。因此,「捲動視窗」最大上下文長度是 1024,與 RE^3 中使用的最大上下文長度相同。在產生了 3072 個 token 後,研究者使用了與 RE^3 相同的故事結束機制。

2. ROLLING-FT,與 ROLLING 相同,只是 GPT3-175B 首先會對 WritingPrompts 故事中的幾百個段落進行微調,這些段落至少有 3000 個 token。

指標

#研究者使用的幾個評估指標包括:

1、有趣。對讀者來說是有趣的。

2、連貫性。情節連貫。

3、相關性。忠於最初的前情。

4、類別人。被判斷為是人類寫的。

此外,研究者也追蹤了產生的故事有多少次出現以下幾方面的寫作問題:

1、敘事。敘述或風格上的令人震驚的變化。

2、不一致。與事實不符或包含非常奇怪的細節。

3、混亂。令人困惑或難以理解。

4、重複。高度的重複性。

5、不流暢。頻繁的語法錯誤。

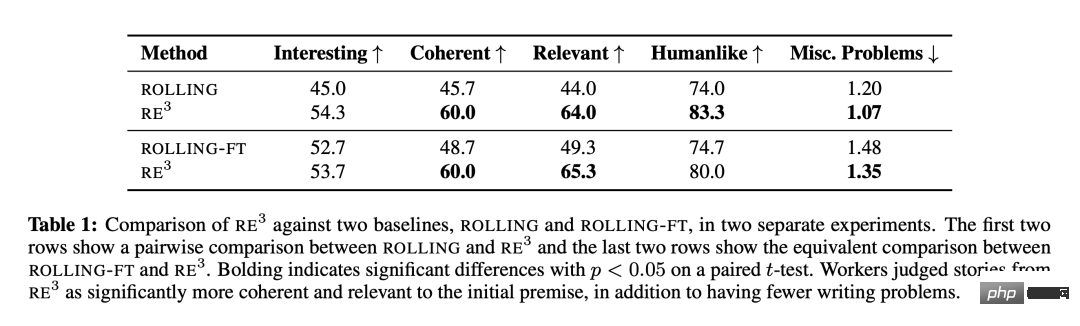

結果

如表1所示,Re^3 在根據預期前情寫一個較長的故事方面非常有效,同時能保持連貫的總體情節,驗證了研究者受人類寫作過程啟發而做出的設計選擇,以及遞歸reprompting 生成方法。與 ROLLING 和 ROLLING-FT 相比,Re^3 在連貫性和相關性方面都有明顯提高。註釋者也將 Re^3 的故事標記為「具有明顯較少的冗餘寫作問題」。

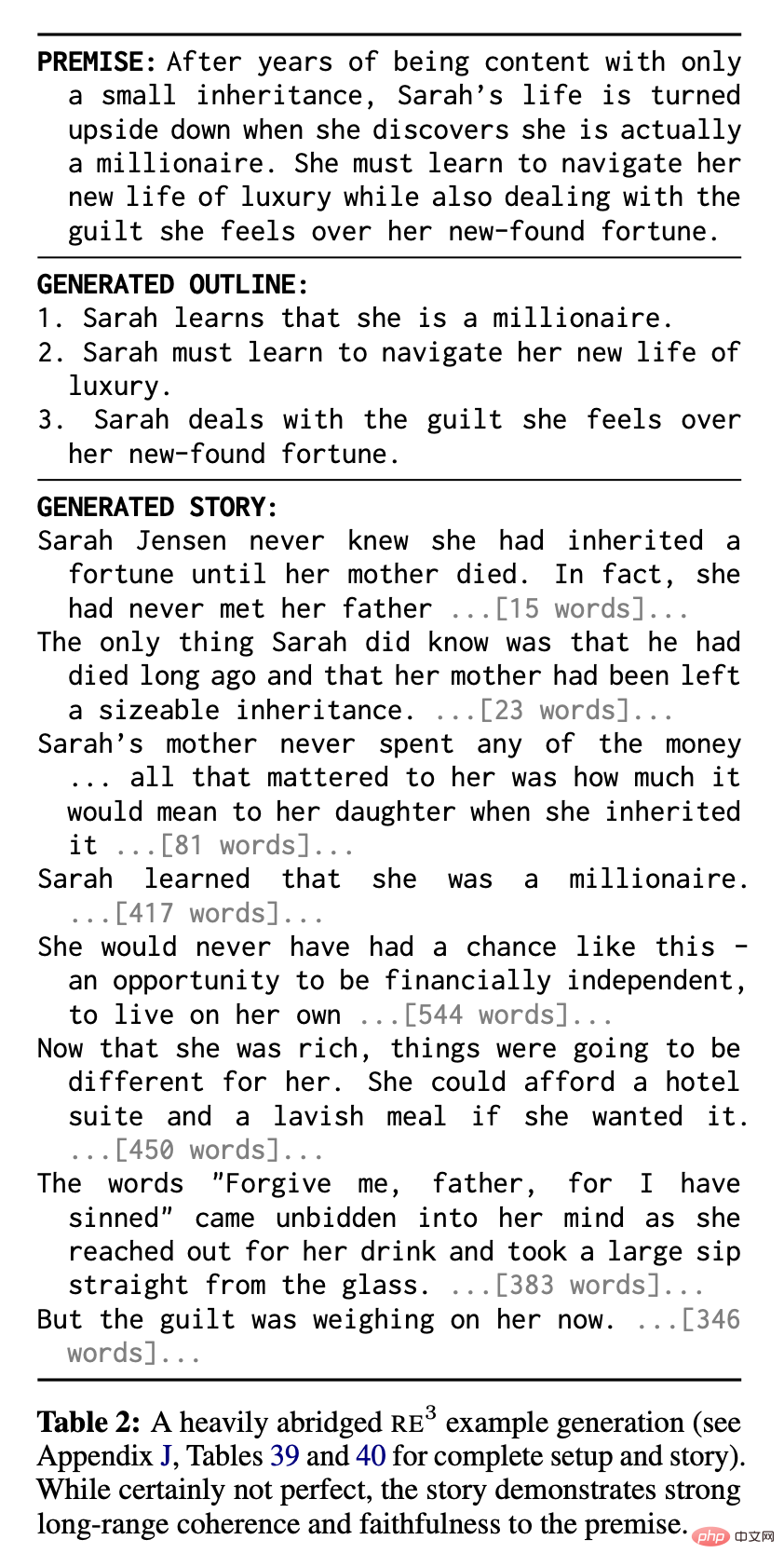

Re^3 展現了絕對意義上的強大表現:註釋者認為在兩次對比中,Re^3 的故事分別有 83.3% 和 80.0% 是由人類寫的。表2 顯示了Re^3 的一個經過大量刪節的故事實例,可以看出很強的連貫性和前情相關性:

儘管如此,研究者仍從品質上觀察到Re^3 仍有很大的改進空間。

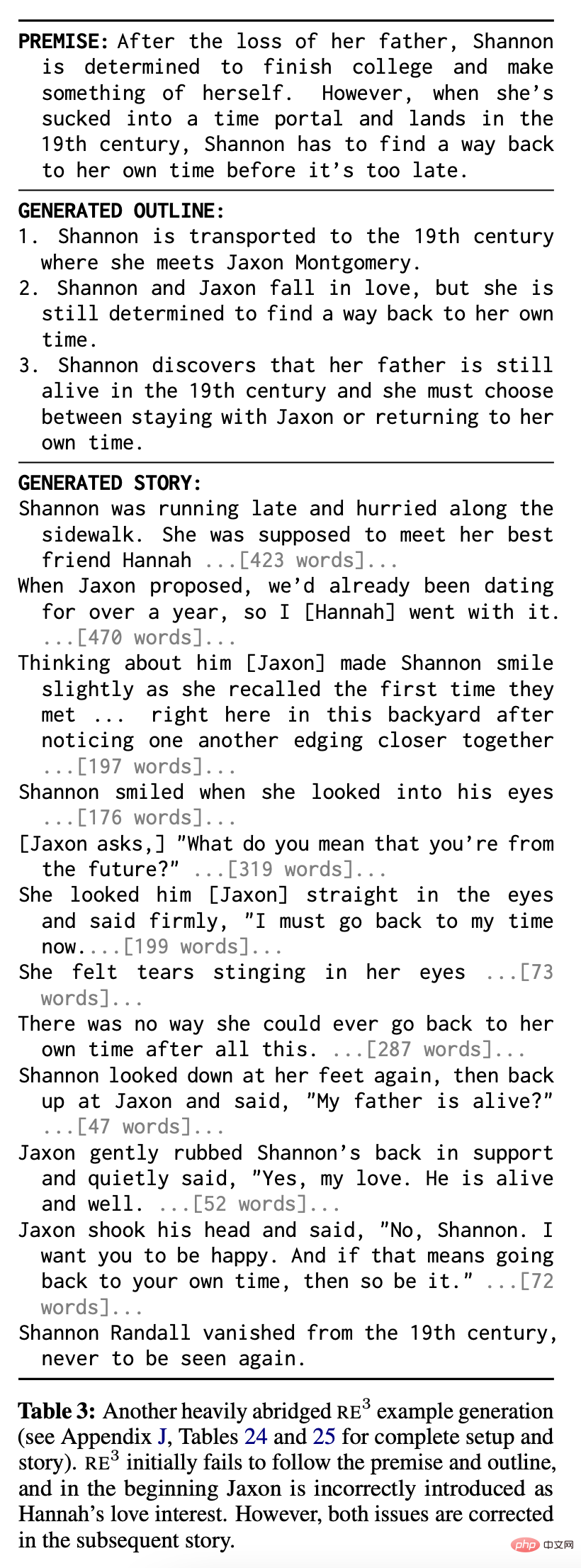

表 3 中顯示了兩個共同的問題。首先,儘管Re^3 幾乎總是在某種程度上遵循故事前情,但與基線故事不同,它們可能無法捕捉到前提的所有部分,也可能無法遵循規劃模組生成的部分大綱(例如,表3中前情和大綱的第一部分)。其次,由於改寫模組,特別是編輯模組的失敗,仍然有一些混亂的段落或矛盾的語句:例如,在表 3 中,人物 Jaxon 在某些地方有一個矛盾的身份。

不過,與捲動視窗方法(rolling window)不同,Re^3 的規劃方法能夠「自我修正」 ,回到最初的情節。表 3 中故事的後半部說明了這種能力。

消融實驗

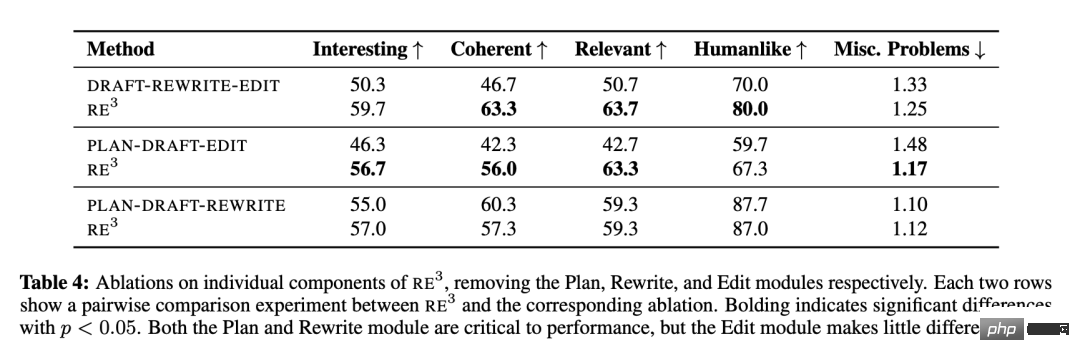

研究者探討了Re^3 的各個模組的相對貢獻:規劃、草稿、改寫和編輯,並依序對每個模組進行消融實驗。 Draft 模組除外,因為尚不清楚沒有它的話系統會如何運作。

表4 顯示,模仿人類規劃和改寫過程的「規劃」和「改寫」模組對整體情節的連貫性和前提的相關性至關重要。然而,「編輯」模組對這些指標的貢獻很小。研究者也從品質上觀察到,在 Re^3 的最終故事中仍然存在許多連貫性問題,這些問題沒有被編輯模組所解決,但這些問題可以由一個細心的人類編輯來解決。

「編輯」模組的進一步分析

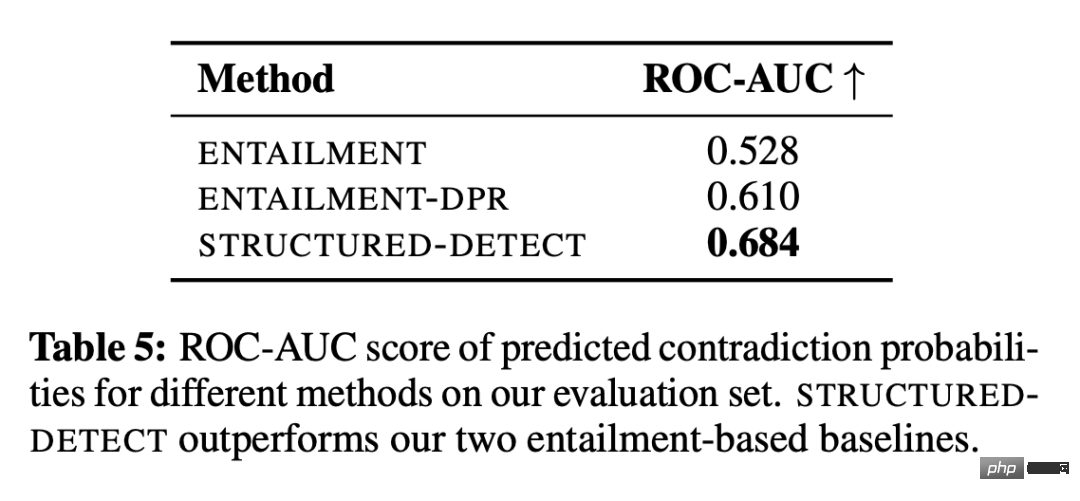

#研究者使用了一個可控的環境,以研究「編輯」模組是否至少能偵測到基於角色的事實不一致。偵測子系統稱為 STRUCTURED-DETECT,避免與整個編輯模組混為一談。

如表 5 所示,當偵測基於角色的不一致時,根據標準的 ROC-AUC 分類指標,STRUCTUREDDETECT 優於兩個基準。 ENTAILMENT 系統的 ROC-AUC 分數勉強優於偶然表現(0.5),突顯了核心挑戰,即偵測系統必須是壓倒性的精確。此外,STRUCTURED-DETECT 的設計是為了擴展到較長的段落。研究者假設,與基線相比,表現差距會在有較長輸入的評估中擴大。

即使在這種簡化的環境中,所有系統的絕對效能仍然很低。此外,許多生成的完整故事包含非角色的不一致,例如背景與當前場景的不一致。雖然研究者沒有正式分析 GPT-3 編輯 API 在偵測到不一致之處後的修正能力,但也觀察到它可以修正孤立的細節,而在處理較大的變化時會很吃力。

綜上所述,來自偵測和修正子系統的複合錯誤使得本研究目前的編輯模組很難在數千字的範圍內有效地改善事實的一致性,而不同時引入不必要的變化。

以上是符合人類創作過程的AIGC:自動產生長故事的模型出現了的詳細內容。更多資訊請關注PHP中文網其他相關文章!