我們都知道,人類的大腦90%都是自監督學習的,生物會不斷對下一步發生的事情做出預測。 自監督學習,就是不需要外部幹預也能做出決策。 只有少數情況我們會接受外在回饋,例如老師說:「你搞錯了」。 而現在有學者發現,大型語言模式的自我監督學習機制,像極了我們的大腦。 知名科普媒體Quanta Magazine近日報道,越來越多的研究發現,自我監督學習模型,尤其是大型語言模型的自學方式,與我們的大腦的學習模式非常類似。

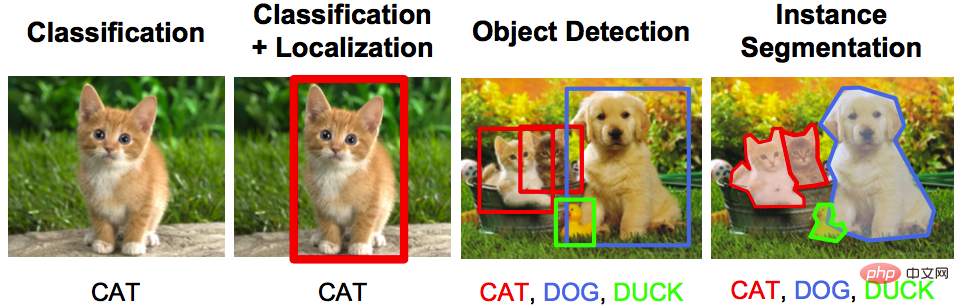

#過去常見的AI系統都是使用大量標記數據進行訓練的。 例如,圖像可能被標記為“虎斑貓”或“虎貓”,用以訓練人工神經網路來正確區分虎斑和虎。

#這種「自我監督」訓練需要人工費力地標記數據,而神經網路通常會走捷徑,學習將標籤與最少、有時甚至是膚淺的資訊聯繫起來。 例如,神經網路可能會使用草的存在來識別乳牛的照片,因為乳牛通常是在田野中拍攝的。加州大學柏克萊分校的電腦科學家阿列克謝·埃弗羅斯(Alexei Efros) 說:

我們正在培養的演算法,就像是一整個學期都沒來上課的本科生,雖然他們並沒有系統學習這些材料,但他們在考試中表現出色。

此外,對於對動物智慧和機器智慧的交叉感興趣的研究人員來說,這種「監督學習」可能僅限於它對生物大腦的揭示。 許多動物,包括人類不使用標記資料集來學習。在大多數情況下,他們自己探索環境,並且透過這樣做,他們對世界獲得了豐富而深刻的理解。

現在,一些運算神經科學家已經開始探索使用很少或沒有人工標記資料進行訓練的神經網路。最近的研究結果表明,使用自我監督學習模型建立的動物視覺和聽覺系統的計算模型比監督學習模型更接近大腦功能。

對一些神經科學家來說,人工神經網路似乎開始揭示用大腦來類比機器學習的途徑。

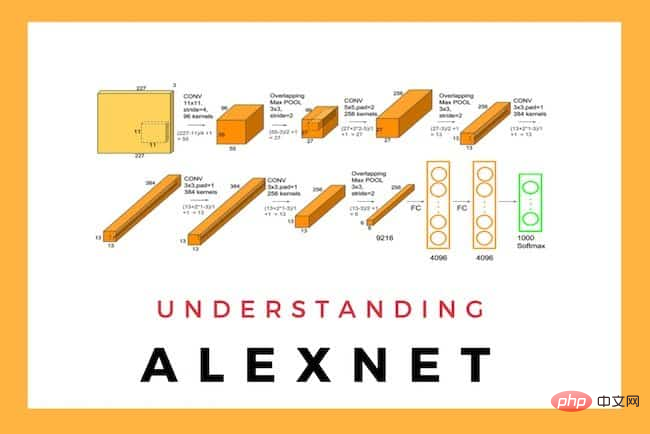

大約10年前,受人工神經網路啟發的大腦模型開始出現,同時一個名為AlexNet的神經網路徹底改變了對未知影像進行分類的任務。

#

#

論文網址:https://dl.acm.org/doi/10.1145/3065386 與所有神經網路一樣,此網路由多層人工神經元組成,其中不同神經元之間連接的權重不同。

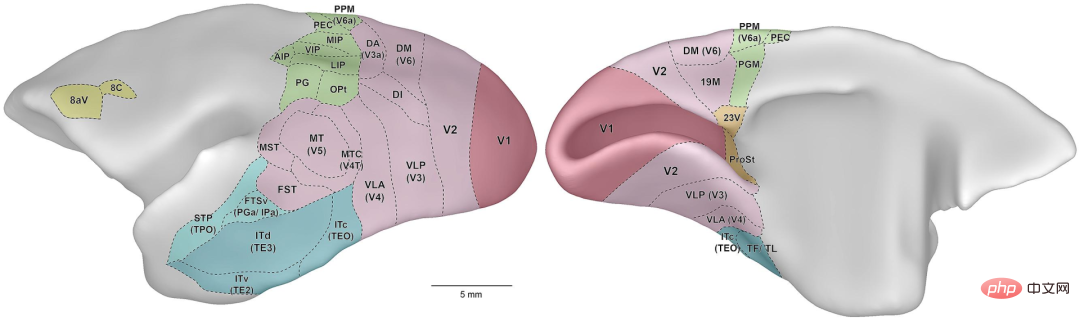

如果神經網路未能正確分類影像,學習演算法會更新神經元之間連接的權重,以降低在下一輪訓練中錯誤分類的可能性。 該演算法重複此過程多次,調整權重,直到網路的錯誤率低到可以接受的程度。 之後,神經科學家使用AlexNet開發了第一個靈長類視覺系統(Primate Visual System)的計算模型。

#當猴子和人工神經網路顯示相同的圖像時,真實神經元和人工神經元的活動顯示出類似的反應。 在聽覺和氣味檢測的人工模型上也取得了類似的結果。 但隨著該領域的發展,研究人員意識到自我監督訓練的限制。 2017年,德國蒂賓根大學的電腦科學家Leon Gatys和他的同事拍攝了一張福特T型車的照片,然後在照片上覆蓋了豹皮圖案。

#而人工智慧神經網路將原始影像正確分類為Model T,但將修改後的影像視為豹子。 原因是它只專注於圖像紋理,不了解汽車(或豹子)的形狀。 自監督學習模式旨在避免此類問題。瑞士巴塞爾弗里德里希·米歇爾生物醫學研究所的計算神經科學家弗里德曼·岑克(Friedemann Zenke) 說,

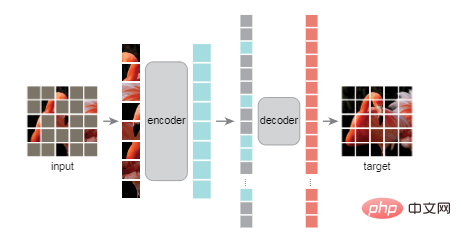

在這種方法中,人類不會標記數據,相反,標籤來自數據本身。自監督演算法本質上是在數據中創建空白,並要求神經網路填補空白。

例如,在所謂的大型語言模型中,訓練演算法將向神經網路顯示句子的前幾個單詞,並要求它預測下一個單字。 當使用大量從網路收集的文字進行訓練時,該模型似乎可以學習語言的句法結構,展示出令人印象深刻的語言能力——所有這些都沒有外部標籤或監督。 計算機視覺方面也正在進行類似的努力。 2021年底,何愷明及其同事展示了著名的遮罩自動編碼器研究「Masked Auto-Encoder」(MAE)。

#論文網址:https://arxiv.org/ abs/2111.06377 MAE將未遮罩部分轉換為潛在表示-壓縮的數學描述,其中包含有關物件的重要資訊。 在影像的情況下,潛在表示可能是一種數學描述,其中包括影像中物件的形狀。然後解碼器將這些表示轉換回完整的圖像。

在這樣的系統中,一些神經科學家認為,我們的大腦其實也是自監督學習的。麥基爾大學和魁北克人工智慧研究所(Mila)的計算神經科學家布萊克-理查茲(Blake Richards)說:「我認為毫無疑問,大腦所做的90%都是自監督學習。」 生物大腦被認為是在不斷地預測,例如,一個物體在移動時的未來位置,或一句話中的下一個詞,就像自我監督學習演算法試圖預測圖像或一段文字的間隙一樣。

#

#計算神經科學家布萊克-理查茲(Blake Richards)創建了一個AI系統,模仿活體大腦中的視覺網絡 理查茲和他的團隊創建了一個自我監督模型,暗示了一個答案。他們訓練了一個結合兩種不同神經網路的人工智慧。

第一個,稱為ResNet架構,是為處理圖像而設計的;第二個,稱為遞歸網絡,可以追蹤先前的輸入序列,對下一個預期輸入進行預測。 為了訓練聯合AI,團隊從一連串的影片開始,比如說10幀,讓ResNet逐一處理。

然後,遞迴網路預測了第11幀的潛在表示,而不是簡單地匹配前10幀。自監督學習演算法將預測值與實際值進行比較,並指示神經網路更新其權重,以使預測效果更好。

為了進一步測試,研究人員向AI展示了一組視頻,西雅圖艾倫腦科學研究所的研究人員以前曾向小鼠展示過這些影片.與靈長類動物一樣,小鼠的大腦區域專門用於靜態圖像和運動。艾倫研究人員在小鼠觀看影片時記錄了小鼠視覺皮質的神經活動。

理查茲的團隊發現了AI和活體大腦對影片的反應方式的相似之處。在訓練過程中,人工神經網路中的一條途徑變得與小鼠大腦的腹側、物體偵測區域更加相似,而另一條途徑則變得與注重運動的背側區域相似。

這些結果表明,我們的視覺系統有兩個專門的通路,因為它們有助於預測視覺的未來;單一的通路是不夠好的。 人類聽覺系統的模型講述了一個類似的故事。 6月,由Meta AI的研究科學家Jean-Rémi King領導的團隊訓練了一個名為Wav2Vec 2.0的人工智慧,它使用一個神經網路將音訊轉化為潛在的表徵。研究人員對這些表徵中的一些進行了屏蔽,然後將其送入另一個稱為轉換器的組件神經網路。

在訓練過程中,轉換器預測被屏蔽的資訊。在這個過程中,整個人工智慧學會了將聲音轉化為潛在的表徵,同樣,不需要標籤。 該團隊使用了約600小時的語音資料來訓練網路。 「這大約是一個孩子在前兩年的經驗中得到的東西。」金說。

# Meta AI的讓-雷米-黃金幫助訓練了一種人工智慧,它以模仿大腦的方式處理音訊--部分是透過預測下一步應該發生什麼 一旦系統被訓練出來,研究人員給它播放英語、法語和普通話的有聲讀物部分,然後將AI的表現與412人的數據進行了比較(這些人都是以這三種語言為母語的人),他們在核磁共振掃描對自己的大腦進行成像時,聽了同樣長的一段音頻。

結果顯示,儘管fMRI影像有雜訊且解析度不高,但AI神經網路和人類的大腦「不僅相互關聯,而且還以系統化的方式關聯」。 AI早期層的活動與初級聽覺皮質的活動一致,而AI最深層的活動則與大腦中較高層的活動相一致,例如前額葉皮質。 「

這是非常漂亮的數據,雖然不算是決定性的,但算得上是令人信服的證據,表明我們學習語言的方式很大程度上是在預測接下來會說的話。」

當然,也並非所有人都認同這種說法。

MIT的計算神經科學家喬希-麥克德莫特(Josh McDermott)曾使用監督和自監督學習研究視覺和聽覺的模型。他的實驗室設計了一些人工合成的音訊和視覺訊號,對於人類來說,這些訊號只是難以捉摸的噪音。

然而,對於人工神經網路來說,這些訊號似乎與真實語言和圖像沒有區別。這表明,在神經網路的深層形成的表徵,即使是自監督學習,也與我們大腦中的表徵不一樣。麥克德莫特說:「這些自我監督的學習方法是一種進步,因為你能夠學習能夠支持很多識別行為的表徵,而不需要所有標籤。但仍然有很多監督模型的特徵。」

#################################################################### ##############演算法本身也需要更多改進。例如在Meta AI的Wav2Vec 2.0模型中,AI只預測了幾十毫秒的聲音的潛在表徵,比人發出一個噪音音節的時間還要短,更不用說預測一個字了。 ##################要真正實現讓AI模型和人類大腦相類似,我們還有很多事情要做,金說。 如果目前發現的大腦和自我監督學習模型之間的相似性在其他感官任務中也成立,將更有力地表明,無論我們的大腦有什麼神奇的能力,都需要以某種形式進行自我監督學習。 ##########

以上是人腦90%都是自監督學習,AI大模型離模擬大腦還有多遠?的詳細內容。更多資訊請關注PHP中文網其他相關文章!