隨著語言模型和語料庫規模的逐漸擴大,大型語言模型(LLM)展現出更多的潛力。近來一些研究表明,LLM 可以使用 in-context learning(ICL)執行一系列複雜任務,例如解決數學推理問題。

來自北京大學、上海AI Lab 和加州大學聖塔芭芭拉分校的十位研究者近期發布了一篇關於in-context learning 的綜述論文,詳細梳理了ICL 研究的當前進展。

論文網址:https://arxiv.org/pdf/2301.00234v1.pdf

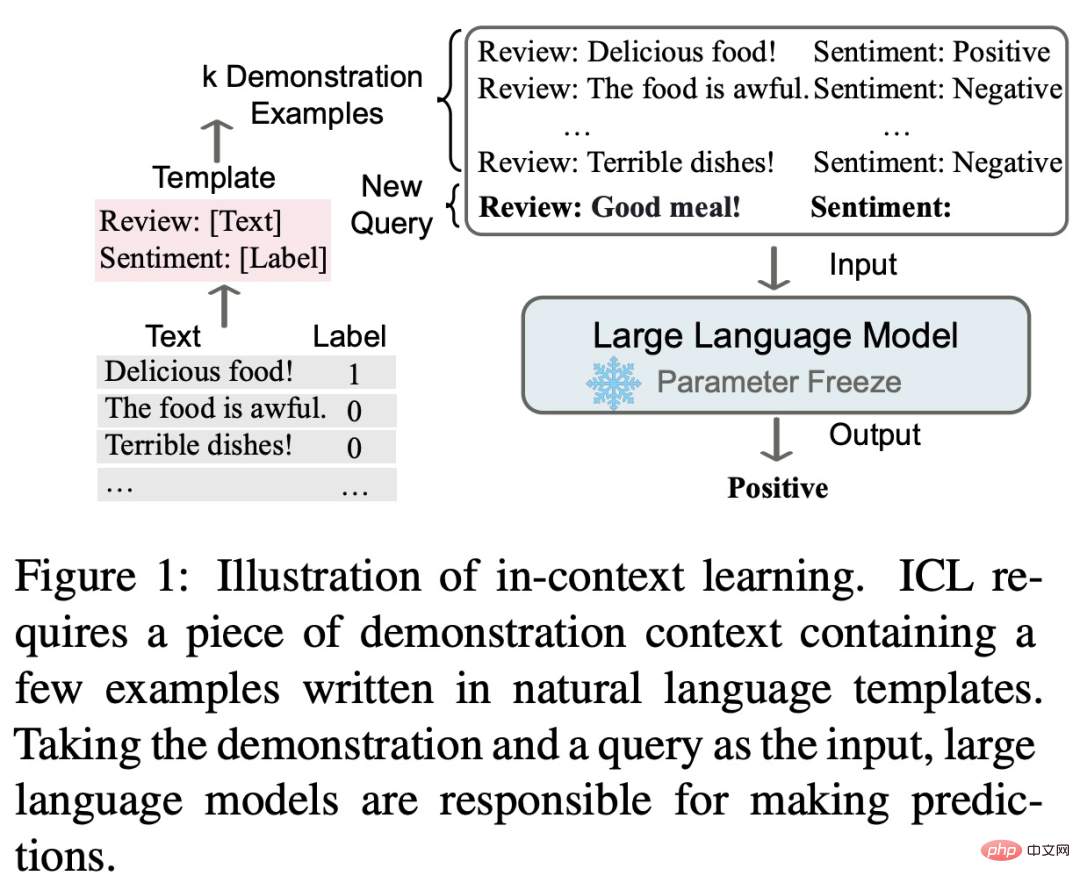

#in-context learning 的核心思路是類比學習,下圖描述了語言模型如何使用ICL 進行決策。

首先,ICL 需要一些範例來形成示範語境,這些範例通常用自然語言範本編寫。然後,ICL 將查詢問題和演示語境相聯繫,形成 prompt,並將其輸入語言模型進行預測。與監督學習需要使用反向梯度更新模型參數的訓練階段不同,ICL 不需要參數更新即可使預訓練語言模型直接執行預測任務,並且模型有望學習演示樣例中隱藏的模式,並據此做出正確的預測。

作為新的範式,ICL 有許多吸引人的優勢。首先,示範範例用自然語言格式編寫,這為與大語言模型關聯提供了一個可解釋的介面。透過改變示範範例和模板(Liu et al., 2022; Lu et al., 2022; Wu et al., 2022; Wei et al., 2022c),這種範式使將人類知識納入語言模型變得更加容易。第二,in-context learning 類似於人類透過類比學習的決策過程。第三,與監督式訓練相比,ICL 是一個無需訓練的學習架構。這不僅可以大大降低模型適應新任務的計算成本,還可以使語言模型即服務(LMaaS,Sun et al., 2022)成為可能,並輕鬆應用於大規模的現實任務。

儘管 ICL 有著大好的前景,但仍有許多值得探究的問題,包括它的效能。例如原始的 GPT-3 模型就具備一定的 ICL 能力,但一些研究發現,透過預訓練期間的適應,這種能力還可以獲得顯著的提升。此外,ICL 的表現對特定的設定很敏銳,包括 prompt 模板、語境樣例的選擇和樣例順序等。此外,ICL 的工作機制雖然看似合理,但仍不夠清晰明了,能夠初步解釋其工作機制的研究也不多。

本篇綜述論文總結道,ICL 的強大表現依賴於兩個階段:

在訓練階段,語言模型直接按照語言建模目標進行訓練,例如從左到右的生成。儘管這些模型並沒有專門針對 in-context learning 進行最佳化,但 ICL 的能力依舊令人驚訝。現有的 ICL 研究基本上以訓練良好的語言模型為主幹。

在推理階段,由於輸入和輸出的 label 都是用可解釋的自然語言模板表徵的,因此 ICL 性能可以從多個角度優化。這篇綜述論文進行了詳細的描述和比較,並選擇合適的例子進行演示,針對不同的任務設計具體的評分方法。

這篇綜述論文的大致內容與架構如下圖所示,包括:ICL 的正式定義(§3)、warmup 方法(§4)、prompt 設計策略(§5 ) 和評分函數(§6)。

此外,§7 深入闡述了目前為揭開 ICL 背後運作所做的探索。 §8 進一步為 ICL 提供了有用的評估與資源,§9 介紹了能顯示 ICL 有效性的潛在應用情境。最後,§10 總結了 ICL 領域存在的挑戰和潛在的方向,為該領域的進一步發展提供參考。

有興趣的讀者可以閱讀論文原文,了解更多研究細節。

以上是被GPT帶飛的In-Context Learning發展現況如何?這篇綜述梳理明白了的詳細內容。更多資訊請關注PHP中文網其他相關文章!