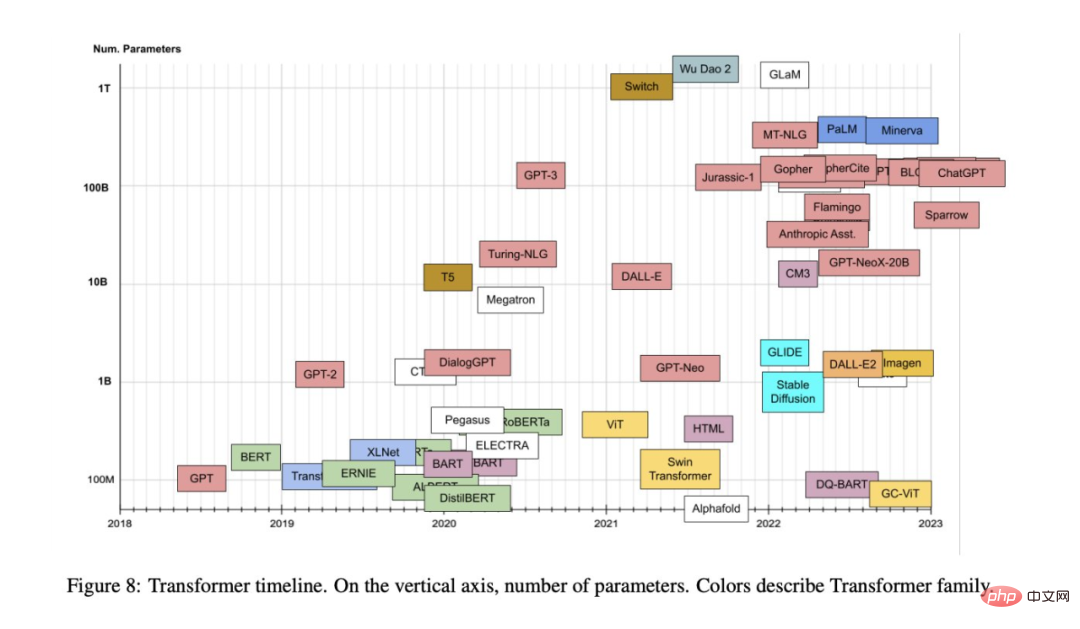

自2017 年提出至今,Transformer 模型已經在自然語言處理、電腦視覺等其他領域展現了前所未有的實力,並引發了ChatGPT 這樣的技術突破,人們也提出了各種基於原始模型的變體。

由於學界和業界不斷提出基於 Transformer 注意力機制的新模型,我們有時很難對這個方向進行歸納總結。近日,領英 AI 產品策略負責人 Xavier Amatriain 的一篇綜述性文章或許可以幫助我們解決這個問題。

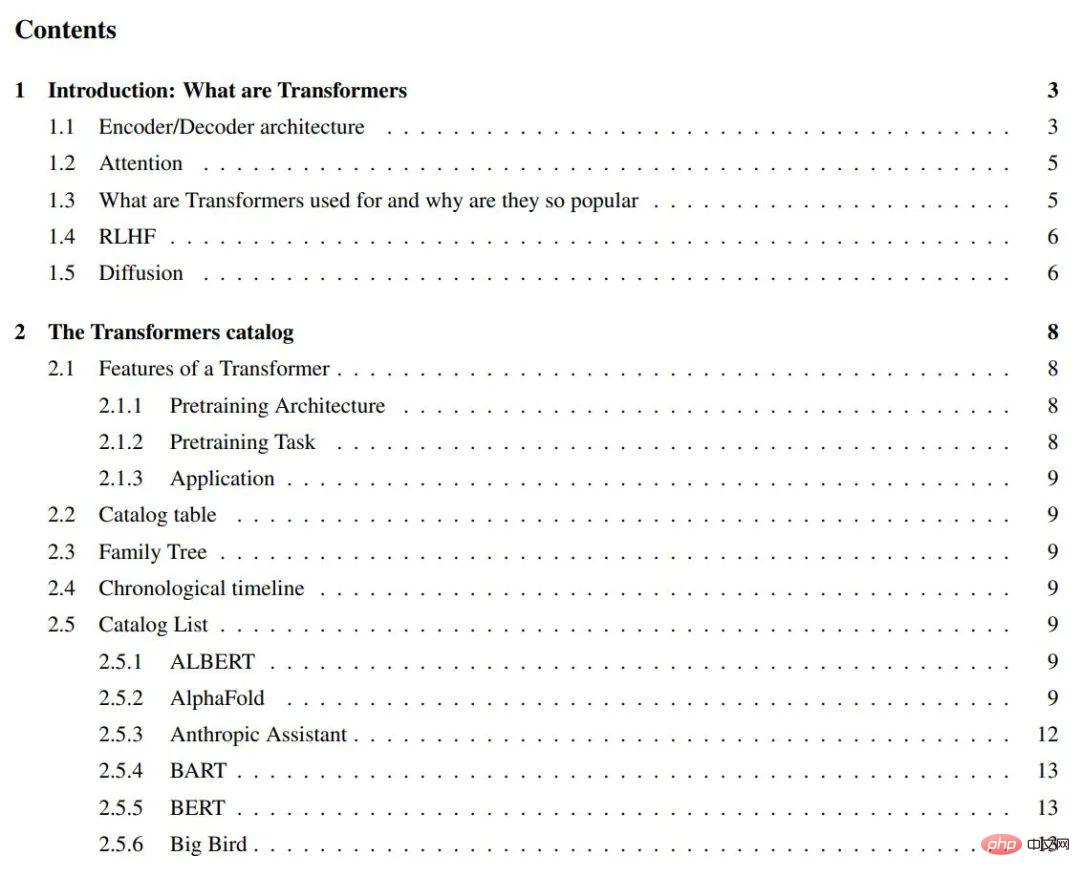

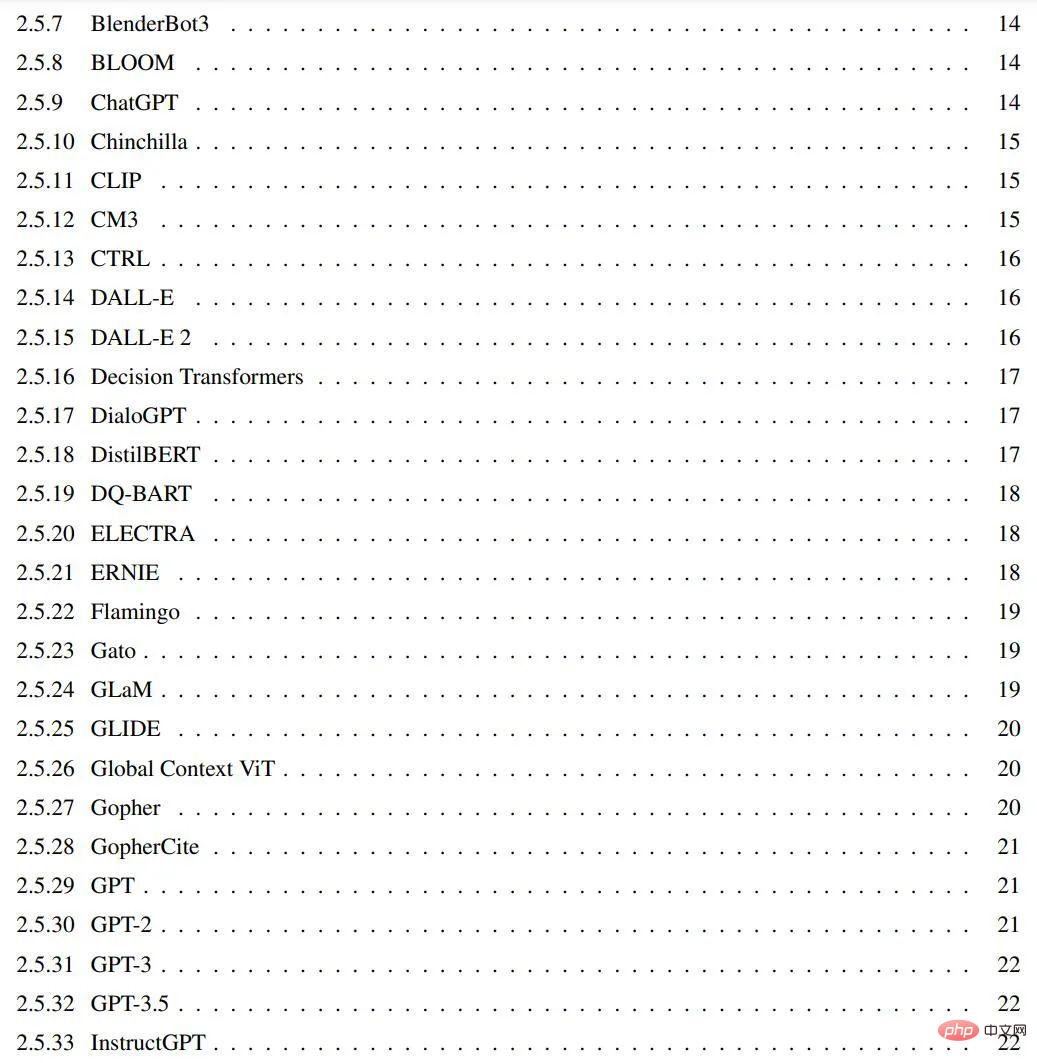

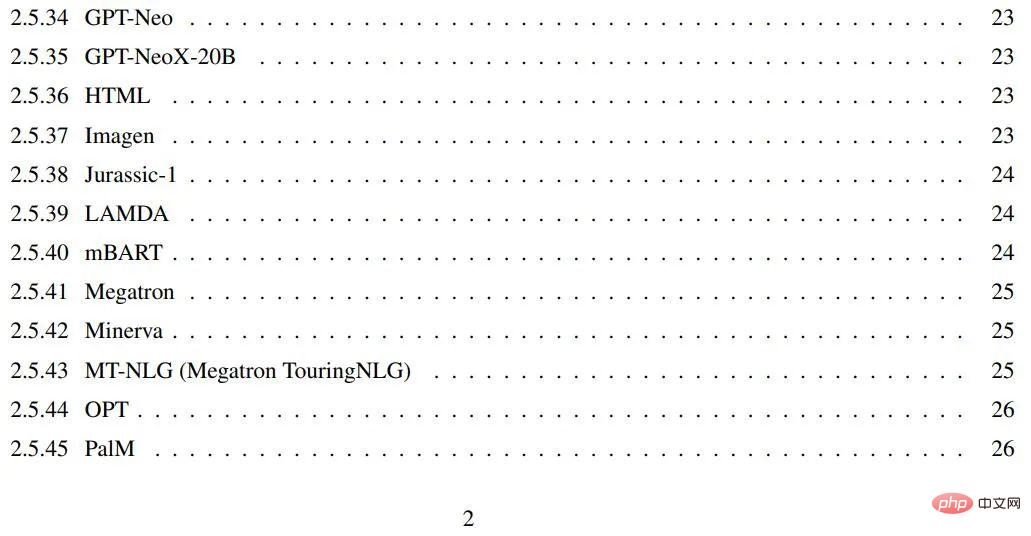

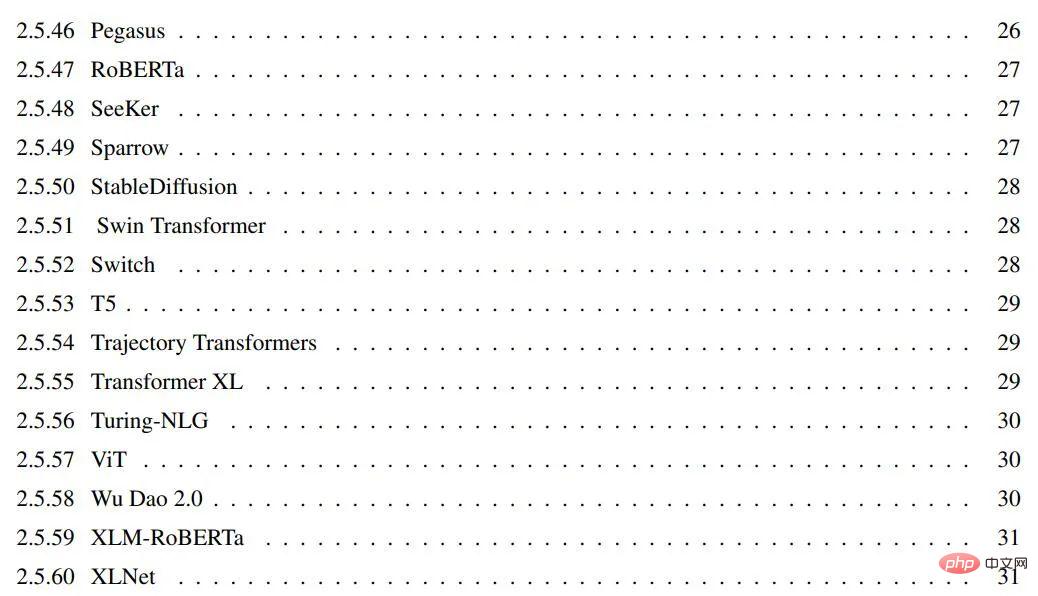

#在過去的幾年裡,陸續出現了數十個來自Transformer 家族模型,所有這些都有有趣且易於理解的名字。本文的目標是為最受歡迎的 Transformer 模型提供一個比較全面但簡單的目錄和分類,此外本文也介紹了 Transformer 模型中最重要的面向和創新。

論文《Transformer models: an introduction and catalog》:

論文連結:

https://arxiv.org/abs/2302.07730

GitHub:https://github.com/xamat/TransformerCatalog

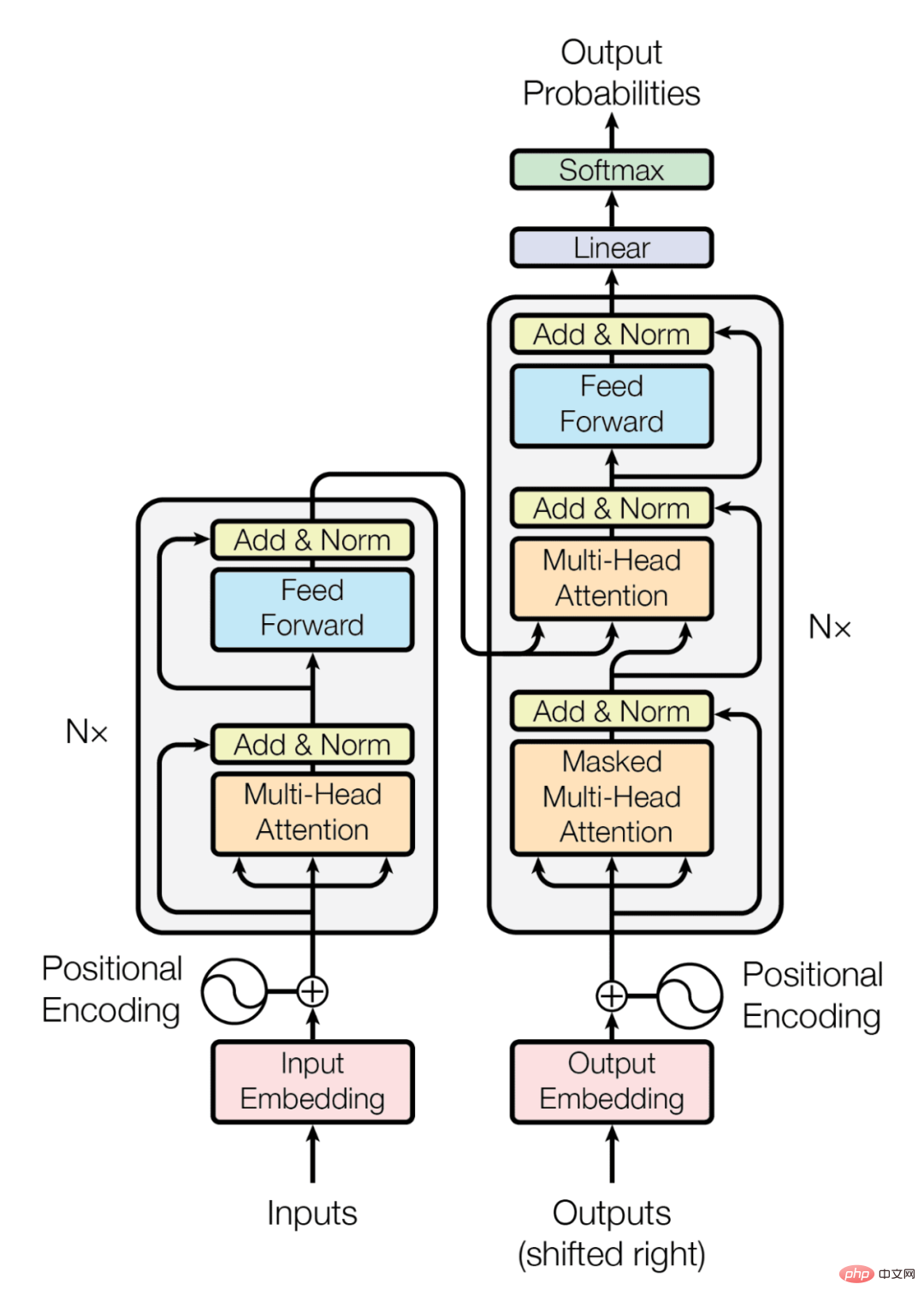

Transformer 是一類由一些架構特徵定義的深度學習模型。首次出現在Google研究人員於 2017 年發表的著名論文《Attention is All you Need》(這篇論文在短短 5 年就被引用了 3.8 萬餘次)以及相關的部落格文章中。 Transformer 架構是編碼器 - 解碼器模型 [2] 的一個特定實例,該模型在 2 - 3 年前開始流行起來。然而,在此之前,注意力只是這些模型使用的機制之一,這些模型主要基於 LSTM(長短期記憶)[3] 和其他 RNN(循環神經網路)[4] 變體。 Transformers 論文的關鍵見解是,正如標題所暗示的那樣,注意力可以被用作推導輸入和輸出之間依賴關係的唯一機制。討論 Transformer 體系結構的所有細節超出了本部落格的範圍。為此,本文建議參考上面的原論文或 Transformers 的帖子,內容都十分精彩。話雖如此,本文將簡要敘述最重要的方面,下面的目錄中也會提到它們。本文將先從原始論文中的基本架構圖開始,進而展開敘述相關內容。

編碼器/ 解碼器架構

#通用編碼器/ 解碼器體系架構(參見圖1) 由兩個模型組成。編碼器接受輸入並將其編碼為固定長度的向量。解碼器取得該向量並將其解碼為輸出序列。編碼器和解碼器聯合訓練以最小化條件對數似然。一旦訓練,編碼器 / 解碼器可以產生給定輸入序列的輸出,或者可以對輸入 / 輸出序列進行評分。在最初的 Transformer 架構中,編碼器和解碼器都有 6 個相同的層。在這 6 層中的每一層編碼器都有兩個子層:一個多頭注意層和一個簡單的前饋網路。每個子層都有一個殘差連接和一個層歸一化。編碼器的輸出大小是 512。解碼器增加了第三個子層,這是編碼器輸出上的另一個多頭注意層。此外,解碼器中的另一個多頭層被遮罩。

#圖1:Transformer 系統架構

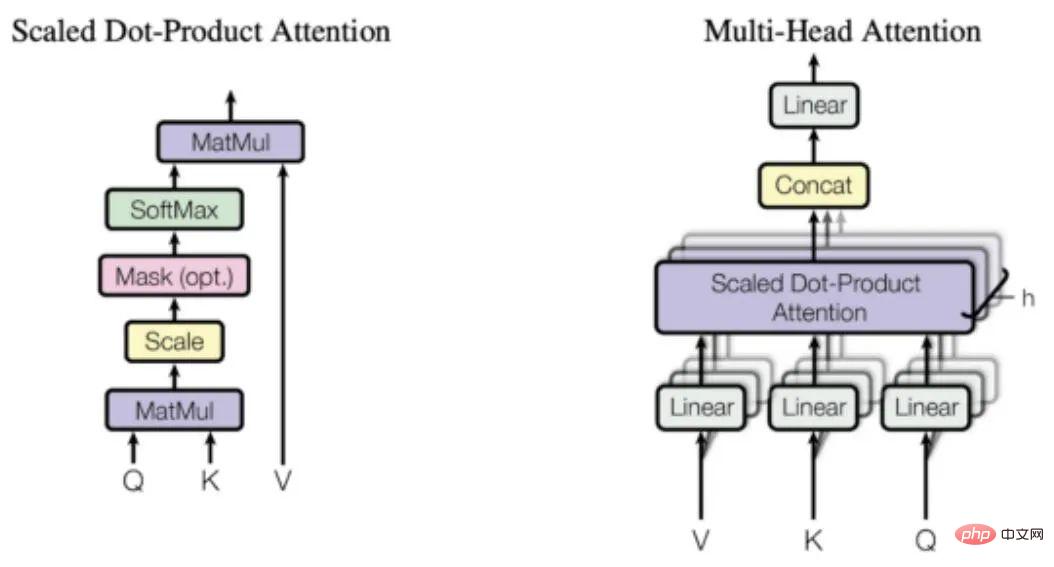

圖2:注意力機制

「注意

#從上面的描述可以清楚地看出,模型體系架構唯一的特別元素是多頭注意力,但是,正如上面所描述的,這正是模型的全部力量所在。那麼,注意力到底是什麼呢?注意力函數是查詢和一組鍵值對到輸出之間的映射。輸出是按值的加權和計算的,其中分配給每個值的權重是透過查詢與對應鍵的相容性函數計算的。 Transformers 使用多頭注意力,這是一個被稱為縮放點積注意力的特定注意力函數的平行計算。關於注意力機制如何運作的更多細節,本文將再次參考《The Illustrated Transformer》的帖文,將在圖 2 中再現原始論文中的圖表,以便了解主要思想。與循環網絡和卷積網絡相比,注意力層有幾個優勢,最重要的兩個是它們較低的計算複雜性和較高的連通性,特別是對於學習序列中的長期依賴關係非常有用。

Transformer 的用途是什麼,為什麼它們如此受歡迎

最初的Transformer 是為語言翻譯而設計的,特別是從英語到德語。但是,透過原先的研究論文就可以看出,該架構可以很好地推廣到其他語言任務。這一特別的趨勢很快就引起了研究界的注意。在接下來的幾個月裡,大多數與語言相關的ML 任務排行榜完全被某個版本的Transformer 架構所主導(比方說,著名的SQUAD 排行榜,其中所有位於頂部的模型都是Transformer 的集合)。 Transformer 能夠如此迅速地佔據大多數 NLP 排行榜的關鍵原因之一是它們能夠快速適應其他任務,也就是遷移學習。預先訓練的 Transformer 模型可以非常容易且快速地適應它們沒有經過訓練的任務,這具有巨大的優勢。身為 ML 從業者,你不再需要在龐大的資料集上訓練大型模型。你所需要做的就是在你的任務中重新使用預先訓練的模型,也許只是用一個小得多的資料集稍微調整它。一種用於使預訓練的模型適應不同任務的特定技術稱為微調。

事實證明,Transformer 適應其他任務的能力是如此之強,以至於儘管它們最初是為與語言相關的任務而開發的,但它們很快就被用於其他任務,從視覺或音頻和音樂應用程序,一直到下棋或做數學。

當然,如果不是因為有無數的工具,任何人都可以輕鬆地編寫幾行程式碼,那麼所有這些應用程式都不可能實現。 Transformer 不僅能迅速整合到主要的人工智慧框架(即 Pytorch8 和 TF9)中,甚至基於此創建起整個公司。 Huggingface 是一家迄今為止已經籌集了 6000 多萬美元的新創公司,幾乎完全是圍繞著將開源 Transformer 庫商業化的想法建立的。

最後,有必要談談 Transformer 普及初期 GPT-3 對其的影響。 GPT-3 是 OpenAI 在 2020 年 5 月推出的 Transformer 模型,是他們早期 GPT 和 GPT-2 的後續產品。該公司通過在預印本中介紹該模型而引起了很大的轟動,他們聲稱該模型非常強大,以至於他們無法向世界發布它。從那以後,該模式不僅發布了,而且還透過 OpenAI 和微軟之間的大規模合作實現了商業化。 GPT-3 支援 300 多個不同的應用程序,是 OpenAI 商業策略的基礎 (對於一家已經獲得超過 10 億美元融資的公司來說,這是很有意義的)。

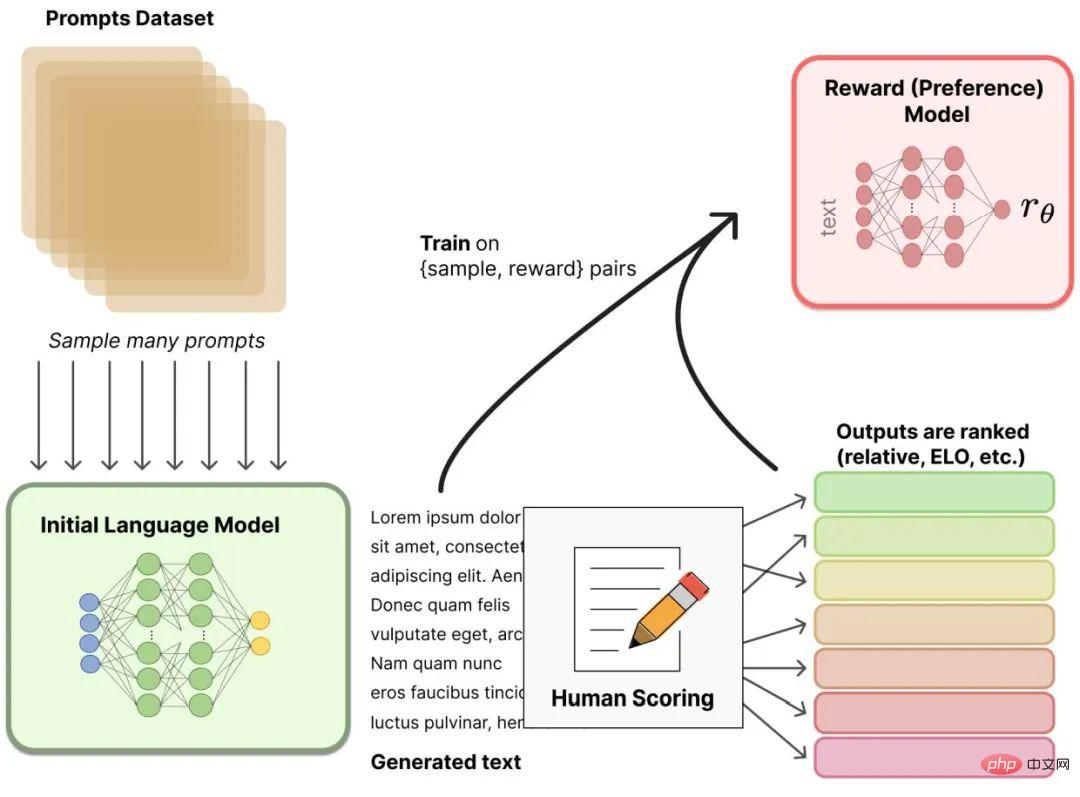

RLHF

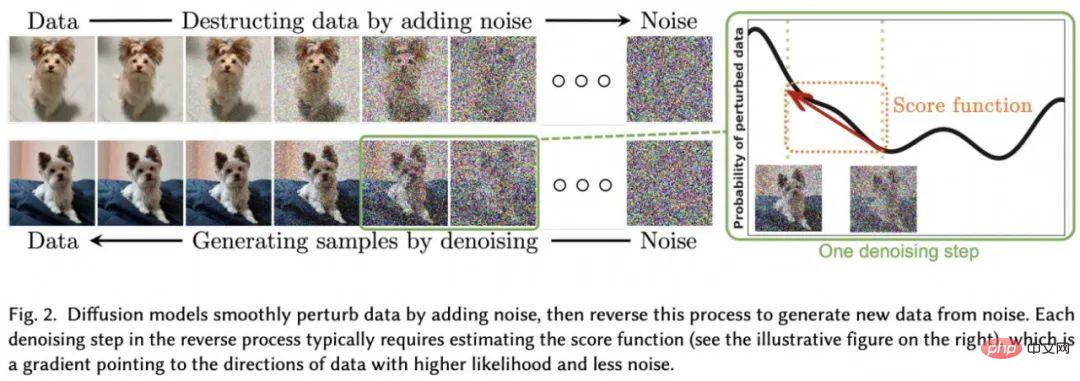

#最近,從人類回饋(或偏好)強化學習(RLHF(也稱為RLHP )已成為人工智慧工具包的一個巨大補充。這個概念已經在2017 年的論文《Deep reinforcement learning from human preferences》中提出。最近,它被應用於ChatGPT 和類似的對話智能體,如BlenderBot 或Sparrow。這個想法很簡單:一旦語言模型被預先訓練,使用者就可以對對話產生不同的反應,並讓人類對結果進行排序。人們可以在強化學習環境中使用這些排名(也就是偏好或回饋)來訓練獎勵(見圖3)。###############擴散##########擴散模型已經成為影像生成中的新 SOTA,顯然將先前的方法如 GANs(生成對抗網路)推到了一邊。什麼是擴散模型?它們是一類經過變分推理訓練的潛在變數模型。以這種方式訓練的網路實際上是在學習這些圖像所代表的潛在空間(參見圖 4)。

擴散模型與其他生成模型有關係,如著名的[生成對抗網路(GAN)] 16,它們在許多應用中已經被取代,特別是與(去雜訊)自動編碼器。有些作者甚至說擴散模型只是自編碼器的一個具體實例。然而,他們也承認,微小的差異確實改變了他們的應用,從 autoconder 的潛在表示到擴散模型的純粹生成性質。

#圖 3:具有人類回饋的強化學習。

#圖4:機率擴散模型架構摘自《Diffusion Models : A Comprehensive Survey of Methods and Applications》

#本文介紹的模型包括:

以上是五年時間被引用3.8萬次,Transformer宇宙發展成了這樣的詳細內容。更多資訊請關注PHP中文網其他相關文章!