每年,全世界有超過 6,900 萬人飽受創傷性腦損傷的折磨,他們中的許多人無法透過語音、打字或手勢進行交流。如果研究人員開發出一種技術,可以透過非侵入性的方式直接從大腦活動解碼語言,這些人的生活將會大大改善。 現在,Meta搞了一個新研究,就是要解決這個事兒。

剛剛,Meta AI官方部落格發文,介紹了可利用AI從大腦活動直接解碼語音的新技術。

#從一段時間為3秒的大腦活動中,這個AI可以從人們日常使用的793 個單字的詞彙表中解碼對應的語音片段,準確率高達73%。

以往,從大腦活動中解碼語音一直是神經科學家和臨床醫生的長期目標,但大部分進展依賴於侵入性大腦記錄技術,例如立體定向腦電圖和皮層電圖。

這些裝置可以提供比非侵入性方法更清晰的訊號,但需要神經外科介入。

雖然這項工作的結果表明從大腦活動記錄中解碼語音是可行的,但使用非侵入性方法解碼語音將提供一種更安全、更具可擴展性的解決方案,最終可以使更多人受益。

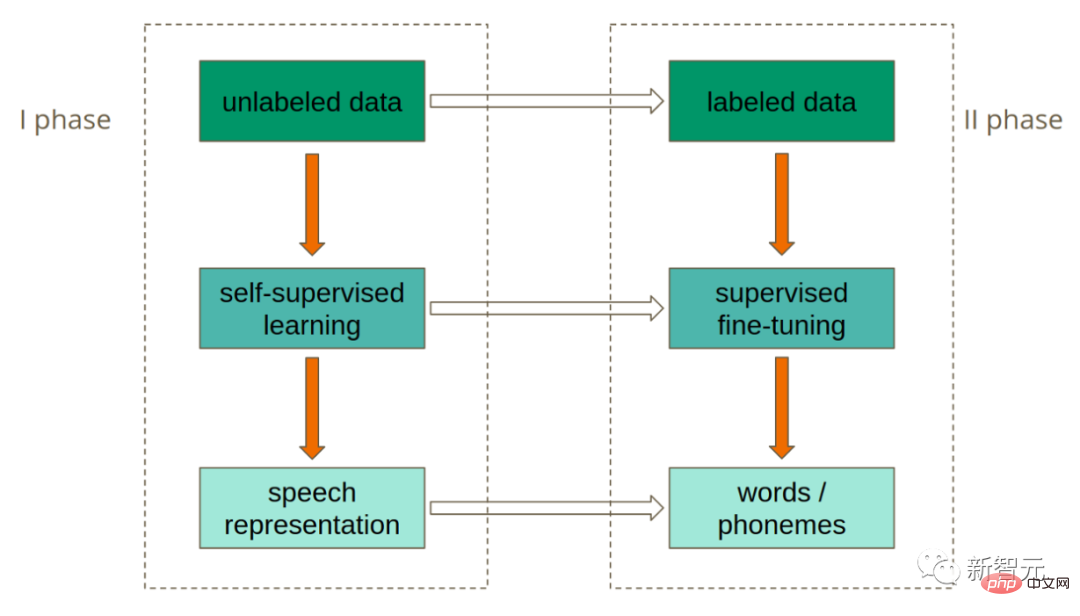

然而,這是非常具有挑戰性的,因為非侵入式錄音是出了名的嘈雜,並且由於各種原因,包括每個人的大腦和感測器放置位置的差異,錄音會話和個人之間可能會有很大差異。 Meta透過創建一個經過對比學習訓練的深度學習模型來應對這些挑戰,然後使用它來最大限度地對齊非侵入性大腦記錄和語音。

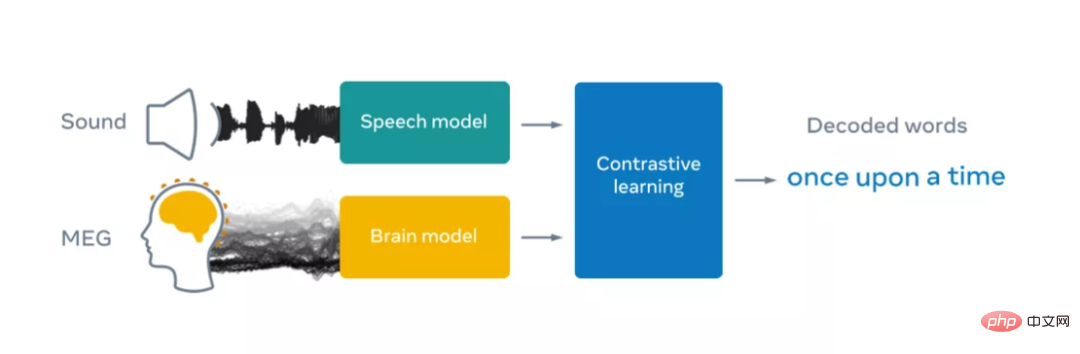

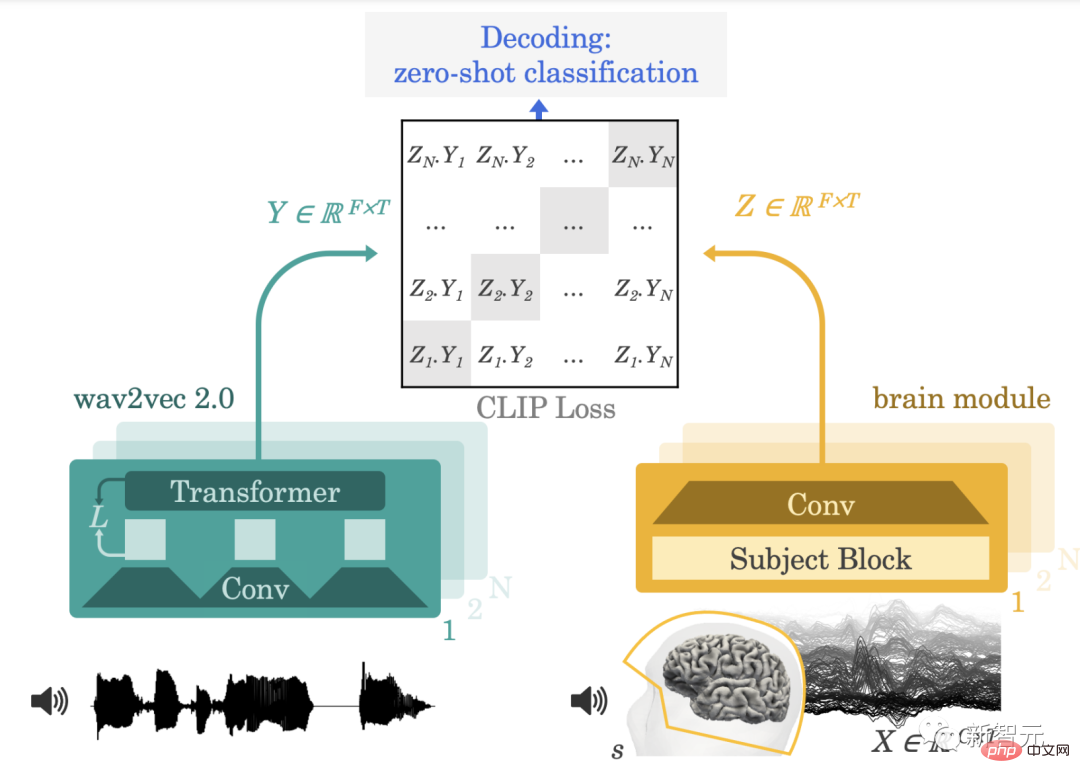

為此,Meta使用一個由FAIR 團隊於2020 年開發的、開源的自我監督學習模型wave2vec 2.0 ,來辨識聽有聲書的在志願者大腦中語音的複雜表示。 Meta主要關注兩種非侵入性技術:腦電圖和腦磁圖(簡稱 EEG 和 MEG),分別測量神經元活動所造成的電場和磁場的波動。

在實踐中,這兩個系統每秒可以使用數百個感測器拍攝約 1000 個宏觀大腦活動的快照。 Meta利用了來自學術機構的四個開源EEG 和MEG 數據集,利用了169 名健康志願者的150 多個小時的錄音,在這些錄音中,是他們正在聽有聲讀物和英語和荷蘭語的孤立句子。

然後,Meta將這些 EEG 和 MEG 記錄輸入到一個「大腦」模型中,該模型由一個帶有殘差連接的標準深度卷積網路組成。

眾所周知,EEG 和 MEG 記錄在個體之間存在很大差異,因為個別大腦解剖結構、大腦區域神經功能的位置和時間差異以及記錄期間感測器的位置。

在實務中,這意味著分析大腦資料通常需要一個複雜的工程管道,用於重新調整模板大腦上的大腦訊號。在先前的研究中,大腦解碼器接受了少量錄音的訓練,以預測一組有限的語音特徵,例如詞性類別或少量詞彙中的單字。

為了方便研究,Meta設計了一個新的主題嵌入層,它被訓練成端到端,將所有的大腦記錄排列在一個共同的空間。

為了從非侵入性大腦訊號中解碼語音,Meta訓練了一個具有對比學習的模型,以校準語音及其相應的大腦活動 最後,Meta的架構學會了將大腦模型的輸出,與呈現給參與者的語音的深度表徵相符。

在Meta之前的工作中,我們使用wav2vec 2.0,顯示這個語音演算法會自動學習產生與大腦一致的語音表示。

#wav2vec 2.0中出現的語音「類腦」表示,使Meta的研究人員自然而然地選擇構建自己的解碼器,因為它有助於讓Meta的研究人員了解,應該從大腦信號中提取哪些表示法。

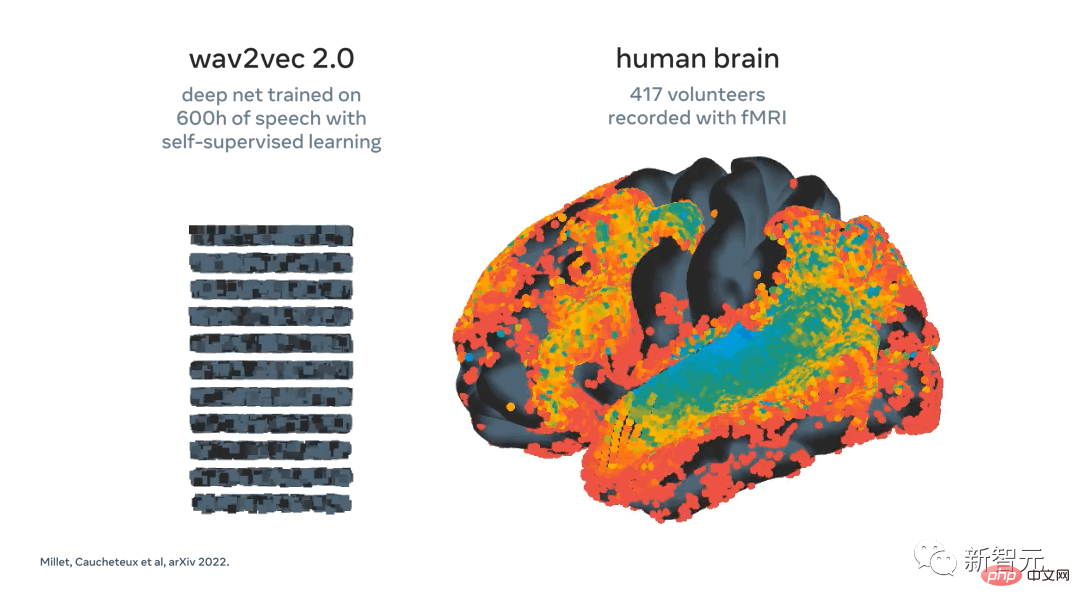

Meta最近展示了 wav2vec 2.0(左)的活化映射到大腦(右)以回應相同的語音。演算法的第一層(冷色)的表示映射到早期聽覺皮層,而最深層映射到高級大腦區域(例如前額葉和頂葉皮層)

訓練後,Meta的系統執行所謂的零樣本分類:給定一個大腦活動片段,它可以從大量新音訊片段中確定該人實際聽到的是哪個片段。

演算法推論出這個人最有可能聽到的字。這是一個令人興奮的步驟,因為它表明人工智慧可以成功地學會在感知語音時解碼大腦活動的嘈雜和可變的非侵入性記錄。

下一步是看看研究人員是否可以擴展這個模型,直接從大腦活動中解碼語音,而不需要音訊剪輯池,即,轉向安全和多功能的語音解碼器。 研究人員的分析進一步表明,我們演算法的幾個組成部分,包括使用 wav2vec 2.0 和主題層,對解碼性能是有益的。

此外,Meta的演算法隨著 EEG 和 MEG 記錄的數量而改進。 實際上,這意味著Meta研究人員的方法受益於大量異質資料的提取,並且原則上可以幫助改進小型資料集的解碼。

這很重要,因為在許多情況下,很難讓給定的參與者收集大量資料。例如,要求患者在掃描儀上花費數十個小時來檢查系統是否適合他們是不切實際的。 相反,演算法可以在包括許多個人和條件的大型資料集上進行預訓練,然後在資料很少的情況下為新患者的大腦活動提供解碼支援。

Meta的研究令人鼓舞,因為結果表明,經過自我監督訓練的人工智慧可以成功地從大腦活動的非侵入性記錄中解碼感知到的語音,儘管這些數據中存在固有的雜訊和可變性。 當然,這些結果只是第一步。在這項研究工作中,Meta專注於解碼語音感知,但實現患者溝通的最終目標需要將這項工作擴展到語音生產。

這個研究領域甚至可以超越幫助患者,潛在地包含啟用與電腦互動的新方式。

從更大的視野來看,Meta的工作是科學界使用人工智慧更好地理解人類大腦的努力的一部分。 Meta希望公開分享這項研究,以加快應對未來挑戰的進展。

#論文連結:https://arxiv.org/pdf/2208.12266.pdf

本文提出了一個單一的端對端架構,在大量的個體群中進行對比性學習訓練,以預測自然語音的自監督表示。

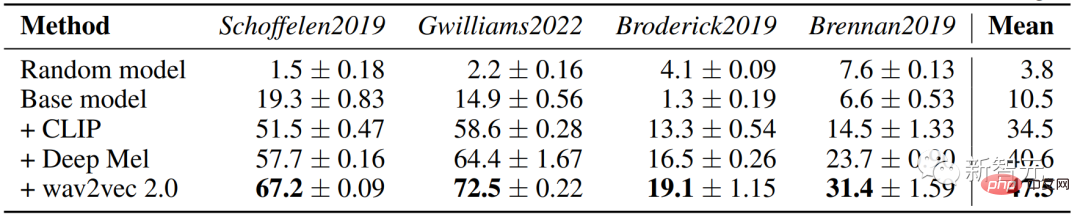

我們在四個公共資料集上評估了模型,其中包括169名志願者在聽自然語音時用腦磁圖或腦電圖(M/EEG)記錄的數據。

這為從非侵入性的大腦活動記錄中即時解碼自然語言處理提供了一個新的想法。

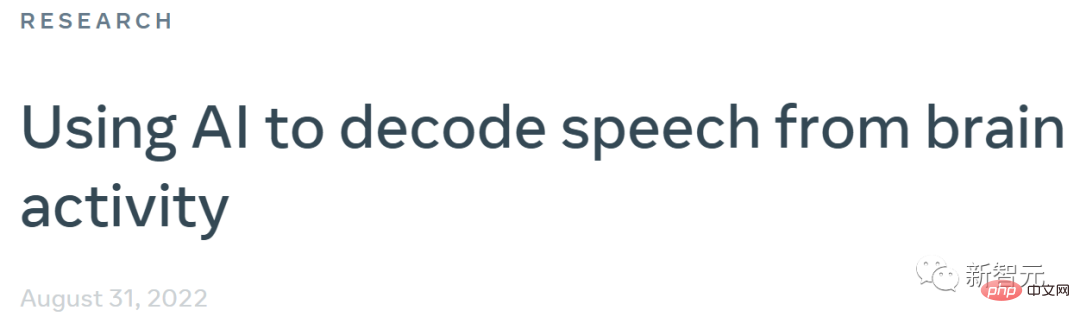

我們首先正式確定了神經解碼的一般任務,並激勵使用對比損失進行訓練。在介紹用於大腦解碼的深度學習架構之前,我們介紹了由預先訓練的自我監督模組wav2vec 2.0提供的豐富的語音表示。

我們的目標是在健康志願者被動地聽他們的母語口語句子時,從用非侵入性腦磁圖(MEG)或腦電圖(EEG)記錄的高維大腦訊號的時間序列中解碼語音。

口語是如何在大腦中表示的在很大程度上是未知的,因此,通常以監督的方式訓練解碼器,以預測已知與大腦有關的語音的潛在表示。

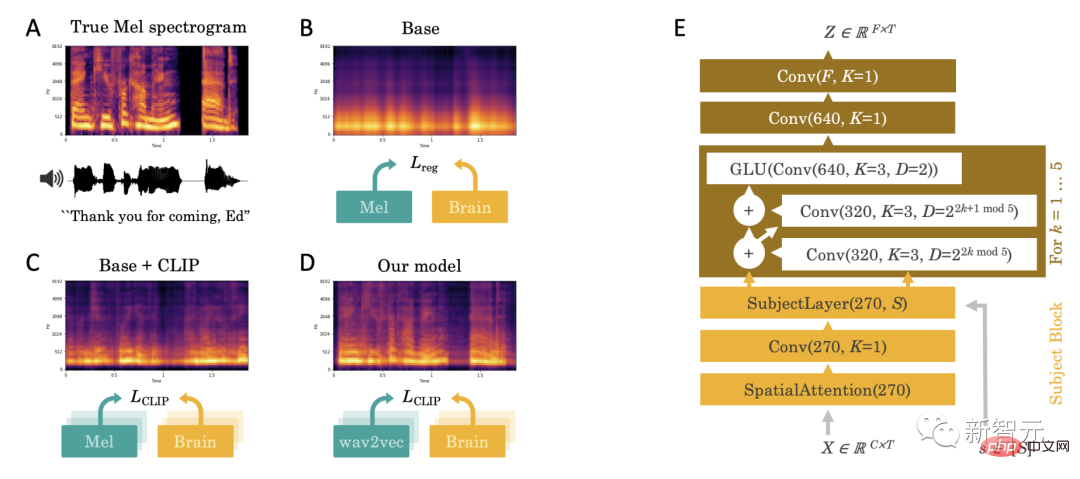

從經驗上看,我們觀察到這種直接回歸的方法面臨幾個挑戰:當語音出現時,解碼預測似乎被一個不可區分的寬頻成分所支配(圖2.A-B)。

這個挑戰促使我們做出三個主要貢獻:引入對比損失、預先訓練好的深層語音表徵和專門的大腦解碼器。

1、對比性損失

#首先,我們推斷,迴歸可能是無效的損失,因為它偏離了我們的目標:從大腦活動中解碼語音。因此,我們用一種對比性損失來取代它,即 "CLIP "損失,它最初被設計用來匹配文字和圖像這兩種模式中的潛在表徵。

2、預訓練的深度語音表徵

#其次,Mel頻譜是語音的低層次表徵,因此不太可能與豐富的皮質表徵相符。 因此,我們用語音的潛在表徵取代了Mel頻譜Y,這些表徵要么是端到端學習的("Deep Mel "模型),要么是用一個獨立的自我監督的語音模型學習的。 在實踐中,我們使用wav2vec2-large-xlsr-531,它已經對53種不同語言的56k小時的語音進行了預訓練。

3、專門的「大腦解碼器」

最後,對於大腦模組,我們使用一個深度神經網路fclip,輸入原始的M/EEG時間序列X和對應的主題s的單次編碼,並輸出潛在的大腦表示Z,其取樣率與X相同。

#這個架構包括(1)在M/EEG感測器上的空間注意力層,然後由一個針對特定物件的1x1卷積設計,以利用物件間的變異性,其輸入是卷積塊的堆疊。

結果顯示,wav2vec 2.0 模型可以從3秒的腦電訊號中辨識出對應的語音片段,在1,594個不同的片段中,準確率高達72.5%,在2,604個腦電記錄片段中,準確率高達19.1%,可以對訓練集中沒有的短語進行解碼。

#以上是Meta:不用插管! AI看看腦電圖就知道你在想啥的詳細內容。更多資訊請關注PHP中文網其他相關文章!