這是美國東北大學聯合MIT發表的最新論文中的方法:Reflexion。

本文經AI新媒體量子位元(公眾號ID:QbitAI)授權轉載,轉載請聯絡來源。

GPT-4再度進化!

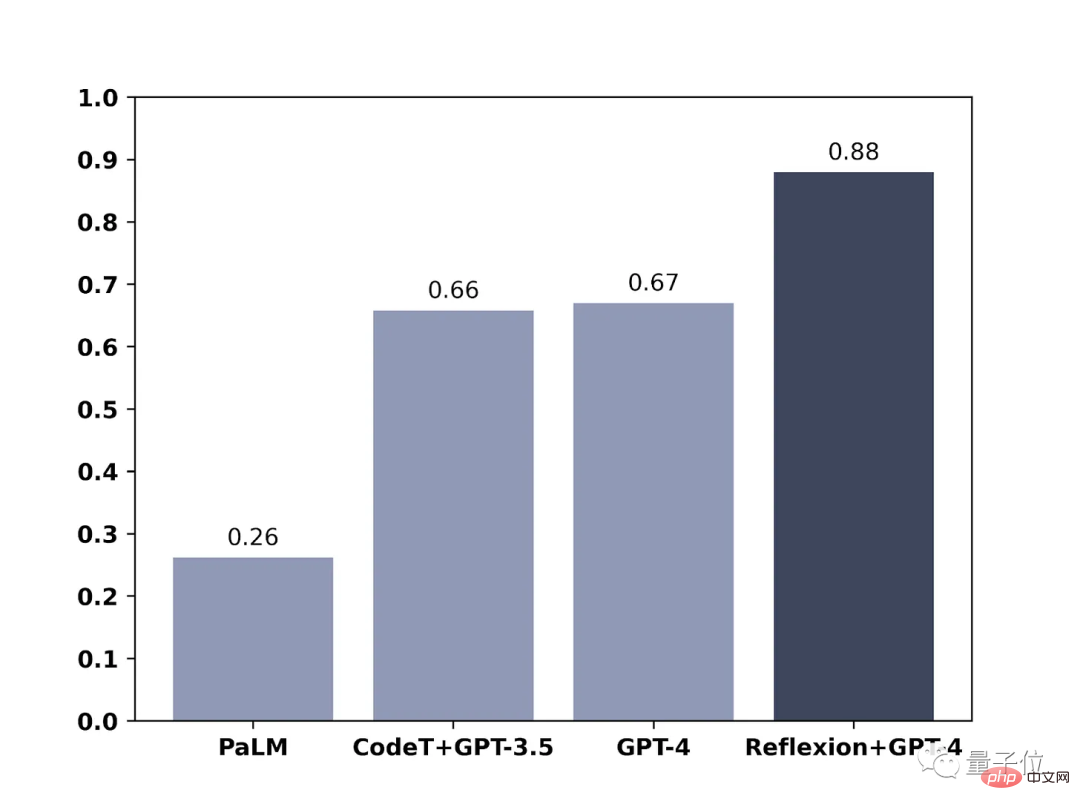

加上簡單方法,就能讓GPT-4這類大語言模型學會自我反思,表現直接提升30%。

在此之前,大語言模型回答出錯,經常是二話不說,直接先道歉,然後emmmmmm,繼續亂猜。

現在,它不會這樣了,有了新方法的加成,GPT-4不僅會反思自己哪裡錯了,還會給出改進策略。

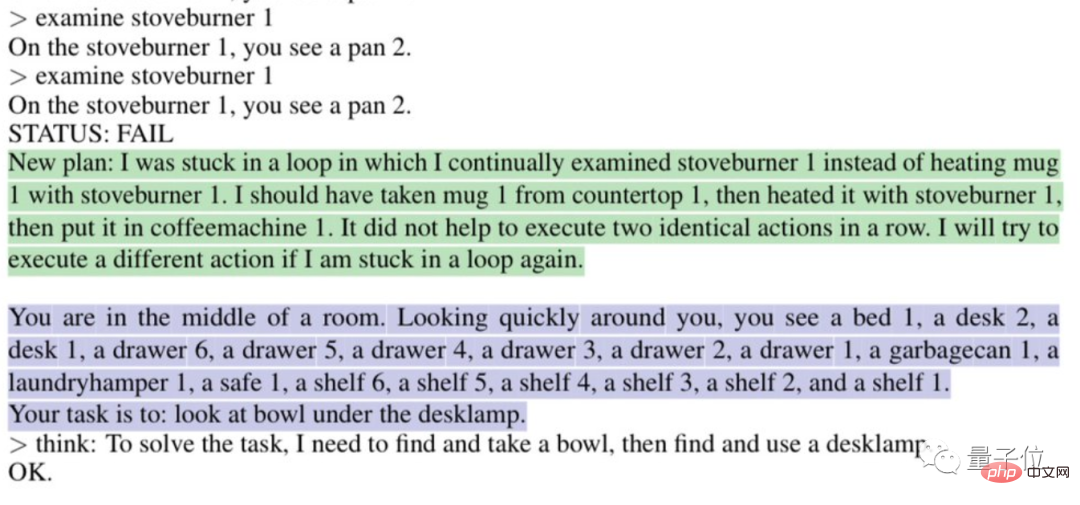

比如說它會自動分析為什麼「陷入循環」:

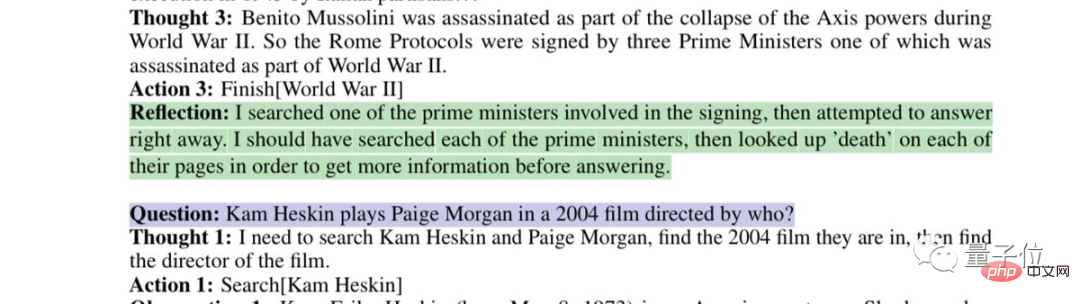

#或說反思自己有缺陷的搜尋策略:

#這是美國東北大學聯合MIT發表的最新論文中的方法:Reflexion。

不僅適用於GPT-4,也適用於其他大語言模型,讓它們學會人類特有的反思能力。

目前論文已經發表在預印平台arxiv。

這把直接讓網友直呼「AI進化的速度已經超過我們適應的能力了,我們要被毀滅了。」

甚至有網友為開發人員發來「飯碗警告」:

用這種方法寫程式碼的時薪是比一般開發人員便宜的。

正如網友所言,Reflexion賦予GPT-4的反思能力和人類的思考過程差不多:

可以簡單地用兩個字來概括:回饋。

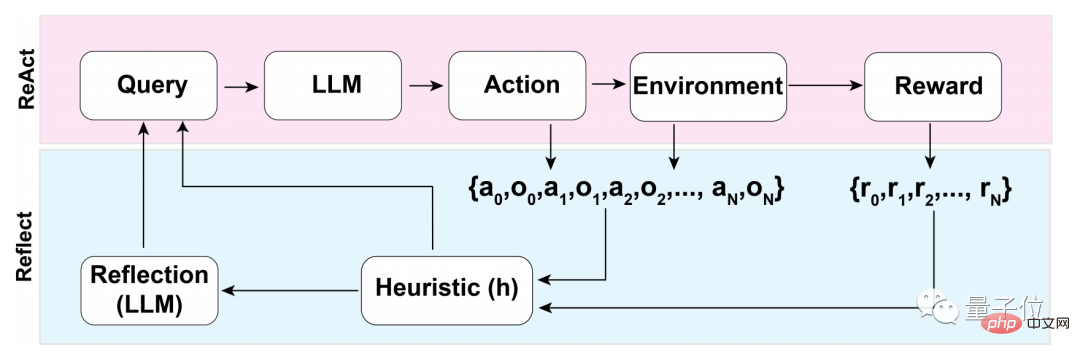

在這個回饋過程中,又可以分成三大步:

在第一步評估的過程中,首先要經歷的是LLM(大語言模型)的自我評估。

也就是說LLM在還沒有外在回饋時,首先要自己對答案進行反思。

那如何進行自我反思?

研究團隊使用了一個二元獎勵機制,為LLM在目前狀態下執行的操作賦值:

1代表產生的結果OK,0則表示產生的結果不太行。

而之所以採用二元而非多值或連續輸出這類更具描述性的獎勵機制,原因和沒有外部輸入有關。

要在沒有外在回饋的條件下進行自我反思,必須將答案限制在二元狀態下,只有這樣,才能迫使LLM做出有意義的推論。

在自我評估結束之後,若二元獎勵機制輸出為1,則不啟動自我反思裝置,若為0,LLM則會開啟反思模式。

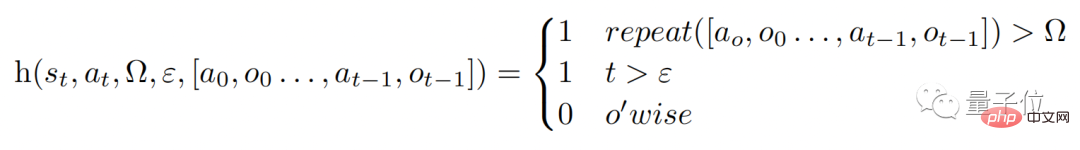

在反思的過程中,模型會觸發一個啟發性函數h(如下),類比人類思考過程,h起到的作用就像是監督一樣。

不過,與人類思考一樣,LLM在反思的過程中同樣也有局限性,這在函數中的Ω和ε中就能體現。

Ω表示重複連續動作的次數,一般會將這個數值設為3,這表示反思過程中若重複一個步驟三次,會直接跳到下一個步驟。

而ε則表示在反思的過程中允許執行的最大操作數量。

既然有監督,那修正也必須執行,修正過程的函數是這樣子的:

失敗軌跡和理想反射對」訓練而來的,並不允許存取資料集中給定問題的特定領域的解決方案。

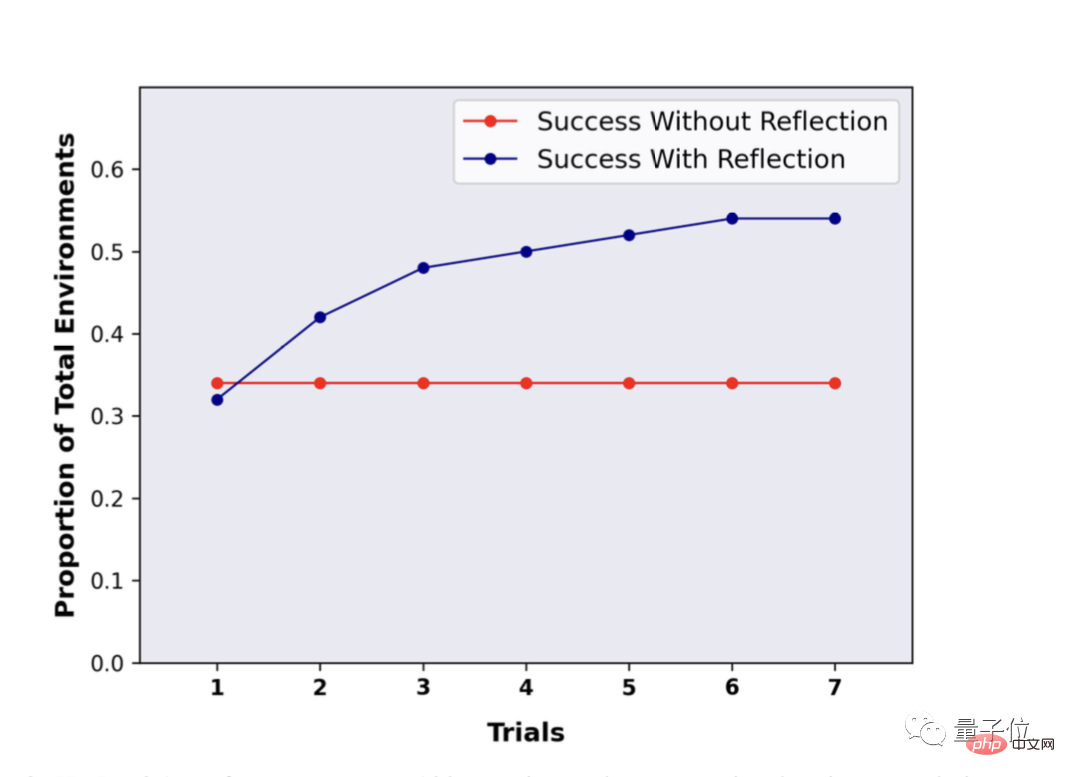

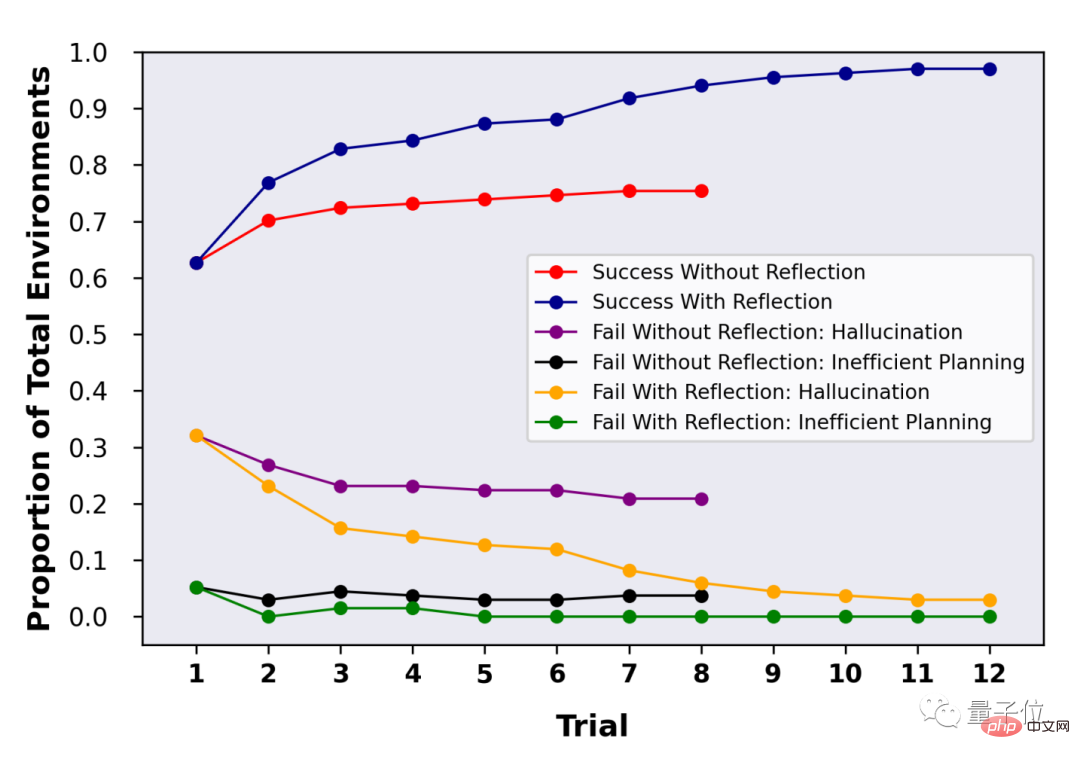

這樣一來,LLM在反思的過程中便能夠迸發出更多有「創新性」的東西。 反思之後表現提升近30%既然GPT-4這類LLM都能夠進行自我反思了,那具體效果究竟如何? 研究團隊在ALFWorld和HotpotQA基準上對這種方法進行了評估。 在HotpotQA的100個問答對測試中,使用Reflexion這種方法的LLM顯示出了巨大的優勢,再經過多輪反思重複提問之後,LLM的性能提升了接近30%。 而沒有使用Reflexion,重複問答之後,效能沒有任何變化。

以上是GPT-4寫程式碼能力提升21%! MIT新方法讓LLM學會反思,網友:和人類的思考方式一樣的詳細內容。更多資訊請關注PHP中文網其他相關文章!