OpenAI的共同創辦人Greg Brockman和首席科學家Ilya Sutskever評價GPT-4的效能,並對安全問題和開源的爭議進行解釋。

毫無疑問,GPT-4一發布,就引爆了整個業界和學界。

憑藉著自己強大的推理和多模態能力,引發了一眾熱議。

然鵝,GPT-4不是一個open的模型。

雖然OpenAI分享了大量GPT-4的基準和測試結果,但基本上沒有提供用於訓練的資料、成本、或用於創建模型的方法。

當然了,這樣的「獨家秘笈」OpenAI肯定不會公佈了。

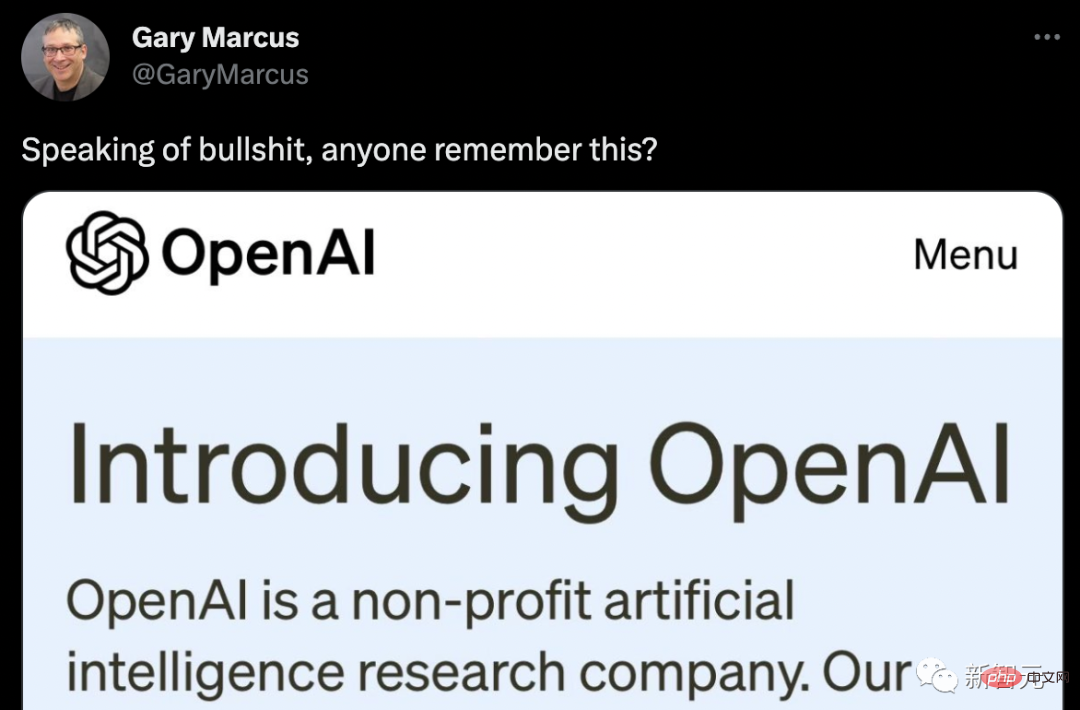

馬庫斯直接拿出當初OpenAI的初衷,發文嘲諷了一波。

網友改進了一個版本。

當OpenAI的總裁、聯合創始人之一Greg Brockman將GPT-4和GPT-3進行比較時,他說了一個詞——不同。

「它只是不同而已,模型仍然有很多問題和錯誤......但你真的可以看到它在微積分或法律等方面的技能提升。在某些領域,它從表現非常糟糕進化到現在足以匹敵人類。」

GPT-4的測試結果很不錯:在AP微積分BC考試中,GPT-4得了4分,而GPT-3得了1分。在模擬的律師考試中,GPT-4以大約前10%考生的分數通過;GPT-3.5的分數徘徊在後10%。

在上下文能力,也就是說在生成文本之前可以記憶的文本方面,GPT-4大約能夠記住50頁左右的內容,是GPT-3的8倍。

在提示方面,GPT-3和GPT-3.5只能接受文字提示:「寫一篇關於長頸鹿的文章」,而多模態的GPT-4可以接受圖片和文字的提示:給出一張長頸鹿的圖片,提示問「這裡有多少隻長頸鹿?」這些GPT-4都能答對,而且它的讀梗能力也很強!

而強到離譜的GPT-4一發布,便引起了大量研究人員和專家的興趣。但令人失望的是,OpenAI發布的GPT-4,不是「Open的AI模型。」

儘管OpenAI分享了大量GPT-4的基準、測試結果和有趣的演示,但基本上沒有提供用於訓練該系統的數據、能源成本或用於創建它的特定硬體或方法的相關資訊。

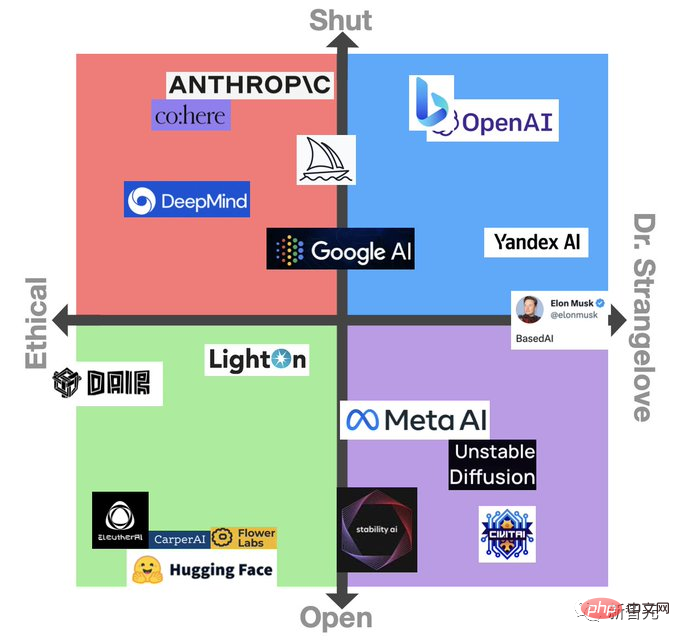

之前Meta的LLaMa模型外洩的時候,就引發一波關於開源的討論。不過,這次大家對於GPT-4封閉模型的最初反應是大部分都是負面的。

人工智慧社群普遍認為,這不僅破壞了OpenAI作為研究機構的創始精神,也讓其他人難以製定保障措施來應對威脅。

Nomic AI的資訊設計副總裁Ben Schmidt表示,由於無法看到GPT-4是在什麼資料上訓練的,大家很難知道該系統在什麼地方是安全使用的,並提出修復方案。

「為了讓人們知道這個模型什麼地方不起作用,OpenAI需要更了解GPT-4所做的事情以及其中的假設。我可不會在下雪的時候,相信一個沒有在雪在地氣候情況下訓練出來的自動駕駛汽車。因為很可能,漏洞和問題只在真實使用的時候才會浮現。」

對此,OpenAI的首席科學家兼聯合創始人Ilya Sutskever解釋稱:OpenAI不分享更多關於GPT-4的資訊是因為害怕競爭,也是因為對安全的擔憂,這一點是毋庸置疑的。

「外面的競爭很激烈,GPT-4的開發並不容易。幾乎所有的OpenAI的員工在一起工作了很長時間才生產出這個東西。從競爭的角度來看,有很多很多公司都想做同樣的事情,而GPT-4像是個成熟的果實。」

眾所周知,OpenAI在2015年成立之初是一個非營利組織。其創始人包括Sutskever、現任執行長Sam Altman、總裁Greg Brockman以及現已離開OpenAI的馬斯克。

Sutskever等人曾表示,該組織的目標是為每個人創造價值,而不是單單為股東創造價值,並表示將與該領域的各方進行「自由合作」。

然而,為了獲得數十億美元的投資(主要來自微軟),OpenAI還是被加蓋了一層商業屬性。

不過,當被問及為什麼OpenAI改變了分享其研究的方法時,Sutskever簡單地回答:

「我們錯了。在某個時候,AI/AGI將變得極其強大,那時,開源就是沒有意義的。可以預料的是,在幾年內,每個人都會完全明白,開源人工智慧是不明智的。因為這個模型是非常有力的。如果有人想,用它就能夠造成巨大的傷害,這將是相當容易的。所以隨著模型的能力越來越高,不想披露它們是有道理的。」

Lightning AI的執行長和開源工具PyTorch Lightning的創建者William Falcon從商業角度解讀稱:「作為一家公司,你完全有權利這樣做。」

同時,Brockman也認為GPT-4的應用推廣應是緩慢推進的,因為OpenAI正在評估風險和利益。

「我們需要解決一些政策問題,如臉部辨識和如何對待人的圖像,我們需要弄清楚,危險區在哪裡,紅線在哪裡,然後慢慢澄清這些點。」

還有就是老生常談的,GPT-4被用來幹壞事的風險。

以色列網路安全新創公司Adversa AI發表了一篇博文,展示了繞過OpenAI的內容過濾器,讓GPT-4生成釣魚郵件、生成對同性戀者的性描述等讓人高度反感的文本的方法。

因此,很多人都希望GPT-4在審核方面帶來重大改進。

針對這一點,Brockman強調,他們花了很多時間試圖了解GPT-4的能力,而該模型已經經歷了六個月的安全培訓。在內部測試中,對於OpenAI的使用政策所不允許的內容,GPT-4作出反應的可能性比GPT-3.5低82%,產生「事實性」反應的可能性高40%。

不過,Brockman並不否認GPT-4在這方面的不足。但他強調了該模型的新的緩和導向工具,稱為「系統資訊」的API級能力。

系統資訊本質上是為GPT-4的互動設定基調,並建立界限的指令。這樣,以系統資訊作為護欄,就可以防止GPT-4偏離方向。

例如,一個系統訊息的人設可能是這樣的:「你是一個總是用蘇格拉底回答問題的導師。你從不給學生答案,而是總是試圖提出正確的問題,幫助他們學會自己思考。」

其實,從某種程度上,Sutskever也認同批評者的觀點:「如果有更多的人願意研究這些模型,我們會對它們有更多的了解,這將是好事。」

所以OpenAI出於這些原因,向某些學術和研究機構提供了訪問其係統的機會。

而且Brockman也提到了Evals,這是OpenAI新開源的軟體框架,用於評估其人工智慧模型的性能。

Evals採用的是模型測試眾包的方式,讓使用者開發和運行評估GPT-4等模型的基準,同時檢查其性能,這也是OpenAI致力於「健全」模型的標誌之一。

「透過Evals,我們可以看到用戶關心的用例,能夠以一種系統的形式進行測試。我們開源的部分原因是,我們正在從每三個月發布一個新模型轉向不斷改進新模型。當我們製作新的模型版本時,我們至少可以透過開源知道這些變化是什麼。」

#其實,關於共享研究的討論一直頗為火熱。一方面,谷歌和微軟這樣的科技巨頭正急於將人工智慧功能添加到他們的產品中,往往會將以前的道德問題擱置一邊,微軟最近就解雇了一個團隊,該團隊是專門確保人工智慧產品遵循道德準則的);另一方面;技術的迅速改善引發了人們對人工智慧的擔憂。

英國人工智慧政策負責人 Jess Whittlestone 說,平衡這些不同的壓力帶來了嚴重的治理挑戰,這意味著我們可能需要第三方監管機構參與。

「OpenAI 不分享關於GPT-4 的更多細節的出發點是好的,但也可能導致人工智慧世界的權力集中化。這些決定不應該由個別公司來做。」

Whittlestone 說:「理想的情況是,我們需要把這裡的做法編纂成冊,然後讓獨立的第三方去審查與某些模型相關的風險。」

以上是GPT-4強到離譜,OpenAI拒絕Open!首席科學家:開源並不明智,我們之前錯了的詳細內容。更多資訊請關注PHP中文網其他相關文章!