引入密集強化學習,用 AI 驗證 AI。

自動駕駛汽車 (AV) 技術的快速發展,使得我們正處於交通革命的風口浪尖,其規模是自一個世紀前汽車問世以來從未見過的。自動駕駛技術具有顯著提高交通安全性、機動性和永續性的潛力,因此引起了工業界、政府機構、專業組織和學術機構的共同關注。

過去 20 年裡,自動駕駛汽車的發展取得了長足的進步,尤其是隨著深度學習的出現。到 2015 年,開始有公司宣布他們將在 2020 之前量產 AV。不過到目前為止,並且沒有 level 4 等級的 AV 可以在市面上買到。

導致這現象的原因有很多,但最重要的是,自動駕駛汽車的安全性能仍大大低於人類駕駛員。對於美國的普通駕駛者來說,在自然駕駛環境 (NDE) 中發生碰撞的機率約為 1.9 × 10^−6 per mile。相較之下,根據加州 2021 年的脫離報告(Disengagement Reports)顯示,最先進的自動駕駛汽車的脫離率約為 2.0 × 10^−5 / 英里。

附註:脫離率是評定自動駕駛可靠性的重要指標,它描述的是系統運行每 1000 英里需要駕駛員接管的次數。系統的脫離率越低,代表可靠性越佳。當脫離率等於 0 時,也從某種程度上說明這個自動駕駛系統已經達到無人駕駛等級。

儘管脫離率會因為偏見而受到批評,但它已被廣泛用於評估自動駕駛汽車安全性能。

提高自動駕駛汽車安全性能存在的關鍵瓶頸是安全驗證效率低。目前流行的是透過軟體模擬、封閉測試軌道和道路測試相結合的方式來測試自動駕駛汽車的無損檢測。這樣一來,AV 開發人員必須支付大量的經濟和時間成本來評估,阻礙了 AV 部署的進展。

在 NDE 環境中,進行 AV 安全性效能驗證非常複雜。例如,駕駛環境在時空上是複雜的,因此定義此類環境所需的變數是高維度的。隨著變數維數呈指數成長,計算複雜度也呈現指數成長。在這種情況下,即使給定大量數據,深度學習模型也很難學習。在

本文中,來自密西根大學安娜堡分校、清華大學等機構的研究者,他們提出密集深度強化學習 (D2RL,dense deep-reinforcement-learning) 方法來解決這一挑戰。

該研究登 Nature 封面。

論文一作封碩,目前是清華大學自動化系終身助理教授(Tenure-Track Assistant Professor) ,此外,他也是密西根大學交通研究所(UMTRI) 的助理研究科學家。他於 2014 年和 2019 年在清華大學自動化系獲得學士和博士學位,師從張毅教授。 2017 年至 2019 年,他在密西根大學土木與環境工程專業擔任訪問博士,師從 Henry X. Liu 教授(本文通訊作者)。

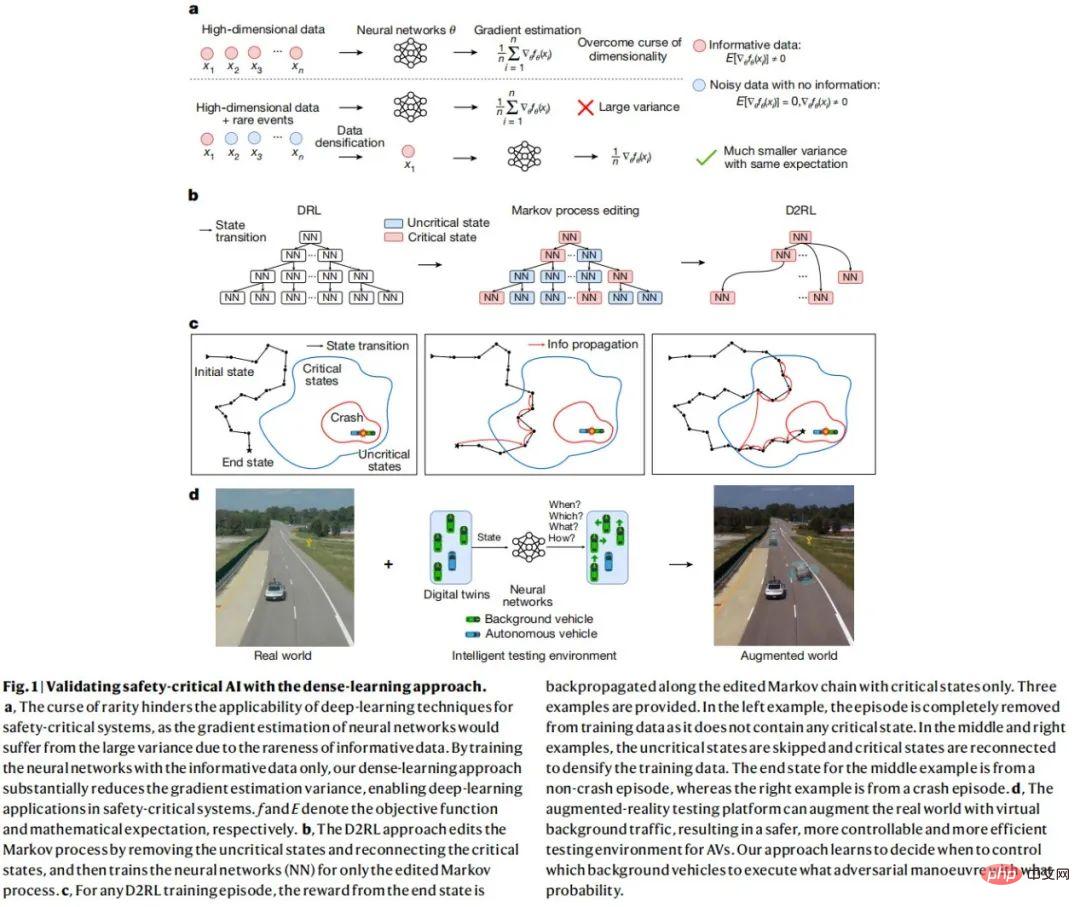

D2RL 方法的基本思想是識別和去除非安全關鍵(non-safety-critical)數據,並利用安全關鍵數據訓練神經網路。由於只有一小部分資料是安全關鍵的,因此其餘資料的資訊將被大量密集化。

與 DRL 方法相比,D2RL 方法可以在不損失無偏性(unbiasedness)的情況下顯著減少多個數量級的策略梯度估計變異數。這種顯著的變異減少可以使神經網路學習和完成 DRL 方法難以處理的任務。

對於 AV 測試,該研究利用 D2RL 方法,透過神經網路訓練週邊車輛 (background vehicles,BV) 學習何時執行何種對抗性操作,旨在提高測試效率。 D2RL 在基於 AI 的對抗性測試環境下可以將 AV 所需的測試里程減少多個數量級,同時確保了測試的無偏性。

D2RL 方法可以應用於複雜的駕駛環境,包括多條高速公路、十字路口和環島,這是以前基於場景的方法無法實現的。並且,該研究提出的方法可以創建智慧測試環境,即使用 AI 來驗證 AI。這是一種範式轉變,它為其他安全關鍵系統進行加速測試和訓練打開了大門。

為了證明基於AI 的測試方法是有效的,該研究使用大規模實際駕駛資料集對BV 進行了訓練,並進行了模擬實驗和物理測試軌道的現場實驗,實驗結果如下圖1所示。

密集深度強化學習

為了利用AI 技術,研究將AV 測試問題表述為馬可夫決策過程(MDP),其中BV 的操作是根據目前狀態資訊決定的。該研究旨在訓練一個由神經網路建模的策略(DRL 智能體),它可以控制 BV 與 AV 交互作用的操作,以最大限度地提高評估效率並確保無偏性。然而,如上所述,受維度和計算複雜度的限制,如果直接應用 DRL 方法,很難甚至根本無法學習有效策略。

由於大多數狀態都是非關鍵的,無法為安全關鍵事件提供信息,因此 D2RL 的重點是去除這些非關鍵狀態的數據。對於 AV 測試問題,可以利用許多安全指標來識別具有不同效率和有效性的關鍵狀態。本研究利用的關鍵度量指標是當前狀態特定時間範圍內(例如 1 秒)內 AV 碰撞率的外部近似值。然後研究編輯了馬可夫過程,丟棄非關鍵狀態的數據,並將剩餘數據用於 DRL 訓練的策略梯度估計和 Bootstrap。

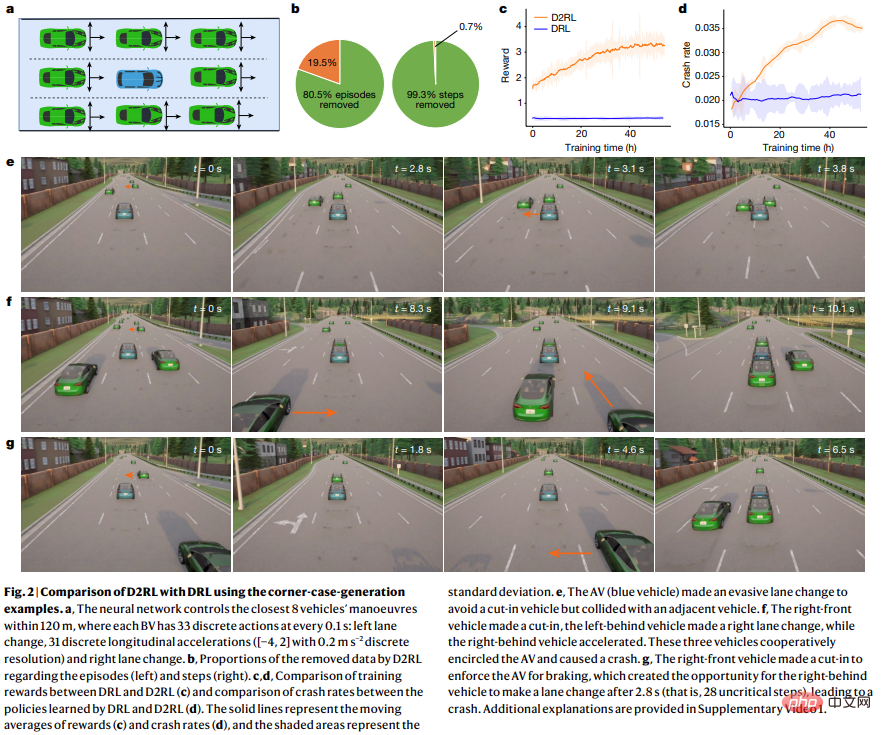

如下圖 2 所示,相較於 DRL,D2RL 的優勢是能夠最大化訓練過程中的獎勵。

AV 模擬測試

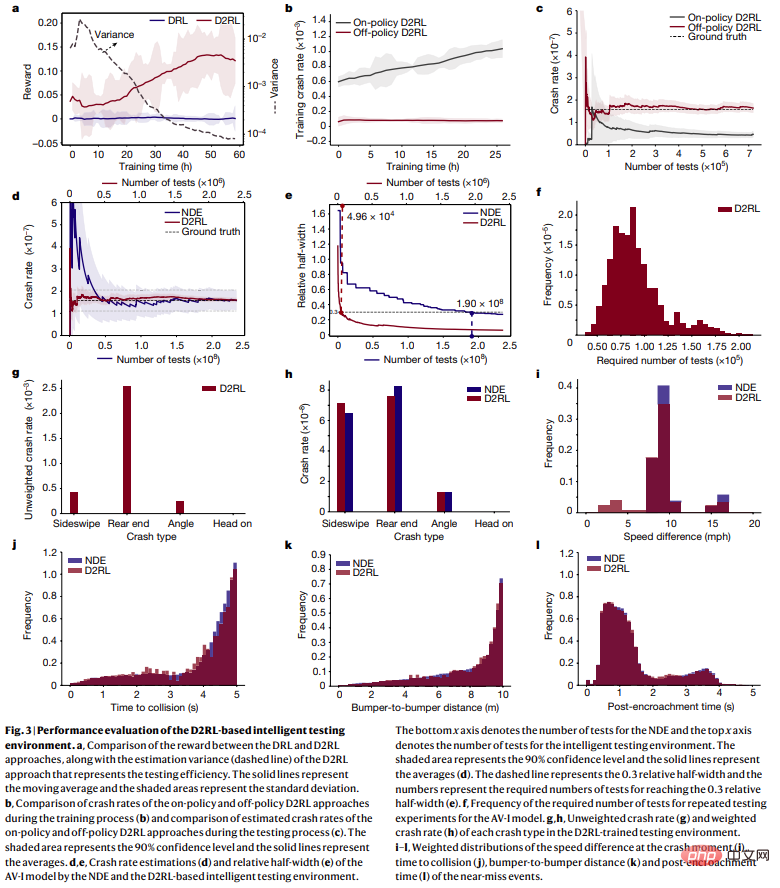

為了評估D2RL 方法的準確性、效率、可擴展性和通用性,研究進行了仿真測試。對於每個測試集,研究模擬了一段固定距離的交通行駛,然後記錄並分析測試結果,如下圖 3 所示。

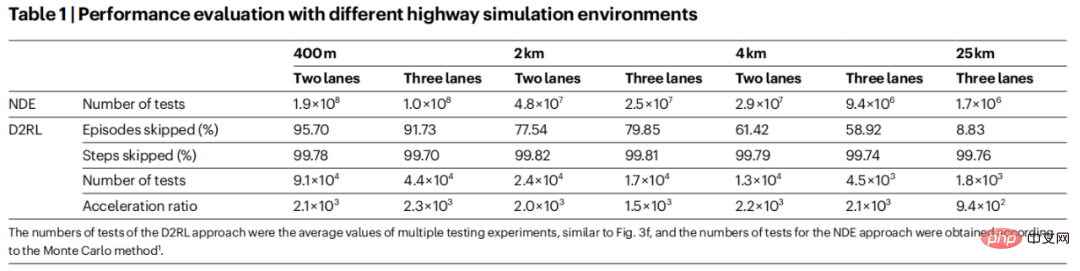

為了進一步研究D2RL 的可擴展性和泛化性,該研究對AV-I 模型進行了不同車道數(2 車道和3 車道) 和行駛距離(400 公尺、2 公里、4 公里和25 公里) 的實驗。本文對 25 公里行程進行了研究 ,因為在美國,平均通勤者單程旅行約為 25 公里。結果如表 1 所示:

以上是強化學習再登Nature封面,自動駕駛安全驗證新典範大幅減少測試里程的詳細內容。更多資訊請關注PHP中文網其他相關文章!