在爬蟲過程中,有些頁面在登入之前是被禁止抓取的,這個時候就需要模擬登陸了,下面這篇文章主要給大家介紹了利用Python爬蟲模擬知乎登錄的方法教程,文中介紹的非常詳細,需要的朋友可以參考借鑒,下面來一起看看吧。

前言

對於經常寫爬蟲的大家都知道,有些頁面在登入之前是被禁止抓取的,例如知乎的話題頁面就要求使用者登入才能訪問,而「登入」 離不開HTTP 中的Cookie 技術。

登入原則

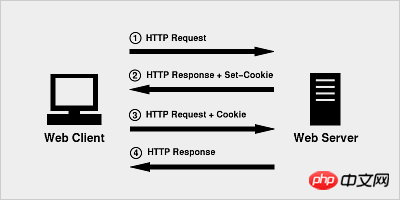

Cookie 的原理非常簡單,因為HTTP 是一種無狀態的協議,因此為了在無狀態的HTTP 協議之上維護會話(session)狀態,讓伺服器知道目前是和哪個客戶在打交道,Cookie 技術出現了,Cookie 相當於是服務端分配給客戶端的一個識別。

瀏覽器第一次發起HTTP 請求時,沒有攜帶任何Cookie 資訊

伺服器把HTTP 回應,同時還有一個Cookie 訊息,一起傳回給瀏覽器

瀏覽器第二次請求就把伺服器傳回的Cookie 訊息一起傳送給伺服器

伺服器收到HTTP請求,發現請求頭中有Cookie字段, 便知道之前就和這個用戶打過交道了。

實戰應用程式

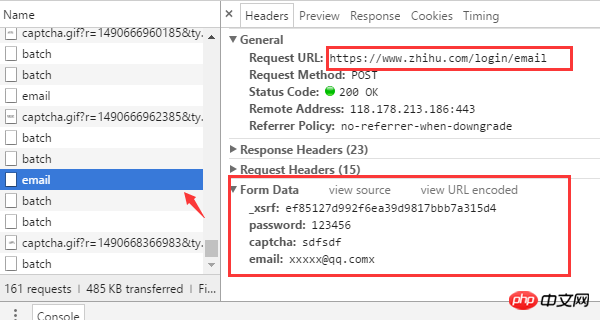

#用過知乎的都知道,只要提供使用者名稱和密碼以及驗證碼之後即可登入。當然,這只是我們眼中看到的現象。而背後隱藏的技術細節就需要藉由瀏覽器來挖掘了。現在我們就用 Chrome 來查看當我們填完表單後,究竟發生了什麼事?

(如果已登入的,先登出)首先進入知乎的登入頁面www.zhihu.com/#signin ,開啟Chrome 的開發者工具列(按F12 )先嘗試輸入一個錯誤的驗證碼觀察瀏覽器是如何發送請求的。

從瀏覽器的請求可以發現幾個關鍵的資訊

登入的URL 位址是https://www. zhihu.com/login/email

登入需要提供的表單資料有4個:使用者名稱(email)、密碼(password)、驗證碼(captcha)、_xsrf。

取得驗證碼的URL位址是https://www.zhihu.com/captcha.gif?r=1490690391695&type=login

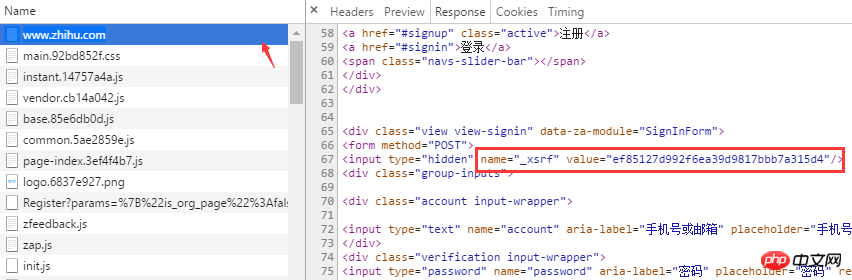

#_xsrf 是什麼?如果你對CSRF(跨站請求偽造)攻擊非常熟悉的話,那麼你一定知道它的作用,xsrf是一串偽隨機數,它是用來防止跨站請求偽造的。它通常存在網頁的form 表單標籤中,為了證實這一點,可以在頁面上搜尋“xsrf”,果然,_xsrf在一個隱藏的input 標籤中

1清了瀏覽器登入時所需的資料是如何取得之後,那麼現在就可以開始寫程式碼用Python 模擬瀏覽器來登入了。登入時所依賴的兩個第三方函式庫是requests 和BeautifulSoup,先安裝

pip install beautifulsoup4==4.5.3 pip install requests==2.13.0

http.cookiejar 模組可用來自動處理HTTP Cookie,LWPCookieJar 物件就是對cookies 的封裝,它支援把cookies 儲存到檔案以及從檔案中載入。

而session 物件提供了Cookie 的持久化,連接池功能,可以透過session 物件發送請求

首先從cookies.txt 檔案中載入cookie訊息,因為首次運行還沒有cookie,所有會出現LoadError 異常。

from http import cookiejar

session = requests.session()

session.cookies = cookiejar.LWPCookieJar(filename='cookies.txt')

try:

session.cookies.load(ignore_discard=True)

except LoadError:

print("load cookies failed")取得xsrf

在前面已經找到了xsrf 所在的標籤,,利用BeatifulSoup 的find 方法可以非常便捷的取得該值

def get_xsrf():

response = session.get("https://www.zhihu.com", headers=headers)

soup = BeautifulSoup(response.content, "html.parser")

xsrf = soup.find('input', attrs={"name": "_xsrf"}).get("value")

return xsrf取得驗證碼

#驗證碼是透過/captcha.gif 介面傳回的,這裡我們把驗證碼圖片下載儲存到目前目錄,由人工識別,當然你可以用第三方支援庫自動識別,例如pytesser。

def get_captcha():

"""

把验证码图片保存到当前目录,手动识别验证码

:return:

"""

t = str(int(time.time() * 1000))

captcha_url = 'https://www.zhihu.com/captcha.gif?r=' + t + "&type=login"

r = session.get(captcha_url, headers=headers)

with open('captcha.jpg', 'wb') as f:

f.write(r.content)

captcha = input("验证码:")

return captcha登入

#一切参数准备就绪之后,就可以请求登录接口了。

def login(email, password):

login_url = 'www.zhihu.com/login/email'

data = {

'email': email,

'password': password,

'_xsrf': get_xsrf(),

"captcha": get_captcha(),

'remember_me': 'true'}

response = session.post(login_url, data=data, headers=headers)

login_code = response.json()

print(login_code['msg'])

for i in session.cookies:

print(i)

session.cookies.save()请求成功后,session 会自动把 服务端的返回的cookie 信息填充到 session.cookies 对象中,下次请求时,客户端就可以自动携带这些cookie去访问那些需要登录的页面了。

auto_login.py 示例代码

# encoding: utf-8

# !/usr/bin/env python

"""

作者:liuzhijun

"""

import time

from http import cookiejar

import requests

from bs4 import BeautifulSoup

headers = {

"Host": "www.zhihu.com",

"Referer": "www.zhihu.com/",

'User-Agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_10_5) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/56.0.2924.87'

}

# 使用登录cookie信息

session = requests.session()

session.cookies = cookiejar.LWPCookieJar(filename='cookies.txt')

try:

print(session.cookies)

session.cookies.load(ignore_discard=True)

except:

print("还没有cookie信息")

def get_xsrf():

response = session.get("www.zhihu.com", headers=headers)

soup = BeautifulSoup(response.content, "html.parser")

xsrf = soup.find('input', attrs={"name": "_xsrf"}).get("value")

return xsrf

def get_captcha():

"""

把验证码图片保存到当前目录,手动识别验证码

:return:

"""

t = str(int(time.time() * 1000))

captcha_url = 'www.zhihu.com/captcha.gif?r=' + t + "&type=login"

r = session.get(captcha_url, headers=headers)

with open('captcha.jpg', 'wb') as f:

f.write(r.content)

captcha = input("验证码:")

return captcha

def login(email, password):

login_url = 'www.zhihu.com/login/email'

data = {

'email': email,

'password': password,

'_xsrf': get_xsrf(),

"captcha": get_captcha(),

'remember_me': 'true'}

response = session.post(login_url, data=data, headers=headers)

login_code = response.json()

print(login_code['msg'])

for i in session.cookies:

print(i)

session.cookies.save()

if name == 'main':

email = "xxxx"

password = "xxxxx"

login(email, password)【相关推荐】

1. python爬虫入门(4)--详解HTML文本的解析库BeautifulSoup

2. python爬虫入门(3)--利用requests构建知乎API

3. python爬虫入门(2)--HTTP库requests

以上是分享一個利用Python爬蟲模擬知乎登入的實例的詳細內容。更多資訊請關注PHP中文網其他相關文章!