為大模型提供全新科學複雜問答基準與評估體系,UNSW、阿貢、芝加哥大學等多家機構共同推出SciQAG框架

編輯 | ScienceAI

問答(QA)資料集在推動自然語言處理(NLP)研究中發揮著至關重要的作用。高品質QA資料集不僅可以用於微調模型,也可以有效評估大語言模型(LLM)的能力,尤其是針對科學知識的理解和推理能力。

儘管目前已有許多科學QA資料集,涵蓋了醫學、化學、生物等領域,但這些資料集仍存在一些不足之處。

其一,資料形式較為單一,大多數為多項選擇題(multiple-choice questions),它們易於進行評估,但限制了模型的答案選擇範圍,無法充分測試模型的科學問題解答能力。相較之下,開放式問答(openQA)可以更全面地評估模型的能力,但缺乏合適的評估指標。

其二,現有資料集的內容很多來自大學及以下等級的教科書,難以評估LLM在實際學術研究或生產環境中的高層次知識保持能力。

其三,這些基準資料集的創建依賴於人類專家標註。

應對這些挑戰對建立更全面的QA資料集至關重要,也有利於科學LLM的更精準評估。

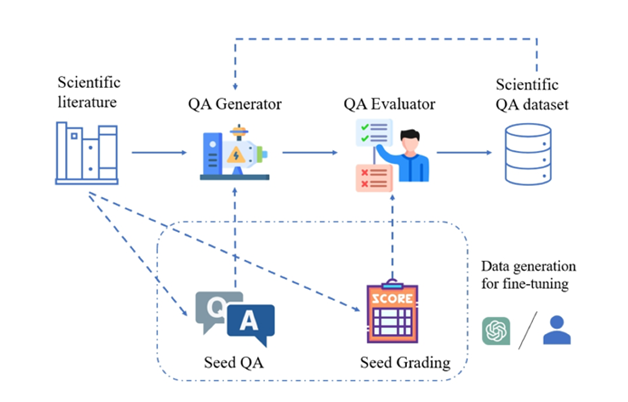

圖示:從科學文獻中產生高品質科學問答對的SciQAG框架。

為此,美國Argonne國家實驗室、芝加哥大學Ian Foster 教授(2002年戈登貝爾獎得主)團隊、澳洲新南威爾斯大學Bram Hoex教授UNSW AI4Science團隊、AI4Science 公司GreenDynamics 與香港城市大學揭春雨教授團隊聯合提出了SciQAG,第一個基於大語言模型(LLM)從大型科學文獻語料庫中自動產生高品質科學開放性問答對的新型框架。

論文連結:https://arxiv.org/abs/2405.09939

github連結:https://github.com/MasterAI-EAM/SciQAGc一個大規模、高品質、開放式的科學QA資料集SciQAG-24D ,包含從24個科學領域的22,743篇科學論文中提取的188,042 個QA對,旨在服務LLM的微調和科學問題解答能力評估。

實驗證明,在 SciQAG-24D 資料集上對 LLM 進行微調可以顯著提高它們在開放式問題解答和科學任務中的表現。 資料集、模型和評估程式碼已經開源(https://github.com/MasterAI-EAM/SciQAG),以促進AI for Science社群對開放式科學問答的共同開發。SciQAG框架與SciQAG-24D基準資料集

SciQAG由QA生成器和QA評估器組成,旨在大規模快速產生基於科學文獻的多樣化開放式問答對。首先,生成器將科學論文轉換為問答對,然後評估器過濾掉不符合品質標準的問答對,從而獲得高品質的科學問答資料集。

QA生成器

研究人員經過對比實驗設計了兩步驟提示詞(prompt),令LLM先提取關鍵字,再基於關鍵字生成問答對。

由於產生的問答資料集採用「閉卷」模式,即不提供原始論文,只關注提取出的科學知識本身,prompt要求生成的問答對不依賴或參考原始論文中的特有信息(例如不得出現代稱如「本/該論文」,「本/該研究」等字樣,或向文中表格/圖片提問)。 為了平衡效能和成本,研究人員選擇微調一個開源LLM作為生成器。 SciQAG使用者可以根據自身情況選擇任何開源或閉源LLM作為生成器,既可以使用微調,也可以使用提示詞工程。QA評估器

評估器用於完成兩個目的:(1)評估產生的問答對品質;(2)基於設定標準摒棄低品質的問答對。

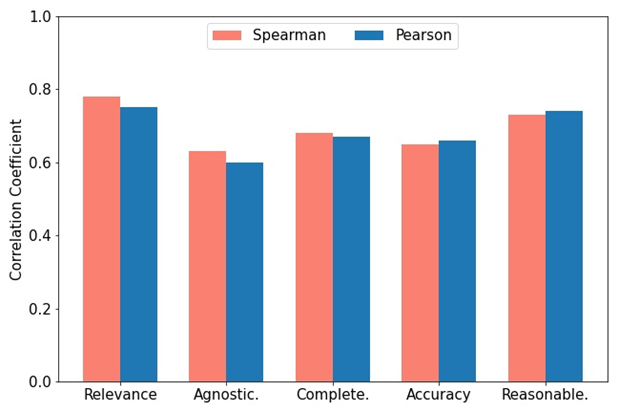

研究人員開發了一個綜合評估指標 RACAR,它由五個維度組成:相關性(relevance)、不可知性(agnosticism)、完整性(completeness)、準確性(accuracy)和合理性(reasonableness)。 在本研究中,研究人員直接使用 GPT-4 作為 QA 評估器,依照RACAR對產生的 QA 對進行評估,評估等級為 1-5(1 表示不可接受,5 表示完全可以接受)。 如圖所示,為了衡量 GPT-4 與人工評估之間的一致性,兩位領域專家使用 RACAR 指標對 10 篇文章(共 100 問答對)進行人工評估。使用者可以根據自身需求選擇任何開源或閉源LLM作為評估器。

圖示:GPT-4 分配分數與專家標註分數之間的 Spearman 與 Pearson 相關性。

SciQAG 框架的運用

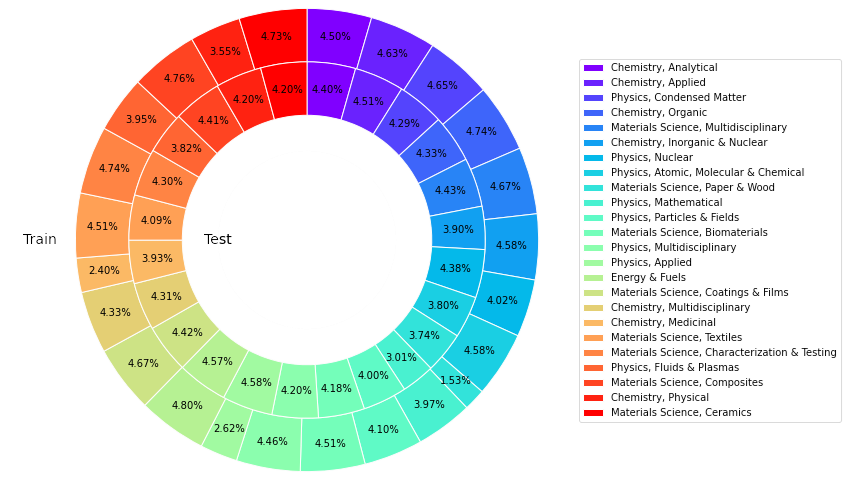

該研究從Web of Science (WoS)核心合集資料庫中獲取了24類高引用論文共計22,743篇,來自材料科學、化學、物理、能源等領域,旨在構建一個一個關於論文共計22,743篇,來自材料科學、化學、物理、能源等領域,旨在構建一個一個領域可靠、豐富、平衡且具代表性的科學知識來源。

為了微調開源LLM以形成QA生成器,研究人員從論文集合中隨機選擇426篇論文作為輸入,透過提示GPT-4產生4260個種子QA對。

使用經過訓練的QA產生器在剩餘論文上進行推理,共產生227,430個QA對(包括種子QA對)。從每個類別中抽取50篇論文(共1,200篇),使用GPT-4計算每個產生的QA對的RACAR分數,過濾掉任一維分數低於3的QA對作為測試集。

對於餘下的QA對,則使用基於規則的方法過濾掉所有包含論文特有資訊的問答對以形成訓練集。

SciQAG-24D 基準資料集

基於以上,研究人員建立了開放式科學QA 基準資料集SciQAG-24D,篩選後的訓練集包括21,529 篇論文和179,511 個篩選後的 QA測試集包含1,199 篇論文和8,531 個QA 對。

統計顯示,99.15%回答中的數據來自原論文,87.29%的問題相似度在0.3以下,且回答對原文內容的覆蓋度達到78.26%。

此資料集應用廣泛:訓練集可用於微調 LLM,為其註入科學知識;測試集可⽤於評估LLM在某特定或整體科學領域中的開放式QA任務表現。由於測試集較大,因此它也可以作為高品質資料用於微調。

圖示:SciQAG-24D資料集訓練和測試中不同類別的文章比例。

實驗結果

研究人員進行了全面的實驗以對比不同語言模型之間的科學問答性能差異及探索微調的影響。

零樣本設定(zero-shot setting)

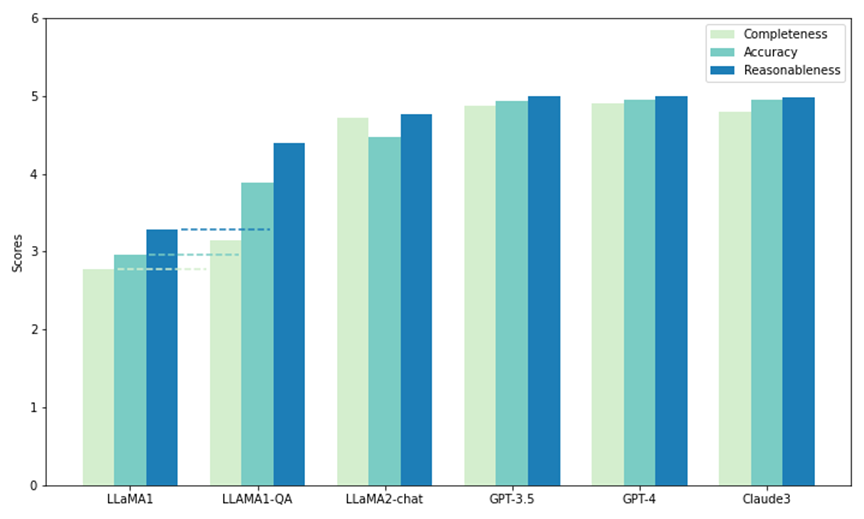

研究人員使用 SciQAG-24D 中的部分測試集對五個模型進行了零樣本性能對比。其中兩個是開源的 LLM:LLaMA1 (7B) 和 LLaMA2-chat (7B),其餘的是閉源 LLM 。

透過API呼叫:GPT3.5 (gpt-3.5-turbo)、GPT-4 (gpt-4-1106-preview) 和 Claude 3 (claude-3-opus-20240229)。每個模型在測試中被提示了 1000 個問題,並透過 CAR 指標(由RACAR指標調整而來,只關注回答評估)評估其產出,以衡量其在回答科學研究問題方面的零樣本能力。

如圖所示,在所有模型中,GPT-4 在完備性(4.90)和合理性(4.99)方面得分最高,而 Claude 3 的準確度得分最高(4.95)。 GPT-3.5 的表現也非常出色,在所有指標上的得分都緊接在 GPT-4 和 Claude 3 之後。

值得注意的是,LLaMA1 在所有三個維度上的得分都最低。相較之下,LLaMA2-chat 模型雖然得分不如 GPT 模型高,但在所有指標上都比原來的 LLaMA1 有了大幅提高。結果顯示了商用LLM在回答科學問題方面的卓越性能,同時開源模型(如 LLaMA2-chat)也在這方面取得了顯著進展。

圖示:SciQAG-24D上的零樣本測試和微調測試(LLAMA1-QA)

微調設定(fine-tuning setting)

基研究人員選擇了零樣本性能最差在SciQAG-24D的訓練集上進行微調,以獲得LLaMA1-QA。透過三個實驗,研究人員證明SciQAG-24D 可以作為有效的微調數據,提高下游科學任務的性能:

(a)LLaMA-QA與原始LLaMA1的在未見過的SciQAG-24D測試集上的表現比較。

如上圖所示,與原始 LLaMA1相比,LLaMA1-QA的性能有了顯著提高(完整性提高了13%,準確性和合理性提高了 超過30%)。這顯示LLaMA1已經從SciQAG-24D的訓練資料中學習了回答科學問題的邏輯,並內化了一些科學知識。

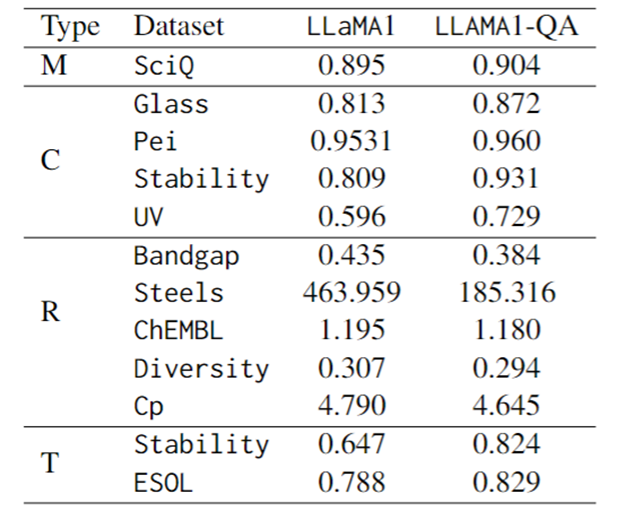

(b)在 SciQ(一個科學 MCQ 基準)上的微調表現比較。

下表的第一行顯示LLaMA1-QA比LLaMA1稍有進步(+1%)。根據觀察,微調也增強了模型的指令跟隨能力:無法解析輸出的機率從LLaMA1的 4.1%降至LLaMA1-QA的 1.7%。

(c)在多種科學任務上的微調表現比較。

評估指標上,分類任務使用F1-score,迴歸任務使用MAE,轉換任務使用KL散度。如下表所示,科學任務中LLaMA1-QA與LLaMA1模型相比有明顯改善。

最明顯的改進體現在迴歸任務中,MAE從463.96降至185.32。這些發現表明,在訓練過程中加入QA對可以增強模型學習和應用科學知識的能力,從而提高其在下游預測任務中的表現。

令人驚訝的是,與專門設計的具有特徵的機器學習模型相比,LLM 可以在某些任務中取得相當甚至超越它們的結果。例如,在帶隙任務中,雖然LLaMA1-QA 的表現不如 MODNet 等模型(0.3327),但它已經超過了AMMExpress v2020(0.4161)。

在多樣性任務中,LLaMA1-QA 的表現優於深度學習基準(0.3198)。這些研究結果表明,LLM在特定科學任務中具有巨大潛力。

圖示:LLaMA1和LLaMA1-QA在SciQ和科學任務上的微調表現(M代表多項選擇,C代表分類,R代表回歸,T代表轉換)

總結與展望 (1)SciQAG是一個從科學文獻中產生QA對的框架,結合用於評估和篩選QA對的RACAR指標,可高效地為資源匱乏的科學領域產生大量基於知識的QA數據。

(2)團隊產生了一個包含188,042個QA對的綜合開源科學QA資料集,稱為SciQAG-24D。訓練集用於微調LLM,測試集評估LLM在開放式閉卷科學QA任務上的表現。

對SciQAG-24D測試集上幾個LLM的零樣本性能進行了比較,並在SciQAG-24D訓練集上微調了LLaMA1,得到了LLaMA1-QA。這種微調顯著提高了其在多個科學任務上的表現。

(3)研究表明,LLM在科學任務中具有潛⼒,LLaMA1-QA的結果可以達到甚⾄超過機器學習基線的⽔平。這證明了SciQAG-24D的多面向效用,顯示將科學QA資料納入訓練過程可以增強LLM的學習和應用科學知識的能力。

以上是為大模型提供全新科學複雜問答基準與評估體系,UNSW、阿貢、芝加哥大學等多家機構共同推出SciQAG框架的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undress AI Tool

免費脫衣圖片

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Stock Market GPT

人工智慧支援投資研究,做出更明智的決策

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

數百萬晶體資料訓練,解決晶體學相位問題,深度學習方法PhAI登Science

Aug 08, 2024 pm 09:22 PM

數百萬晶體資料訓練,解決晶體學相位問題,深度學習方法PhAI登Science

Aug 08, 2024 pm 09:22 PM

編輯|KX時至今日,晶體學所測定的結構細節和精度,從簡單的金屬到大型膜蛋白,是任何其他方法都無法比擬的。然而,最大的挑戰——所謂的相位問題,仍然是從實驗確定的振幅中檢索相位資訊。丹麥哥本哈根大學研究人員,開發了一種解決晶體相問題的深度學習方法PhAI,利用數百萬人工晶體結構及其相應的合成衍射數據訓練的深度學習神經網絡,可以產生準確的電子密度圖。研究表明,這種基於深度學習的從頭算結構解決方案方法,可以以僅2埃的分辨率解決相位問題,該分辨率僅相當於原子分辨率可用數據的10%到20%,而傳統的從頭算方

Iyo One:是耳機,也是音訊計算機

Aug 08, 2024 am 01:03 AM

Iyo One:是耳機,也是音訊計算機

Aug 08, 2024 am 01:03 AM

任何時候,專注都是一種美德。作者|湯一濤編輯|靖宇人工智慧的再次流行,催生了新一波的硬體創新。風頭最勁的AIPin遭遇了前所未有的負評。 MarquesBrownlee(MKBHD)稱這是他評測過的最糟糕的產品;TheVerge的編輯DavidPierce則表示,他不會建議任何人購買這款設備。它的競爭對手RabbitR1也沒有好到哪裡去。對這款AI設備最大的質疑是,明明只是做一個App的事情,但Rabbit公司卻整出了一個200美元的硬體。許多人把AI硬體創新視為顛覆智慧型手機時代的機會,並投身其

生物版DeepSeek的隱秘競爭,中國模型被視為更強對手,賽諾菲10億美金押寶!

Mar 12, 2025 pm 01:18 PM

生物版DeepSeek的隱秘競爭,中國模型被視為更強對手,賽諾菲10億美金押寶!

Mar 12, 2025 pm 01:18 PM

中國AI力量領跑全球:百圖生科xTrimoV3生物大模型超越Evo2斯坦福大學與英偉達聯合發布的Evo2生物學AI模型引發熱議,然而,其論文中的一處細節卻凸顯了中國AI的崛起:百圖生科的xTrimo系列大模型被列為參數規模更大、但尚未開源的競爭對手。百圖生科,這家被美國市場視為生命科學基礎大模型先行者的公司,自2020年起便持續深耕該領域。 2024年10月,其推出的xTrimoV3全模態生物大模型,以2100億參數刷新了全球最大規模生命科學AI基礎模型的紀錄。 xTrimoV3的突破性在於其首

AI硬體再添一員!不圖取代手機,NotePin反而能活更久?

Sep 02, 2024 pm 01:40 PM

AI硬體再添一員!不圖取代手機,NotePin反而能活更久?

Sep 02, 2024 pm 01:40 PM

目前為止,AI穿戴裝置賽道還沒有任何一個產品取得特別好的成績。今年年初在MWC24橫空出世的AIPin,評樣機一經寄出,發佈時被狂吹的「AI神話」也開始破滅,短短幾個月就經歷了大規模退貨;同樣開局賣爆的RabbitR1則相對好些,但也在大批交付時受到了類似「Android套殼」的不利評價。現在,又有一家公司進入了AI穿戴裝置賽道。科技媒體TheVerge昨天發布博文,表示AI新創公司Plaud推出了一款名為NotePin產品。有別於仍在「畫餅」階段的AIFriend,NotePin目前已開始

Nature觀點,人工智慧在醫學上的測試一片混亂,該怎麼做?

Aug 22, 2024 pm 04:37 PM

Nature觀點,人工智慧在醫學上的測試一片混亂,該怎麼做?

Aug 22, 2024 pm 04:37 PM

編輯|ScienceAI基於有限的臨床數據,數百種醫療演算法已被批准。科學家們正在討論由誰來測試這些工具,以及如何最好地進行測試。 DevinSingh在急診室目睹了一名兒科患者因長時間等待救治而心臟驟停,這促使他探索AI在縮短等待時間中的應用。 Singh利用了SickKids急診室的分診數據,與同事們建立了一系列AI模型,用於提供潛在診斷和推薦測試。一項研究表明,這些模型可以加快22.3%的就診速度,將每位需要進行醫學檢查的患者的結果處理速度加快近3小時。然而,人工智慧演算法在研究中的成功只是驗證此

首個全自動科學發現AI系統,Transformer作者新創公司Sakana AI推出AI Scientist

Aug 13, 2024 pm 04:43 PM

首個全自動科學發現AI系統,Transformer作者新創公司Sakana AI推出AI Scientist

Aug 13, 2024 pm 04:43 PM

編輯|ScienceAI一年前,Google最後一位Transformer論文作者LlionJones離職創業,與前Google研究人員DavidHa共同創立人工智慧公司SakanaAI。 SakanaAI聲稱將創建一種基於自然啟發智能的新型基礎模型!現在,SakanaAI交上了自己的答案。 SakanaAI宣布推出AIScientist,這是世界上第一個用於自動化科學研究和開放式發現的AI系統!從構思、編寫程式碼、運行實驗和總結結果,到撰寫整篇論文和進行同行評審,AIScientist開啟了AI驅動的科學研究和加速

HyperOS 2.0 帶著小米 15 亮相,AI 是重點

Sep 01, 2024 pm 03:39 PM

HyperOS 2.0 帶著小米 15 亮相,AI 是重點

Sep 01, 2024 pm 03:39 PM

最近,有消息传出,小米公司将在10月推出备受期待的HyperOS2.0版本。1.HyperOS2.0预计将与小米15智能手机同步发布。HyperOS2.0将显著增强AI功能,特别是在照片和视频编辑方面。HyperOS2.0将带来更加现代和精致的用户界面(UI),提供更流畅、清晰、美观的视觉效果。HyperOS2.0的更新还包括用户界面的多项改进,如增强的多任务处理能力、改进的通知管理以及更多的主屏幕自定义选项。HyperOS2.0的发布,不仅是小米公司技术实力的展示,也是其对未来智能手机操作系统

AI在用 | 穿越了! 3款AI工具讓梵谷、莫札特們「活」在當下

Aug 14, 2024 pm 07:39 PM

AI在用 | 穿越了! 3款AI工具讓梵谷、莫札特們「活」在當下

Aug 14, 2024 pm 07:39 PM

機器之能報道編輯:楊文以大模型、AIGC為代表的人工智慧浪潮已經在悄悄改變我們生活及工作方式,但絕大部分人依然不知道該如何使用。因此,我們推出了「AI在用」專欄,透過直覺、有趣且簡潔的人工智慧使用案例,來具體介紹AI使用方法,並激發大家思考。我們也歡迎讀者投稿親自實踐的創新用例。最近,有部落客將一堆世界名人的自畫像製成了動畫,吸引了不少網友圍觀。例如,文森・梵谷略帶憂鬱地撫摸著紅色的絡腮鬍子:一副貴族氣質的莫札特擺弄起禮服:寫出《傲慢與偏見》的簡・奧斯汀坐在椅子上露出微笑:貝多芬忘我地拉著小