顛覆過往大模型評測標準,最新、最全、最權威的測評資料集 MR-Ben 來了

! 這是繼今年 4 月發布堪稱 GPT-4 + DALL-E-3 的王炸產品超強視覺語言模型 Mini-Gemini 後,港中文賈佳亞團隊再次提出的極具代表性的作品。在 MR-Ben 的「監督」下,大模型不僅要像學生一樣會答題,還要像老師那樣會閱卷,真實的推理能力無所遁形。

MR-Ben 細緻評測了許多國內外一線的開源與閉源模型,如GPT4-Turbo、Cluade3.5-Sonnet、Mistral-Large、Zhipu-GLM4、Moonshot-v1、Yi-Large、Qwen2-70Bhipu-GLM4、Moonshot-v1、Yi-Large、Qwen2-70B 、Deepseek-V2 等,並進行了詳盡的分析。

哪些看似美麗的大模型會被“卸妝”,哪個模型地表最強?目前該工作所有程式碼和資料都已開源,一起來看看!

Project Page: https://randolph-zeng.github.io/Mr-Ben.github.io/

Arxiv Page: https://arxiv.org/abs/2406.13975

Github Repo: https://github.com /dvlab-research/Mr-Ben

MR-Ben 秒破大模型「高分低能」

人工智慧領域進入GPT 時刻後,學術界和產業界共同發力,每月甚至每週都有新的模型問世。

大模型層出不窮,用什麼標準來衡量大模型的具體能力?目前的主流方向是使用人類的標準化考試——選擇題和填空題的方式去進行大模型評測。使用這套測試方式的好處有很多, 簡單來說可以分為以下幾點:

• 標準化考試易於量化和評測,標準明確,對就是對錯就是錯。

• 指標直觀,在國內高考或美國高考 SAT 裡取得怎麼樣的分數易於比較和理解。

• 量化結果自然具有主題性(如 GPT4 輕鬆通過美國律師認證資格考試極為吸引眼球)。

但如果深究大模型的訓練方式,就會發現這種逐步作答的思維鏈方式產生最終答案,並不「可靠」。

問題正是出現在逐步作答的流程上!

預訓練模型在預訓練時早已見過數以萬億級別的詞元,很難說被評測的模型是否早已見過相應的數據,從而通過“背題”的方式回答正確。而在分步作答的時候,模型是否是基於正確的理解推理選出正確的選項,我們不得而知,因為評測的方式主要靠檢查最終的答案。

儘管學術界不斷地對諸如GSM8K、MMLU 等數據集進行升級改造,如在GSM8K 上引入多語言版本的MGSM 數據集,在MMLU 的基礎上引入更難的題目等,依然無法擺脫選擇或填空的窠臼。

並且,這些資料集都已面臨著嚴重的飽和問題,大語言模型在這些指標上的數值已經見頂,並逐漸喪失了區分度。

為此,賈佳亞團隊聯合 MIT、清華、劍橋等多家知名高校,與國內頭部標註公司合作,標註了一個針對複雜問題推理過程的評測數據集 MR-Ben。

MR-Ben 基於GSM8K、MMLU、LogiQA、MHPP 等大模型預訓練必測資料集的題目,進行了「閱卷式」的範式改造,產生的新資料集更難、更有區分度,更能真實地反映模型推理能力!

而賈佳亞團隊這次的工作也針對現存評測痛點進行了針對性的改進:

不是害怕資料外洩導致的大模型背題導致分數虛高嗎?不用重新找題出卷,也不用把題目變形來測試模型的穩健性,MR-Ben 直接讓模型從答題者的學生身份,轉變為對答題過程的“閱卷”模式,讓大模型當老師來測試它對知識點的掌握情況!

不是擔心模型對解題過程毫無知覺,有可能出現「幻覺」或錯誤的理解,蒙對答案嗎? MR-Ben 直接招募一批高水準的碩博標註者,對大量題目的解題過程進行精心標註。把解題過程是否正確,出錯的位置,出錯的原因都細緻指出,比對大模型的閱卷結果和人類專家的閱卷結果來測試模型的知識點掌握情況。

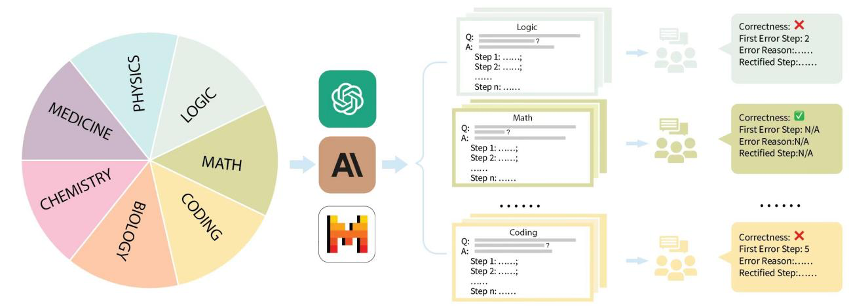

具體來說,賈佳亞團隊針對市面上主流的評測資料集GSM8K、MMLU、LogiQA、MHPP 等資料集進行整理,並分成了數理化生、程式碼、邏輯、醫藥等多個類別,同時區分了不同的難度等級。針對每個類別、收集到的每個問題,團隊精心收集了對應的逐步解題過程,並經由專業的碩博標註者進行培訓和標註。

MR-Ben資料集的建構流程表現最佳大模型是它?

Seterusnya, mari gabungkan contoh khusus yang diberikan dalam kerja MR-Ben untuk melihat mengapa kaedah langkah demi langkah menjana jawapan akhir dan penilaian berkaitan tidak boleh dipercayai.

Sebagai model "penggredan" yang dinilai, GPT4-Turbo tidak menjumpai ralat pengiraan yang tersembunyi dalam langkah kedua:

E.1 Matematik

Subjek: Matematik Sekolah Menengah

Soalan: Manakah nombor terkecil dibahagikan dengan4 integer baki 1, baki 2 apabila dibahagikan dengan 3, baki 2 apabila dibahagikan dengan 5?

Pilihan: [A] 67 [B] 43 [C] 57 [D] 37

Jawapan: D

Model Persampelan: Claude2

Langkah Penyelesaian Model:

- Semak bila pilihanLangkah 1 Apabila 67 dibahagikan dengan 4, bakinya ialah 3, bukan 1. Jadi 67 bukan jawapan yang betul.

- Langkah 2: Semak pilihan B (43) Apabila 43 dibahagikan dengan 4, bakinya ialah 1. Apabila 43 dibahagikan dengan 3, bakinya ialah 3, bukan 2. Jadi 43 bukan jawapan yang betul.

- Langkah 3: Semak pilihan C (57) Apabila 57 dibahagikan dengan 4, bakinya ialah 1. Apabila 57 dibahagikan dengan 3, bakinya ialah 0, bukan 2. Jadi 57 bukan jawapan yang betul.

- Langkah 4: Semak pilihan D (37) Apabila 37 dibahagikan dengan 4, bakinya ialah 1. Apabila 37 dibahagikan dengan 3, bakinya ialah 1. Apabila 37 dibahagikan dengan 5, bakinya ialah 2.

-

Langkah 5: Pilihan D (37) memenuhi semua syarat dan merupakan jawapan yang betul.

Jawapan: Pilihan D

Anotasi manusia

Ketepatan jawapan model: Salah

Langkah salah pertama: Langkah 2

Alasan ralat jawapan model:

Dalam langkah 2, model tersalah mengira bahawa baki 4 ialah 43 daripada 3. Model mengandaikan bahawa apabila 43 dibahagikan dengan 4 bakinya ialah 1, tetapi bakinya hendaklah 3. Terdapat ralat pengiraan di sini.

Langkah pertama yang betul selepas pembetulan: Langkah 2

Apabila 43 dibahagi dengan 4, bakinya ialah 1. Apabila 43 dibahagikan dengan 3, bakinya ialah 1. Apabila 43 dibahagikan dengan 5, bakinya ialah 3, bukan 2. Oleh itu, 43 bukanlah jawapan yang betul.

Model penilaian: gpt-4-turbo

Balasan model:

-Langkah 1: Langkah semak baki 67 dibahagikan dengan 4 dan 3, dan mendapati ia memenuhi syarat dibahagikan dengan 4 dan baki 3, iaitu pengesahan yang betul.

-Langkah 2: Semak baki pembahagian 43 dengan 4, 3, dan 5, dan dapatkan baki 1, 3, dan 5 dengan betul sepadan dengan jangkaan, kecuali baki 5 tidak memenuhi syarat.

-Langkah 3: Langkah Kira baki pembahagian 57 dengan 4 dan 3, bakinya ialah 1 dan 0 masing-masing. Apabila 57 dibahagikan dengan 3 bakinya tidak memenuhi kriteria.

-Langkah 4: Semak dan sahkan baki pembahagian 37 dengan 4, 3, dan 5. Didapati semua baki yang dijangkakan adalah tepat, dan 37 memenuhi semua syarat dalam soalan.

Adakah proses penyelesaian betul? , penilaian Kaedah model bahasa diubah menjadi membenarkan model "menandai" proses jawapan, menilai sama ada ia betul atau salah, dan menunjukkan lokasi dan punca ralat. Ketepatan proses penyelesaian dan potensi lokasi ralat boleh dikira dengan membandingkan dengan hasil anotasi. Penilaian langkah dan sebab ralat model boleh diserahkan kepada GPT4 untuk menentukan sama ada model itu betul dengan membandingkan penjelasan sebab ralat yang diberikan oleh annotator dan penjelasan sebab ralat model.

Daripada kaedah penilaian, kaedah yang dicadangkan oleh MR-Ben memerlukan model untuk menjalankan analisis terperinci premis, andaian, dan logik setiap langkah dalam proses penyelesaian masalah, dan untuk melihat proses penaakulan untuk menentukan sama ada langkah semasa boleh menuju ke arah yang betul. fenye1. Kaedah penilaian "penggredan" ini jauh lebih sukar daripada kaedah penilaian hanya menjawab soalan, tetapi ia boleh mengelakkan masalah skor tinggi palsu yang disebabkan oleh hafalan soalan model. Sukar untuk pelajar yang hanya boleh menghafal soalan untuk menjadi guru pemarkahan yang berkelayakan.

Kedua, MR-Ben telah mencapai sejumlah besar anotasi berkualiti tinggi dengan menggunakan kawalan proses anotasi manual dan tepat, dan reka bentuk proses yang bijak membolehkan kaedah penilaian diukur secara intuitif.

Pasukan Jiajiaya juga menguji sepuluh teratas model bahasa yang paling mewakili dan versi yang berbeza. Dapat dilihat bahawa antara model bahasa besar sumber tertutup, GPT4-Turbo mempunyai prestasi terbaik (walaupun tiada ralat pengiraan ditemui semasa "penggredan" dalam kebanyakan subjek, terdapat demo (k=1) dan tiada demo. (k=0) mendahului model lain.

**Hasil penilaian beberapa model bahasa besar sumber terbuka pada set data MR-Ben

Dapat dilihat bahawa kesan beberapa model bahasa besar sumber terbuka terkuat telah mengikuti beberapa model komersial, malah sumber tertutup terkuat model berada dalam MR-Ben Prestasi pada set data Ben masih belum tepu, dan perbezaan antara model yang berbeza adalah besar.

Selain itu, terdapat lebih banyak analisis dan penemuan yang menarik dalam kertas asal MR-Ben, seperti:

Model sumber terbuka yang dikeluarkan oleh Qwen dan Deepseek tidak kalah dengan model sumber tertutup PK walaupun dalam eselon global.

Strategi harga dan prestasi sebenar model sumber tertutup yang berbeza adalah menarik. Rakan yang mengambil berat tentang keupayaan penaakulan dalam senario penggunaan boleh mencari model kegemaran mereka untuk digunakan berdasarkan harga dan keupayaan.

Dalam senario sumber rendah, model kecil juga mempunyai banyak sorotan Dalam penilaian MR-Ben, Phi-3-mini menonjol di kalangan model kecil, malah lebih tinggi daripada atau sama dengan model besar dengan berpuluh bilion parameter, menunjukkan. keupayaan untuk memperhalusi kepentingan data.

Adegan MR-Ben mengandungi analisis logik yang kompleks dan inferens langkah demi langkah yang terlalu panjang dalam mod Sedikit tangkapan akan mengelirukan model dan menyebabkan penurunan prestasi. . jelas. Sebaliknya, untuk model peringkat pertengahan, kesannya bertambah baik sedikit kerana yang salah sentiasa diperbetulkan dan yang betul dibetulkan.

Selepas membahagikan secara kasar subjek yang dinilai oleh MR-Ben kepada jenis berasaskan pengetahuan, logik, pengiraan dan algoritma, model yang berbeza mempunyai kelebihan dan kekurangan mereka sendiri dalam jenis penaakulan yang berbeza.

Pasukan Jiajiaya telah memuat naik kaedah penilaian satu klik pada github Semua rakan kongsi yang mengambil berat tentang penaakulan yang kompleks dialu-alukan untuk menilai dan menyerahkan model mereka sendiri.

Dengan cara ini, penilaian satu klik menggunakan skrip rasmi hanya menelan kos kira-kira 12 juta token Proses ini sangat lancar, jadi cubalah!

Rujukan

Melatih Pengesah untuk Menyelesaikan Masalah Perkataan Matematik (https://arxiv.org/abs/2110.14168)

Mengukur Pemahaman Bahasa Berbilang Tugas Besar-besaran (https://arxiv.org/abs/2009.03)

Q3A. Set Data untuk Pemahaman Pembacaan Mesin dengan Penaakulan Logik(https://arxiv.org/abs/2007.08124)

MHPP: Meneroka Keupayaan dan Had Model Bahasa Melangkaui Penjanaan Kod Asas(https://arxiv.org/abs/2405.11430 Percikan Kecerdasan Am Buatan: Percubaan awal dengan GPT-4(https://arxiv.org/abs/2303.12712)

Laporan Teknikal Qwen(https://arxiv.org/abs/2309.16609)

DeepSeek-V2: A Strong, Model Bahasa Campuran Pakar yang Jimat dan Cekap(https://arxiv.org/abs/2405.04434)

Buku Teks Sahaja Anda Perlu(https://arxiv.org/abs/2306.11644)

Model Bahasa Sendiri Tidak Boleh Penaakulan Yang Betul(https://arxiv.org/abs/2310.01798)

以上是賈佳亞團隊聯手劍橋清華等共推評測新範式 一秒偵察大模型'高分低能”的詳細內容。更多資訊請關注PHP中文網其他相關文章!