假如你有閒置的設備,或許可以試試看。

這次,你手上的硬體設備也能在 AI 領域大展拳腳了。

將 iPhone、iPad、Macbook 進行組合,就能組裝成「異質集群推理方案」, 然後順暢的運行 Llama3 模型。

值得一提的是,這個異質叢集可以是 Windows 系統,也可以是Linux、iOS 系統,並且對 Android 的支援很快就會到來。

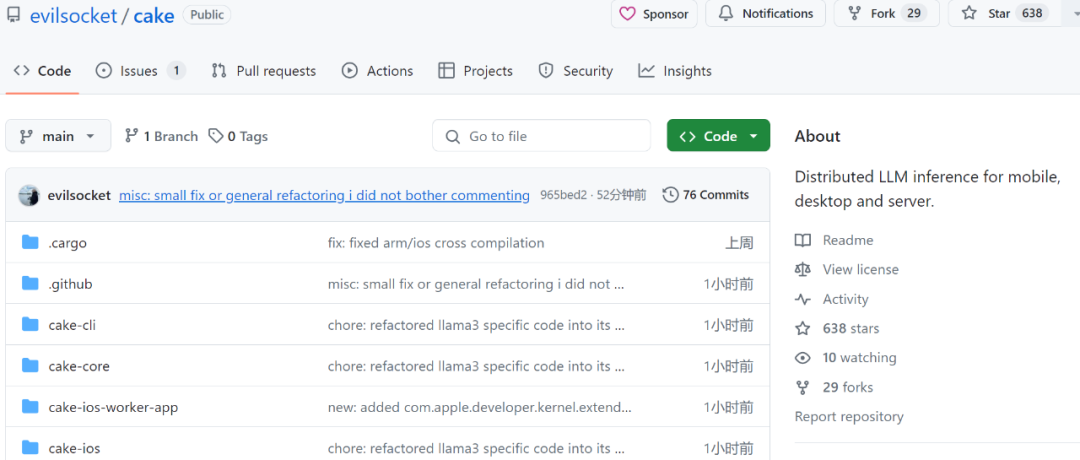

根據專案作者 @evilsocket 的介紹,這個異質叢集包括 iPhone 15 Pro Max、iPad Pro、MacBook Pro (M1 Max)、NVIDIA GeForce 3080、2x NVIDIA Titan X Pascal。所有程式碼都已經上傳到 GitHub。

看到這,網友紛紛表示,這位老哥確實不簡單。

不過也有網友開始擔心能耗問題,暫且不管速度,電費都耗不起。來回搬數據,損耗太大了。

專案介紹

上述功能的實現,離不開一個名為 Cake 的 Rust 框架。 Cake 可以完成大型模型(例如Llama3)的分散式推理,旨在將消費級硬體組合成異質集群,其中消費級硬體採用多種作業系統,包括:iOS、Android、macOS、Linux 和Windows,從而使AI 更易於存取。

項目位址:https://github.com/evilsocket/cake

Cake 的主要思路是將transformer 區塊分片到多個設備,以便能夠讓通常不適合單一設備GPU 記憶體的模型運行推理。對同一工作執行緒上的連續 transformer 區塊的推理是分批進行的,以便最大限度地減少資料傳輸造成的延遲。

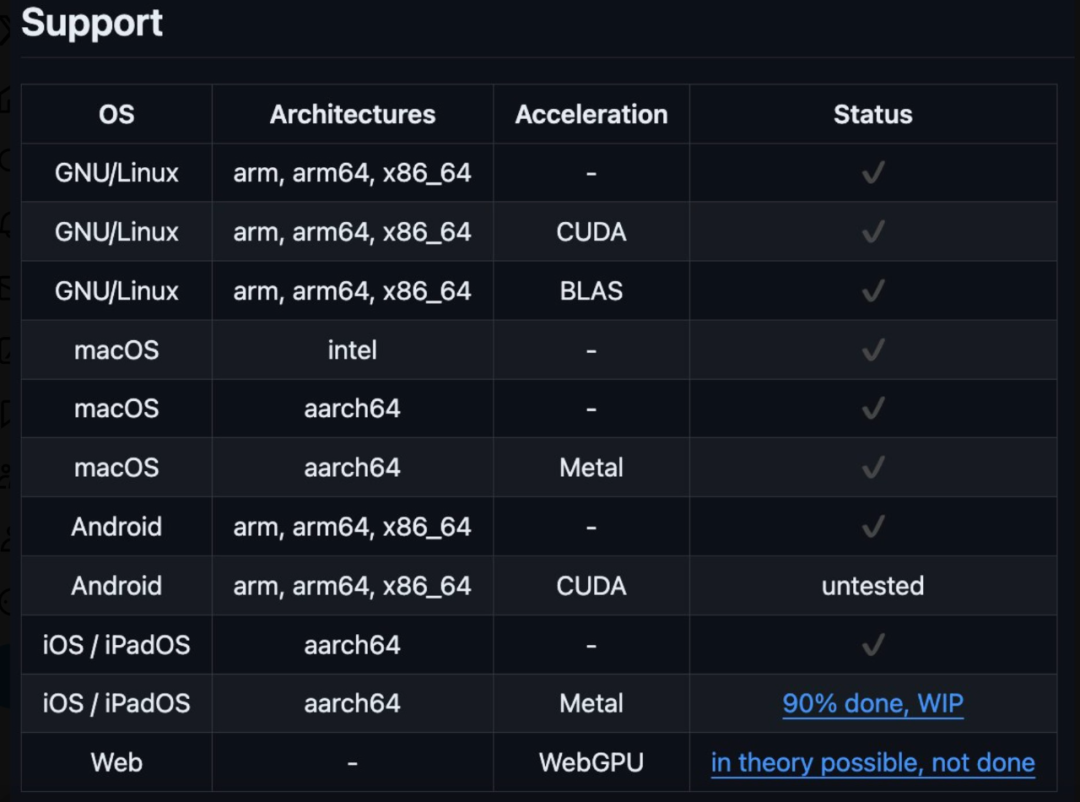

Cake 目前支援的系統和裝置如下:

編譯

安裝Rust 後,執行下列程式碼:

cargo build --release

make ios

運行worker 節點:

cake-cli --model /path/to/Meta-Llama-3-8B \ # model path, read below on how to optimize model size for workers --mode worker \# run as worker --name worker0 \ # worker name in topology file --topology topology.yml \# topology --address 0.0.0.0:10128 # bind address

cake-cli --model /path/to/Meta-Llama-3-8B \ --topology topology.yml

以上是太酷了! iPhone、iPad、MacBook老舊設備組成異質集群,能跑Llama 3的詳細內容。更多資訊請關注PHP中文網其他相關文章!