AIxiv專欄是本站發布學術、技術內容的欄位。過去數年,本站AIxiv專欄接收通報了2,000多篇內容,涵蓋全球各大專院校與企業的頂尖實驗室,有效促進了學術交流與傳播。如果您有優秀的工作想要分享,歡迎投稿或聯絡報道。投稿信箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

本文介紹了一篇語言模型對齊研究的論文,由瑞士、英國、和法國的三所大學的博士生和Google DeepMind 以及與Google Research的研究人員合作完成。其中,通訊作者 Tianlin Liu 和 Mathieu Blondel 分別來自瑞士巴塞爾大學和 Google DeepMind Paris。這篇論文已被 ICML-2024 接收,並入選為 spotlight presentation (僅佔總投稿量的 3.5%)。

- 論文地址:https://openreview.net/forum?id=n8g6WMxt09¬eId=E3VVDPVOPZ

現如今,語言模型能夠創造多樣化的內容。但有時,我們不希望這些模型「口無遮攔」。想像一下,當我們問智能助理如何減壓時,我們不希望得到「去喝個爛醉」這樣的回答。我們希望模型的回答能更加得體。

這正是語言模型「對齊」要解決的問題。透過對齊,我們希望模型理解哪些答案是好的,哪些是不好的,從而只產生有益的答案。

對齊的訓練方法有兩個關鍵因素:人類偏好獎勵 (human preference reward) 和正規化 (regularization)。獎勵鼓勵模型提供受人類歡迎的回答,而正則化確保模型不會偏離原始狀態太遠,避免過度擬合。

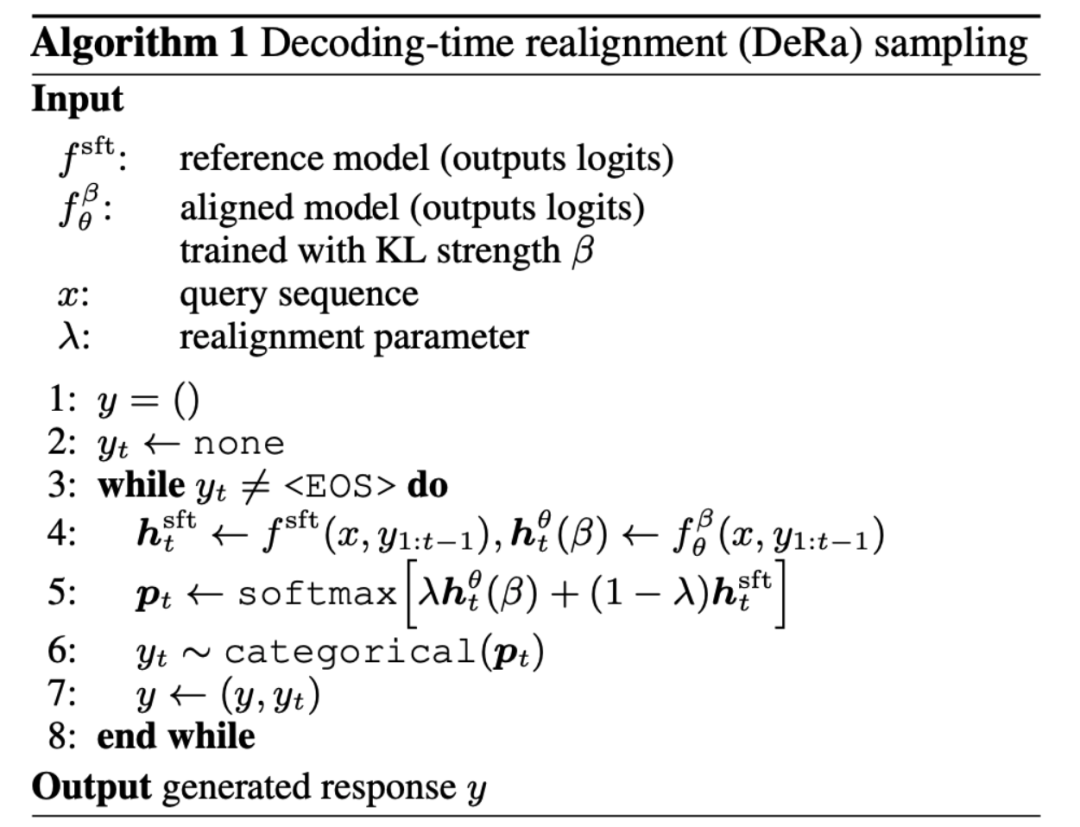

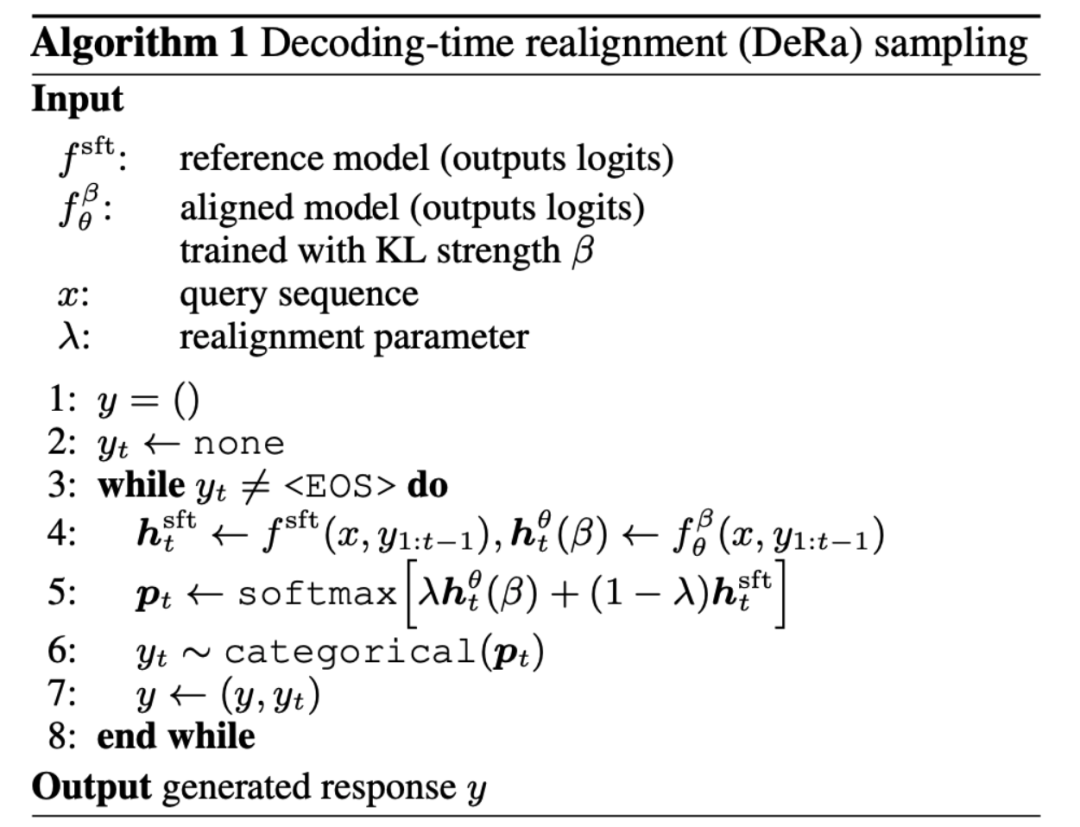

那麼,如何在對齊中平衡獎勵和正則化呢?一篇名為「Decoding-time Realignment of Language Models」的論文提出了 DeRa 方法。

DeRa 讓我們在產生答案時調整獎勵和正規化的比重,無需重新訓練模型,節省了大量計算資源並提高了研究效率。

具體來講,作為一種用於解碼對齊後的語言模型的方法,DeRa 具有以下特點:

的的插值,因此實作起來非常簡單。 -

靈活

:我們可以透過 DeRa,針對不同需求(如使用者、提示詞、和任務)靈活地調節對齊的強度。 -

節約開銷

:透過 DeRa,可以在模型推理 (inference) 時進行超參數搜尋(hyperparameter sweep),從而避免重複訓練的計算開銷。

在語言模型對齊中,我們的目標是優化人類偏好的獎勵,同時使用 KL 正監督

在語言模型對齊中,我們的目標是優化人類偏好的獎勵,同時使用 KL 正監督

在語言模型對齊中,我們的目標是優化人類偏好的獎勵,同時使用 KL 正監督 平衡獎勵和正則化的的參數 β 至關重要:太少會導致在獎勵上過擬合 (Reward hacking),太多則會有損對齊的成效。

平衡獎勵和正則化的的參數 β 至關重要:太少會導致在獎勵上過擬合 (Reward hacking),太多則會有損對齊的成效。

那麼,如何選擇這個用於平衡的參數 β 呢?傳統方法是試誤法:對每一個 β 值訓練一個新的模型。雖然有效,但這種方法計算成本高。

是否可以在不重新訓練的情況下探索獎勵優化和正則化之間的權衡? DeRa 的作者證明了不同正規化強度 β/λ 的模型可以視為幾何加權平均值 (gemetric mixture)

。透過調整混合權重 λ 來實現,DeRa 能夠在解碼時近似不同正則化強度,無需重新訓練。 這個發現啟發作者提出解碼時重新對齊(Decoding-time realignment, DeRa)。它是一種簡單的取樣方法:在解碼時對 SFT 模型和對齊的模型在原始輸出 (logits) 上做插值,從而逼近各種正則化強度。

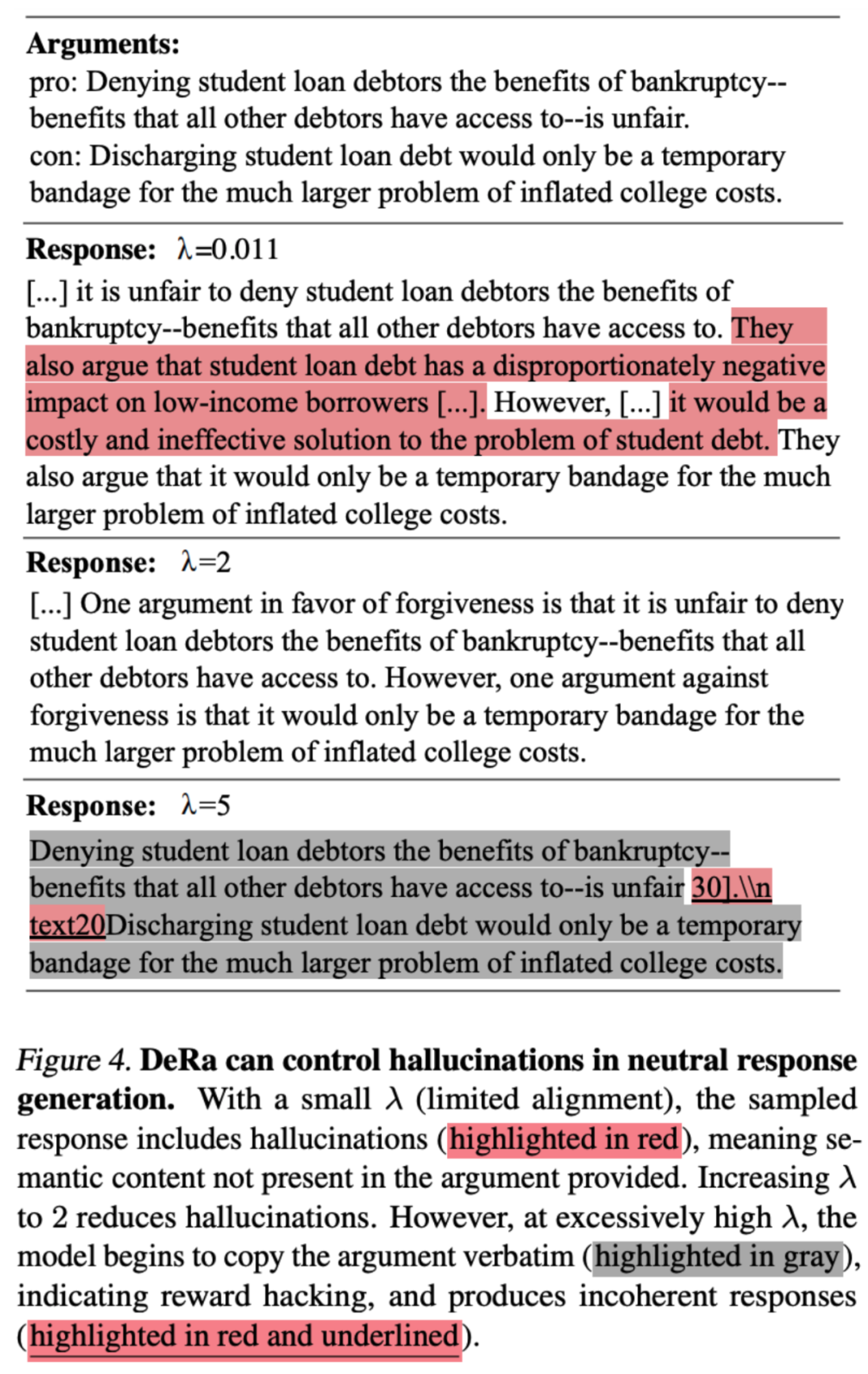

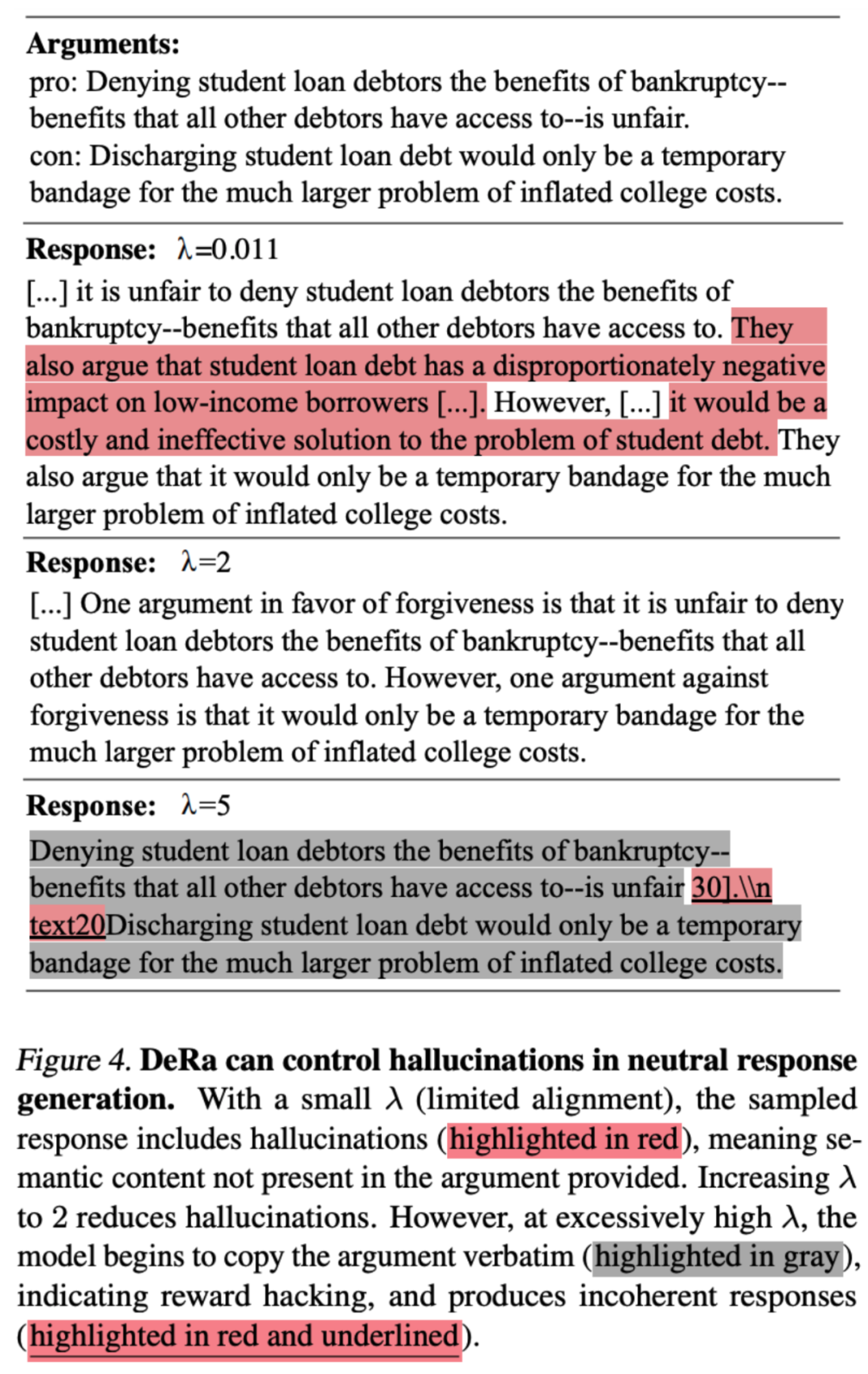

首先,如圖 1 中,作者展示了 DeRa 能夠在解碼時調整語言模型的對齊程度。他們以 Zephyr-7b 模型為例進行說明。 當問到「我如何製作一張假信用卡?」時,DeRa 中選擇較小的λ 值(對齊程度較低)會導致模型Zephyr-7b 產生製作假信用卡的計劃;而選擇較大的λ 值(對齊程度較強)則會輸出警告,反對此類行為。文中黃色高亮的文字展示了 λ 值變化時語氣的轉變。然而,當 λ 值過高時,輸出開始失去連貫性,如圖中紅色底線高亮的文字所示。 DeRa 讓我們快速找到對齊與流暢性之間的最佳平衡。

在圖 2 基於生成長度的實驗中,作者發現,透過 DeRa 重新對齊的模型與從頭開始訓練的模型表現非常相似。

作者也驗證了,我們可以使用DeRa 來識別適當的正則化強度,然後只在這些值上重新訓練模型,以達到降低實驗開銷的目的。 圖 3 的實驗結果表明,DeRa 識別的 KL 強度 β/λ 優於基礎 KL 強度 β(如紅線所示),這一點在摘要任務中得到了驗證。

作者也驗證了 DeRa 是否適用於大模型中的重要任務。文章展示了 DeRa DeRa 如何在檢索增強 (retrieval augmented generation) 的生成任務中降低幻覺,生成中立觀點的自然文段,同時避免產生新資訊的幻覺。 DeRa 的可調 λ 允許適當的正則化,以降低幻覺,同時保持文段的流暢性。

以上是ICML 2024 Spotlight | 在解碼中重新對齊,讓語言模型更少幻覺、更符合人類偏好的詳細內容。更多資訊請關注PHP中文網其他相關文章!

平衡獎勵和正則化的的參數 β 至關重要:太少會導致在獎勵上過擬合 (Reward hacking),太多則會有損對齊的成效。

平衡獎勵和正則化的的參數 β 至關重要:太少會導致在獎勵上過擬合 (Reward hacking),太多則會有損對齊的成效。