abstract:一、CAS和synchronized适用场景1、对于资源竞争较少的情况,使用synchronized同步锁进行线程阻塞和唤醒切换以及用户态内核态间的切换操作额外浪费消耗cpu资源;而CAS基于硬件实现,不需要进入内核,不需要切换线程,操作自旋几率较少,因此可以获得更高的性能。2、对于资源竞争严重的情况,CAS自旋的概率会比较大,从而浪费更多的CPU资源,效率低于synchronized。以java

一、CAS和synchronized适用场景

1、对于资源竞争较少的情况,使用synchronized同步锁进行线程阻塞和唤醒切换以及用户态内核态间的切换操作额外浪费消耗cpu资源;而CAS基于硬件实现,不需要进入内核,不需要切换线程,操作自旋几率较少,因此可以获得更高的性能。

2、对于资源竞争严重的情况,CAS自旋的概率会比较大,从而浪费更多的CPU资源,效率低于synchronized。以java.util.concurrent.atomic包中AtomicInteger类为例,其getAndIncrement()方法实现如下:

public final int getAndIncrement() {

for (;;) {

int current = get();

int next = current + 1;

if (compareAndSet(current, next))

return current;

}

}如果compareAndSet(current, next)方法成功执行,则直接返回;如果线程竞争激烈,导致compareAndSet(current, next)方法一直不能成功执行,则会一直循环等待,直到耗尽cpu分配给该线程的时间片,从而大幅降低效率。

二、CAS错误的使用场景

public class CASDemo {

private final int THREAD_NUM = 1000;

private final int MAX_VALUE = 20000000;

private AtomicInteger casI = new AtomicInteger(0);

private int syncI = 0;

private String path = "/Users/pingping/DataCenter/Books/Linux/Linux常用命令详解.txt";

public void casAdd() throws InterruptedException {

long begin = System.currentTimeMillis();

Thread[] threads = new Thread[THREAD_NUM];

for (int i = 0; i < THREAD_NUM; i++) {

threads[i] = new Thread(new Runnable() {

public void run() {

while (casI.get() < MAX_VALUE) {

casI.getAndIncrement();

}

}

});

threads[i].start();

}

for (int j = 0; j < THREAD_NUM; j++) {

threads[j].join();

}

System.out.println("CAS costs time: " + (System.currentTimeMillis() - begin));

}

public void syncAdd() throws InterruptedException {

long begin = System.currentTimeMillis();

Thread[] threads = new Thread[THREAD_NUM];

for (int i = 0; i < THREAD_NUM; i++) {

threads[i] = new Thread(new Runnable() {

public void run() {

while (syncI < MAX_VALUE) {

synchronized ("syncI") {

++syncI;

}

}

}

});

threads[i].start();

}

for (int j = 0; j < THREAD_NUM; j++)

threads[j].join();

System.out.println("sync costs time: " + (System.currentTimeMillis() - begin));

}

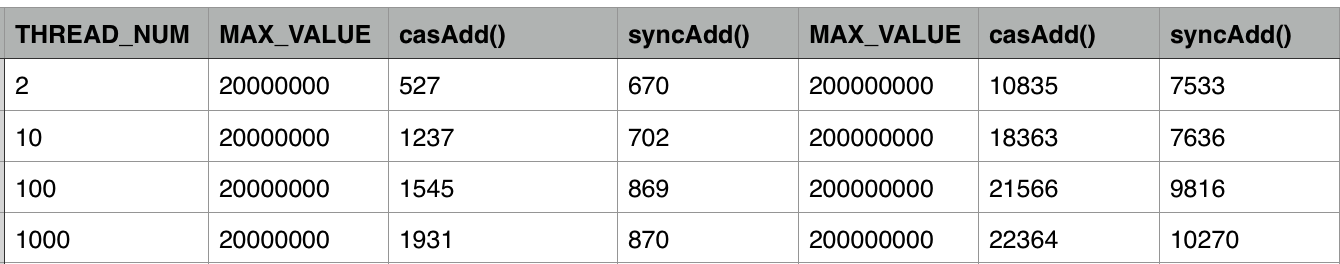

}在我的双核cpu上运行,结果如下:

可见在不同的线程下,采用CAS计算消耗的时间远多于使用synchronized方式。原因在于第15行

14 while (casI.get() < MAX_VALUE) {

15 casI.getAndIncrement();

16 }

的操作是一个耗时非常少的操作,15行执行完之后会立刻进入循环,继续执行,从而导致线程冲突严重。

三、改进的CAS使用场景

为了解决上述问题,只需要让每一次循环执行的时间变长,即可以大幅减少线程冲突。修改代码如下:

public class CASDemo {

private final int THREAD_NUM = 1000;

private final int MAX_VALUE = 1000;

private AtomicInteger casI = new AtomicInteger(0);

private int syncI = 0;

private String path = "/Users/pingping/DataCenter/Books/Linux/Linux常用命令详解.txt";

public void casAdd2() throws InterruptedException {

long begin = System.currentTimeMillis();

Thread[] threads = new Thread[THREAD_NUM];

for (int i = 0; i < THREAD_NUM; i++) {

threads[i] = new Thread(new Runnable() {

public void run() {

while (casI.get() < MAX_VALUE) {

casI.getAndIncrement();

try (InputStream in = new FileInputStream(new File(path))) {

while (in.read() != -1);

} catch (IOException e) {

e.printStackTrace();

}

}

}

});

threads[i].start();

}

for (int j = 0; j < THREAD_NUM; j++)

threads[j].join();

System.out.println("CAS Random costs time: " + (System.currentTimeMillis() - begin));

}

public void syncAdd2() throws InterruptedException {

long begin = System.currentTimeMillis();

Thread[] threads = new Thread[THREAD_NUM];

for (int i = 0; i < THREAD_NUM; i++) {

threads[i] = new Thread(new Runnable() {

public void run() {

while (syncI < MAX_VALUE) {

synchronized ("syncI") {

++syncI;

}

try (InputStream in = new FileInputStream(new File(path))) {

while (in.read() != -1);

} catch (IOException e) {

e.printStackTrace();

}

}

}

});

threads[i].start();

}

for (int j = 0; j < THREAD_NUM; j++)

threads[j].join();

System.out.println("sync costs time: " + (System.currentTimeMillis() - begin));

}

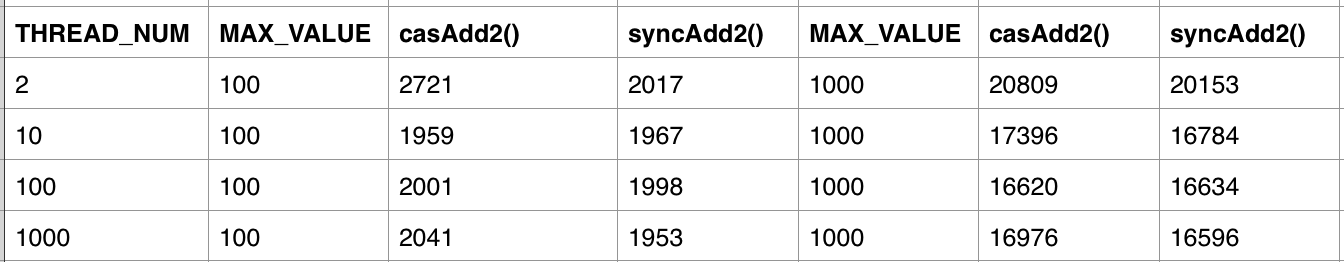

}在while循环中,增加了一个读取文件内容的操作,该操作大概需要耗时40ms,从而可以减少线程冲突。测试结果如下:

可见在资源冲突比较小的情况下,采用CAS方式和synchronized同步效率差不多。为什么CAS相比synchronized没有获得更高的性能呢?

测试使用的jdk为1.7,而从jdk1.6开始,对锁的实现引入了大量的优化,如锁粗化(Lock Coarsening)、锁消除(Lock Elimination)、轻量级锁(Lightweight Locking)、偏向锁(Biased Locking)、适应性自旋(Adaptive Spinning)等技术来减少锁操作的开销。而其中自旋锁的原理,类似于CAS自旋,甚至比CAS自旋更为优化。

四、总结

1、使用CAS在线程冲突严重时,会大幅降低程序性能;CAS只适合于线程冲突较少的情况使用。

2、synchronized在jdk1.6之后,已经改进优化。synchronized的底层实现主要依靠Lock-Free的队列,基本思路是自旋后阻塞,竞争切换后继续竞争锁,稍微牺牲了公平性,但获得了高吞吐量。在线程冲突较少的情况下,可以获得和CAS类似的性能;而线程冲突严重的情况下,性能远高于CAS。