.

Bermula pada 32k, 100k adalah perkara biasa hari ini. Adakah ini sengaja meninggalkan ruang untuk sumbangan kepada komuniti sumber terbuka? Komuniti sumber terbuka pastinya tidak melepaskan peluang ini:

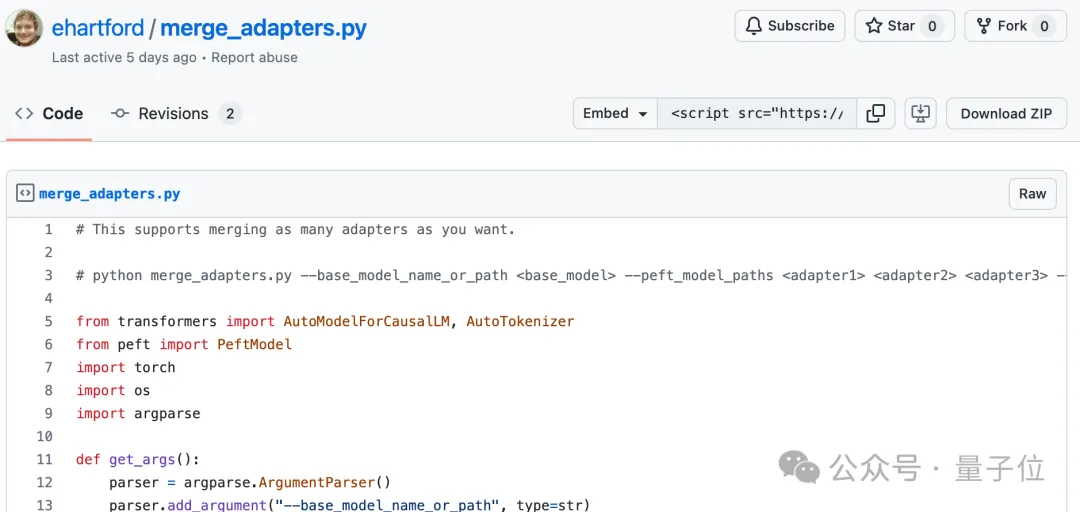

Kini dengan hanya 58 baris kod, mana-mana versi Llama 3 70b yang diperhalusi boleh berskala secara automatik kepada 1048k (satu juta)

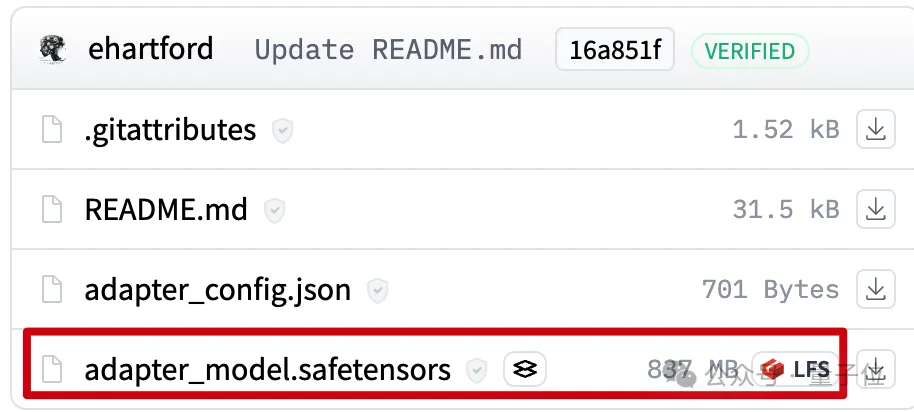

konteks.Di belakang ialah LoRA, diekstrak daripada versi Llama 3 70B Instruct yang diperhalusi yang memanjangkan konteks yang baik, Fail hanya 800mb

.

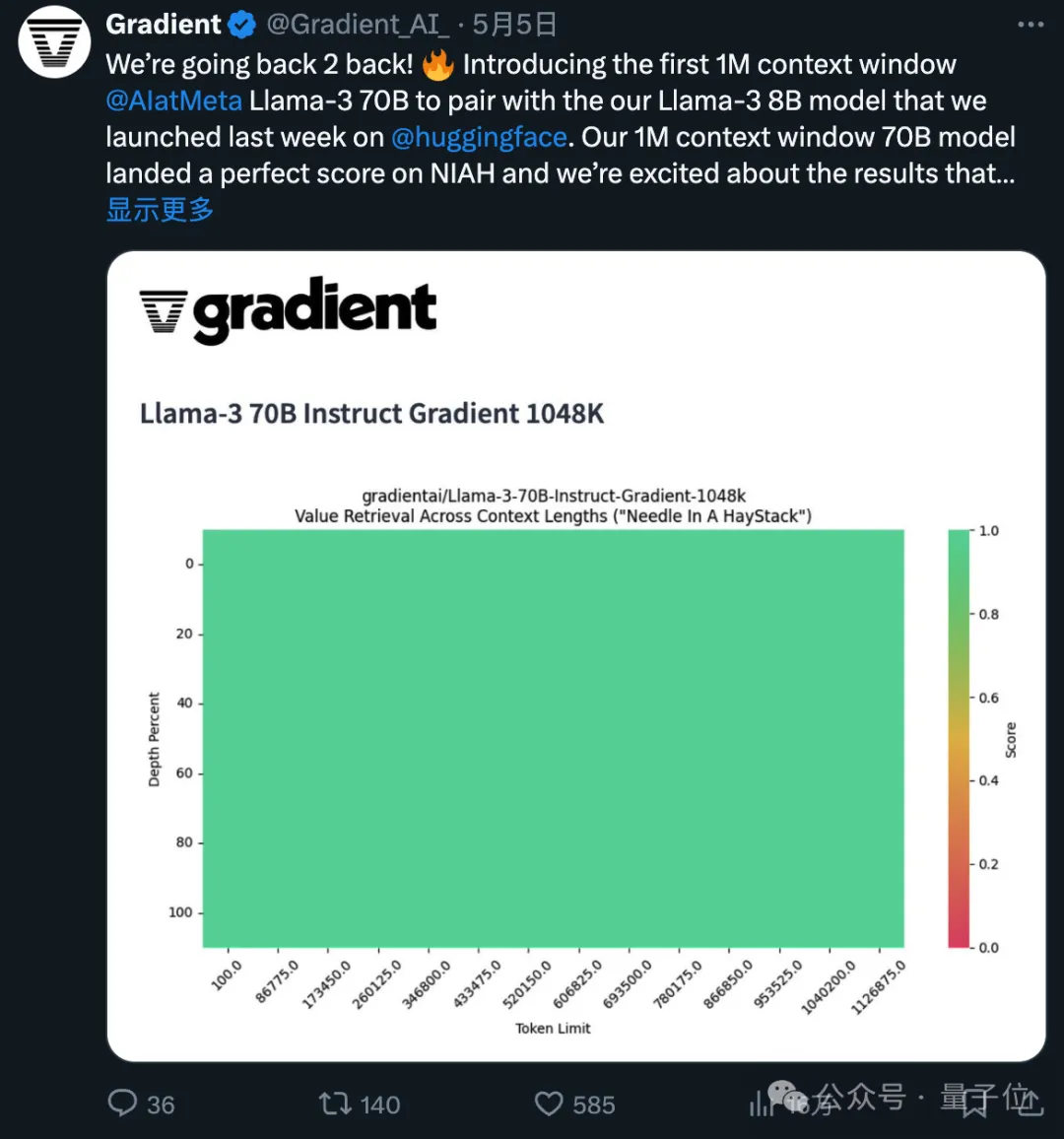

Versi yang diperhalusi bagi konteks 1048k yang digunakan baru sahaja mencapai markah hijau (100% ketepatan) dalam ujian jarum dalam timbunan jerami yang popular.

Saya harus mengatakan bahawa kelajuan kemajuan sumber terbuka adalah eksponen. .

Saya harus mengatakan bahawa kelajuan kemajuan sumber terbuka adalah eksponen. .

LoRA yang sepadan datang daripada pembangun

LoRA yang sepadan datang daripada pembangun

Eric Hartford

Dengan membandingkan perbezaan antara model yang diperhalusi dan versi asal, perubahan parameter diekstrak.

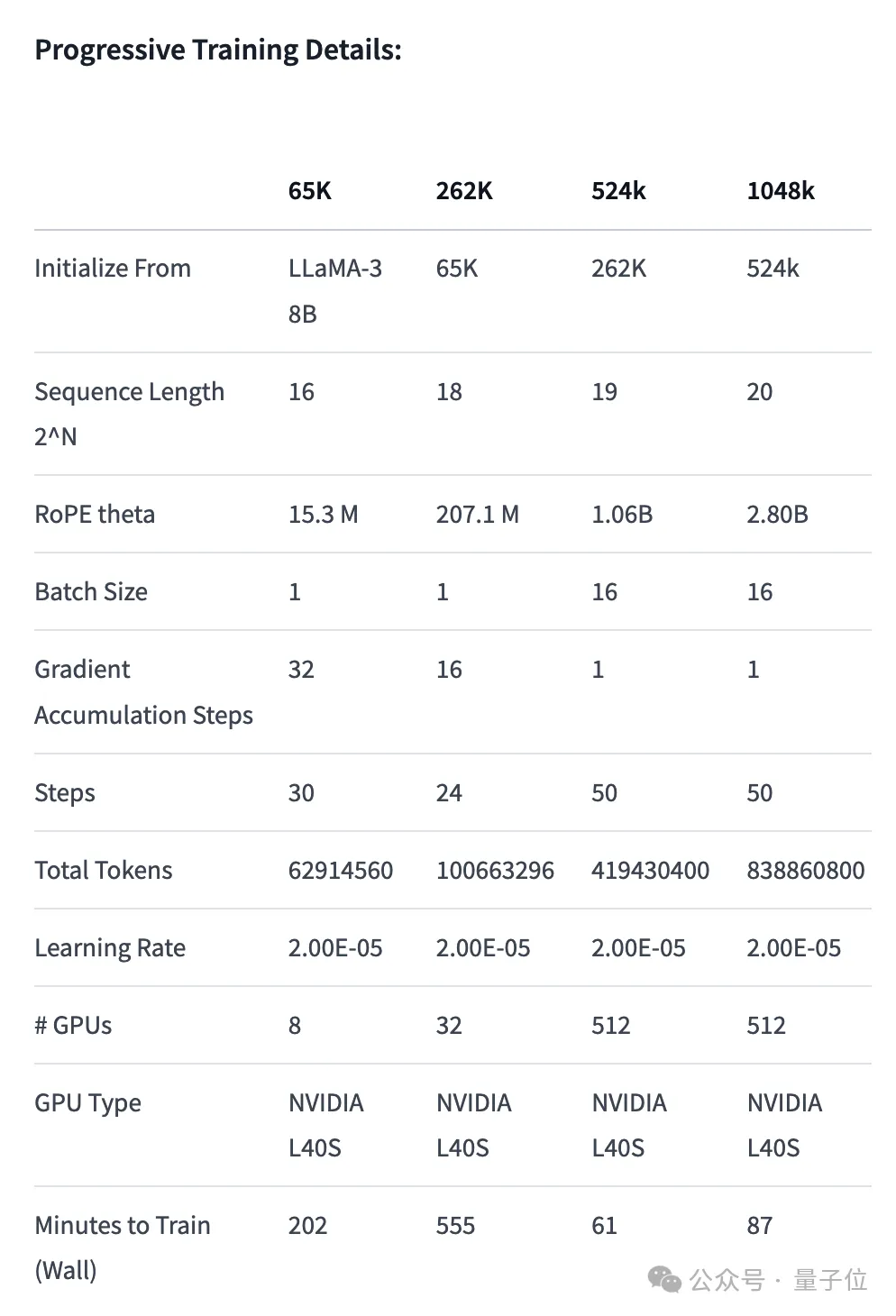

Pertama sekali, pasukan Gradient meneruskan latihan berdasarkan Llama 3 70B Instruct asal dan memperoleh Llama-3-70B-Instruct-Gradient-1048k. Kaedah khusus adalah seperti berikut:

Laraskan pengekodan kedudukan: Gunakan interpolasi sedar NTK untuk memulakan penjadualan optimum RoPE theta dan mengoptimumkannya untuk mengelakkan kehilangan maklumat lanjutan frekuensi tinggi length

Latihan Progresif:

Latihan Progresif:

Versi 524k LoRA: https://huggingface.co/cognitivecomputations/Llama-3-70B-Gradient-524k-adapter

1048k versi LoRA: https:/cohugging cognitivecomputations/Llama-3-70B-Gradient-1048k-adapter

Gabung kod: https://gist.github.com/ehartford/731e3f7079db234fa1b98a09

Atas ialah kandungan terperinci 58 baris skala kod Llama 3 hingga 1 juta konteks, mana-mana versi yang diperhalusi boleh digunakan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Bina pelayan git anda sendiri

Bina pelayan git anda sendiri

Perbezaan antara git dan svn

Perbezaan antara git dan svn

git undo menyerahkan komit

git undo menyerahkan komit

Bagaimana untuk mengikat data dalam senarai lungsur

Bagaimana untuk mengikat data dalam senarai lungsur

Bagaimana untuk membatalkan ralat komit git

Bagaimana untuk membatalkan ralat komit git

Bagaimana untuk membandingkan kandungan fail dua versi dalam git

Bagaimana untuk membandingkan kandungan fail dua versi dalam git

Punca dan penyelesaian ralat masa jalan

Punca dan penyelesaian ralat masa jalan

Bagaimana untuk menyegarkan cache dns

Bagaimana untuk menyegarkan cache dns