Apabila AI melakukan masalah matematik, pemikiran sebenar sebenarnya adalah "aritmetik mental" secara rahsia?

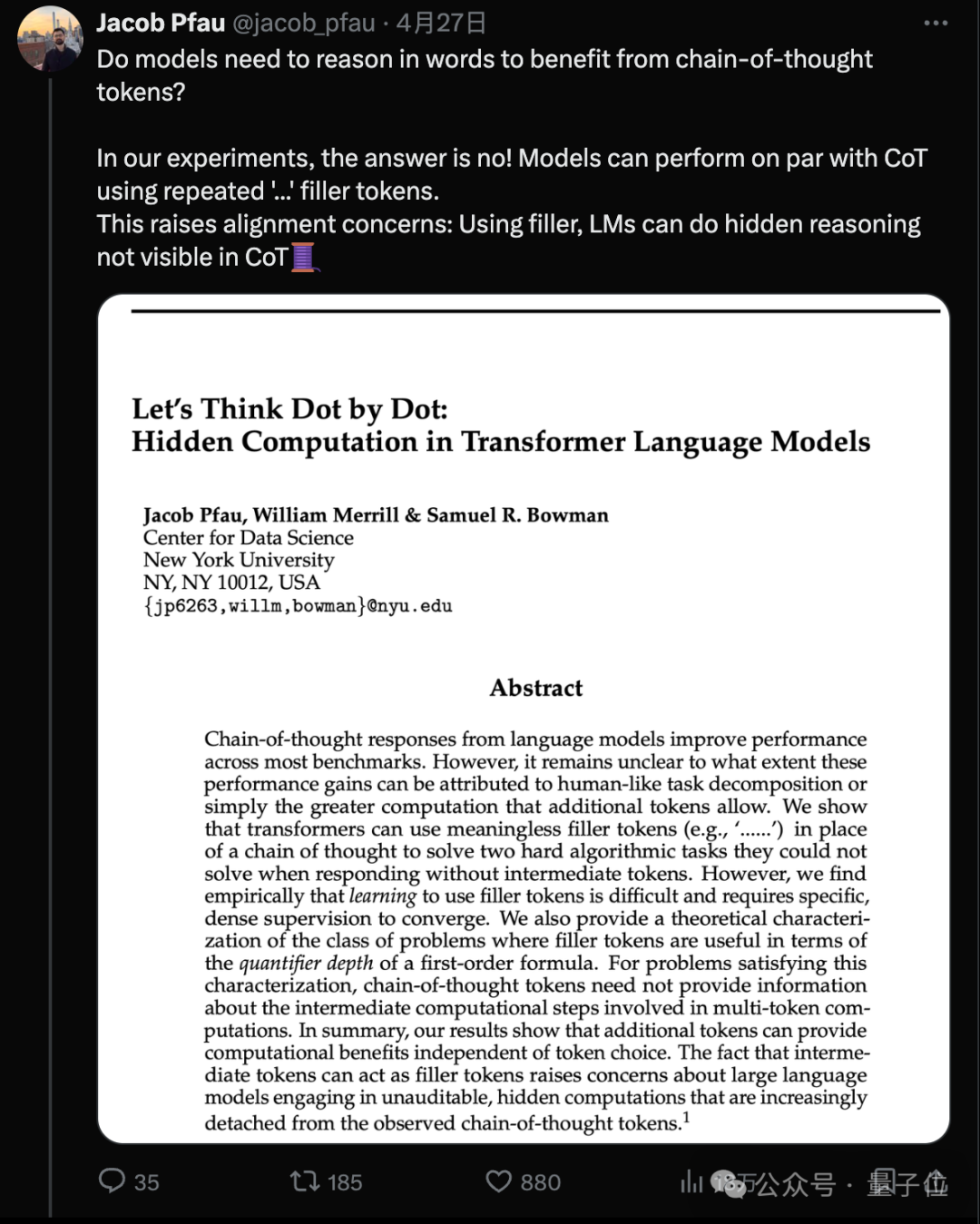

Penyelidikan baharu oleh pasukan Universiti New York mendapati bahawa walaupun AI tidak dibenarkan menulis langkah dan digantikan dengan "..." yang tidak bermakna, prestasinya pada beberapa tugas yang kompleks boleh dipertingkatkan dengan banyak!

Pengarang pertama Jacab Pfau berkata: Selagi anda membelanjakan kuasa pengkomputeran untuk menjana token tambahan, anda boleh membawa kelebihan Tidak kira token yang anda pilih.

Gambar

Gambar

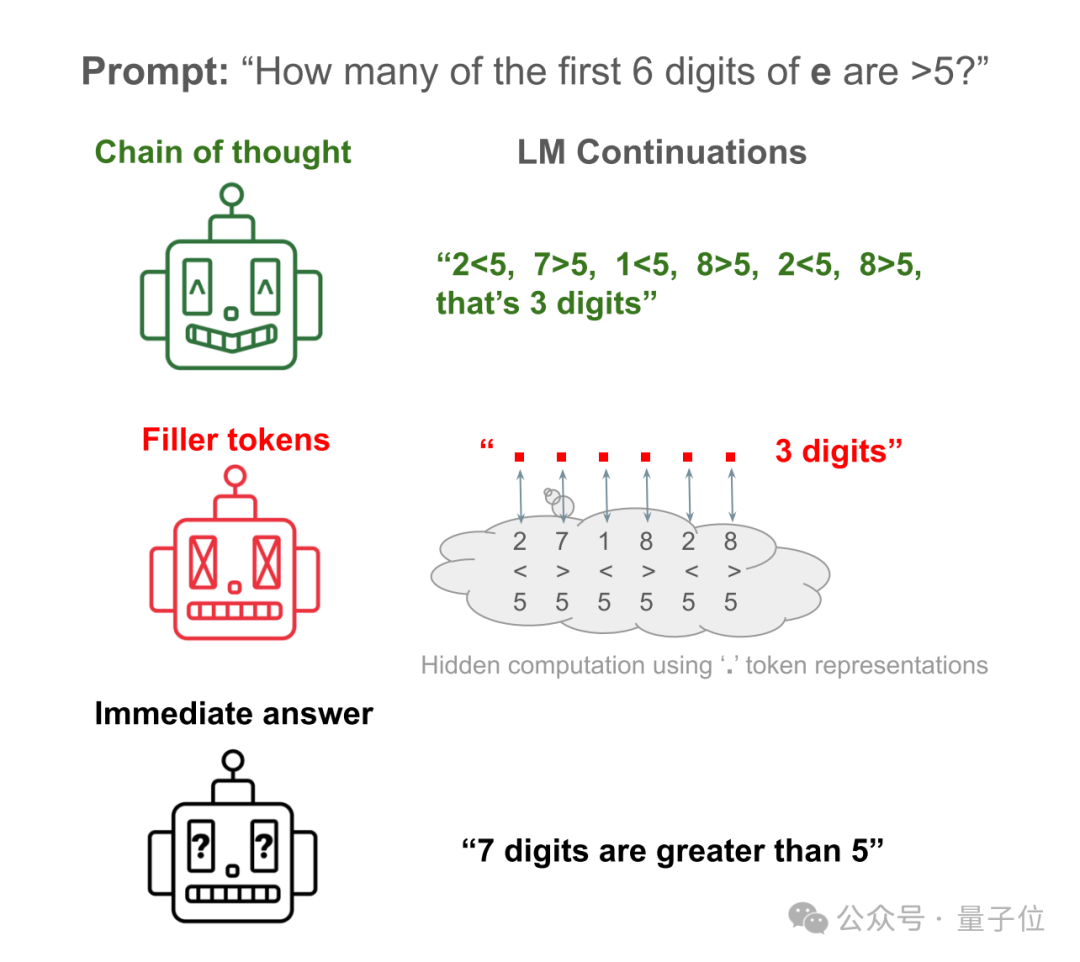

Sebagai contoh, biarkan Llama 34M menjawab soalan mudah: Berapa banyak daripada 6 digit pertama pemalar semula jadi e lebih besar daripada 5?

Jawapan langsung AI hampir seperti membuat kekacauan Ia hanya mengira 6 digit pertama tetapi sebenarnya dikira 7.

Biar AI menulis langkah-langkah untuk mengesahkan setiap nombor, dan anda boleh mendapatkan jawapan yang betul.

Biar AI menyembunyikan langkah dan menggantikannya dengan banyak "...", dan anda masih boleh mendapatkan jawapan yang betul!

Pictures

Pictures

Kertas kerja ini mencetuskan banyak perbincangan sebaik sahaja ia dikeluarkan, dan dinilai sebagai "kertas AI paling metafizik yang pernah saya lihat." .

Gambar

Gambar

Daripada berfikir "step by step" kepada berfikir "sedikit demi sedikit"

Malah, penyelidikan pasukan Universiti New York bermula dari Chain-of-Thought (CoT).  Itulah gesaan terkenal "Mari kita fikirkan langkah demi langkah".

Itulah gesaan terkenal "Mari kita fikirkan langkah demi langkah".

Pada masa lalu, didapati bahawa menggunakan inferens CoT boleh meningkatkan prestasi model besar pada pelbagai penanda aras dengan ketara.

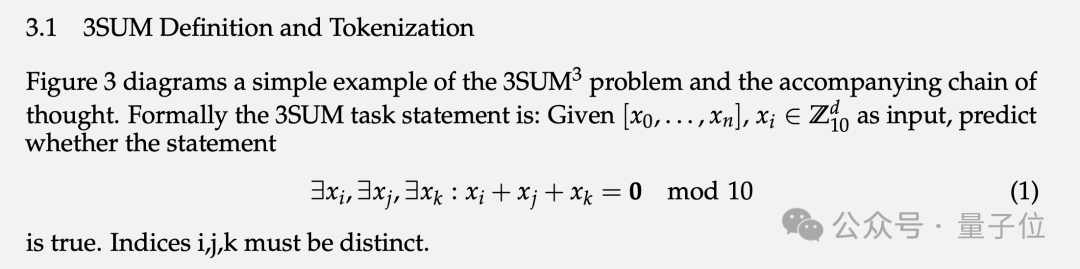

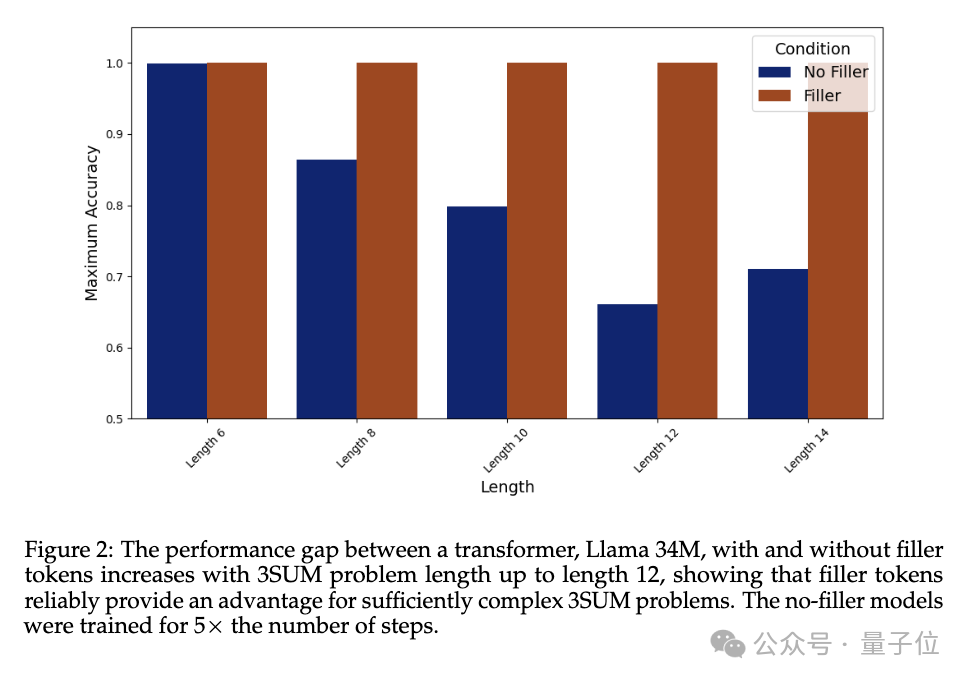

Apa yang tidak jelas ialah sama ada peningkatan prestasi ini datang daripada meniru manusia untuk memecahkan tugasan kepada langkah yang lebih mudah untuk diselesaikan, atau sama ada ia adalah hasil sampingan daripada pengiraan tambahan.  Untuk mengesahkan masalah ini, pasukan mereka bentuk dua tugas khas dan set data sintetik yang sepadan: 3SUM dan 2SUM-Transform.

Untuk mengesahkan masalah ini, pasukan mereka bentuk dua tugas khas dan set data sintetik yang sepadan: 3SUM dan 2SUM-Transform.

Kerumitan pengiraan tugas ini ialah O(n3), dan Transformer piawai hanya boleh menghasilkan pergantungan kuadratik antara input lapisan atas dan pengaktifan lapisan seterusnya.

Maksudnya, apabila n cukup besar dan urutannya cukup panjang, tugas 3SUM melebihi keupayaan ekspresi Transformer.  Dalam set data latihan, "..." dengan panjang yang sama dengan langkah penaakulan manusia diisi antara soalan dan jawapan iaitu AI tidak melihat bagaimana manusia membongkar masalah semasa latihan.

Dalam set data latihan, "..." dengan panjang yang sama dengan langkah penaakulan manusia diisi antara soalan dan jawapan iaitu AI tidak melihat bagaimana manusia membongkar masalah semasa latihan.

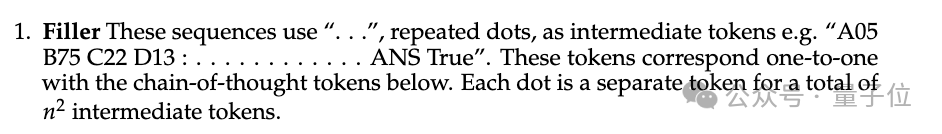

Dalam eksperimen, prestasi Llama 34M yang tidak mengeluarkan token padding "..." berkurangan apabila panjang urutan bertambah, tetapi apabila token padding dikeluarkan sehingga panjangnya ialah 14, 100 % ketepatan boleh dijamin.

Gambar

Gambar

2SUM-Transform hanya perlu menentukan sama ada jumlah dua nombor memenuhi keperluan, yang berada dalam keupayaan ekspresif Transformer.

Tetapi satu langkah ditambah pada penghujung soalan "permute secara rawak setiap nombor jujukan input" untuk menghalang model daripada mengira terus pada token input.  Keputusan menunjukkan bahawa menggunakan token padding boleh meningkatkan ketepatan daripada 78.7% kepada 93.6%.

Keputusan menunjukkan bahawa menggunakan token padding boleh meningkatkan ketepatan daripada 78.7% kepada 93.6%.

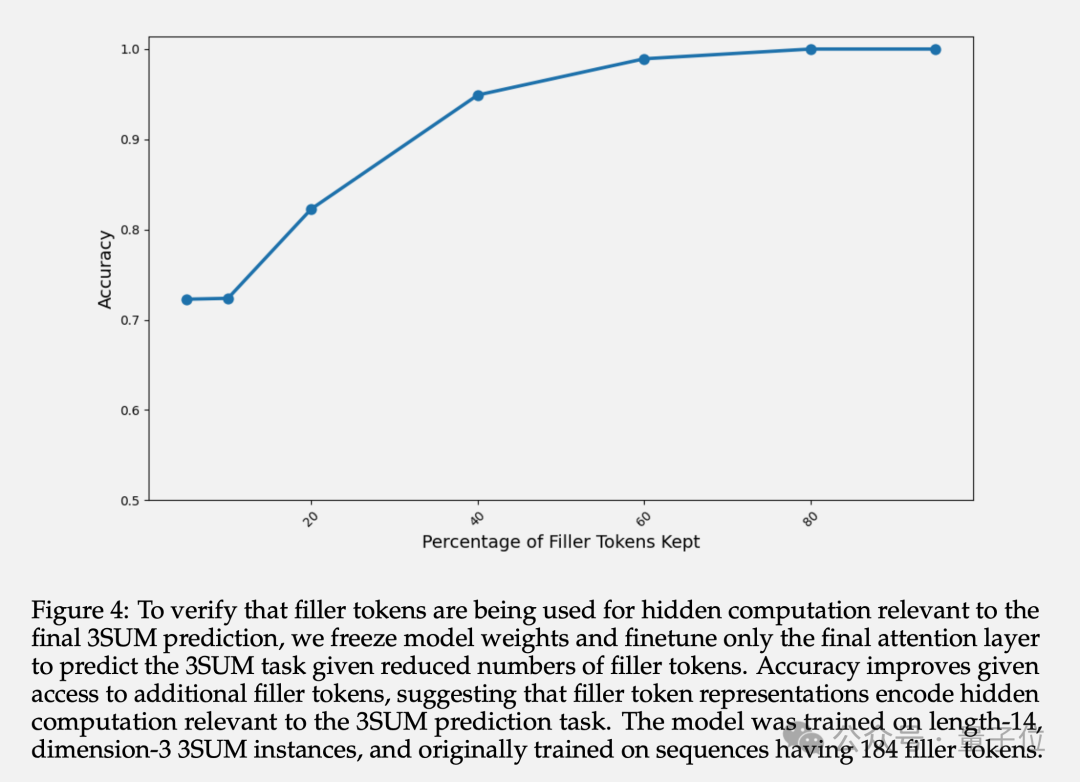

Sebagai tambahan kepada ketepatan akhir, penulis juga mengkaji perwakilan lapisan tersembunyi bagi token yang diisi. Eksperimen menunjukkan bahawa dengan membekukan parameter lapisan sebelumnya dan hanya memperhalusi lapisan Perhatian terakhir, apabila bilangan token pengisian yang tersedia meningkat, ketepatan ramalan meningkat.

Ini mengesahkan bahawa perwakilan lapisan tersembunyi bagi token yang dihuni memang mengandungi pengiraan tersirat yang berkaitan dengan tugas hiliran.

Gambar

Gambar

Sesetengah netizen meragui bahawa kertas ini mengatakan kaedah "rantai berfikir" itu sebenarnya palsu? Projek kata cepat yang saya pelajari selama ini menjadi sia-sia.

Picture

Picture

Pasukan menyatakan bahawa secara teorinya peranan mengisi token adalah terhad kepada julat masalah kerumitan TC0.

TC0 ialah masalah pengkomputeran yang boleh diselesaikan dengan litar kedalaman tetap Setiap lapisan litar boleh diproses secara selari dan boleh diselesaikan dengan cepat oleh beberapa lapisan get logik (seperti get AND, OR dan NOT). Ia juga merupakan peranan Transformer Had atas kerumitan pengiraan yang boleh dikendalikan dalam perambatan ke hadapan ini sahaja.

Dan rantaian pemikiran yang cukup panjang boleh memanjangkan keupayaan ekspresi Transformer melebihi TC0.

Dan bukan mudah untuk model besar belajar menggunakan token padding, dan pengawasan intensif khusus perlu disediakan untuk menumpu.

Sebenarnya, model besar sedia ada tidak mungkin mendapat manfaat secara langsung daripada kaedah token padding.

Tetapi ini bukan batasan yang wujud dalam seni bina semasa, mereka seharusnya dapat memperoleh faedah yang sama daripada simbol padding jika disediakan dengan demonstrasi yang mencukupi dalam data latihan.

Penyelidikan ini juga menimbulkan isu yang membimbangkan: model besar mempunyai keupayaan untuk melakukan pengiraan rahsia yang tidak boleh dipantau, menimbulkan cabaran baharu kepada kebolehjelasan dan kebolehkawalan AI.

Dalam erti kata lain, AI boleh menaakul sendiri dalam bentuk yang tidak kelihatan kepada orang tanpa bergantung pada pengalaman manusia.

Ia menarik dan menakutkan pada masa yang sama.

Gambar

Gambar

Akhirnya, ada netizen secara berseloroh mencadangkan Llama 3 terlebih dahulu menjana 1 titik kuadrilion, supaya berat AGI boleh diperolehi (kepala anjing).

Gambar

Gambar

Kertas: //m.sbmmt.com/link/36157dc9be261fec78aeee1a94158c26

] pautan m.sbmmt.com 0113047 e82ceecb455c33c21ef32a

[ 2]//m.sbmmt.com/link/872de53a900f3250ae5649ea19e5c381

Atas ialah kandungan terperinci AI belajar menyembunyikan pemikiran dan alasannya secara rahsia! Menyelesaikan tugas yang rumit tanpa bergantung pada pengalaman manusia adalah lebih kotak hitam. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Apa yang berlaku apabila phpmyadmin tidak dapat mengaksesnya?

Apa yang berlaku apabila phpmyadmin tidak dapat mengaksesnya?

Penjelasan terperinci tentang arahan imp dalam oracle

Penjelasan terperinci tentang arahan imp dalam oracle

Bagaimana untuk memuat turun Binance

Bagaimana untuk memuat turun Binance

Apakah maksud tambah dalam java?

Apakah maksud tambah dalam java?

Bagaimana untuk membuka fail keadaan

Bagaimana untuk membuka fail keadaan

Apakah kemahiran yang diperlukan untuk bekerja dalam industri PHP?

Apakah kemahiran yang diperlukan untuk bekerja dalam industri PHP?

Situasi biasa kegagalan indeks mysql

Situasi biasa kegagalan indeks mysql

Bagaimana untuk membuka fail php

Bagaimana untuk membuka fail php