Dalam bidang sains komputer, struktur graf terdiri daripada nod (mewakili entiti) dan tepi (mewakili hubungan antara entiti).

Gambar ada di mana-mana.

Internet boleh dianggap sebagai rangkaian yang besar, dan enjin carian menggunakan kaedah grafik untuk menyusun dan memaparkan maklumat.

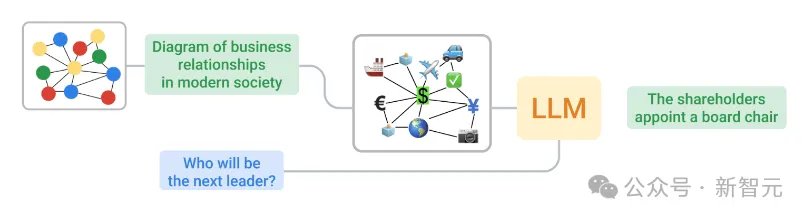

LLM terutamanya dilatih pada teks biasa, jadi menukar graf kepada teks yang boleh difahami oleh LLM adalah tugas yang mencabar kerana struktur graf pada asasnya berbeza daripada teks.

Di ICLR 2024, pasukan daripada Google meneroka cara mengubah data graf kepada bentuk yang sesuai untuk LLM faham.

Alamat kertas: https://openreview.net/pdf?id=IuXR1CCrSi

Gunakan dua kaedah berbeza untuk mengekodkan grafik dan soalan, dan kembali ke LLM Dalam proses

mereka juga membangunkan penanda aras yang dipanggil GraphQA untuk meneroka pendekatan untuk menyelesaikan masalah penaakulan graf yang berbeza dan menunjukkan cara untuk menyatakan masalah ini dengan cara yang kondusif untuk LLM menyelesaikan masalah berkaitan graf.

Menggunakan kaedah yang betul, LLM boleh meningkatkan prestasi tugas grafik sehingga 60%.

Pertama, pasukan Google mereka bentuk penanda aras GraphQA, yang boleh dilihat sebagai peperiksaan yang direka untuk menilai keupayaan LLM menangani masalah graf tertentu.

GraphOA memastikan kepelbagaian dalam keluasan dan bilangan sambungan dengan menggunakan berbilang jenis graf untuk mencari kemungkinan sisihan dalam LLM semasa memproses graf, dan menjadikan keseluruhan proses lebih dekat dengan perkara yang mungkin dihadapi oleh LLM dalam keadaan aplikasi praktikal.

Rangka kerja untuk penaakulan dengan LLM menggunakan GraphIQA

Walaupun tugasnya mudah, seperti menyemak sama ada tepi wujud, mengira bilangan nod atau tepi ini untuk memahami LLM, dsb. hubungan antara nod dan tepi Hubungan antara mereka adalah penting untuk penaakulan grafik yang lebih kompleks.

Pada masa yang sama, pasukan juga meneroka cara menukar graf kepada teks yang boleh diproses oleh LLM, seperti menyelesaikan dua isu utama berikut:

Pengekodan nod: Bagaimanakah kita mewakili satu nod? Nod boleh termasuk integer mudah, nama biasa (orang, aksara) dan huruf.

Pengekodan Tepi: Bagaimanakah kita menerangkan perhubungan antara nod? Kaedah boleh termasuk notasi kurungan, frasa (seperti "adalah kawan") dan perwakilan simbolik (seperti anak panah).

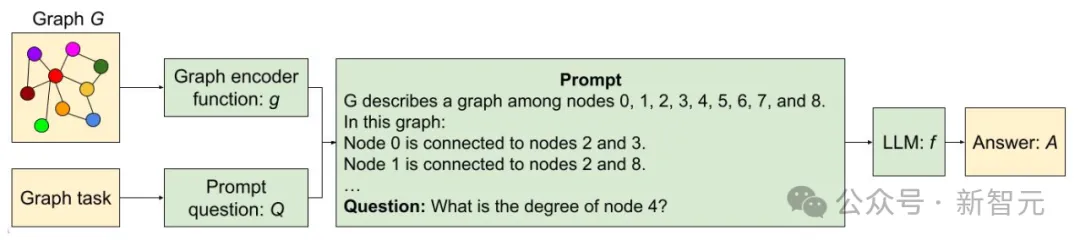

Akhirnya, penyelidik menggabungkan pelbagai kaedah pengekodan nod dan tepi secara sistematik untuk menghasilkan fungsi seperti yang ditunjukkan dalam rajah di bawah.

Contoh fungsi pengekodan graf

Pasukan penyelidik menjalankan tiga eksperimen utama pada GraphOA:

Dalam percubaan pertama, LLM berprestasi biasa-biasa sahaja, dan pada kebanyakan tugas asas, LLM berprestasi tidak lebih baik daripada meneka secara rawak.

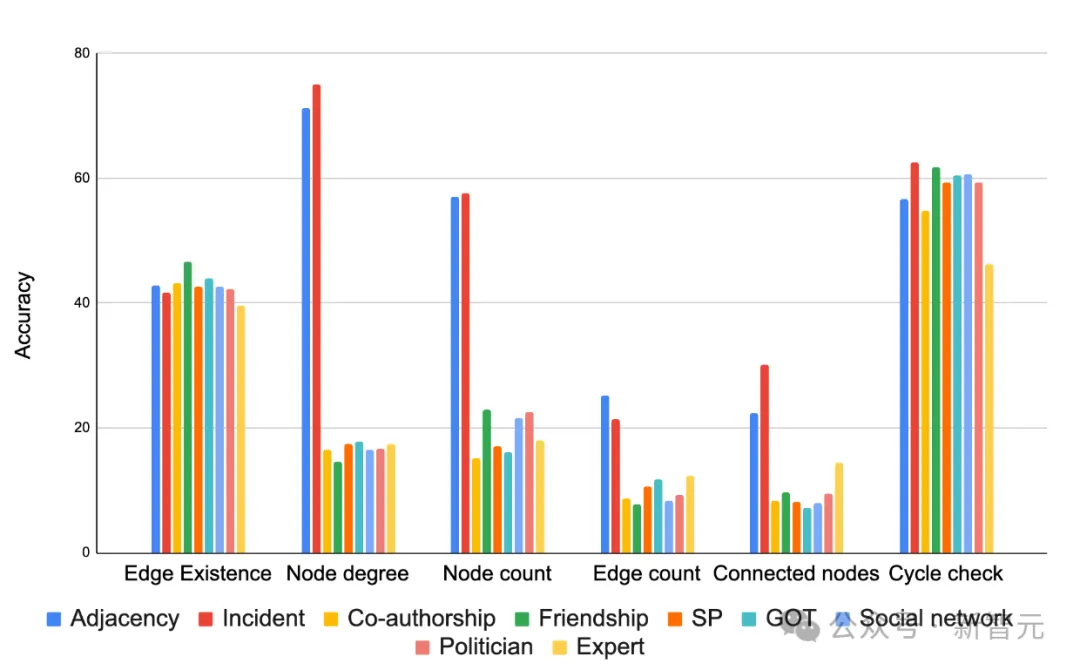

Tetapi kaedah pengekodan mempengaruhi keputusan dengan ketara, seperti yang ditunjukkan dalam rajah di bawah, dalam kebanyakan kes, pengekodan "insiden" berfungsi dengan baik dalam kebanyakan tugas. Memilih fungsi pengekodan yang sesuai boleh mempertingkatkan ketepatan tugasan.

Perbandingan pelbagai fungsi pengekod graf berdasarkan ketepatan tugasan yang berbeza

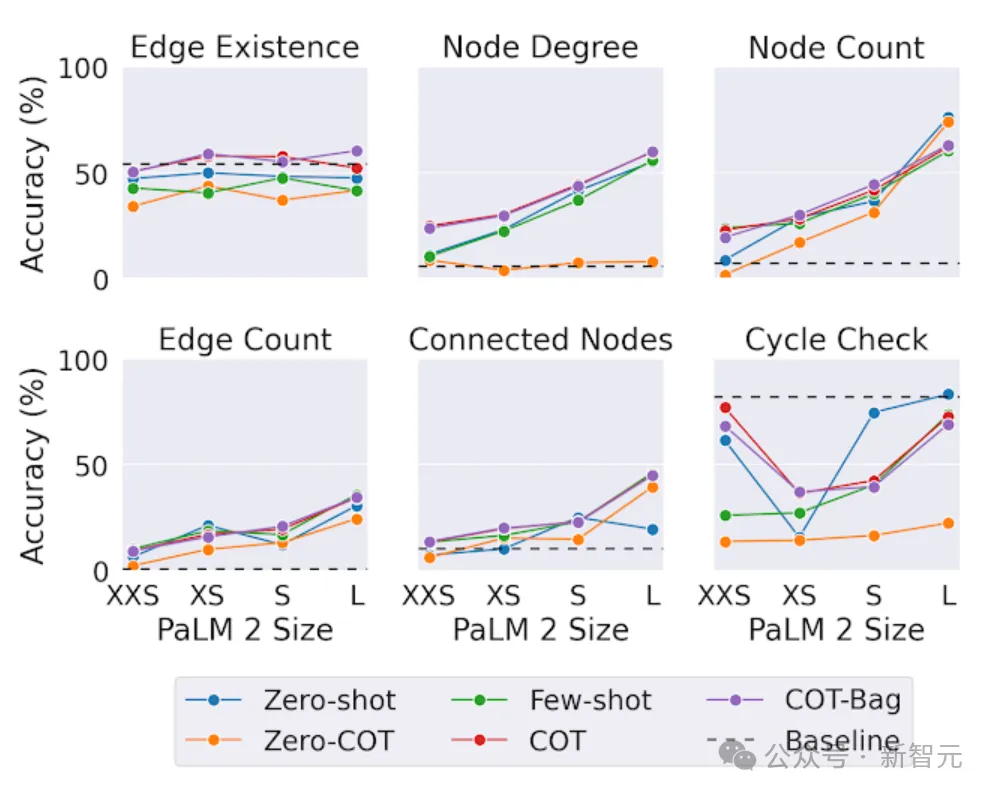

Dalam ujian kedua, penyelidik menguji tugasan graf yang sama pada model yang berbeza saiz.

Dari segi kesimpulan, dalam tugasan inferens graf, model yang lebih besar berprestasi lebih baik,

Namun, menariknya, dalam tugasan "kewujudan tepi" (menentukan sama ada dua nod dalam graf disambungkan) , saiz adalah tidak sepenting tugas lain.

Malah LLM terbesar tidak boleh sentiasa mengatasi penyelesaian garis dasar yang mudah pada masalah semakan kitaran (menentukan sama ada kitaran wujud dalam graf). Ini menunjukkan bahawa LLM masih mempunyai ruang untuk penambahbaikan pada tugas graf tertentu.

Impak kapasiti model pada tugas penaakulan graf PaLM 2-XXS, Orang ramai menggunakan GraphOA untuk menjana graf struktur berbeza untuk analisis.

Contoh graf yang dijana oleh penjana graf berbeza bagi GraphQA. ER, BA, SBM dan SFN masing-masing ialah Erdős-Rényi, Barabási-Albert, model blok stokastik dan rangkaian tanpa skala.

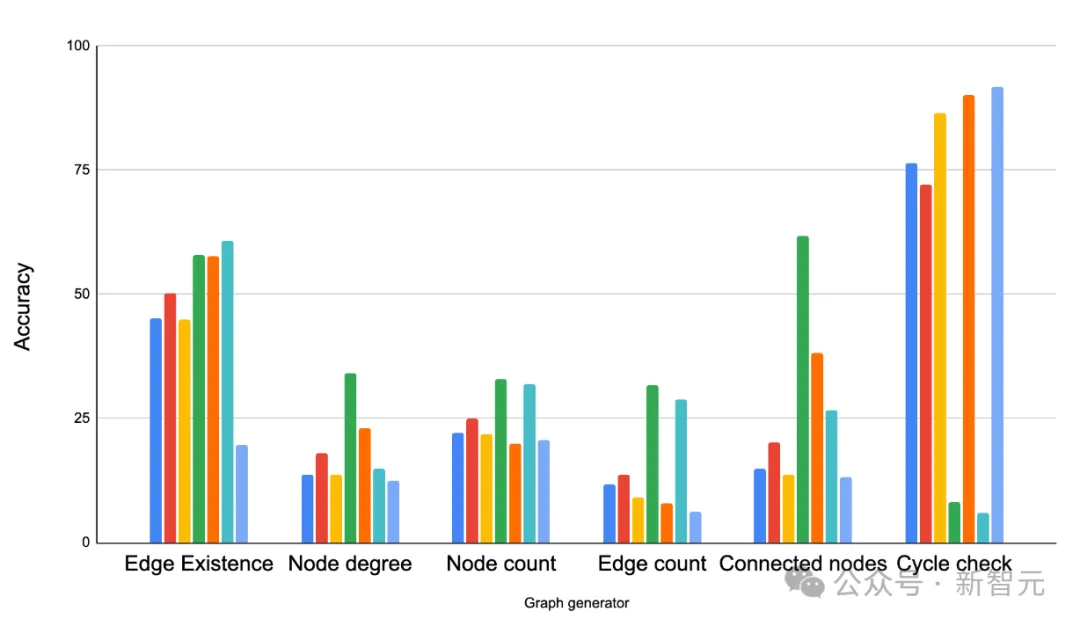

Hasilnya menunjukkan bahawa struktur graf mempunyai kesan yang besar terhadap prestasi LLM.

Sebagai contoh, dalam tugasan bertanya sama ada gelung wujud, LLM berprestasi baik dalam graf yang berkait rapat (di mana gelung adalah biasa), tetapi kurang baik dalam graf laluan (di mana gelung tidak pernah berlaku).

Tetapi pada masa yang sama, menyediakan beberapa sampel campuran membantu LLM menyesuaikan diri Contohnya, dalam tugas pengesanan kitaran, penyelidik menambah beberapa contoh yang mengandungi kitaran dan beberapa yang tidak mengandungi kitaran dalam gesaan sebagai contoh beberapa-. pembelajaran pukulan Melalui kaedah ini meningkatkan prestasi LLM.

Bandingkan penjana graf yang berbeza pada tugasan graf yang berbeza. Pemerhatian utama ialah struktur graf mempunyai kesan yang signifikan terhadap prestasi LLM. ER, BA, SBM dan SFN masing-masing merujuk kepada Erdős-Rényi, Barabási-Albert, model blok stokastik dan rangkaian tanpa skala.

Ini hanyalah permulaan untuk membolehkan LLM memahami graf

Meningkatkan ketepatan LLM pada masalah graf dengan ketara (dari kira-kira 5% kepada lebih 60% peningkatan) dengan bantuan teknik pengekodan yang betul.

Kami juga mengenal pasti tiga faktor utama yang mempengaruhi, iaitu kaedah pengekodan untuk menukar grafik kepada teks, jenis tugas grafik yang berbeza dan struktur ketumpatan grafik.

Ini hanyalah permulaan untuk LLM memahami graf. Dengan bantuan GraphQA penanda aras baharu, kami menantikan penyelidikan lanjut untuk meneroka lebih banyak kemungkinan LLM.

Atas ialah kandungan terperinci Prestasi LLM dipertingkatkan sehingga 60%! Karya agung Google ICLR 2024: Biarkan model bahasa besar mempelajari 'bahasa graf'. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Bagaimana untuk membuka fail html pada telefon bimbit

Bagaimana untuk membuka fail html pada telefon bimbit

aplikasi pertukaran okex

aplikasi pertukaran okex

Bagaimana untuk mempertahankan pelayan awan daripada serangan DDoS

Bagaimana untuk mempertahankan pelayan awan daripada serangan DDoS

penggunaan fungsi sampel semula

penggunaan fungsi sampel semula

tutorial pemasangan pycharm

tutorial pemasangan pycharm

Bagaimana untuk menyelesaikan synrax yang tidak sah

Bagaimana untuk menyelesaikan synrax yang tidak sah

Komputer dijangkiti dan tidak boleh dihidupkan

Komputer dijangkiti dan tidak boleh dihidupkan

Penggunaan kata kunci Jenis dalam Go

Penggunaan kata kunci Jenis dalam Go