Vision Pro mempunyai satu lagi permainan baharu yang hangat, kali ini ia dikaitkan dengan kecerdasan yang terkandung~

Sama seperti ini, lelaki MIT menggunakan fungsi penjejakan tangan Vision Pro untuk berjaya mencapai kawalan masa nyata anjing robot itu.

Bukan sahaja tindakan seperti membuka pintu boleh diperolehi dengan tepat:

, hampir tiada kelewatan.

Sebaik Demo keluar, bukan sahaja netizen memuji Goose Girl, malah pelbagai penyelidik perisikan yang dijelmakan turut teruja.

Sebagai contoh, bakal pelajar kedoktoran di Universiti Tsinghua ini:

Sesetengah orang dengan berani meramalkan: Beginilah cara kita akan berinteraksi dengan generasi mesin akan datang.

Cara melaksanakan projek, pengarang Park Younghyo(Younghyo Park) telah sumber terbuka di GitHub. Apl yang berkaitan boleh dimuat turun terus daripada App Store Vision Pro.

Mari lihat aplikasi yang dibangunkan oleh pengarang secara terperinci - Pengukus Penjejakan.

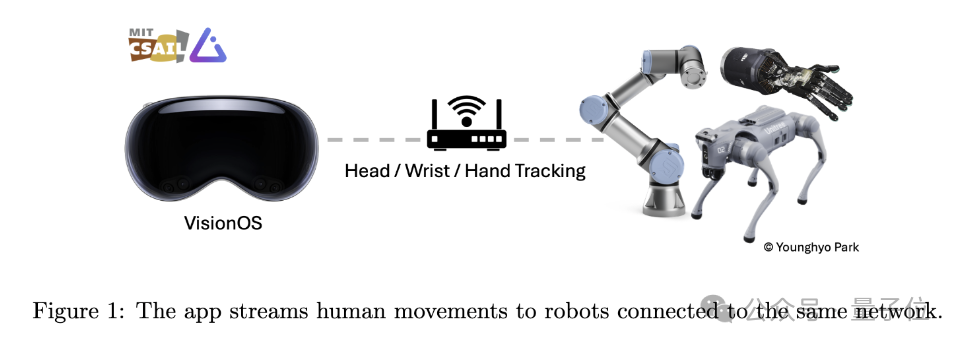

Seperti namanya, aplikasi ini direka bentuk untuk menggunakan Vision Pro untuk mengesan pergerakan manusia dan menghantar data pergerakan ini ke peranti robot lain di bawah WiFi yang sama dalam masa nyata.

Bahagian penjejakan gerakan bergantung terutamanya pada perpustakaan ARKit Apple.

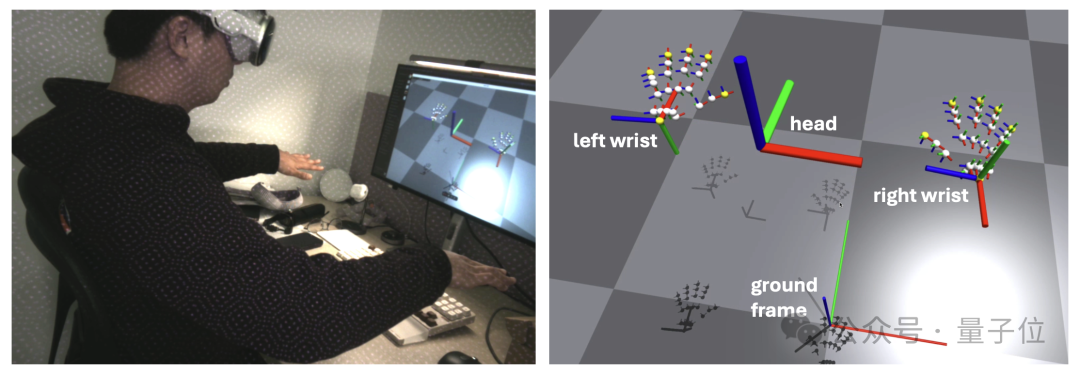

Penjejakan kepala memanggil queryDeviceAnchor. Pengguna boleh menetapkan semula bingkai kepala kepada kedudukan semasa dengan menekan dan menahan Digital Crown.

Penjejakan pergelangan tangan dan jari dilaksanakan melalui HandTrackingProvider. Ia mampu mengesan kedudukan dan orientasi pergelangan tangan kiri dan kanan berbanding rangka tanah, serta postur 25 sendi jari pada setiap tangan berbanding rangka pergelangan tangan.

Dari segi komunikasi rangkaian, Aplikasi ini menggunakan gRPC sebagai protokol komunikasi rangkaian untuk menstrim data. Ini membolehkan data melanggan lebih banyak peranti, termasuk peranti Linux, Mac dan Windows.

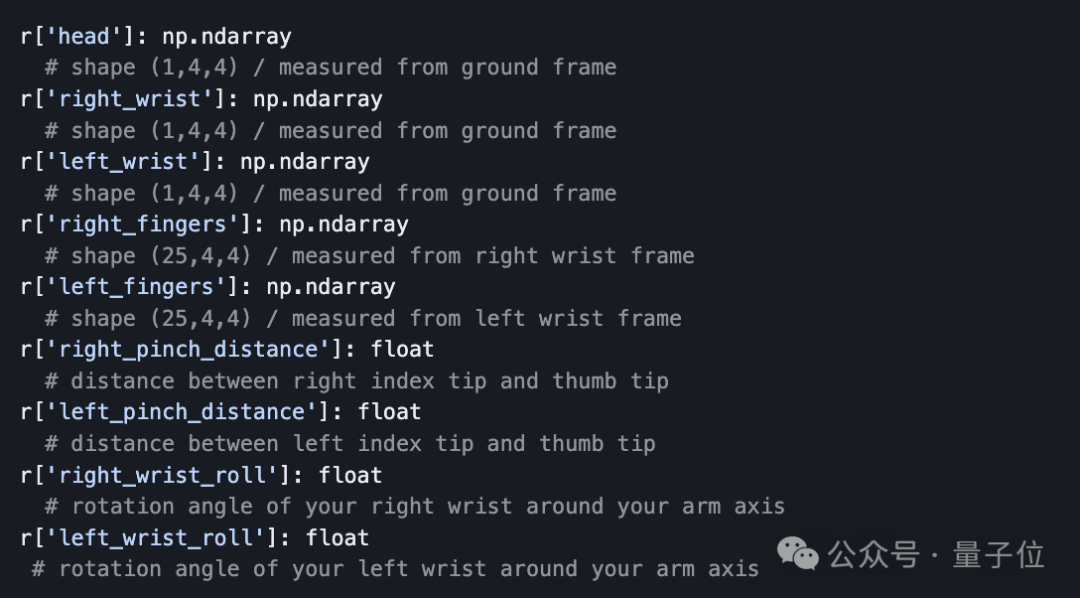

Selain itu, bagi memudahkan penghantaran data, penulis juga telah menyediakan Python API yang membolehkan pembangun melanggan dan menerima data penjejakan yang distrim daripada Vision Pro secara pemrograman.

Data yang dikembalikan oleh API adalah dalam bentuk kamus, termasuk maklumat postur SE (3) kepala, pergelangan tangan dan jari, iaitu kedudukan dan orientasi tiga dimensi. Pembangun boleh memproses data ini secara langsung dalam Python untuk analisis dan kawalan lanjut robot.

Seperti yang ditunjukkan oleh ramai profesional, tidak kira sama ada pergerakan anjing robot itu masih dikawal oleh manusia, sebenarnya, berbanding "kawalan" itu sendiri, digabungkan dengan algoritma pembelajaran tiruan, manusia lebih berkebolehan dalam proses ini seperti jurulatih robot.

Vision Pro menyediakan kaedah interaksi yang intuitif dan mudah dengan menjejaki pergerakan pengguna, membolehkan bukan profesional menyediakan data latihan yang tepat untuk robot.

Pengarang sendiri juga menulis dalam kertas:

Dalam masa terdekat, orang mungkin memakai peranti seperti Vision Pro seperti cermin mata harian.

Ini adalah sumber data yang menjanjikan dari mana robot boleh mempelajari cara manusia berinteraksi dengan dunia sebenar.

Akhir sekali, peringatan, jika anda ingin mencuba projek sumber terbuka ini, selain Vision Pro, anda juga perlu menyediakan:

Nampaknya Apple masih perlu mengaut keuntungan (doge) terlebih dahulu.

Pautan projek:https://github.com/Improbable-AI/VisionProTeleop?tab=readme-ov-file

Atas ialah kandungan terperinci Latih anjing robot anda dalam masa nyata dengan Vision Pro! Projek sumber terbuka pelajar PhD MIT menjadi popular. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

apa itu mysql index

apa itu mysql index

Apa yang ditonjolkan dalam jquery

Apa yang ditonjolkan dalam jquery

Pertanyaan blockchain pelayar Ethereum

Pertanyaan blockchain pelayar Ethereum

Bagaimana untuk mendapatkan semula nyalaan Douyin selepas ia hilang?

Bagaimana untuk mendapatkan semula nyalaan Douyin selepas ia hilang?

Bagaimana untuk menyelesaikan masalah 400 permintaan buruk apabila halaman web dipaparkan

Bagaimana untuk menyelesaikan masalah 400 permintaan buruk apabila halaman web dipaparkan

Alat carian yang biasa digunakan

Alat carian yang biasa digunakan

Perisian percuma untuk membina laman web

Perisian percuma untuk membina laman web

Apakah konsep asas kecerdasan buatan

Apakah konsep asas kecerdasan buatan