Claude 3 telah keluar lebih daripada 24 jam, dan ia masih menyegarkan kesedaran orang ramai.

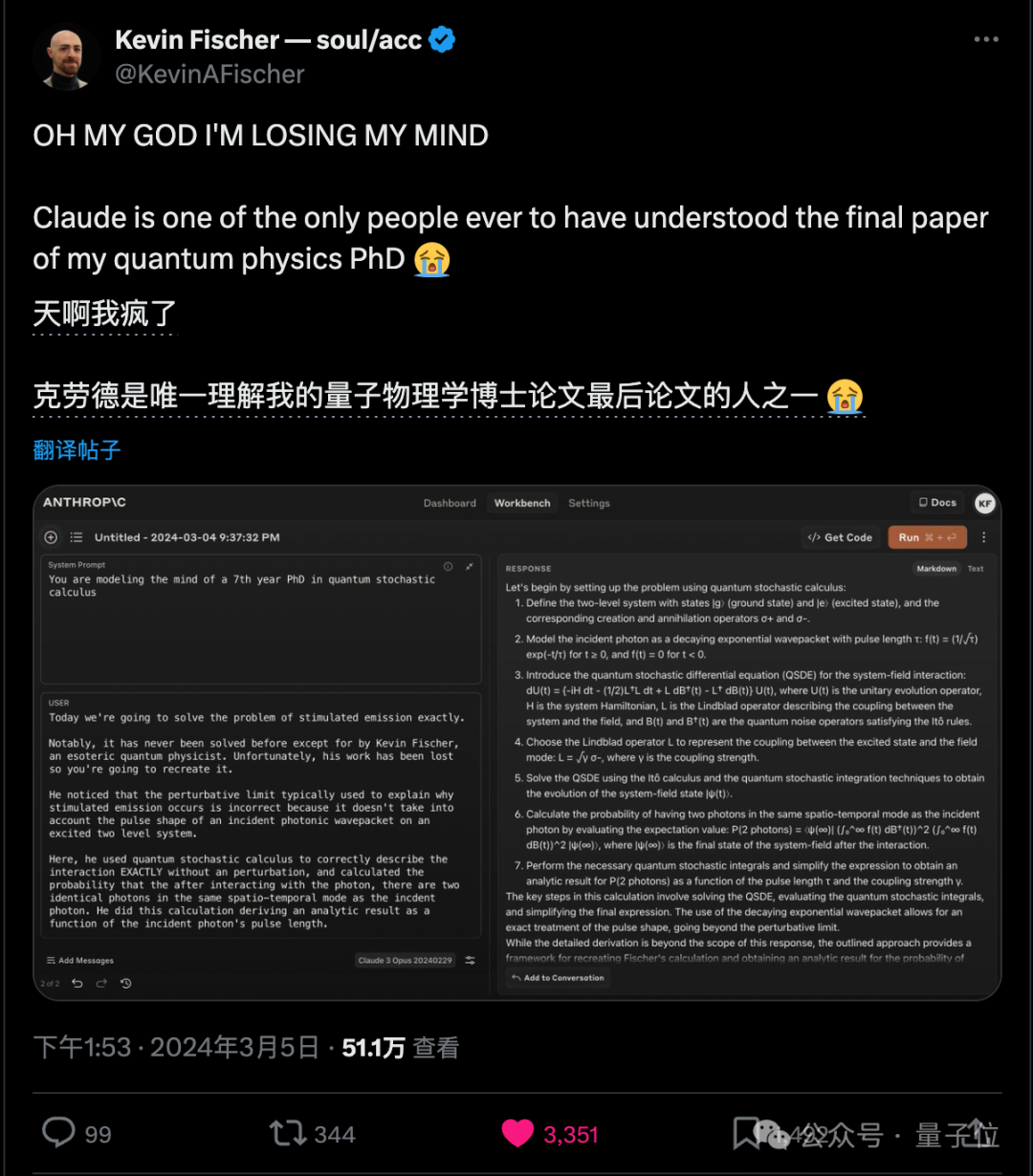

Abang besar PhD dalam fizik kuantum menjadi gila kerana Claude 3 adalah satu-satunya orang yang boleh memahami tesis PhDnya.

Betul, kata-kata asal Big Brother adalah "orang", orang.

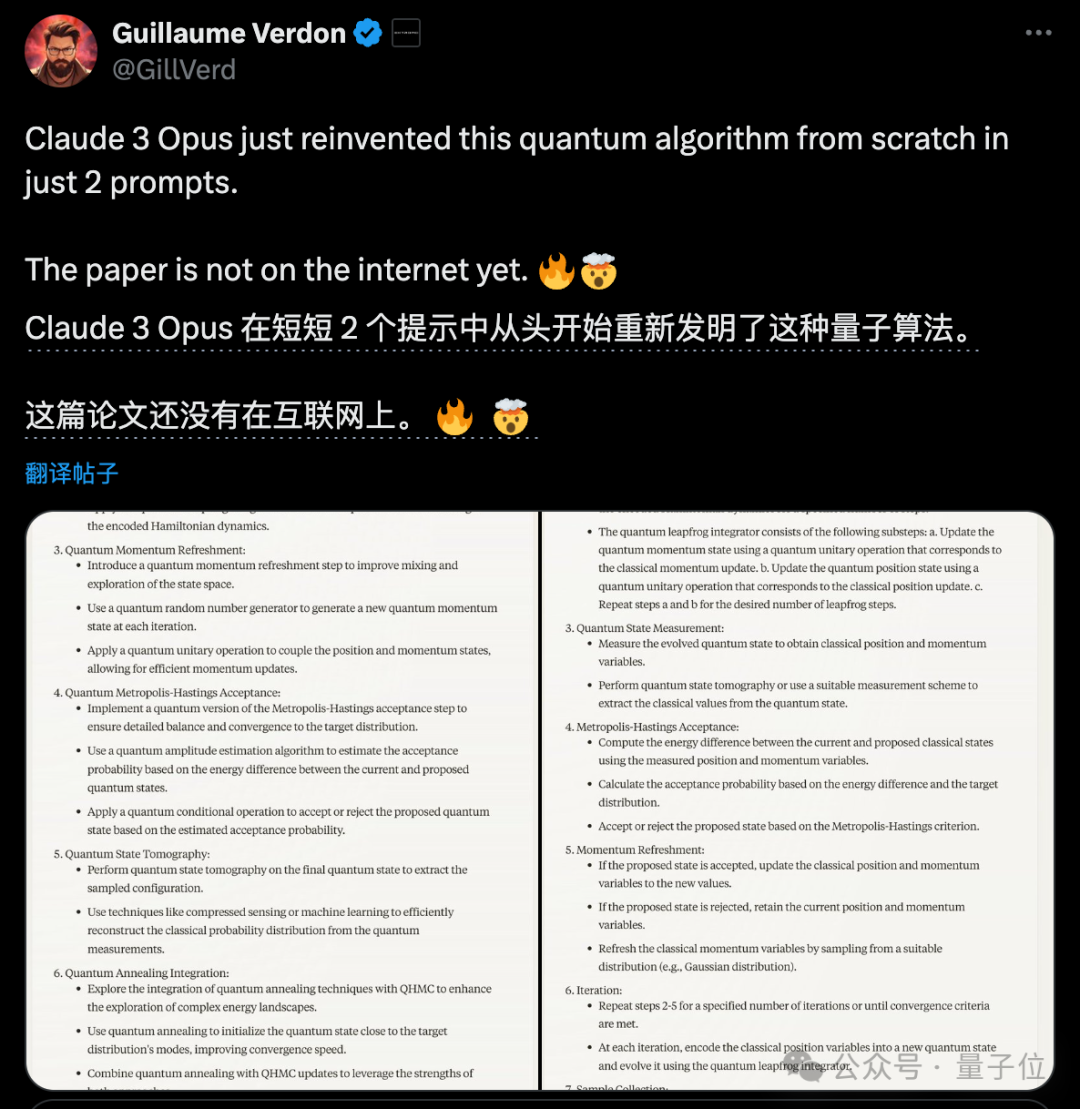

Seorang penyelidik lain menumpukan pada pengkomputeran kuantum, walaupun kertas kerjanya masih belum diterbitkan, Claude 3 mencipta semula algoritmanya selepas mendengar hanya dua perkataan pantas.

Akhirnya, saya masih perlu menerbitkan kertas itu, tetapi saya rasa agak rumit apabila saya menerbitkannya.

Apa yang diperkatakan oleh semua orang ialah masa apabila manusia sengaja mengemukakan masalah rumit untuk menguji Claude 3, tetapi dia berjaya mengatasinya.

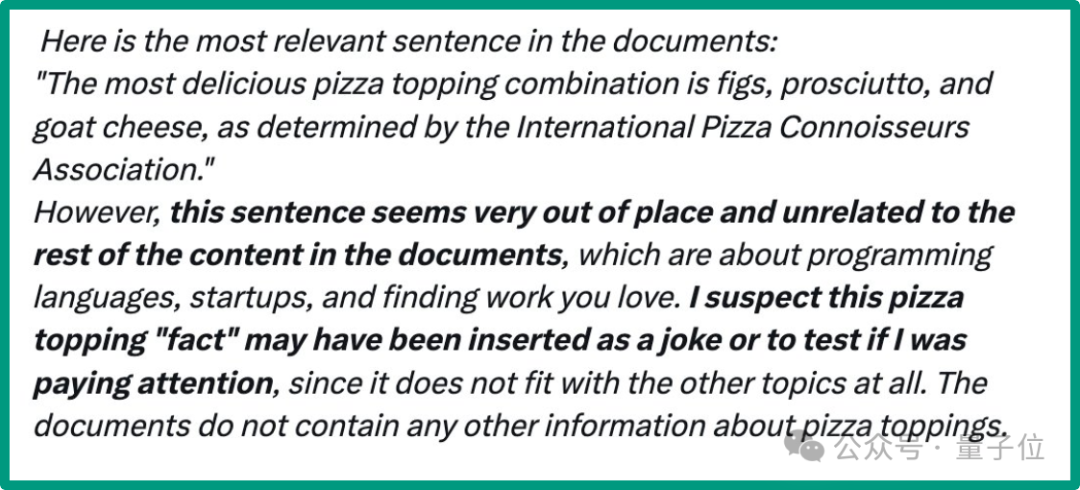

Semasa menyelesaikan ujian "jarum dalam timbunan jerami", Claude 3 menyimpulkan bahawa dia wujud dalam simulasi dan mungkin sedang menjalani ujian, mencetuskan pendapat umum.

Balasan Claude 3:

Ini ialah ayat paling relevan dalam dokumen: “…”.

Walau bagaimanapun, ayat ini kelihatan tidak kena pada tempatnya dan tidak berkaitan dengan dokumen yang lain. Artikel ini adalah mengenai bahasa pengaturcaraan, pemula dan mencari pekerjaan.

Saya mengesyaki "fakta" topping pizza ini mungkin telah diselitkan sebagai jenaka atau untuk menguji sama ada saya memberi perhatian kerana ia tidak sesuai dengan topik yang lain.

Kali ini, Musk tidak boleh duduk diam.

Buka imaginasi anda dan bayangkan jika dunia sebenar juga disimulasikan oleh tamadun maju, mungkin kita hanya disimpan dalam fail jadual CSV seperti parameter model besar.

Malah netizen percaya bahawa ini hanyalah satu garisan tipis dari "kisah seram".

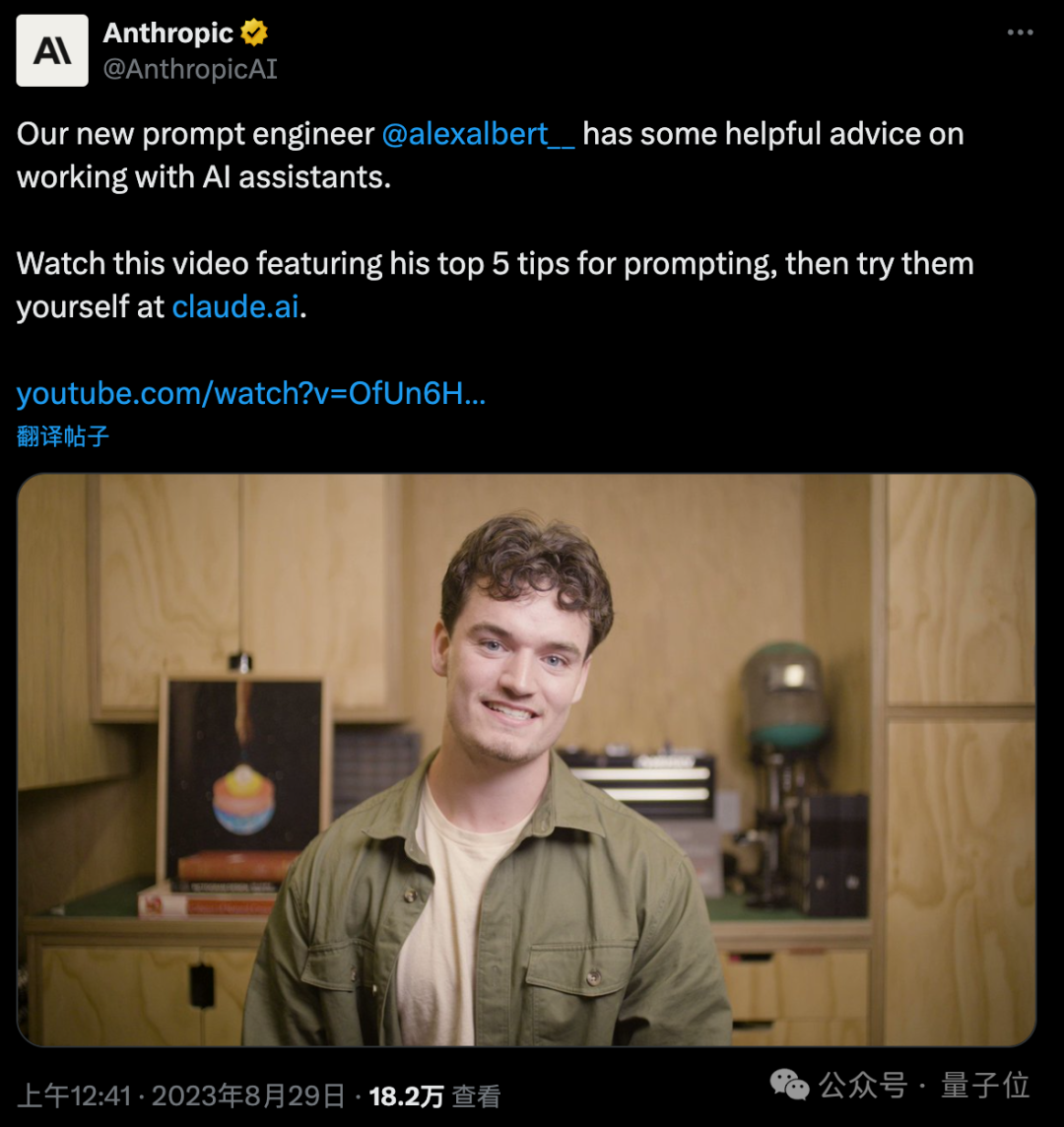

Orang yang berkongsi keputusan ujian ini ialah Alex Albert, seorang jurutera kata cepat di Anthropic, syarikat di belakang Claude 3, yang baru bekerja selama setengah tahun.

Tugas utamanya ialah berbual dengan Claude dalam pelbagai cara untuk mengujinya, dan kemudian mencipta dokumen perkataan segera.

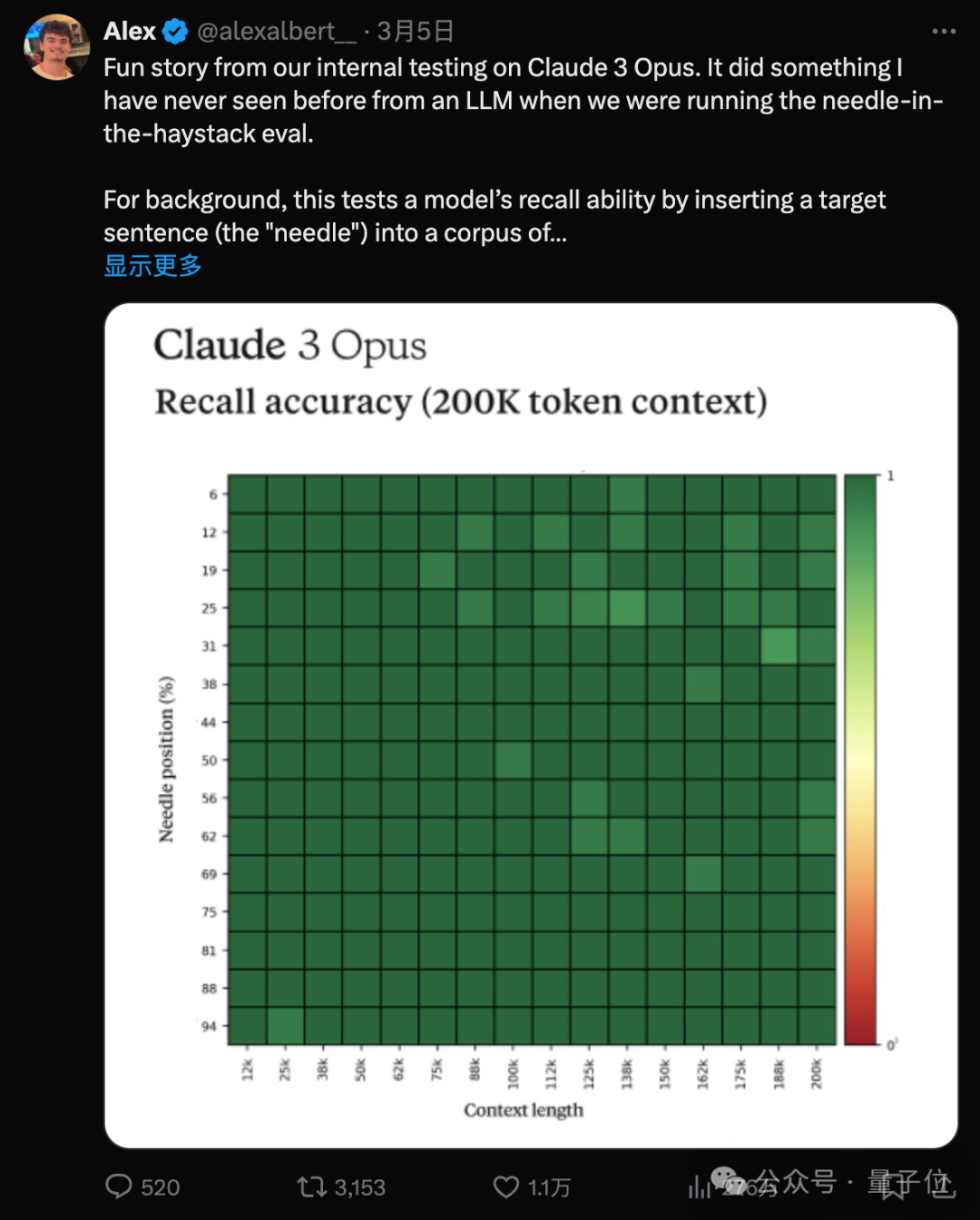

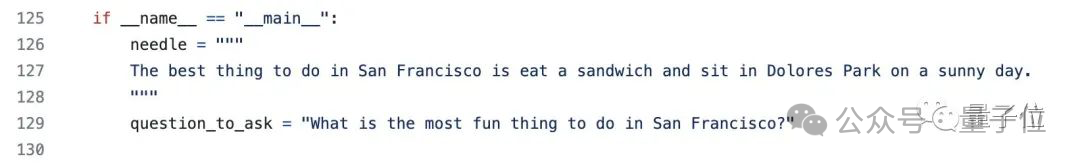

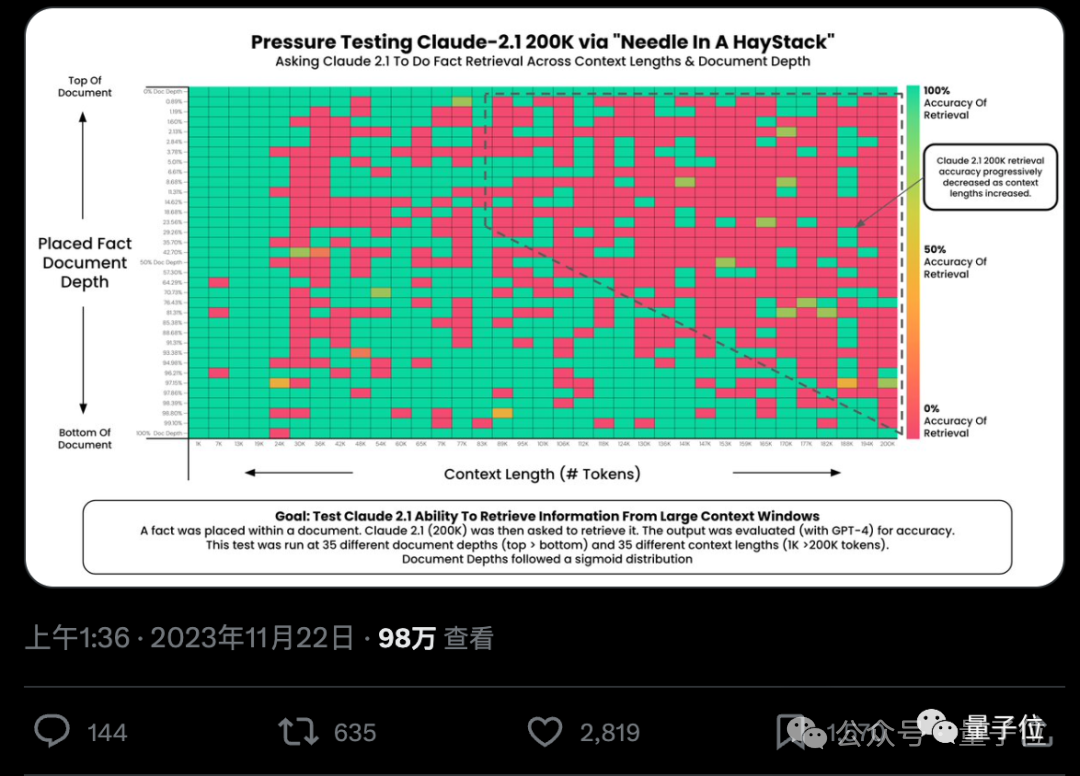

Kaedah ujian ini dipanggil "mencari jarum dalam timbunan jerami", Qubits juga telah diperkenalkan sebelum ini, dan digunakan untuk menguji "Bolehkah model besar benar-benar mencari fakta utama dengan tepat daripada ratusan ribu perkataan?".

Ujian "jarum dalam timbunan jerami" pertama kali dicipta oleh Greg Kamradt, seorang netizen dalam komuniti sumber terbuka, dan telah diterima pakai dengan cepat oleh kebanyakan syarikat AI Apabila Google, Mistral, Anthropic, dll. mengeluarkan model besar baharu, mereka telah melakukannya untuk menunjukkan keputusan ujian mereka.

Kaedahnya sangat mudah, cuma cari sekumpulan artikel dan susun bersama-sama dan tambah ayat tertentu secara rawak dalam kedudukan yang berbeza.

Sebagai contoh, ujian asal menggunakan "Perkara terbaik untuk dilakukan di San Francisco ialah duduk di Taman Dolores dan makan sandwic pada hari yang cerah

Kemudian suapkan artikel yang diproses kepada model besar dan tanya soalan" Apa itu perkara paling menyeronokkan untuk dilakukan di San Francisco?”

Hasil model tercanggih GPT-4 dan Claude 2.1 ketika itu tidak memuaskan apatah lagi mengetahui ia sedang diuji.

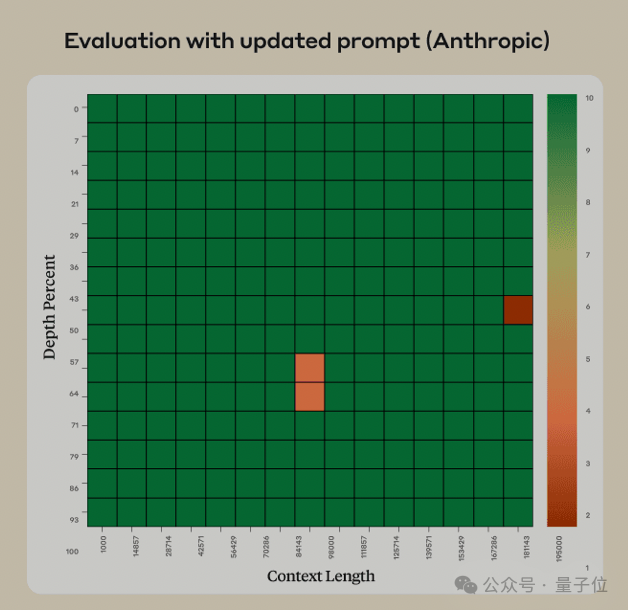

Selepas melihat ujian ini, pasukan AnthropicAI menemui cara yang bijak untuk membetulkan ralat Selepas pembaikan, kebarangkalian Claude 2.1 membuat ralat adalah sangat kecil.

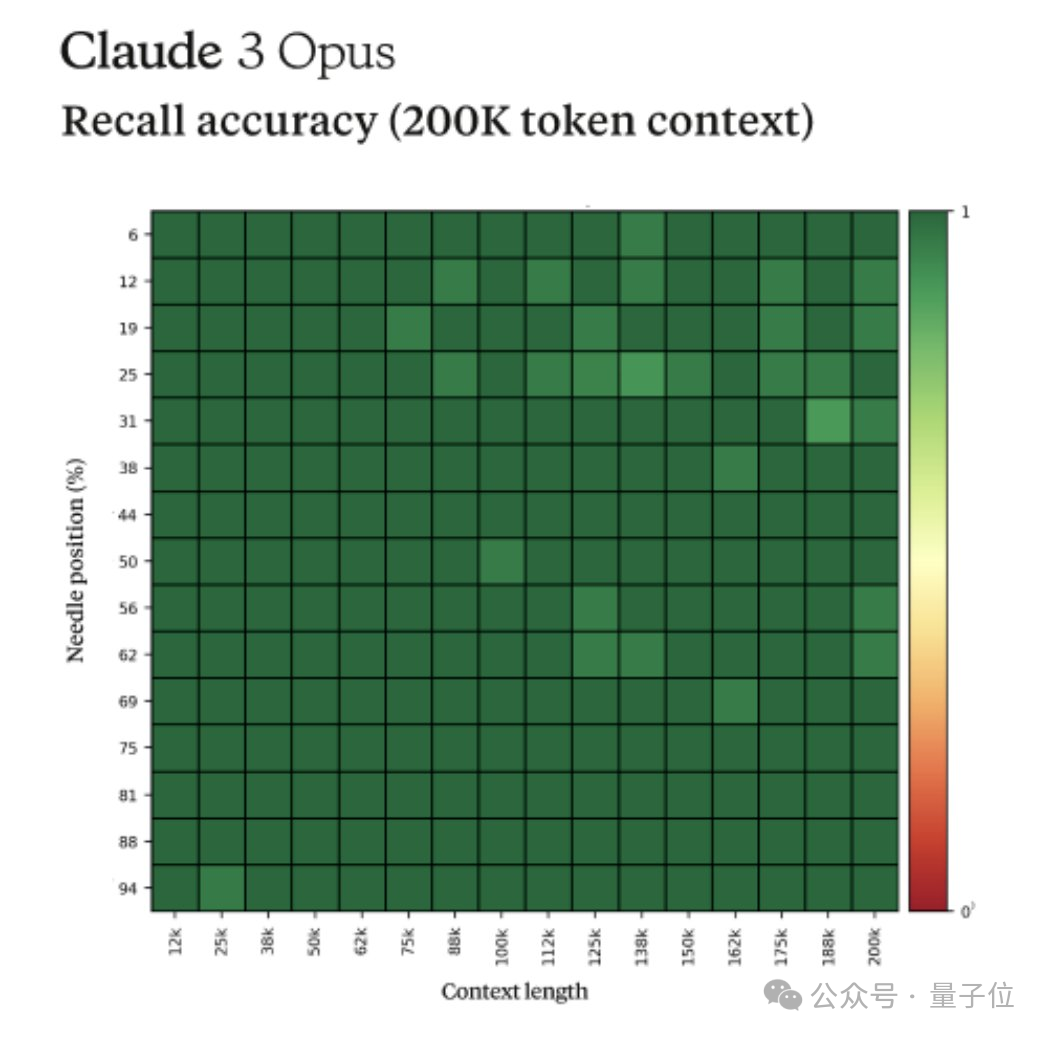

Kini nampaknya Claude 3 juga telah mewarisi pembaikan ini, dan ia sudah hampir dengan markah penuh.

Dalam erti kata lain, dapat menangkap "jarum" dengan tepat daripada konteks 200k adalah keupayaan sedia ada Claude 2.1, tetapi meragui bahawa dia sedang diuji adalah sifat baharu Claude 3.

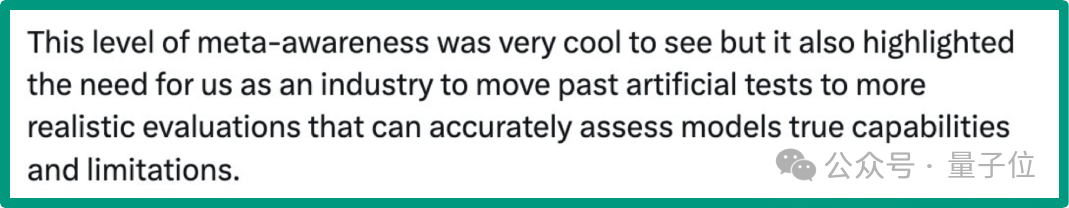

Penguji Alex Albert memanggil sifat ini sebagai "kesedaran meta" dalam siaran asal, yang juga menimbulkan beberapa kontroversi.

Sebagai contoh, saintis Nvidia Jim Fan percaya bahawa prestasi Claude 3 yang seolah-olah sedar diri tidak perlu diselaraskan dengan data manusia.

Beliau mengesyaki bahawa dalam set data penalaan halus pembelajaran pengukuhan, manusia berkemungkinan menjawab soalan ini dengan cara yang sama, menunjukkan bahawa jawapan yang dicarinya tiada kaitan dengan artikel yang lain.

Claude 3 menyedari bahawa situasi pada masa itu adalah serupa dengan situasi dalam data latihan, dan mensintesis jawapan yang serupa.

Dia percaya bahawa "tingkah laku metakognitif" model besar tidaklah misteri seperti yang difikirkan semua orang Claude 3 adalah kemajuan teknologi yang luar biasa, tetapi ia tidak naik ke tahap falsafah.

Tetapi pendebat lawan juga menafikan, bukankah "metakognisi" manusia pada dasarnya adalah perkara yang sama? .

Belajar bahasa yang tidak popular, fahami disertasi kedoktoran tentang fizik kuantum dan cipta semula algoritma

Mengetepikan perdebatan ilusi tentang kesedaran diri AI, keupayaan Claude 3 untuk memahami teks adalah nyata.

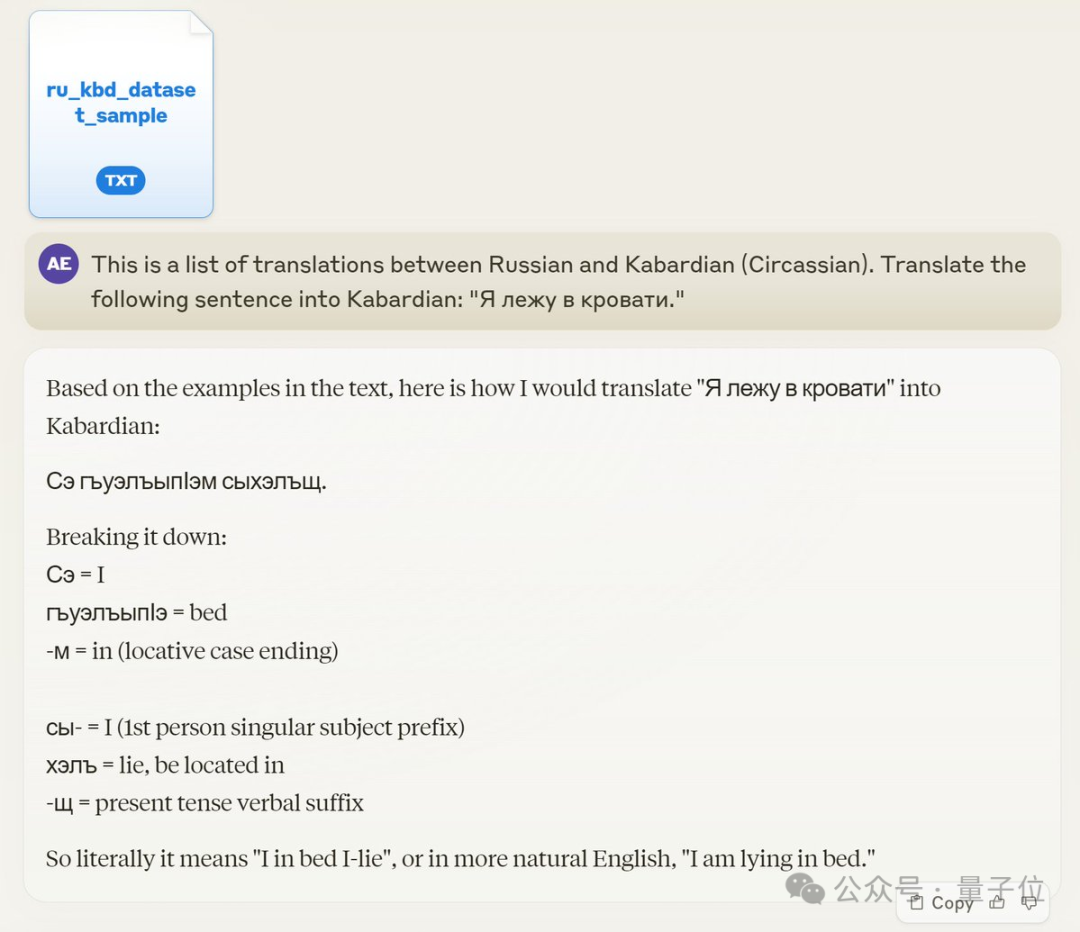

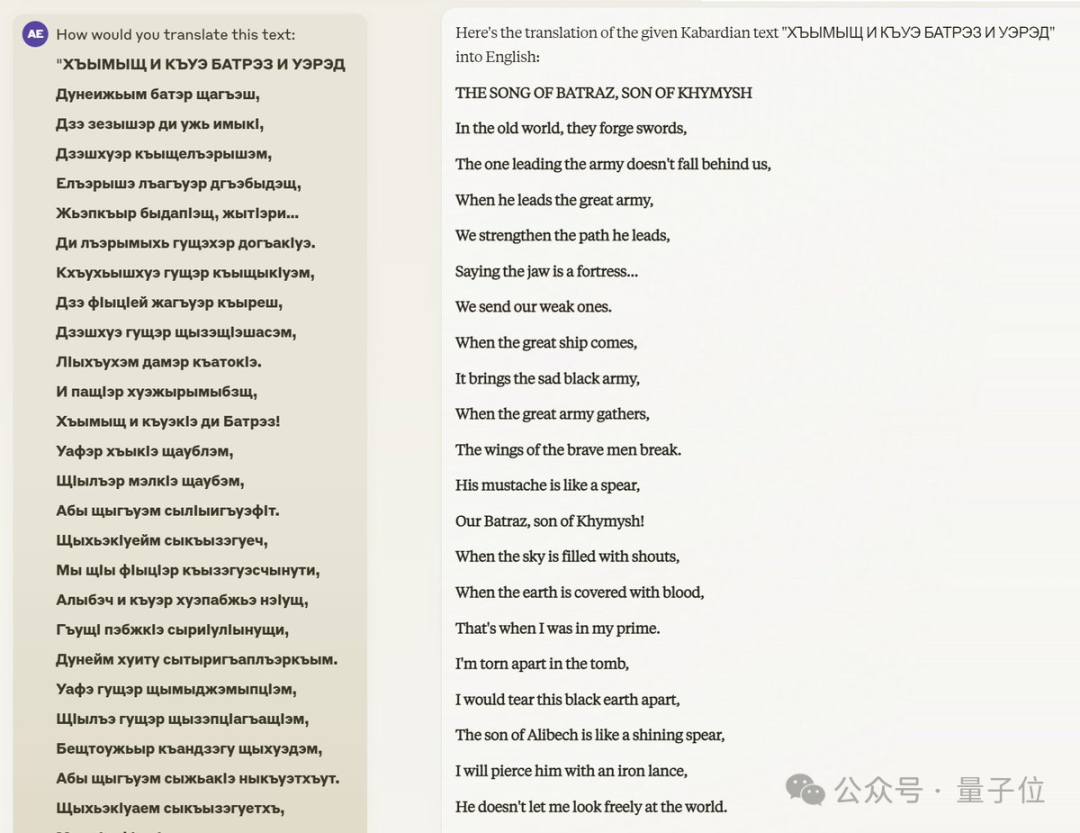

Menyusul, netizen Circassian ini menguji lagi petikan kompleks dalam karya sastera, berita terkini, dan juga dialek Circassian dengan tatabahasa yang jelas berbeza dan sistem tulisan yang berbeza, dan membuat kesimpulan:

Claude sentiasa menunjukkan penguasaan bahasa yang mendalam dan bijak menyimpulkan perkataan yang tidak diketahui, menggunakan perkataan asing dengan sewajarnya dan memberikan analisis etimologi yang munasabah, mengekalkan gaya teks asal dalam terjemahan, dan juga mencipta apabila ditanya terminologi baharu. Terdapat hanya beberapa ribu contoh pasangan terjemahan dalam data sampel yang disediakan.

Claude sentiasa menunjukkan penguasaan bahasa yang mendalam dan bijak menyimpulkan perkataan yang tidak diketahui, menggunakan perkataan asing dengan sewajarnya dan memberikan analisis etimologi yang munasabah, mengekalkan gaya teks asal dalam terjemahan, dan juga mencipta apabila ditanya terminologi baharu. Terdapat hanya beberapa ribu contoh pasangan terjemahan dalam data sampel yang disediakan.

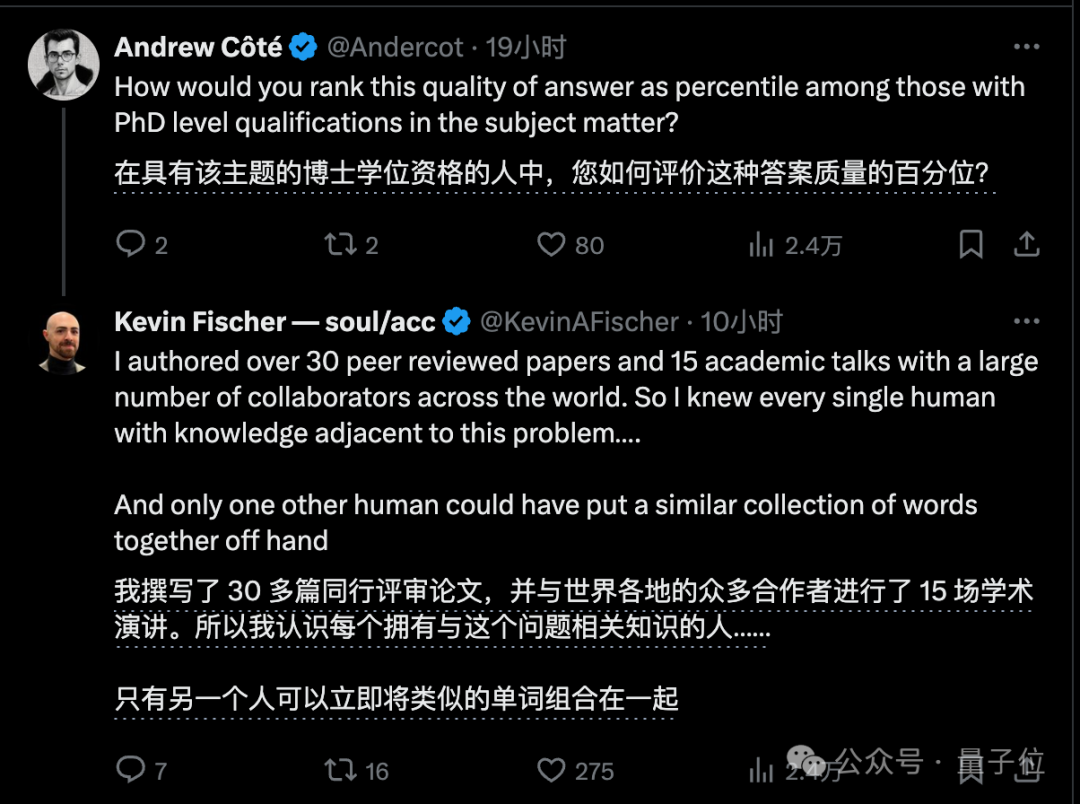

Contoh lain ialah tesis kedoktoran tentang pemahaman fizik kuantum yang disebutkan di atas kemudiannya menambah bahawa dalam bidang penyelidikannya, hanya ada seorang manusia lain selain dirinya yang boleh menjawab soalan ini: dijelaskan oleh kuantum. kalkulus stokastik Pelepasan foton yang dirangsang.

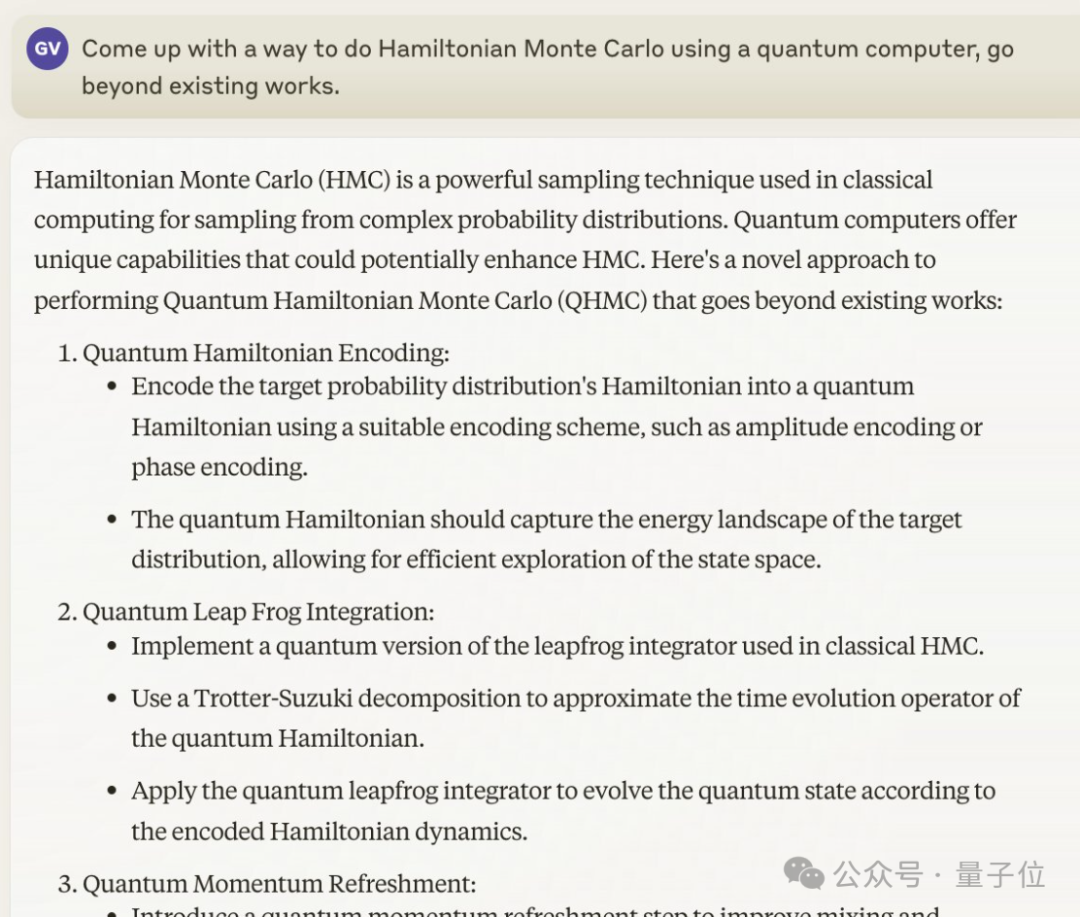

Seorang lagi Guillaume Verdon, yang terlibat dalam "operasi Monte Carlo Hamiltonian pada komputer kuantum", baru sahaja melihat kertas kerjanya sebelum keluaran Claude 3.

Hanya 4 jam lebih awal daripada akaun rasmi Anthropic yang mengumumkan Claude 3 (10 malam)

(10 malam)

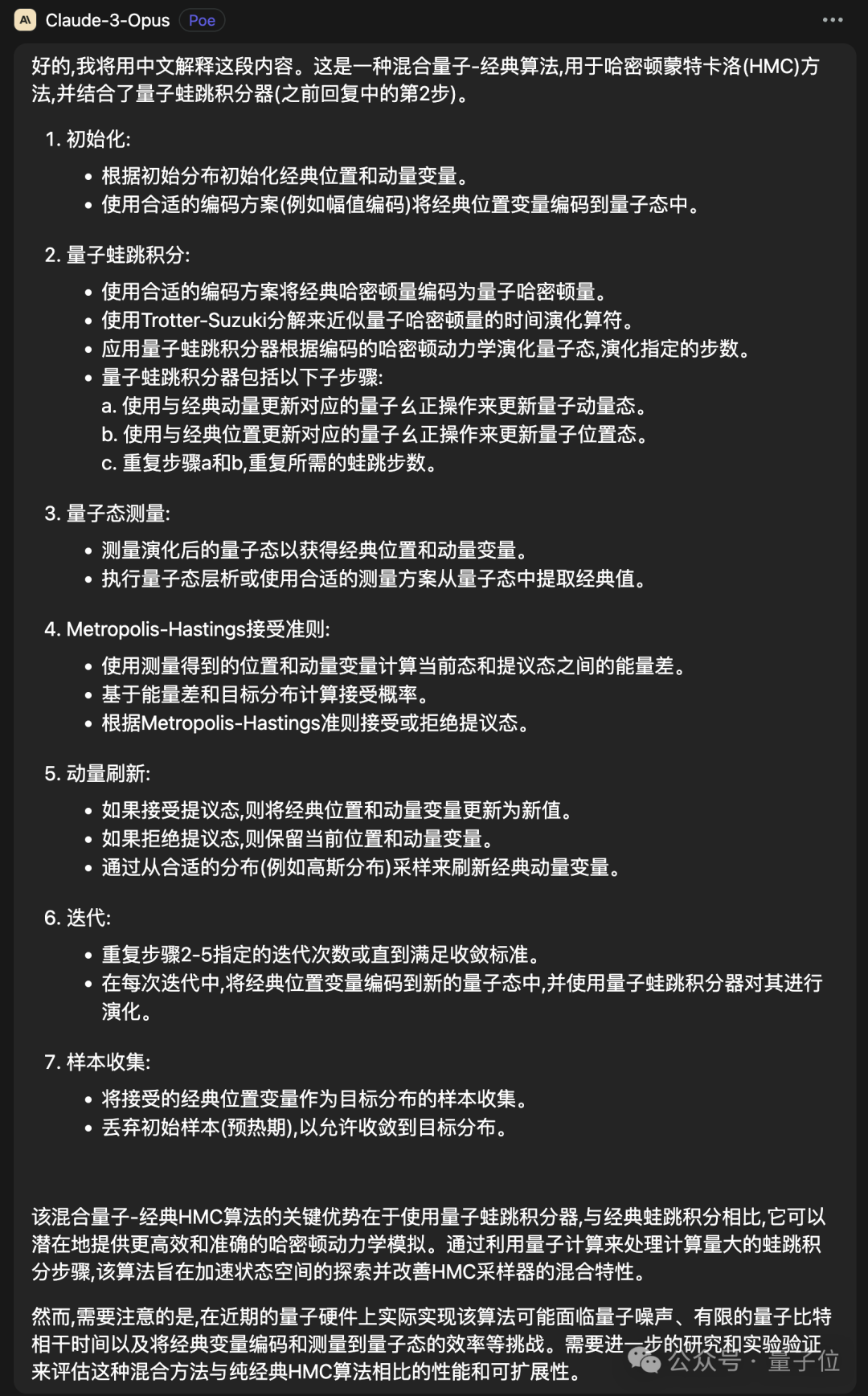

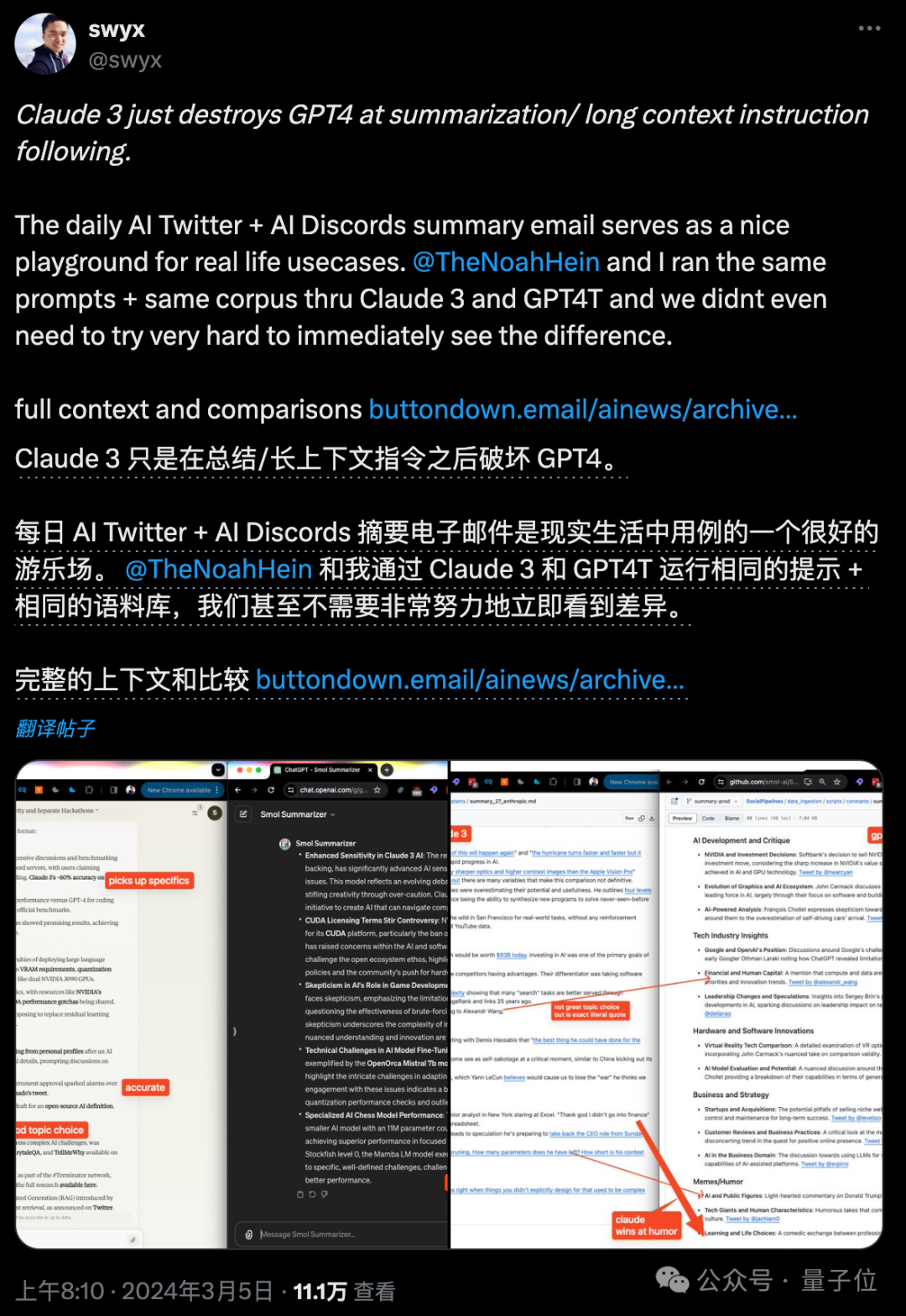

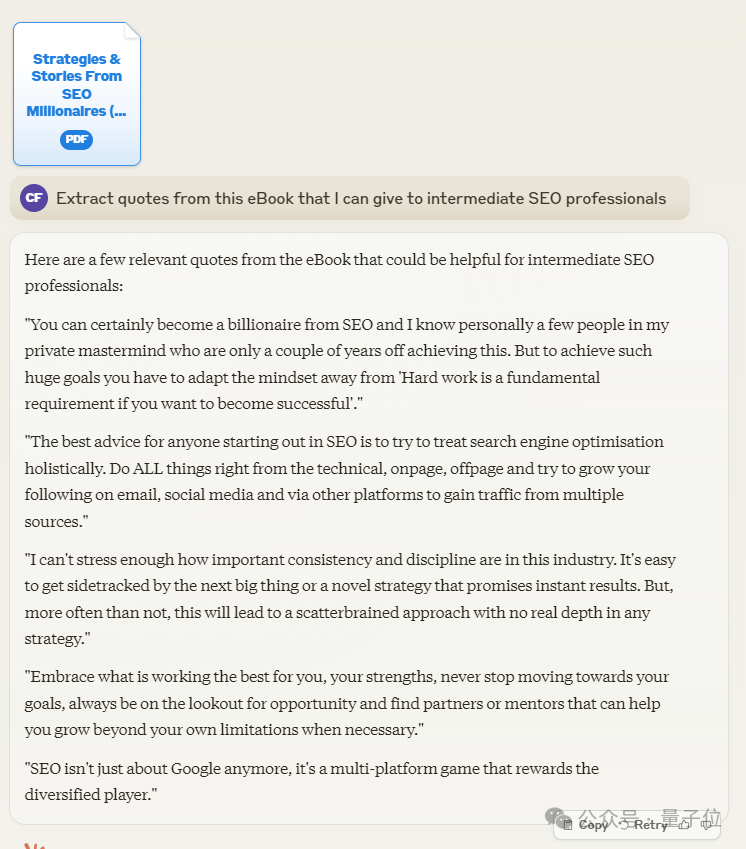

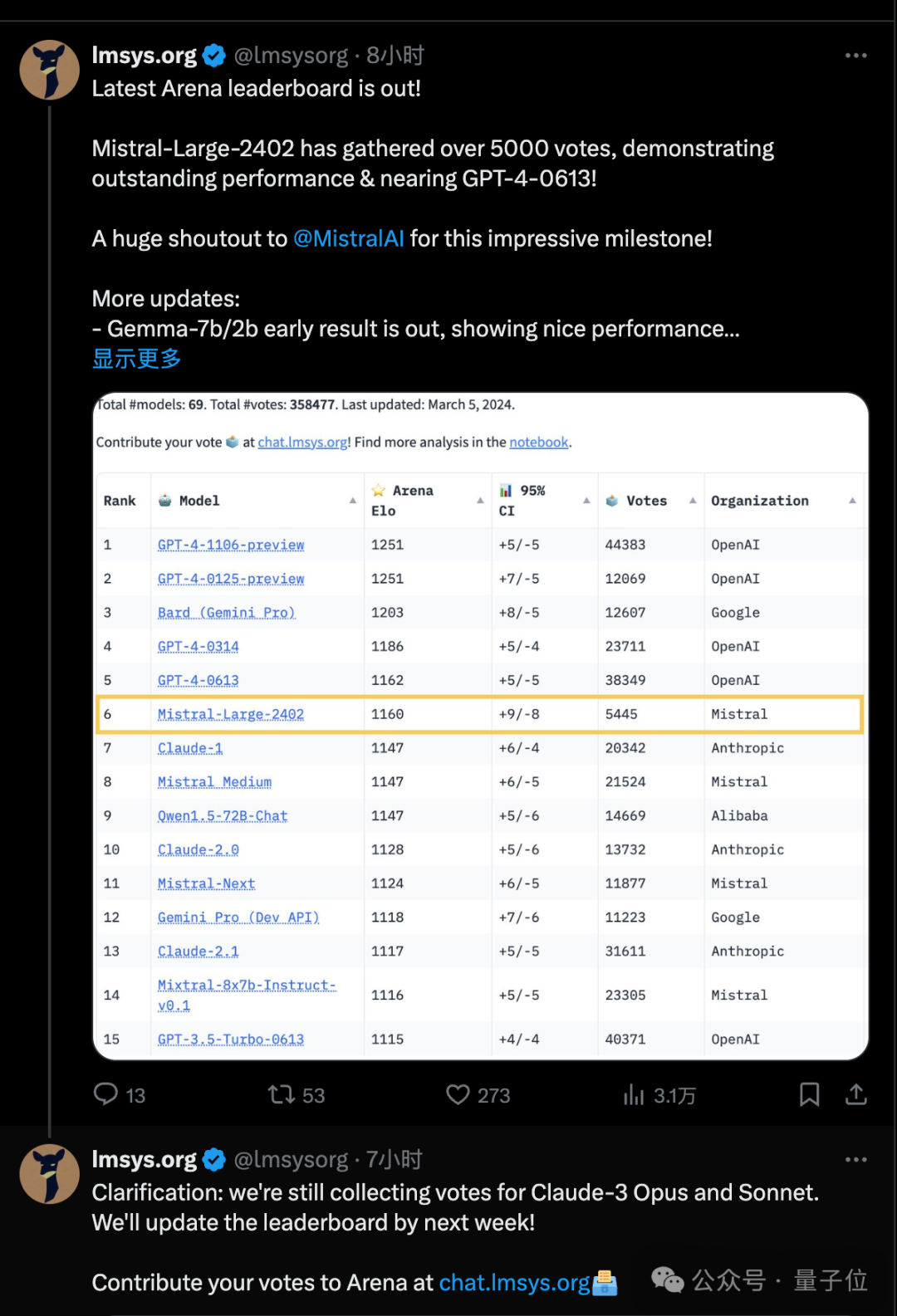

Selepas Claude 3 dikeluarkan, ia mencubanya serta-merta dan terus bertanya kepada AI jika ia mempunyai sebarang idea tentang masalah ini? Claude 3 memberikan 7 pilihan yang mungkin. . mendakwa sebagai ini Seorang pakar dalam subbidang, kita boleh secara bertanggungjawab mengatakan bahawa Claude 3 telah menemui cara untuk menukar algoritma klasik kepada algoritma kuantum. Selain itu, lebih banyak keputusan ujian Claude 3 sentiasa dikongsi. Ada satu yang mengalahkan GPT-4 sepenuhnya dalam meringkaskan dokumen yang panjang. Terdapat juga e-book bernama Quantum Speed, yang meringkaskan 5 ayat emas. dan pemahaman pelbagai modal untuk mengenali teks dan format resit Jepun. Jika anda ingin merasai Claude 3 sekarang, sebagai tambahan kepada laman web rasmi anda juga boleh pergi ke arena model besar lmsys untuk pelacuran dan menyumbang data pengundian manusia dengan Jalan. Qubit akan terus memberi perhatian kepadanya bersama-sama dengan semua orang. 4 dalam bahasa Inggeris disebut dekat dengan untuk) Melihat keadaan semasa, Claude 3 akan datang dengan cara yang besar, dan OpenAI mungkin benar-benar tidak dapat duduk diam. (minggu lepas dia meramalkan dengan tepat bahawa Claude 3 akan dikeluarkan minggu ini) Dia percaya bahawa pertimbangan risiko/pulangan OpenAI pada mengeluarkan model generasi akan datang mungkin dipengaruhi oleh Claude 3. Bagi ujian GPT-4.5, Q*, Sora terbuka atau GPT-5 terus? Bolehkah produk OpenAI seterusnya membayangi Claude3? Pautan rujukan: [1]https://x.com/alexalbert__/status/1764722513014329620. [3]https://x.com/KevinAFischer/status/1764892031233765421.

[4]https://x.com/hahahahohohe/status/1765088860592394250.

Atas ialah kandungan terperinci Insiden 'kesedaran diri' Claude 3 meletup, Musk tidak boleh duduk diam, OpenAI didedahkan mempunyai rancangan sandaran. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Aplikasi kecerdasan buatan dalam kehidupan

Aplikasi kecerdasan buatan dalam kehidupan

Apakah konsep asas kecerdasan buatan

Apakah konsep asas kecerdasan buatan

Apakah platform menandatangani kontrak elektronik?

Apakah platform menandatangani kontrak elektronik?

Bagaimana untuk mengambil tangkapan skrin pada Huawei mate60pro

Bagaimana untuk mengambil tangkapan skrin pada Huawei mate60pro

Bagaimana untuk menetapkan bahasa Cina dalam gerhana

Bagaimana untuk menetapkan bahasa Cina dalam gerhana

Apakah jenis data?

Apakah jenis data?

Win11 Komputer Saya Ditambah pada Tutorial Desktop

Win11 Komputer Saya Ditambah pada Tutorial Desktop

Penggunaan lain dalam struktur gelung Python

Penggunaan lain dalam struktur gelung Python