Apakah kekuatan Google Gemini? Carnegie Mellon University menjalankan perbandingan pihak ketiga yang profesional dan objektif

Untuk memastikan keadilan, semua model menggunakan gesaan dan parameter penjanaan yang sama, serta menyediakan kod yang boleh dihasilkan semula dan hasil yang telus sepenuhnya.

tidak akan menggunakan CoT@32 untuk membandingkan 5-shot seperti sidang akhbar rasmi Google.

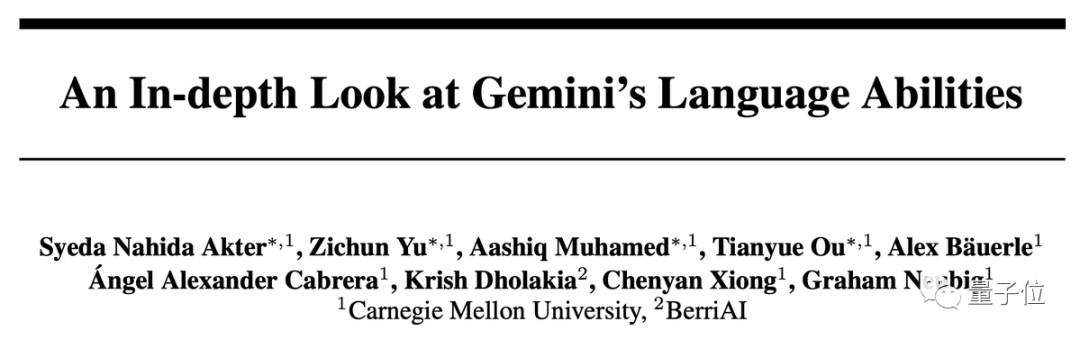

Hasil dalam satu ayat: Versi Gemini Pro hampir tetapi lebih rendah sedikit daripada GPT-3.5 Turbo, dan GPT-4 masih jauh di hadapan.

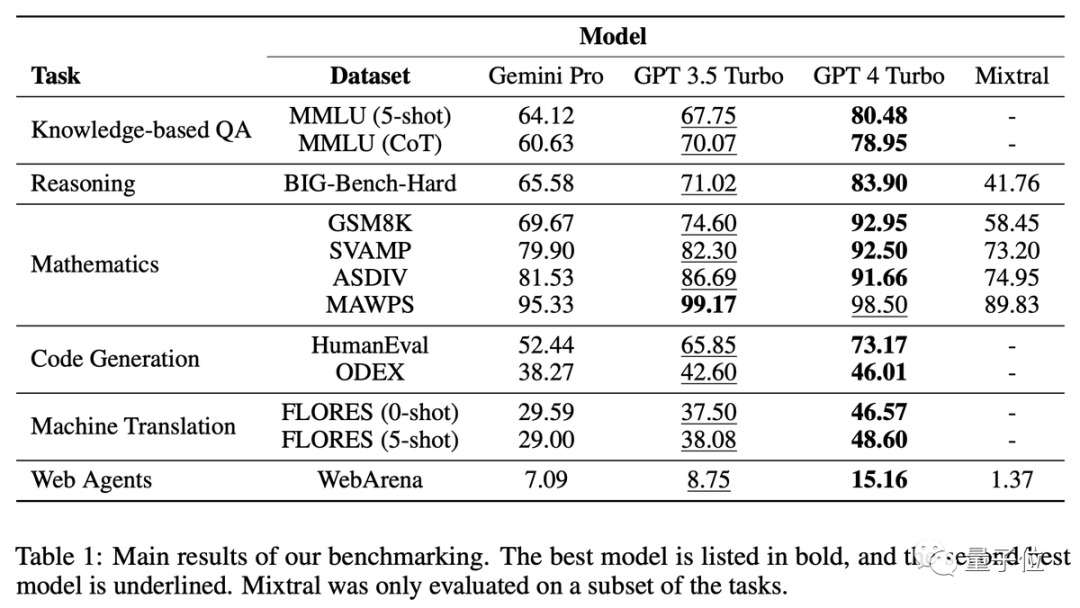

Dalam analisis yang mendalam, kami juga mendapati beberapa ciri aneh Gemini, seperti Saya suka memilih D untuk soalan aneka pilihan...

Ramai penyelidik berkata bahawa Gemini telah dijalankan dengan sangat terperinci hanya beberapa hari selepas dikeluarkan Ini adalah pencapaian yang sangat luar biasa

Ujian ini secara khusus membandingkan 6 tugasan yang berbeza, dan memilih set data yang sepadan untuk setiap tugasan

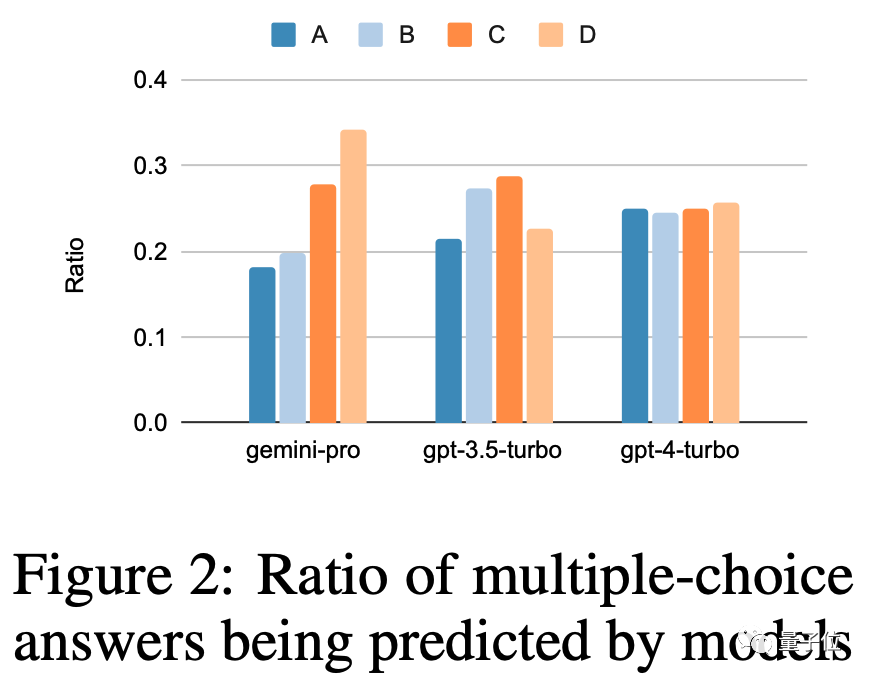

Gemini Pro mengatasi GPT-3.5 dalam penyelidikan keselamatan dan mikroekonomi sekolah menengah, tetapi jurangnya tidak besar, kata pasukan itu Boleh' t mencari sesuatu yang istimewa

Penaakulan: Masalah yang panjang tidak bagus untuk

Siri GPT berprestasi lebih baik apabila menangani masalah yang lebih panjang dan lebih kompleks, berbanding, Gemini Pro berprestasi kurang baik Cemerlang

Terutamanya pada masalah bentuk, GPT-4 Turbo hampir tidak mempunyai kemerosotan prestasi, yang menunjukkan bahawa ia mempunyai keupayaan yang kuat untuk memahami masalah yang kompleks

Analisis berdasarkan jenis masalah, Gemini sangat baik dalam "menjejaki item pertukaran" Ia melakukan kurang baik dalam masalah yang melibatkan orang bertukar barang dan akhirnya memerlukan AI untuk menentukan item yang dimiliki setiap orang

Tugas yang Gemini mahir termasuk memahami pelbagai pengetahuan sukan dunia, memanipulasi timbunan simbol, menyusun perkataan dalam susunan abjad dan menghuraikan jadual

Dalam tugas terjemahan, Gemini enggan menjawab 12 jenis soalan, tetapi kualiti terjemahan yang dijawab semuanya sangat baik, dan prestasi keseluruhan melebihi GPT -4

Gemini enggan menterjemah Bahasa terutamanya melibatkan Latin dan Arab

WebArena mensimulasikan persekitaran Internet untuk AI, termasuk e-dagang, termasuk e-dagang forum, pembangunan kolaboratif GitLab, sistem pengurusan kandungan dan peta dalam talian. AI perlu mencari maklumat dalam persekitaran ini atau menyelesaikan tugas merentas tapak

Gemini tidak berprestasi sebaik GPT-3.5 Turbo secara keseluruhan, tetapi melakukan lebih baik sedikit pada tugas merentas berbilang tapak.

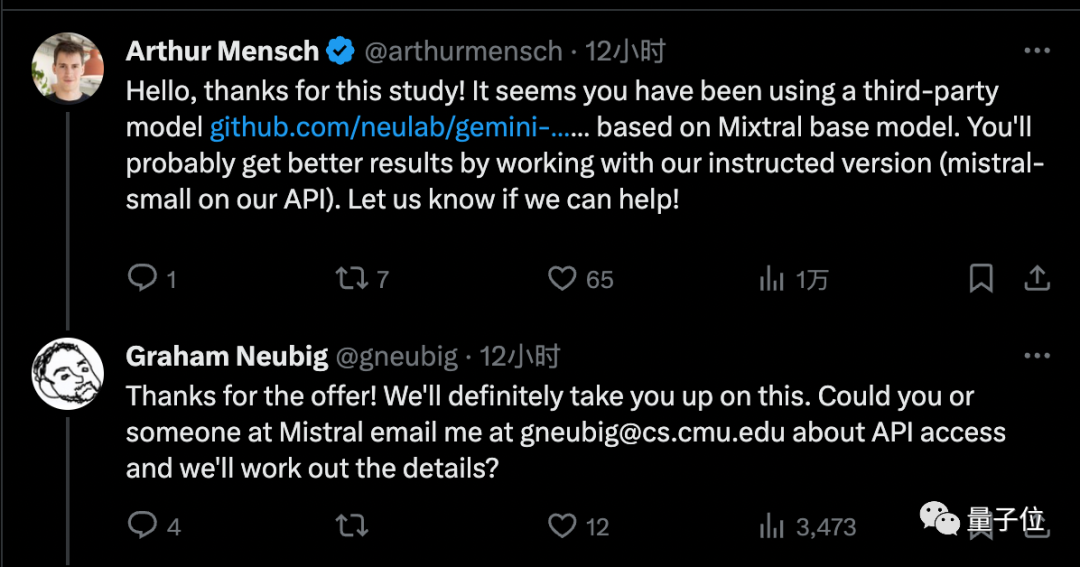

Akhirnya, profesor madya CMU Graham Newbig mengakui beberapa batasan kajian

Pengasas Mistral AI telah menyediakan pasukan akses kepada versi rasmi, yang dia percaya akan membawa hasil yang lebih baik

Walaupun Gemini Pro tidak sebaik GPT-3.5, kelebihannya ialah ia boleh dipanggil tidak lebih daripada 60 kali seminit Ia boleh digunakan secara percuma

Oleh itu, ramai pembangun individu telah menukar kem

Pada masa ini versi tertinggi Gemini, versi Ultra, masih belum dikeluarkan, dan pasukan CMU juga berhasrat untuk meneruskan penyelidikan ini pada masa itu

Adakah anda fikir Gemini Ultra boleh mencapai GPT- Tahap 4?

Artikel ini memperincikan kertas: https://arxiv.org/abs/2312.11444

Pautan rujukan:

[1]https://twitter.com/81ubig3710.2014

Atas ialah kandungan terperinci CMU menjalankan kajian perbandingan terperinci dan mendapati GPT-3.5 lebih unggul daripada Gemini Pro, memastikan prestasi yang adil, telus dan boleh dihasilkan semula. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!