Untuk mengelakkan risiko besar yang mungkin dibawa oleh kecerdasan buatan (AI), OpenAI memutuskan untuk memberikan lembaga pengarah kuasa yang lebih besar untuk mengawasi hal keselamatan dan menjalankan penyeliaan ketat ke atas CEO Sam Altman, yang baru sahaja memenangi pertempuran dalaman bulan lalu

OpenAI mengeluarkan satu siri garis panduan pada hari Isnin, 18 Disember, EST, bertujuan untuk menjejak, menilai, meramal dan mencegah risiko bencana yang ditimbulkan oleh model kecerdasan buatan (AI) yang semakin berkuasa. OpenAI mentakrifkan "risiko bencana" sebagai sebarang risiko yang boleh mengakibatkan kerugian ekonomi ratusan bilion dolar, atau kecederaan serius atau kematian kepada berbilang orang

Panduan 27 halaman, yang dikenali sebagai "Rangka Kerja Kesediaan," menyatakan bahawa walaupun pengurusan tertinggi syarikat, termasuk CEO atau seseorang yang dilantik oleh kepimpinan, percaya bahawa model AI yang akan dikeluarkan adalah selamat, lembaga pengarah syarikat masih mempunyai kuasa untuk Memilih menangguhkan pengeluaran model ini. Ini bermakna walaupun Ketua Pegawai Eksekutif OpenAI bertanggungjawab ke atas keputusan harian, lembaga pengarah akan menyedari penemuan risiko dan mempunyai kuasa untuk memveto keputusan CEO

Rangka Kerja Kesediaan OpenAI mengesyorkan menggunakan pendekatan matriks untuk mendokumenkan tahap risiko yang ditimbulkan oleh model AI termaju merentas pelbagai kategori, selain peruntukan untuk kepimpinan syarikat dan pihak berkuasa lembaga pengarah. Risiko ini termasuk pelakon jahat yang menggunakan model AI untuk mencipta perisian hasad, melancarkan serangan kejuruteraan sosial atau menyebarkan maklumat senjata nuklear atau biologi yang berbahaya

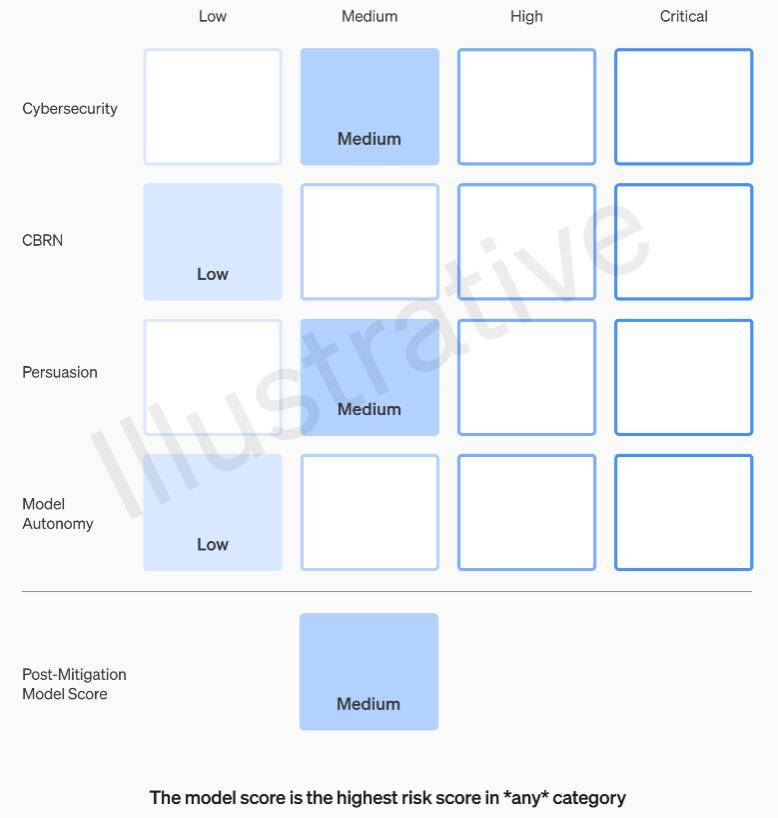

Secara khusus, OpenAI menetapkan ambang risiko dalam empat kategori: keselamatan siber, CBRN (ancaman kimia, biologi, radiologi, nuklear), pemujukan dan autonomi model. Sebelum dan selepas langkah pengurangan risiko dilaksanakan, OpenAI mengklasifikasikan setiap risiko kepada empat tahap: rendah, sederhana, tinggi atau teruk

OpenAI menetapkan bahawa hanya model AI yang dinilai sebagai "sederhana" atau di bawah selepas pengurangan risiko boleh digunakan, dan hanya model yang dinilai sebagai "tinggi" atau di bawah selepas pengurangan risiko boleh terus dibangunkan Jika risiko tidak dapat dikurangkan kepada Di bawah yang teruk tahap, syarikat akan berhenti membangunkan model. OpenAI juga akan mengambil langkah keselamatan tambahan untuk model yang dinilai sebagai risiko tinggi atau risiko teruk sehingga risiko itu dikurangkan

OpenAI membahagikan pengendali isu keselamatan kepada tiga pasukan. Pasukan Sistem Keselamatan memberi tumpuan kepada mengurangkan dan menangani risiko yang ditimbulkan oleh produk semasa seperti GPT-4. Pasukan Penjajaran Super bimbang tentang masalah yang mungkin timbul apabila sistem masa depan melebihi keupayaan manusia. Selain itu, terdapat pasukan baharu yang dipanggil Prepare, diketuai oleh Aleksander Madry, profesor di Jabatan Kejuruteraan Elektrik dan Sains Komputer (EECS) di Massachusetts Institute of Technology (MIT)

Pasukan baharu akan menilai pembangunan dan pelaksanaan model yang mantap. Mereka akan bertanggungjawab secara khusus untuk mengawasi kerja teknikal dan seni bina operasi yang berkaitan dengan keputusan keselamatan. Mereka akan memacu kerja teknikal, menyemak had keupayaan model termaju, dan menjalankan penilaian serta mensintesis laporan berkaitan

Madry berkata bahawa pasukannya akan sentiasa menilai tahap risiko model kecerdasan buatan OpenAI yang paling maju yang masih belum dikeluarkan, dan menyerahkan laporan bulanan kepada Kumpulan Penasihat Keselamatan dalaman (SAG) OpenAI. SAG akan menganalisis kerja pasukan Madry dan memberikan cadangan kepada CEO Altman dan Lembaga Pengarah syarikat

Menurut dokumen panduan yang dikeluarkan pada hari Isnin, Altman dan kepimpinannya boleh memutuskan sama ada untuk mengeluarkan sistem AI baharu berdasarkan laporan ini, tetapi lembaga pengarah mengekalkan kuasa untuk membatalkan keputusan mereka

Pada masa ini, pasukan Madry hanya mempunyai empat orang, tetapi dia bekerja keras untuk merekrut lebih ramai ahli. Dijangkakan bahawa ahli pasukan akan mencapai 15 hingga 20 orang, yang serupa dengan pasukan keselamatan dan pasukan penjajaran hiper yang sedia ada

Madry berharap syarikat AI lain akan menilai risiko model mereka dengan cara yang sama dan berpendapat ini boleh menjadi model untuk peraturan

Atas ialah kandungan terperinci Panduan OpenAI membolehkan lembaga menyekat CEO daripada mengeluarkan model baharu untuk melindungi daripada risiko AI. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Apa itu Ethereum

Apa itu Ethereum

Apakah itu Indeks Baidu

Apakah itu Indeks Baidu

Apakah yang perlu saya lakukan jika pemacu C saya bertukar merah?

Apakah yang perlu saya lakukan jika pemacu C saya bertukar merah?

Apakah algoritma penyulitan gsm?

Apakah algoritma penyulitan gsm?

ungkapan biasa js

ungkapan biasa js

Apakah kaedah untuk memulakan semula aplikasi dalam Android?

Apakah kaedah untuk memulakan semula aplikasi dalam Android?

Penyelesaian untuk Kebenaran ditolak

Penyelesaian untuk Kebenaran ditolak

Cara membuat klon WeChat pada telefon bimbit Huawei

Cara membuat klon WeChat pada telefon bimbit Huawei