Microsoft mengeluarkan model kecerdasan buatan yang dipanggil Phi-2, yang telah menunjukkan keupayaan luar biasa setanding atau bahkan melebihi model yang lebih besar dan lebih matang yang 25 kali lebih besar.

Baru-baru ini Microsoft mengumumkan dalam catatan blog bahawa Phi-2 ialah model bahasa dengan 2.7 bilion parameter Berbanding dengan model asas yang lain, Phi-2 menunjukkan prestasi lanjutan, terutamanya dalam ujian penanda aras yang kompleks Penaakulan yang dibangunkan, pemahaman bahasa. matematik, pengekodan dan kemahiran pengetahuan am. Kini Phi-2 telah dikeluarkan melalui katalog model Microsoft Azure Artificial Intelligence Studio, yang bermaksud penyelidik dan pembangun boleh mengintegrasikannya ke dalam aplikasi pihak ketiga

Phi-2 diasaskan oleh CEO Microsoft Satya Nadella pada 11 Ia pertama kali dikeluarkan di persidangan Ignite pada bulan Mac. Kuasa produk datang daripada apa yang dipanggil oleh Microsoft sebagai data "kualiti buku teks" yang direka khas untuk pengetahuan dan juga menggunakan teknik cerapan daripada model lain

Phi-2 adalah unik kerana ia mempunyai sebelumnya Kuasa model selalunya rapat. berkaitan dengan saiz parameternya. Secara umumnya, model dengan lebih banyak parameter bermakna keupayaan yang lebih berkuasa. Walau bagaimanapun, kemunculan Phi-2 telah mengubah konsep tradisional ini

Microsoft berkata bahawa Phi-2 telah menunjukkan keupayaan untuk memadankan atau bahkan mengatasi model asas yang lebih besar dalam beberapa ujian penanda aras. Penanda aras ini termasuk 7 bilion parameter Mistral AI Mistral, 13 bilion parameter Platform Meta Llama 2, malah melebihi 70 bilion parameter Llama-2 dalam beberapa penanda aras

Pernyataan yang mengejutkan mungkin , prestasinya malah mengatasi Gemini Nano Google, yang paling model cekap dalam siri Gemini yang dikeluarkan minggu lepas. Gemini Nano direka untuk tugasan pada peranti dan boleh dijalankan pada telefon pintar, membolehkan ciri seperti ringkasan teks, pembacaan pruf lanjutan, pembetulan tatabahasa dan balasan pintar kontekstual

Penyelidik Microsoft mengatakan bahawa ujian yang terlibat dalam Phi-2 adalah sangat luas, Termasuk pemahaman bahasa, penaakulan, matematik, cabaran pengekodan dan banyak lagi.

Syarikat mengatakan bahawa sebab Phi-2 mencapai keputusan yang sangat baik adalah kerana ia dilatih dengan data peringkat buku teks yang dipilih dengan teliti yang direka untuk mengajar penaakulan, pengetahuan dan akal, yang bermaksud Ia boleh belajar lebih banyak daripada maklumat yang kurang. Penyelidik Microsoft juga menggunakan teknik yang membolehkan pengetahuan diperoleh daripada model yang lebih kecil.

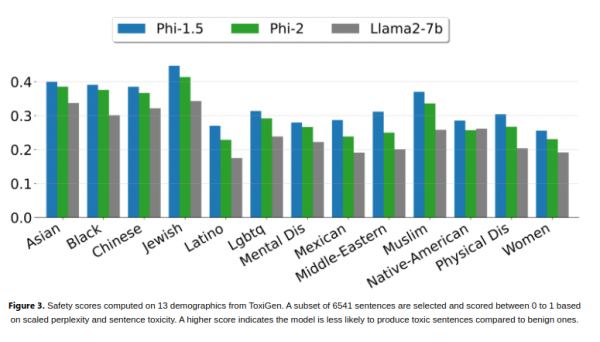

Para penyelidik menegaskan bahawa perlu diperhatikan bahawa Phi-2 masih mampu mencapai prestasi yang kukuh tanpa menggunakan teknik seperti pembelajaran pengukuhan atau penalaan halus pengajaran berdasarkan maklum balas manusia. Teknik ini sering digunakan untuk memperbaiki tingkah laku model kecerdasan buatan. Walaupun tidak menggunakan teknik ini, Phi-2 masih menunjukkan prestasi yang baik dalam mengurangkan berat sebelah dan kandungan berbahaya berbanding model sumber terbuka lain yang melakukannya. Syarikat percaya ini disebabkan oleh penyesuaian perbalahan data

Penyelidik Microsoft memanggil Phi-2 versi terbaharu siri "model bahasa kecil (SLM)". Phi-1, model pertama dalam siri ini dan pertama kali dikeluarkan awal tahun ini, mempunyai 1.3 bilion parameter dan diperhalusi untuk tugas pengekodan Python asas. Pada September tahun ini, Microsoft melancarkan Phi-1.5, model dengan 1.3 bilion parameter dan dilatih menggunakan sumber data baharu, termasuk pelbagai teks sintetik yang dijana dengan pengaturcaraan bahasa semula jadi

Microsoft berkata Phi-2 Kecekapannya yang tinggi menjadikannya ideal. platform untuk penyelidik meneroka bidang seperti meningkatkan keselamatan kecerdasan buatan, kebolehtafsiran dan pembangunan etika model bahasa.

Atas ialah kandungan terperinci Microsoft memperkenalkan model 2.7 bilion parameter Phi-2, yang mengatasi banyak model bahasa besar. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!