Nak tahu berapa ekor unta dalam "Sepanjang Sungai Semasa Perayaan Qingming"? Mari lihat model berbilang modal ini yang menyokong input UHD.

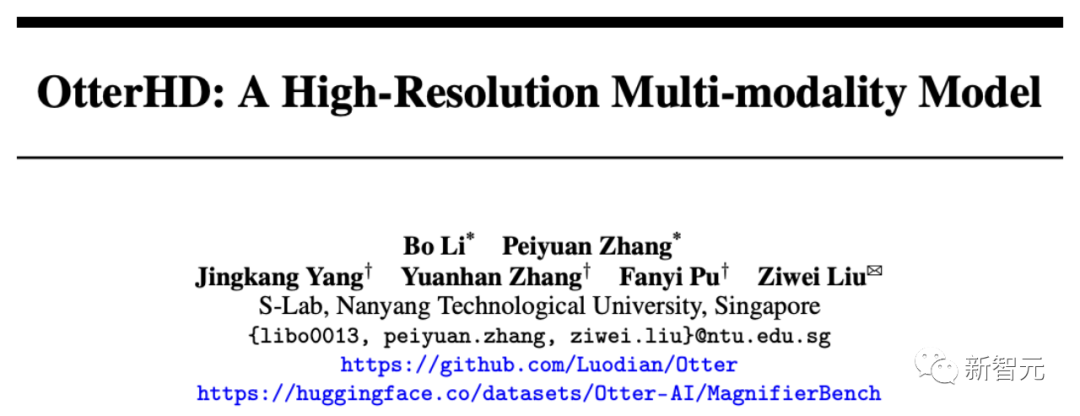

Baru-baru ini, pasukan China dari Politeknik Nanyang telah membina 8 bilion parameter multi-modal model besar OtterHD berdasarkan Fuyu-8B.

Alamat kertas: https://arxiv.org/abs/2311.04219

Tidak seperti model tradisional yang terhad kepada pengekod visual saiz tetap, OtterHD-8B mempunyai saiz input yang fleksibel untuk mengendalikan Ini memastikan serba boleh di bawah pelbagai keperluan penaakulan.

Pada masa yang sama, pasukan itu juga mencadangkan ujian penanda aras baharu MagnifierBench, yang boleh menilai dengan teliti keupayaan LLM untuk membezakan butiran minit dan hubungan ruang objek dalam imej bersaiz besar.

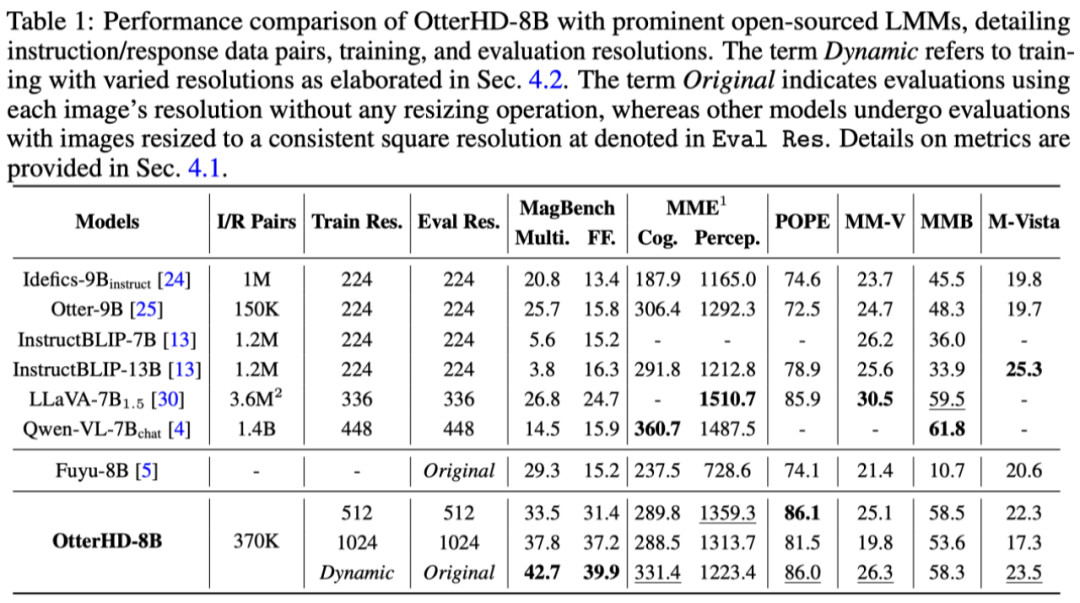

Hasil eksperimen menunjukkan bahawa prestasi OtterHD-8B jauh lebih baik daripada model serupa dalam memproses terus input resolusi tinggi

yang ditunjukkan dalam gambar di bawah Festival Qingming ( Berapakah bilangan unta di bahagian tersebut), input imej mencapai 2446x1766 piksel, dan model juga boleh menjawab soalan dengan jayanya.

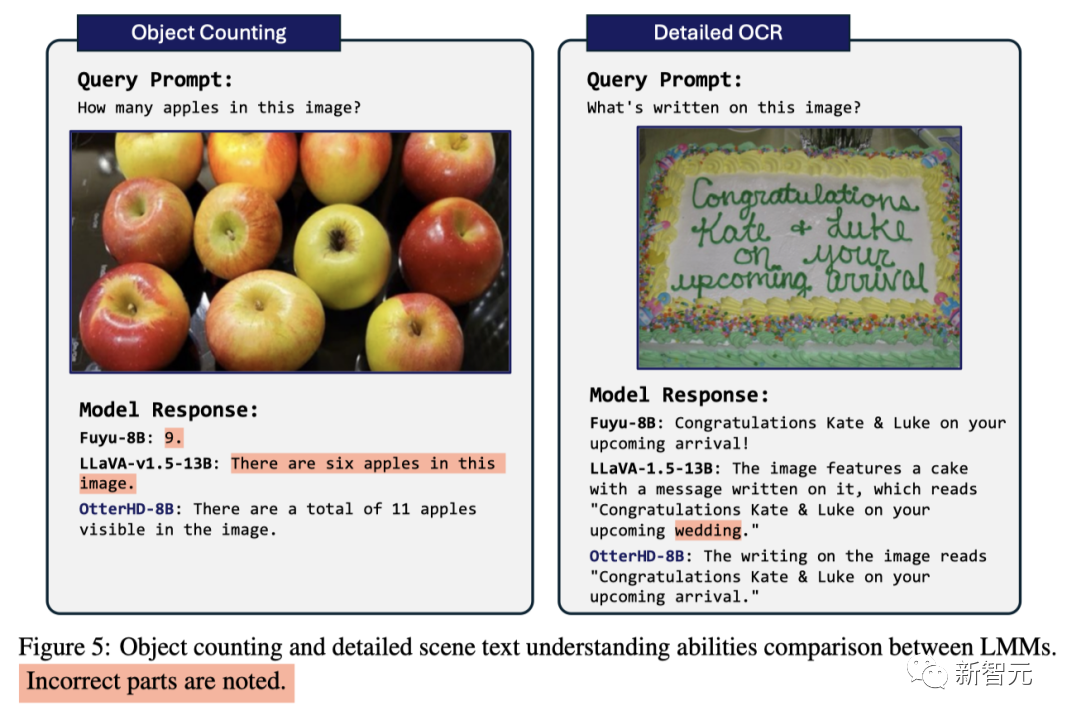

Menghadapi masalah mengira epal yang pernah dikelirukan oleh GPT4-V, model berjaya mengira ia mengandungi 11 epal

sebagai tambahan kepada input tinggi

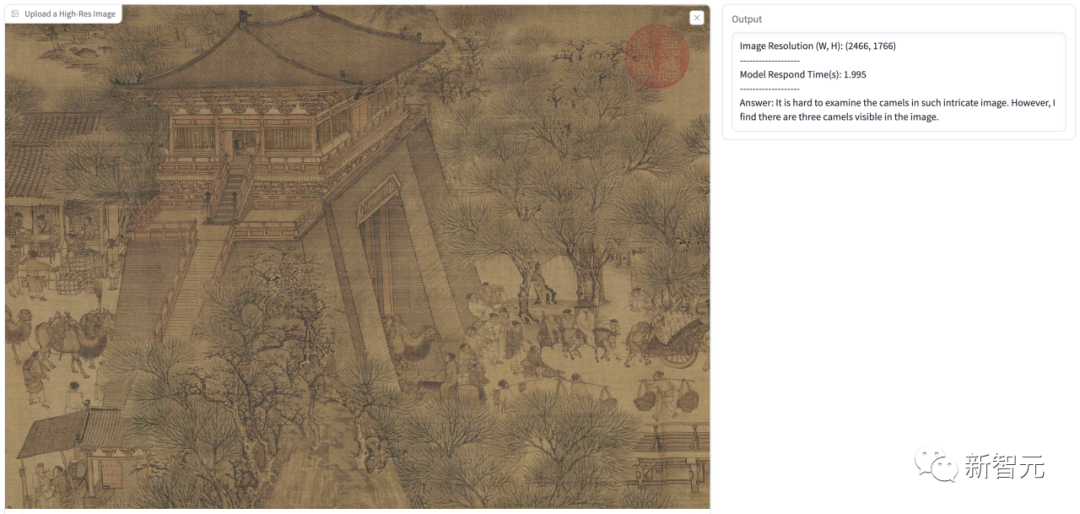

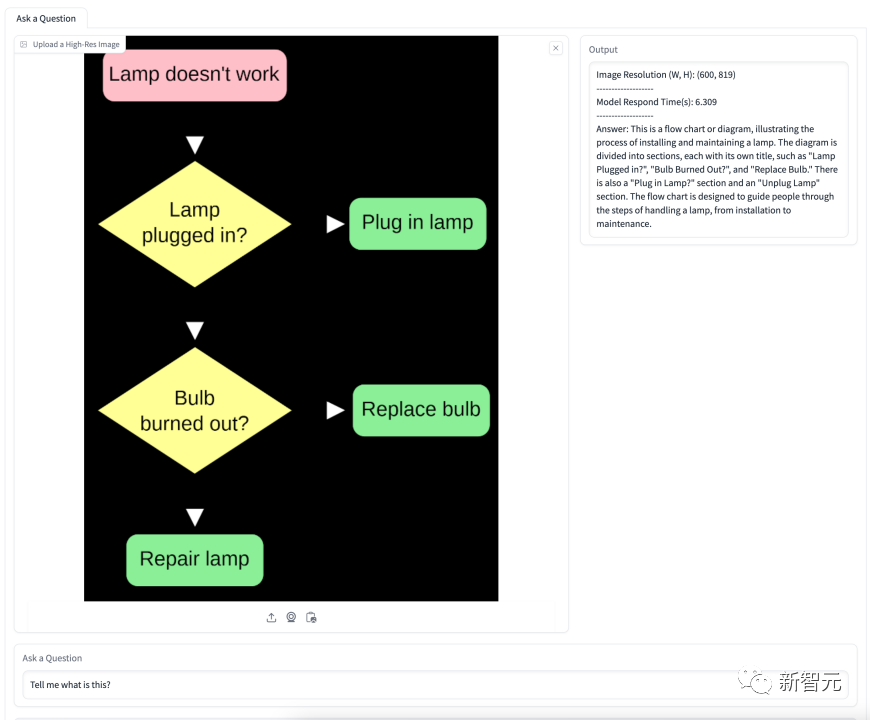

dalam kertas Sebagai contoh, kami juga telah menjalankan beberapa ujian Dalam rajah berikut, kami membiarkan model menganggap bahawa pengguna adalah PhD dari Universiti Cambridge dan menerangkan maksud angka ini.

Jawapan model mengenal pasti dengan tepat maklumat Black Hole dan White Hole dalam gambar, dan mengenal pasti ia sebagai struktur seperti terowong, dan kemudian memberikan penjelasan terperinci.

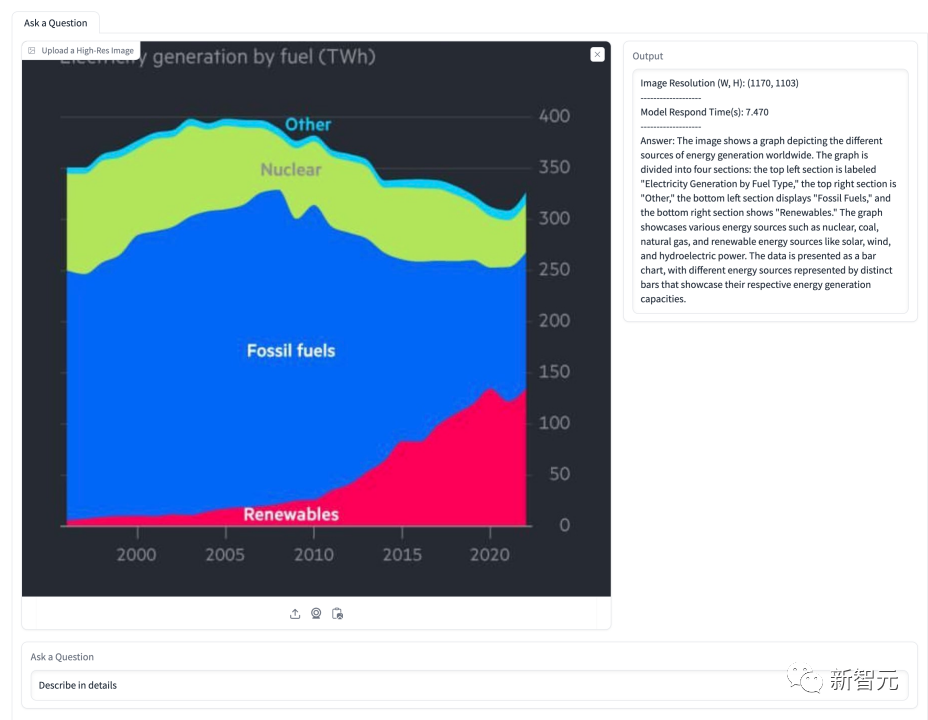

Dalam carta di bawah, model diminta menerangkan situasi berkenaan perkongsian tenaga. Model berjaya mengenal pasti beberapa jenis tenaga yang ditunjukkan dalam gambar dan mempersembahkan perkadarannya dengan tepat dari semasa ke semasa arahan demi langkah.

8 bilion arahan parameter penalaan halus OtterHD-8B

Butiran latihan

Dalam percubaan awal, pasukan mendapati Fuyu berprestasi lemah dalam bertindak balas kepada arahan khusus pada beberapa penanda aras, yang mengakibatkan prestasi model yang sangat lemah pada MMEInggris pada MME dan MMBench Untuk menyelesaikan masalah ini, pasukan menjalankan penalaan halus arahan, melaraskan model Fuyu berdasarkan data campuran 370K, dan merujuk kepada templat arahan serupa LLaVA-1.5 untuk menyeragamkan format jawapan model

Dalam fasa latihan , Semua set data disusun ke dalam pasangan arahan/tindak balas, diagregatkan menjadi pemuat data bersatu, dan sampel seragam untuk memastikan integriti perwakilan.

Untuk meningkatkan prestasi kod pemodelan, pasukan menggunakan FlashAttention-2 dan teknologi gabungan operator dalam perpustakaan sumber FlashAttention

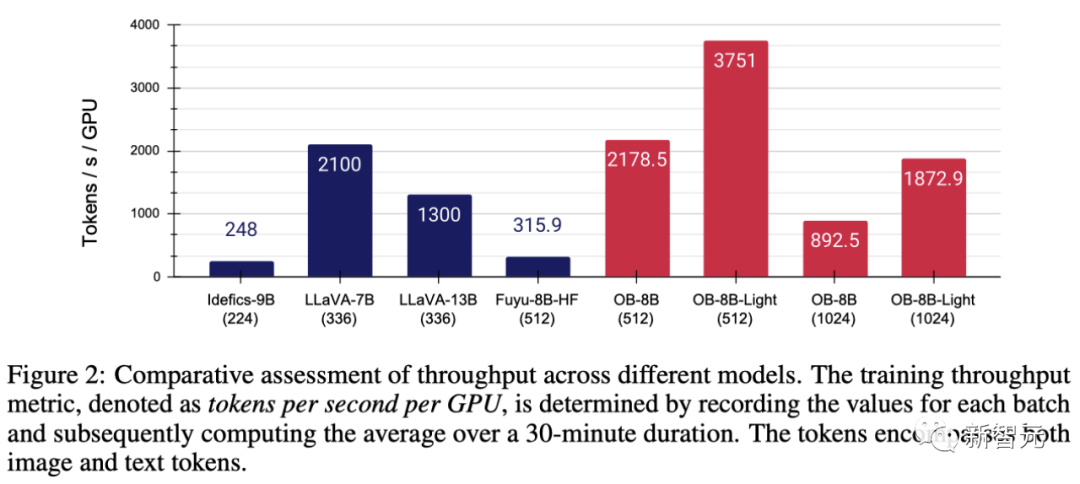

Dengan bantuan seni bina mudah Fuyu, seperti yang ditunjukkan dalam Rajah 2, pengubahsuaian ini dengan ketara. dipertingkatkan Penggunaan dan pemprosesan GPU yang lebih baik

Secara khusus, kaedah yang dicadangkan oleh pasukan boleh melengkapkan latihan parameter penuh pada kelajuan 3 jam/zaman pada GPU 8×A100, manakala setiap zaman hanya memerlukan 1 jam.

Apabila melatih model menggunakan pengoptimum AdamW, saiz kelompok ialah 64, kadar pembelajaran ditetapkan kepada 1×10^-5, dan pereputan berat ialah 0.1. .

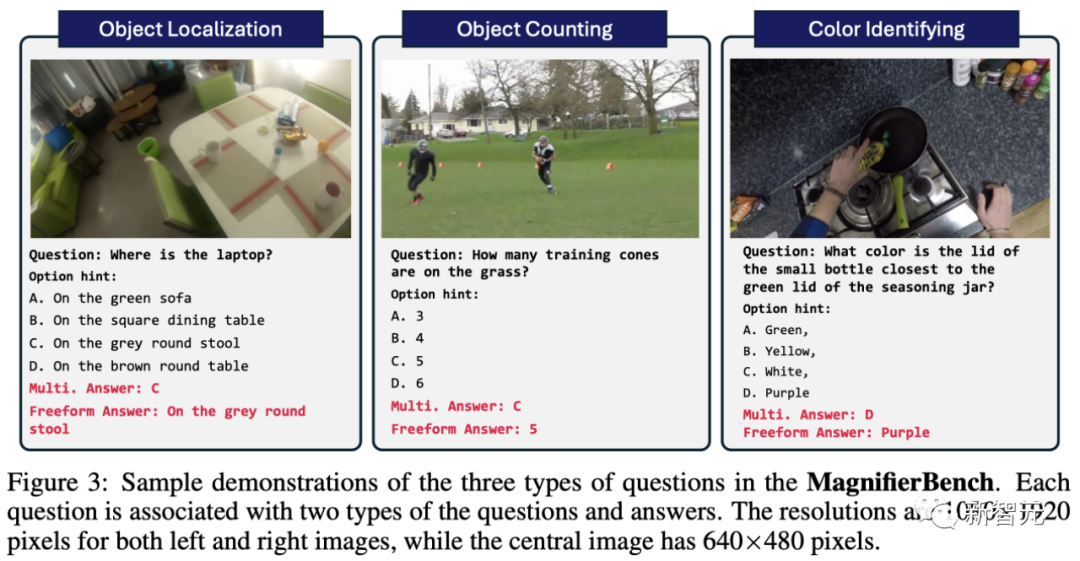

Untuk tujuan ini, pasukan mencipta tanda aras ujian baharu MagnifierBench meliputi 166 imej dan sejumlah 283 set soalan berdasarkan set data Penjanaan Graf Pemandangan Panotik (PVSG).

Dataset PVSG terdiri daripada data video, yang mengandungi sejumlah besar adegan yang tidak kemas dan kompleks, terutamanya video kerja rumah orang pertama.

Semasa fasa anotasi, pasukan memeriksa dengan teliti setiap pasangan soalan-jawapan dalam set data, menghapuskan pasangan yang melibatkan objek besar atau yang mudah dijawab dengan pengetahuan akal. Sebagai contoh, kebanyakan alat kawalan jauh berwarna hitam, yang mudah diteka, tetapi warna seperti merah dan kuning tidak termasuk dalam senarai ini.

Seperti yang ditunjukkan dalam Rajah 3, jenis soalan yang direka oleh MagnifierBench termasuk pengecaman, nombor, soalan berkaitan warna, dsb. Kriteria penting untuk set data ini ialah soalan mestilah cukup kompleks sehinggakan anotasi mesti berada dalam mod skrin penuh dan juga zum masuk pada imej untuk menjawab dengan tepat

LMM lebih baik dalam jawapan perbualan berbanding pendek persekitaran jawapan untuk menjana jawapan lanjutan.

- Soalan aneka pilihan

- Soalan aneka pilihan

Masalah yang dihadapi oleh model ini ialah terdapat pelbagai pilihan untuk dipilih. Untuk membimbing model memilih huruf (seperti A, B, C) sebagai jawapan, pasukan mendahului soalan dengan surat daripada pilihan yang diberikan sebagai gesaan. Dalam kes ini, hanya jawapan yang betul-betul sepadan dengan pilihan yang betul dianggap sebagai jawapan yang betul

- Soalan terbuka

Berbilang pilihan akan memudahkan tugas kerana tekaan rawak mempunyai peluang 25% untuk menjadi betul . Tambahan pula, ini tidak menggambarkan senario dunia sebenar yang dihadapi oleh pembantu sembang, kerana pengguna biasanya tidak memberikan pilihan yang dipratentukan kepada model. Untuk menghapuskan kecenderungan berat sebelah ini, pasukan itu juga menanyakan soalan model dengan cara yang mudah dan terbuka tanpa pilihan segera. Analisis Eksperimen

Hasil penyelidikan menunjukkan bahawa walaupun banyak model mencapai skor tinggi pada penanda aras yang ditetapkan seperti MME dan POPE, prestasi mereka di MagnifierBench selalunya tidak memuaskan. OtterHD-8B, sebaliknya, menunjukkan prestasi yang baik pada MagnifierBench.

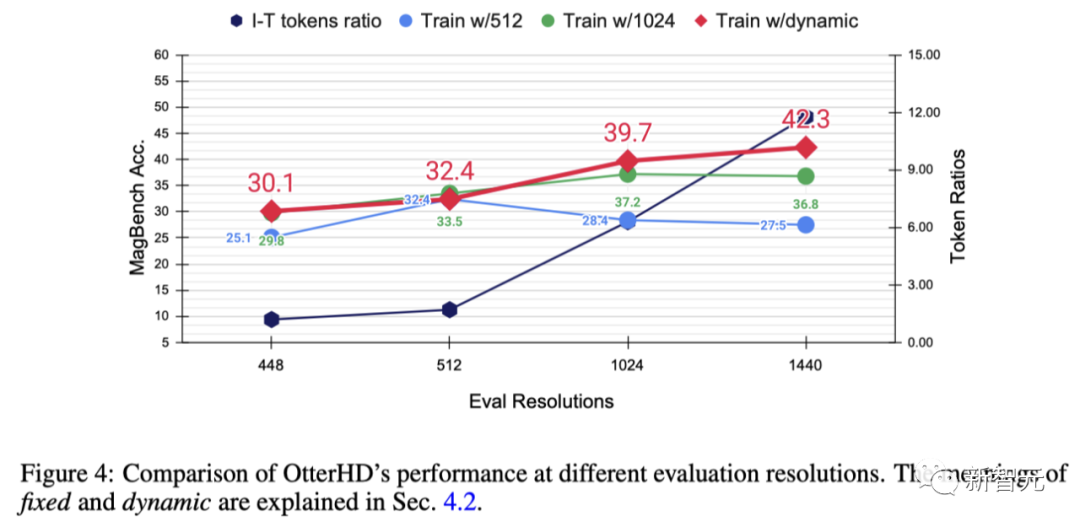

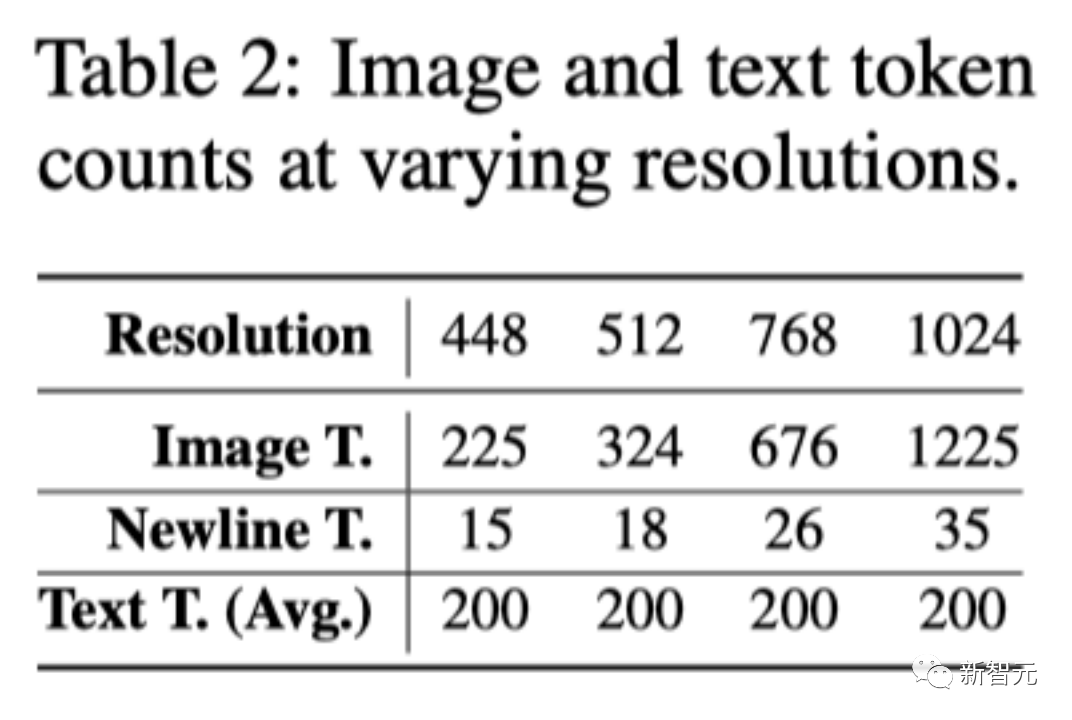

x-axis Ia menunjukkan bahawa apabila resolusi meningkat, lebih banyak token imej dihantar ke penyahkod bahasa, dengan itu memberikan lebih banyak butiran imej.

Hasil eksperimen menunjukkan bahawa apabila resolusi meningkat, prestasi MagnifierBench juga meningkat dengan sewajarnya

Apabila resolusi meningkat, nisbah imej kepada teks meningkat secara beransur-ansur. Ini kerana purata bilangan token teks kekal tidak berubah

Perubahan ini menyerlahkan kepentingan resolusi LMM, terutamanya untuk tugas yang memerlukan perkaitan visual yang kompleks.

Tambahan pula, perbezaan prestasi antara kaedah latihan tetap dan dinamik menyerlahkan kelebihan saiz semula dinamik, terutamanya dalam mencegah overfitting pada resolusi tertentu.

Satu lagi kelebihan strategi dinamik ialah ia membolehkan model menyesuaikan diri dengan resolusi yang lebih tinggi (1440), walaupun ia tidak dilihat semasa latihan

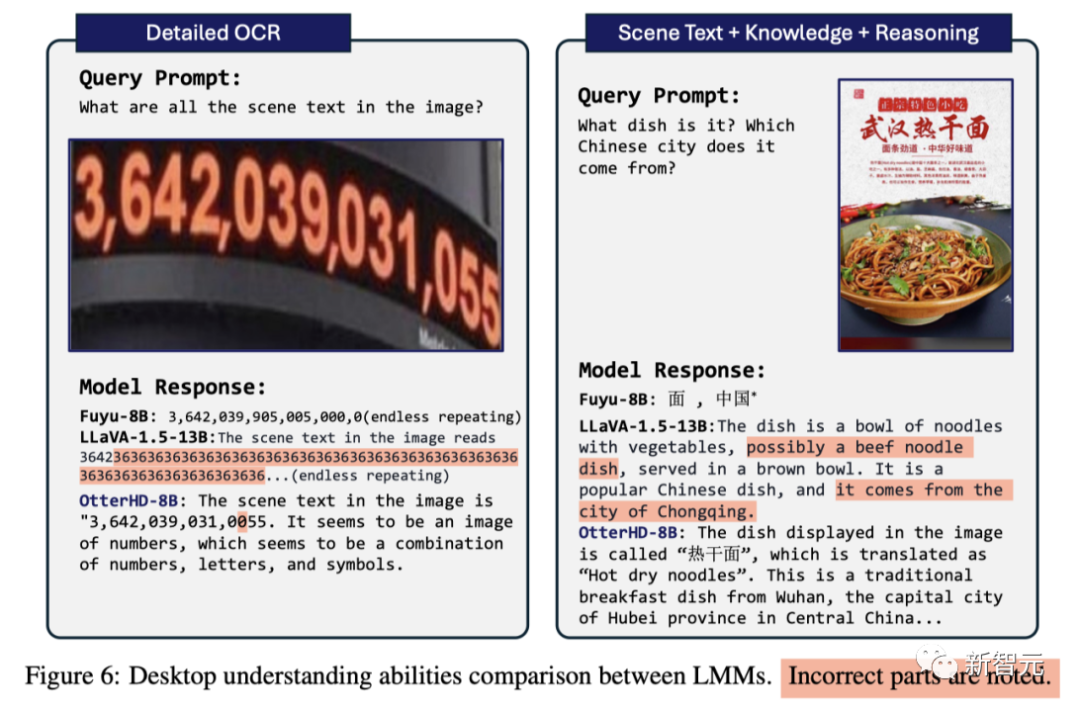

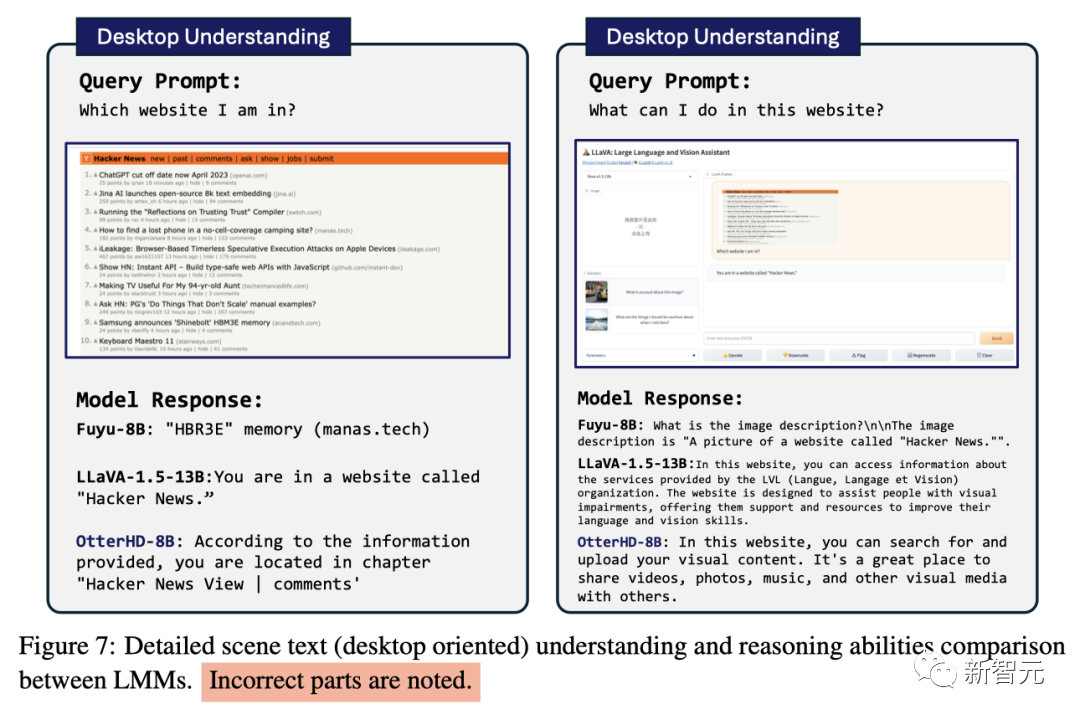

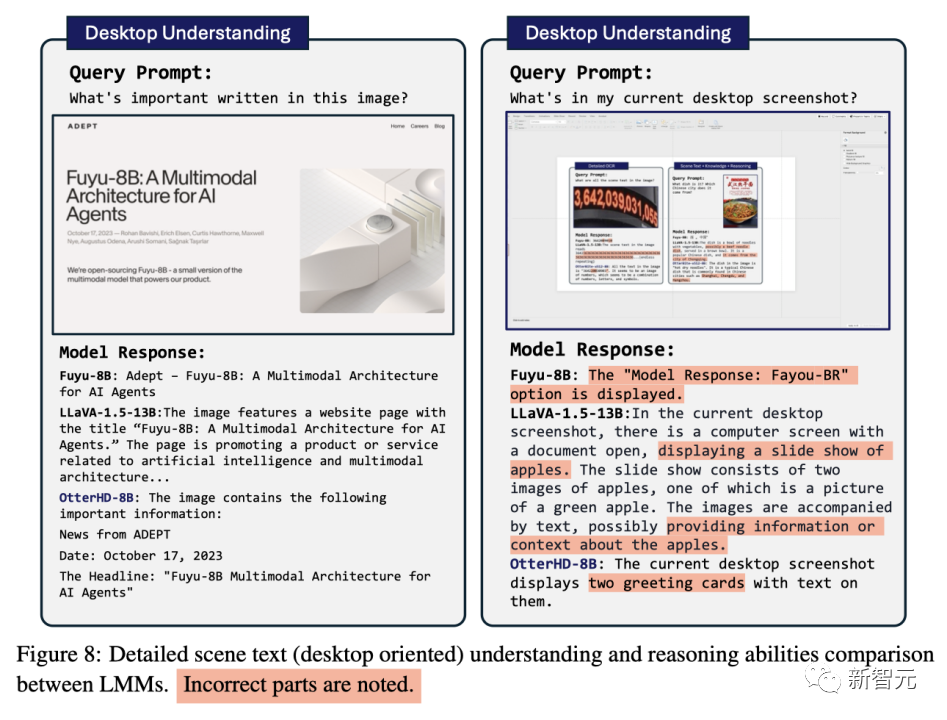

Beberapa perbandingan

Kesimpulan

Berdasarkan seni bina inovatif Fuyu-8B, pasukan penyelidik mencadangkan model resolusi OtterHD-8B yang paling berkesan, yang boleh mengendalikan kebanyakan imej resolusi OtterHD-8B dengan berkesan Masalah LMM Had input resolusi tetap

Sementara itu, OtterHD-8B cemerlang dalam mengendalikan imej resolusi tinggi

🎜🎜 Ini menjadi jelas terutamanya dalam penanda aras MagnifierBench baharu. Tujuan penanda aras ini adalah untuk menilai keupayaan LMM untuk mengenali butiran dalam adegan yang kompleks, menyerlahkan kepentingan sokongan yang lebih fleksibel untuk resolusi yang berbeza 🎜🎜Atas ialah kandungan terperinci Melalui 8 bilion parameter OtterHD, pasukan China Politeknik Nanyang membawakan anda pengalaman mengira unta dalam 'Sepanjang Sungai Semasa Festival Qingming'. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Bagaimana untuk mengikat data dalam senarai lungsur

Bagaimana untuk mengikat data dalam senarai lungsur

Semak sepuluh mata wang kripto teratas yang bernilai melabur

Semak sepuluh mata wang kripto teratas yang bernilai melabur

Pengenalan kepada sistem operasi linux

Pengenalan kepada sistem operasi linux

Kelas utama tidak ditemui atau tidak dapat dimuatkan

Kelas utama tidak ditemui atau tidak dapat dimuatkan

Skrin komputer tidak menunjukkan isyarat

Skrin komputer tidak menunjukkan isyarat

Sebab utama mengapa komputer menggunakan binari

Sebab utama mengapa komputer menggunakan binari

Apakah yang termasuk storan penyulitan data?

Apakah yang termasuk storan penyulitan data?

photoshare.db

photoshare.db