Kini, AI boleh mentafsir isyarat otak dalam masa nyata!

Ini bukan sensasi, tetapi kajian baharu oleh Meta, yang boleh meneka gambar yang anda lihat dalam masa 0.5 saat berdasarkan isyarat otak, dan menggunakan AI untuk memulihkannya dalam masa nyata.

Sebelum ini, walaupun AI telah dapat memulihkan imej daripada isyarat otak dengan agak tepat, masih terdapat pepijat - ia tidak cukup pantas.

Untuk tujuan ini, Meta telah membangunkan model penyahkodan baharu, yang meningkatkan kelajuan pengambilan imej AI sahaja sebanyak 7 kali Ia hampir "semerta" membaca perkara yang dilihat orang dan meneka apa yang mereka lakukan melihat .

kelihatan seperti lelaki berdiri Selepas beberapa pemulihan, AI sebenarnya mentafsirkan "lelaki berdiri":

#🎜🎜 #图#🎜🎜. #LeCun mengemukakan bahawa penyelidikan tentang membina semula visual dan input lain daripada isyarat otak MEG sememangnya hebat.

#🎜🎜 #图#🎜🎜. #LeCun mengemukakan bahawa penyelidikan tentang membina semula visual dan input lain daripada isyarat otak MEG sememangnya hebat.

Picture Jadi, bagaimanakah Meta membenarkan AI "membaca otak dengan cepat"?

Jadi, bagaimanakah Meta membenarkan AI "membaca otak dengan cepat"?

Bagaimana untuk mentafsir penyahkodan aktiviti otak?

Satu ialah fMRI (pengimejan resonans magnetik berfungsi), yang boleh menjana imej aliran darah ke bahagian tertentu otak; yang lain ialah MEG (magnetoencephalography), yang boleh mengukur arus elektrik yang dipancarkan oleh saraf masuk; isyarat medan biomagnet yang sangat lemah.

Walau bagaimanapun, kelajuan pengimejan saraf fMRI selalunya sangat perlahan, dengan purata 2 saat untuk menghasilkan gambar (≈0.5 Hz sebagai perbandingan, MEG malah boleh merakam beribu-ribu aktiviti otak sesaat). imej (≈5000 Hz).

Jadi berbanding dengan fMRI, mengapa tidak menggunakan data MEG untuk cuba memulihkan "imej yang dilihat oleh manusia"?

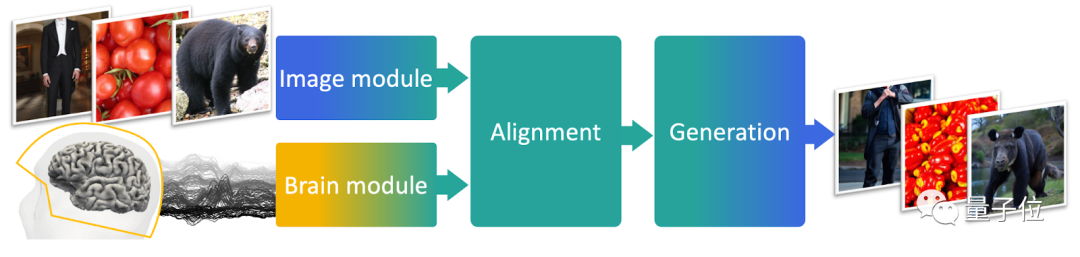

Berdasarkan idea ini, pengarang mereka bentuk model penyahkod MEG, yang terdiri daripada tiga bahagian.

Bahagian pertama ialah model pra-terlatih, bertanggungjawab untuk mendapatkan pembenaman daripada imej; data dengan pembenaman imej;# 🎜🎜#

Bahagian ketiga ialah penjana imej terlatih, bertanggungjawab untuk memulihkan imej akhir. PictureUntuk latihan, penyelidik menggunakan set data yang dipanggil THINGS-MEG, yang mengandungi 4 MEG data yang direkodkan manakala orang muda (2 lelaki dan 2 perempuan, purata umur 23.25 tahun) melihat imej.  Golongan muda ini melihat sejumlah 22,448 imej (1,854 jenis setiap imej dipaparkan selama 0.5 saat dan selang 0.8~1.2 saat daripadanya dilihat berulang kali).

Golongan muda ini melihat sejumlah 22,448 imej (1,854 jenis setiap imej dipaparkan selama 0.5 saat dan selang 0.8~1.2 saat daripadanya dilihat berulang kali).

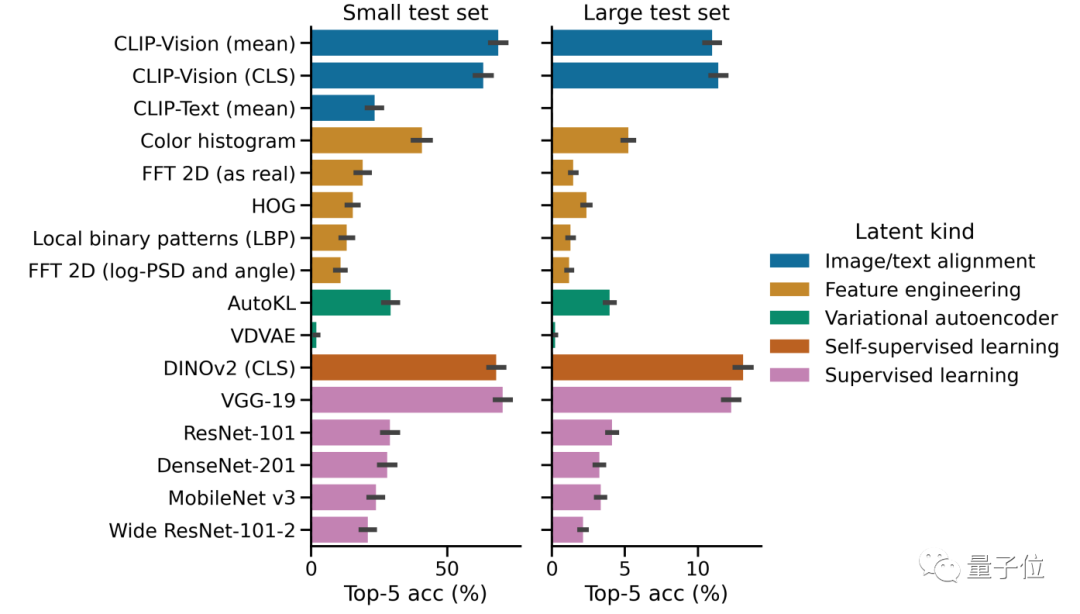

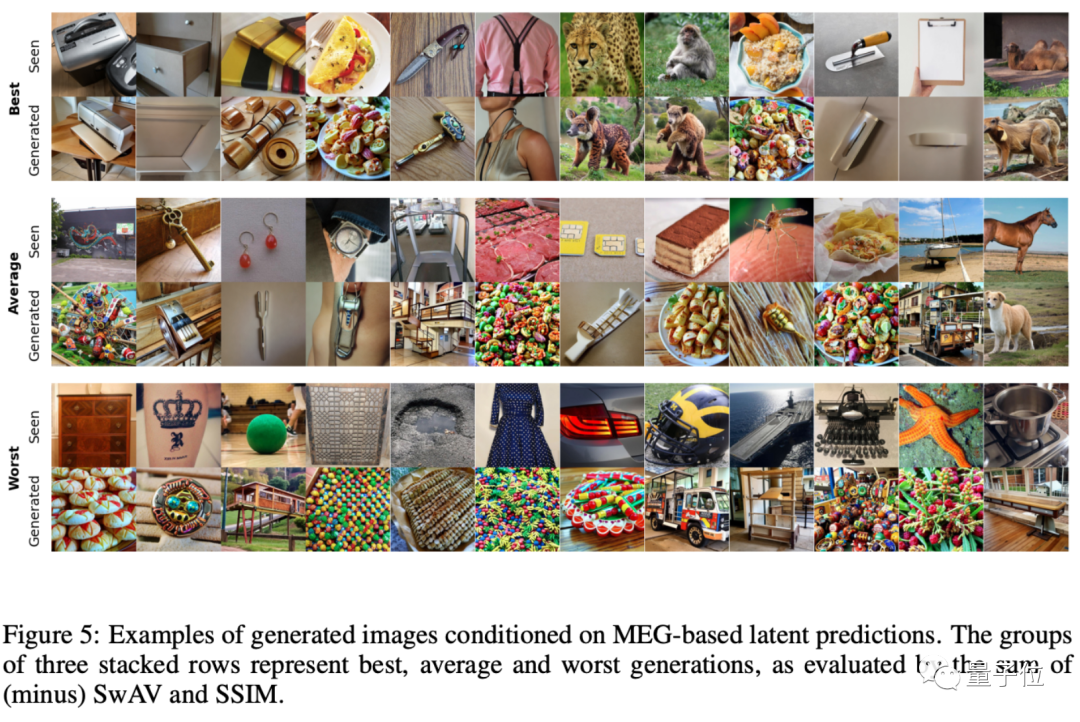

Pengarang membahagikan keseluruhan imej yang dihasilkan kepada tiga kategori, padanan tertinggi, padanan sederhana dan Paling teruk padanan:

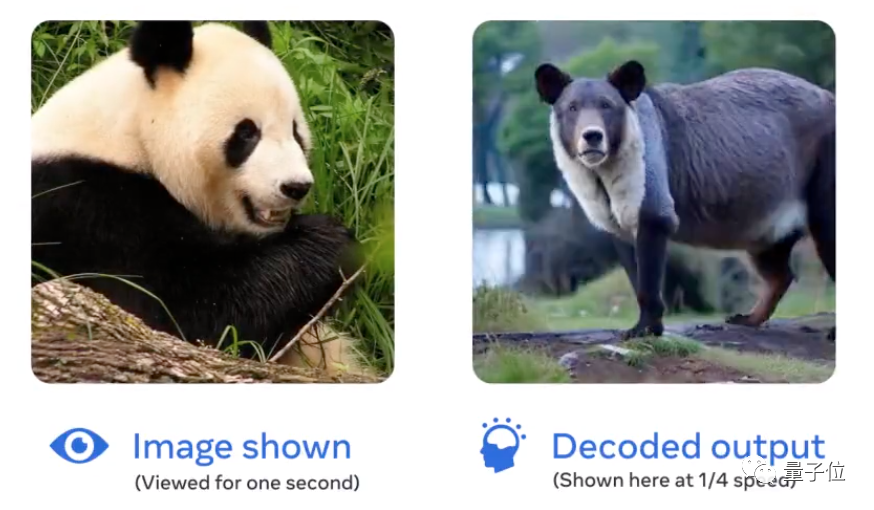

Namun, berdasarkan contoh yang dihasilkan, imej yang dipulihkan oleh AI ini sebenarnya tidak sangat baik.  Malah imej yang paling dipulihkan masih dipersoalkan oleh sesetengah netizen: Mengapa panda itu tidak kelihatan seperti panda?

Malah imej yang paling dipulihkan masih dipersoalkan oleh sesetengah netizen: Mengapa panda itu tidak kelihatan seperti panda?

Penulis berkata: Sekurang-kurangnya seperti beruang hitam putih. (Panda mengamuk!)

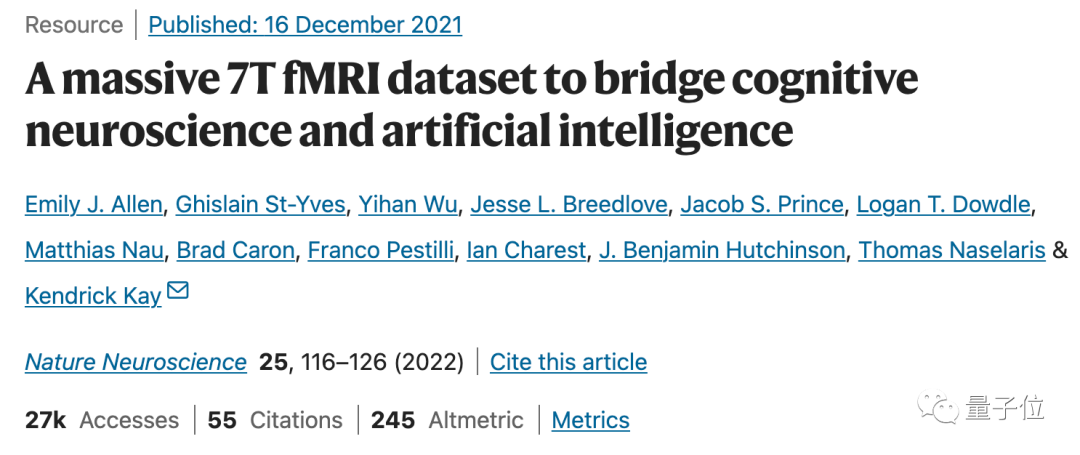

Sudah tentu, penyelidik juga mengakui bahawa kesan imej dipulihkan daripada MEG data memang Ia belum begitu baik, kelebihan utama adalah kelajuan.  Sebagai contoh, kajian terdahulu yang dipanggil 7T fMRI dari Universiti Minnesota dan institusi lain boleh memulihkan imej yang dilihat oleh mata manusia daripada data fMRI dengan tahap pemulihan yang tinggi.

Sebagai contoh, kajian terdahulu yang dipanggil 7T fMRI dari Universiti Minnesota dan institusi lain boleh memulihkan imej yang dilihat oleh mata manusia daripada data fMRI dengan tahap pemulihan yang tinggi.

Gambar

Gambar

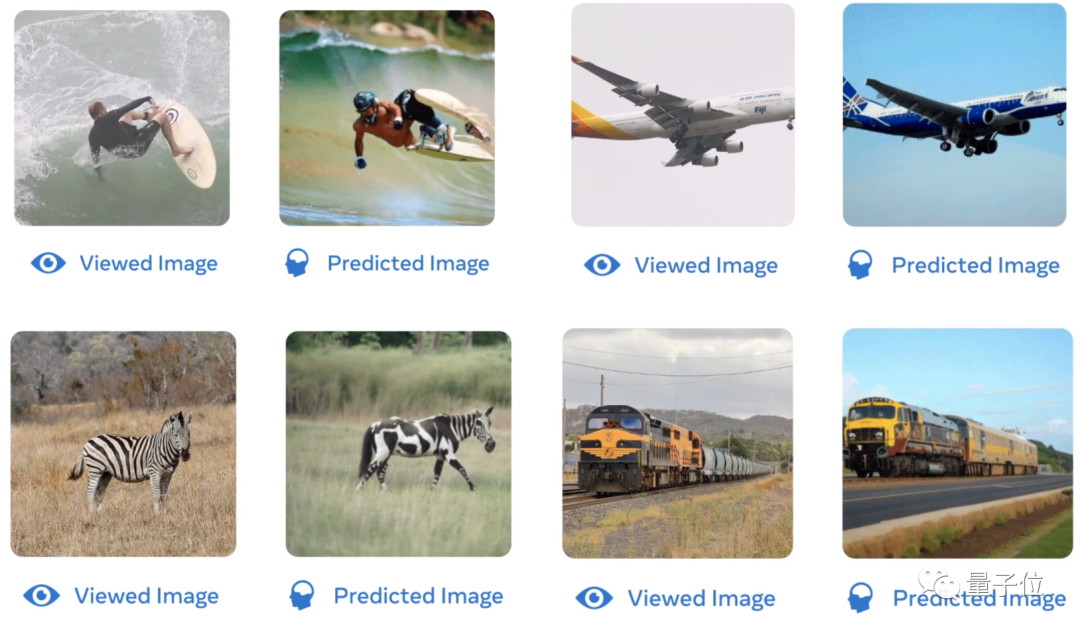

Sama ada pergerakan manusia melayari, bentuk kapal terbang, warna zebra atau latar belakang kereta api, AI yang dilatih berdasarkan data fMRI boleh memulihkan imej dengan lebih baik:

gambar

gambar

//m.sbmmt.com/link/f40723ed94042ea9ea36bfb5ad4157b2

Atas ialah kandungan terperinci AI mentafsir isyarat otak dalam masa nyata dan memulihkan ciri visual utama imej pada kelajuan 7x, dikemukakan oleh LeCun. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Bagaimana untuk mengikat data dalam senarai lungsur

Bagaimana untuk mengikat data dalam senarai lungsur

Bagaimana untuk mendapatkan nombor input dalam java

Bagaimana untuk mendapatkan nombor input dalam java

Douyin tidak boleh memuat turun dan menyimpan video

Douyin tidak boleh memuat turun dan menyimpan video

Apakah peranan pelayan sip

Apakah peranan pelayan sip

lightbox.js

lightbox.js

bios tidak dapat mengesan pemacu keadaan pepejal

bios tidak dapat mengesan pemacu keadaan pepejal

Bagaimanakah cara saya menyediakan WeChat untuk memerlukan persetujuan saya apabila orang menambahkan saya ke kumpulan?

Bagaimanakah cara saya menyediakan WeChat untuk memerlukan persetujuan saya apabila orang menambahkan saya ke kumpulan?

Mongodb dan mysql mudah digunakan dan disyorkan

Mongodb dan mysql mudah digunakan dan disyorkan