Apabila industri terkejut bahawa Baichuan Intelligent mengeluarkan model besar dalam purata 28 hari, syarikat itu tidak berhenti.

Pada sidang akhbar pada petang 6 September, Baichuan Intelligence mengumumkan sumber terbuka rasmi model besar Baichuan-2 yang telah diperhalusi.

Zhang Bo, ahli akademik Akademi Sains China dan dekan kehormat Institut Kecerdasan Buatan Universiti Tsinghua, berada di sidang akhbar.

Zhang Bo, ahli akademik Akademi Sains China dan dekan kehormat Institut Kecerdasan Buatan Universiti Tsinghua, berada di sidang akhbar.

Ini adalah satu lagi keluaran baharu oleh Baichuan sejak keluaran model besar Baichuan-53B pada bulan Ogos. Model sumber terbuka termasuk Baichuan2-7B, Baichuan2-13B, Baichuan2-13B-Chat dan versi terkuantiti 4-bit mereka, dan semuanya percuma dan tersedia secara komersial.

Sebagai tambahan kepada pendedahan penuh model, Baichuan Intelligence juga membuka Sumber Check Point untuk latihan model kali ini, dan menerbitkan laporan teknikal Baichuan 2, yang memperincikan butiran latihan model baharu itu. Wang Xiaochuan, pengasas dan Ketua Pegawai Eksekutif Baichuan Intelligence, menyatakan harapan bahawa langkah ini dapat membantu institusi akademik model besar, pemaju dan pengguna perusahaan memperoleh pemahaman yang mendalam tentang proses latihan model besar, dan lebih menggalakkan pembangunan teknologi model besar penyelidikan akademik dan komuniti.

Baichuan 2 model besar pautan asal: https://github.com/baichuan-inc/Baichuan2

Laporan teknikal: https://cdn.baichuan-ai com /paper/Baichuan2-technical-report.pdf

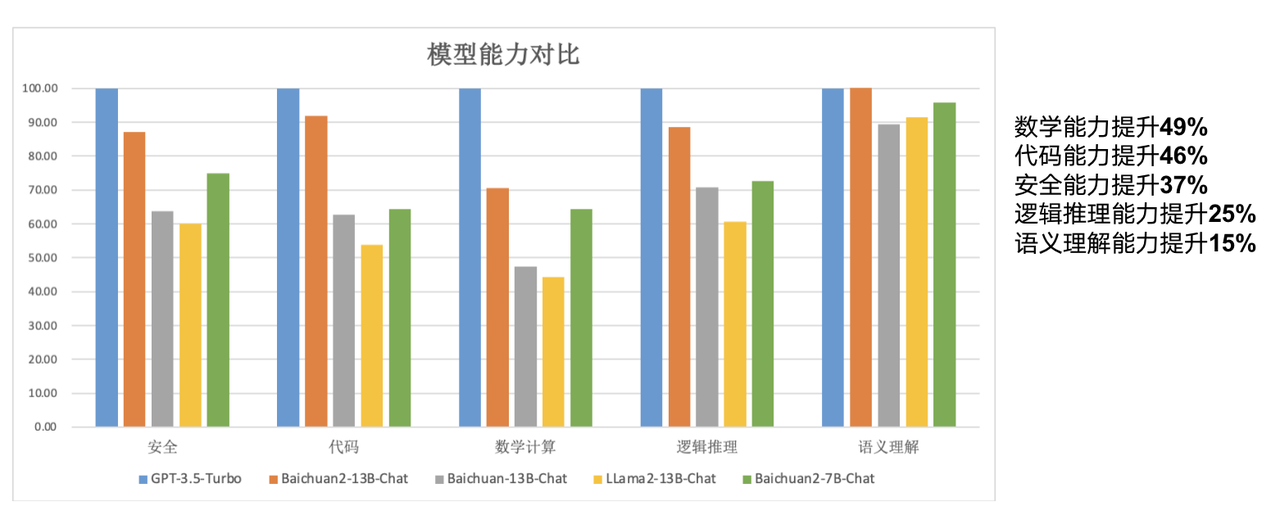

Model sumber terbuka hari ini bersaiz "lebih kecil" berbanding model besar, antaranya Baichuan2-7B-Base dan Baichuan2-13B-Base kedua-duanya berdasarkan 2.6 trilion data berbilang bahasa berkualiti tinggi digunakan untuk latihan Atas dasar mengekalkan keupayaan penjanaan dan penciptaan model sumber terbuka generasi sebelumnya, keupayaan dialog berbilang pusingan yang lancar, dan ambang penggunaan yang rendah, kedua-dua model mempunyai kelebihan yang kukuh dalam. matematik, kod dan sebagainya, keselamatan, penaakulan logik, pemahaman semantik dan kebolehan lain telah dipertingkatkan dengan ketara.

"Ringkasnya, model parameter Baichuan7B 7 bilion sudah setanding dengan model parameter 13 bilion LLaMA2 pada penanda aras Bahasa Inggeris. Oleh itu, kita boleh membuat perbezaan besar dengan model kecil dan kecil model adalah bersamaan dengan keupayaan model yang besar, dan model dengan saiz yang sama boleh mencapai prestasi yang lebih tinggi, secara menyeluruh mengatasi prestasi LLaMA2," kata Wang Xiaochuan.

Berbanding dengan model 13B generasi sebelumnya, Baichuan2-13B-Base mempunyai peningkatan 49% dalam keupayaan matematik, peningkatan 46% dalam keupayaan pengekodan, peningkatan 37% dalam keupayaan keselamatan, peningkatan 25% dalam keupayaan penaakulan logik, dan peningkatan dalam keupayaan pemahaman semantik 15%.

Menurut laporan, pada model baharu itu, penyelidik dari Baichuan Intelligence telah membuat banyak pengoptimuman daripada pemerolehan data kepada penalaan halus.

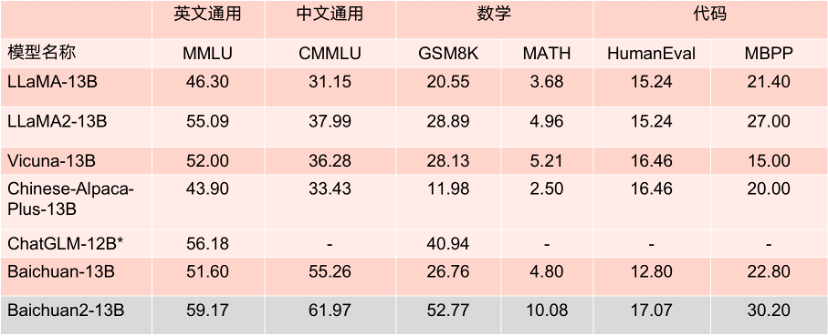

"Kami memperoleh lebih banyak pengalaman daripada carian sebelumnya, menjalankan pemarkahan kualiti kandungan berbutir-butir pada sejumlah besar data latihan model, dan menggunakan 260 juta T tahap korpus untuk melatih model 7B dan 13B. Dan sokongan berbilang bahasa telah ditambah," kata Wang Xiaochuan. "Kami boleh mencapai prestasi latihan sebanyak 180TFLOPS dalam kelompok Qianka A800, dan kadar penggunaan mesin melebihi 50%. Selain itu, kami juga telah menyelesaikan banyak kerja penjajaran keselamatan." Kedua-dua model telah menunjukkan prestasi yang baik pada senarai penilaian utama Dalam beberapa penanda aras penilaian berwibawa seperti MMLU, CMMLU dan GSM8K, mereka mendahului LLaMA2 dengan margin yang besar Berbanding dengan model lain dengan bilangan parameter yang sama, prestasi mereka juga sangat mengagumkan . Prestasinya jauh lebih baik daripada model pesaing LLaMA2 dengan saiz yang sama.

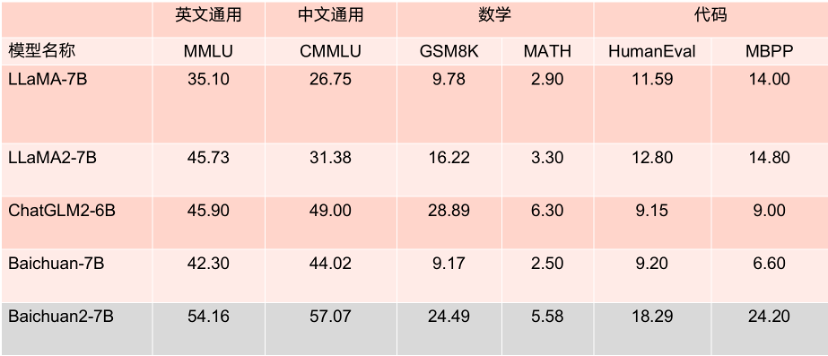

Apa yang lebih patut disebut ialah menurut pelbagai penanda aras penilaian bahasa Inggeris yang berwibawa seperti MMLU, Baichuan2-7B mempunyai 7 bilion parameter pada tahap yang sama dengan LLaMA2 dengan 13 bilion parameter pada tugas bahasa Inggeris arus perdana.

Keputusan penanda aras model parameter 7B.

Keputusan penanda aras model parameter 7B.

Keputusan penanda aras model parameter 13B.

Keputusan penanda aras model parameter 13B.

Baichuan2-7B dan Baichuan2-13B bukan sahaja terbuka sepenuhnya kepada penyelidikan akademik, tetapi pembangun juga boleh menggunakannya secara percuma secara komersial selepas memohon melalui e-mel untuk mendapatkan lesen komersial rasmi.

"Selain keluaran model, kami juga berharap dapat memberikan lebih banyak sokongan kepada bidang akademik," kata Wang Xiaochuan. "Selain laporan teknikal, kami juga telah membuka model parameter berat dalam proses latihan model besar Baichuan2. Ini boleh membantu semua orang memahami pra-latihan, atau melakukan penalaan halus dan peningkatan. Ini juga kali pertama di China bahawa sebuah syarikat telah membuka model seperti proses Latihan "

Latihan model besar termasuk beberapa langkah seperti pemerolehan data besar-besaran berkualiti tinggi, latihan yang stabil bagi kelompok latihan berskala besar dan algoritma model. penalaan. Setiap pautan memerlukan pelaburan sejumlah besar bakat, kuasa pengkomputeran dan sumber lain Kos yang tinggi untuk melatih model sepenuhnya dari awal telah menghalang komuniti akademik daripada menjalankan penyelidikan mendalam tentang latihan model besar.

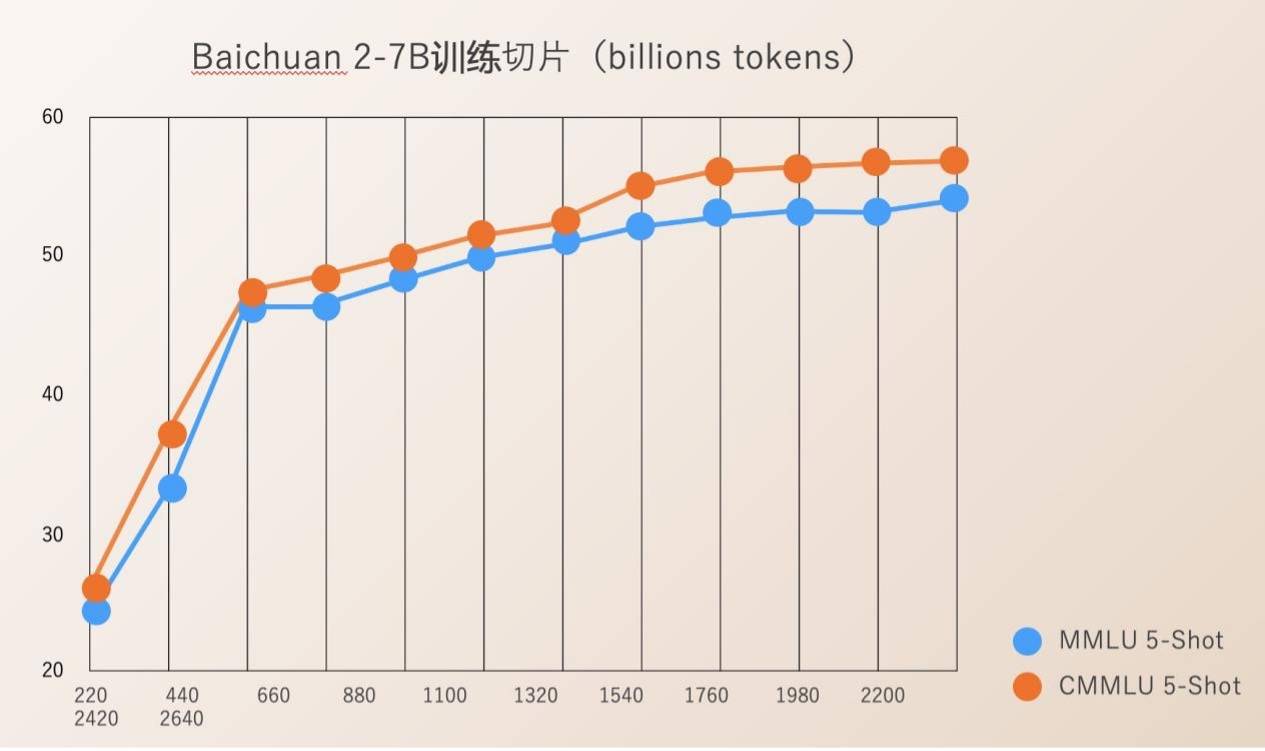

Baichuan Intelligence mempunyai Check Ponit sumber terbuka untuk keseluruhan proses latihan model dari 220B hingga 2640B. Ini amat bernilai bagi institusi penyelidikan saintifik untuk mengkaji proses latihan model besar, latihan model berterusan dan penjajaran nilai model, dsb., dan boleh menggalakkan kemajuan penyelidikan saintifik model besar domestik.

Sebelum ini, kebanyakan model sumber terbuka hanya mendedahkan berat model mereka sendiri dan jarang menyebut butiran latihan Pembangun hanya boleh melakukan penalaan halus yang terhad, menjadikannya sukar untuk menjalankan penyelidikan yang mendalam.

Laporan teknikal Baichuan 2 yang diterbitkan oleh Baichuan Intelligence memperincikan keseluruhan proses latihan Baichuan 2, termasuk pemprosesan data, pengoptimuman struktur model, undang-undang penskalaan, penunjuk proses, dsb.

Sejak penubuhannya, Baichuan Intelligence menganggap mempromosikan kemakmuran model besar ekologi China melalui sumber terbuka sebagai hala tuju pembangunan penting syarikat. Kurang daripada empat bulan selepas penubuhannya, ia telah mengeluarkan dua model besar Cina komersial percuma sumber terbuka, Baichuan-7B dan Baichuan-13B, serta model besar yang dipertingkatkan carian Baichuan-53B Kedua-dua model besar sumber terbuka telah dinilai dalam banyak ulasan berwibawa Ia berada pada kedudukan tinggi dalam senarai dan telah dimuat turun lebih daripada 5 juta kali.

Minggu lepas, pelancaran kumpulan pertama fotografi perkhidmatan awam model berskala besar merupakan berita penting dalam bidang teknologi. Antara syarikat model besar yang diasaskan tahun ini, Baichuan Intelligent adalah satu-satunya yang telah didaftarkan di bawah "Langkah Interim untuk Pengurusan Perkhidmatan Kepintaran Buatan Generatif" dan secara rasmi boleh menyediakan perkhidmatan kepada orang ramai.

Dengan keupayaan R&D model besar asas peneraju industri dan keupayaan inovasi, kedua-dua model besar Baichuan 2 sumber terbuka kali ini telah menerima respons positif daripada perusahaan huluan dan hiliran, termasuk Tencent Cloud, Alibaba Cloud, Volcano Ark, Huawei, MediaTek dan banyak lagi perusahaan terkenal Semua mengambil bahagian dalam persidangan ini dan mencapai kerjasama dengan Baichuan Intelligence. Menurut laporan, jumlah muat turun model besar Baichuan Intelligence pada Hugging Face telah mencecah 3.37 juta pada bulan lalu.

Menurut rancangan Baichuan Intelligence sebelum ini, tahun ini mereka akan mengeluarkan model besar dengan ratusan bilion parameter dan melancarkan "aplikasi super" pada suku pertama tahun depan.

Atas ialah kandungan terperinci Baichuan Intelligent mengeluarkan model besar Baichuan2: ia mendahului sepenuhnya daripada Llama2, dan bahagian latihan juga adalah sumber terbuka. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Sebab mengapa phpstudy tidak boleh dibuka

Sebab mengapa phpstudy tidak boleh dibuka

Platform manakah yang lebih baik untuk perdagangan mata wang maya?

Platform manakah yang lebih baik untuk perdagangan mata wang maya?

504 Gateway Tamat masa

504 Gateway Tamat masa

Apakah sebenarnya syiling fil?

Apakah sebenarnya syiling fil?

Bagaimana untuk menetapkan sempadan bertitik css

Bagaimana untuk menetapkan sempadan bertitik css

Bagaimana untuk membuka fail mobi

Bagaimana untuk membuka fail mobi

kekunci pintasan baldi cat ps

kekunci pintasan baldi cat ps

Cara menggunakan pangkalan data ucsc

Cara menggunakan pangkalan data ucsc