Kaedah pra-latihan berbilang mod juga telah membawa kepada pembangunan pembelajaran perwakilan 3D dengan menjajarkan bentuk 3D, gambar 2D dan huraian bahasa yang sepadan.

Walau bagaimanapun, rangka kerja pra-latihan pelbagai mod yang sedia ada kurang berskala dalam kaedah pengumpulan data , yang sangat mengehadkan potensi pembelajaran pelbagai mod, antaranya paling Halangan utama terletak pada skalabiliti dan kelengkapan modaliti bahasa.

Baru-baru ini, Salesforce AI bergabung tenaga dengan Universiti Stanford dan Universiti Texas di Austin untuk mengeluarkan projek ULIP (CVP R2023) dan ULIP-2, yang menerajui lembaran baharu dalam 3D persefahaman.

Pautan kertas: https://arxiv.org/pdf/2212.05171.pdf

Pautan kertas: https://arxiv.org/pdf/2305.08275.pdf

Pautan kod: https: //github.com/salesforce/ULIP

Para penyelidik mengambil pendekatan unik dengan melatih pra-latihan model menggunakan awan titik 3D, imej dan teks, menjajarkannya ke A unified ruang ciri. Pendekatan ini mencapai keputusan terkini dalam tugas pengelasan 3D dan membuka kemungkinan baharu untuk tugas merentas domain seperti pengambilan imej-ke-3D.

Dan ULIP-2 menjadikan pra-latihan berbilang modal ini boleh dilakukan tanpa sebarang anotasi manual, dengan itu boleh berskala pada skala besar.

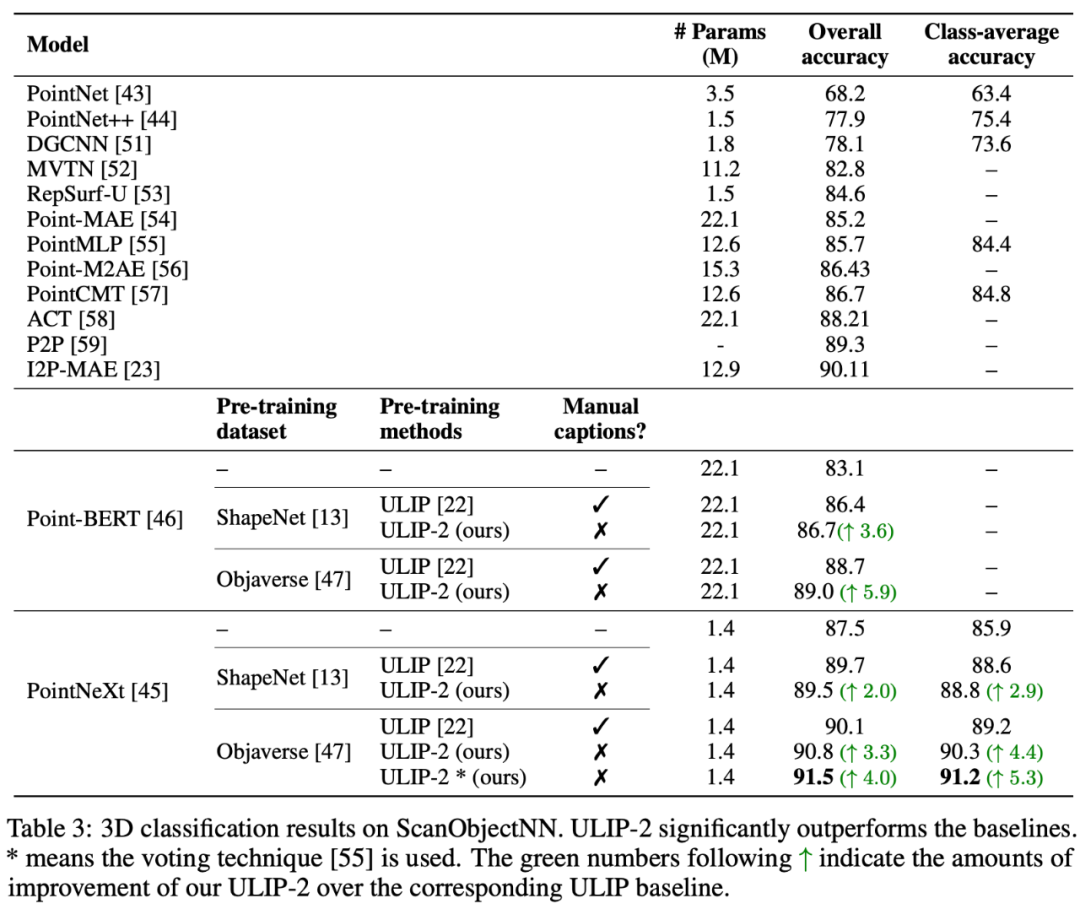

ULIP-2 telah mencapai peningkatan prestasi yang ketara dalam klasifikasi tangkapan sifar hiliran ModelNet40, mencapai ketepatan tertinggi 74.0% pada penanda aras ScanObjectNN dunia sebenar, hanya 1.4 juta sahaja digunakan Ketepatan keseluruhan 91.5% dicapai dengan hanya satu parameter, menandakan kejayaan dalam pembelajaran perwakilan 3D multimodal berskala tanpa memerlukan anotasi 3D manusia.

Gambar rajah skema rangka kerja pra-latihan untuk menjajarkan ketiga-tiga ciri ini (3D, imej , teks)

Kod dan set data tri-modal berskala besar yang dikeluarkan ("ULIP - Objaverse Triplets" dan "ULIP - ShapeNet Triplets") telah menjadi sumber terbuka .

Latar BelakangPemahaman 3D ialah bahagian penting dalam bidang kecerdasan buatan, yang membolehkan mesin melihat dan berinteraksi dalam ruang tiga dimensi seperti manusia. Keupayaan ini mempunyai aplikasi penting dalam bidang seperti kenderaan autonomi, robotik, realiti maya dan realiti tambahan.

Walau bagaimanapun, pemahaman 3D telah menghadapi cabaran besar disebabkan oleh kerumitan pemprosesan dan tafsiran data 3D, serta kos mengumpul dan menganotasi data 3D.

Rangka kerja pra-latihan trimodal dan tugas hilirannya

ULIP (sudah diterima oleh CVPR2023) menggunakan pendekatan unik untuk pralatih model menggunakan awan titik 3D, imej dan teks, menjajarkannya ke dalam ruang perwakilan bersatu .

Pendekatan ini mencapai hasil terkini dalam tugas pengelasan 3D dan membuka kemungkinan baharu untuk tugas merentas domain seperti pengambilan semula imej-ke-3D.

Kunci kejayaan ULIP ialah penggunaan pengekod imej dan teks yang diprajajarkan, seperti CLIP, yang dilatih terlebih dahulu pada sebilangan besar pasangan teks imej.

Pengekod ini menjajarkan ciri tiga modaliti ke dalam ruang perwakilan bersatu, membolehkan model memahami dan mengelaskan objek 3D dengan lebih berkesan.

Pembelajaran perwakilan 3D yang dipertingkatkan ini bukan sahaja meningkatkan pemahaman model tentang data 3D, tetapi juga mendayakan aplikasi rentas mod seperti pengelasan 3D tangkapan sifar dan perolehan semula imej-ke-3D kerana pengekod 3D memperoleh konteks Multimodal.

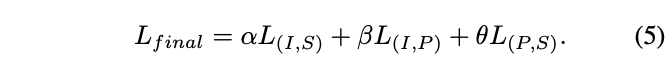

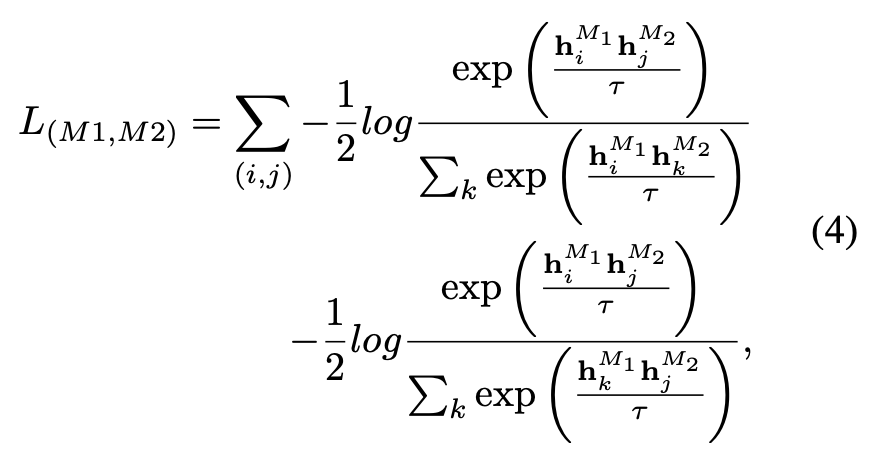

Fungsi kehilangan pra-latihan ULIP adalah seperti berikut:

Dalam tetapan lalai ULIP, α ditetapkan kepada 0, β dan θ ditetapkan kepada 1, dan fungsi kehilangan pembelajaran kontrastif antara setiap dua mod ditakrifkan seperti berikut, di mana M1 dan M2 merujuk kepada mana-mana dua mod antara tiga mod:

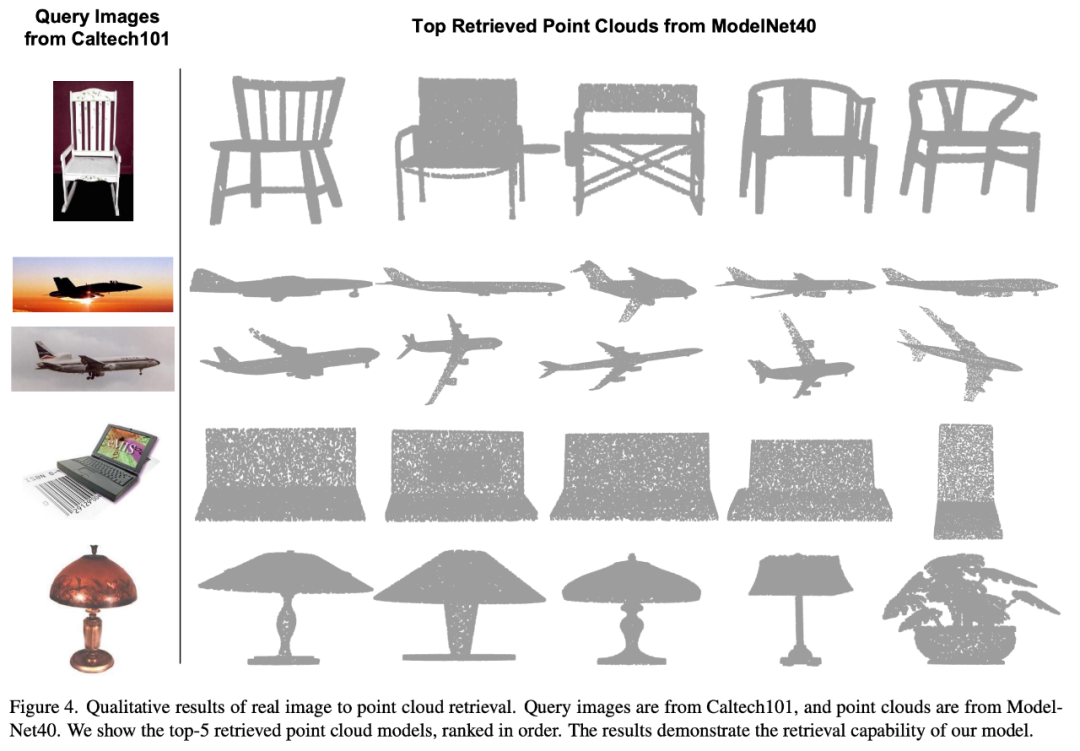

ULIP juga menjalankan eksperimen untuk mendapatkan semula daripada imej kepada 3D, dan hasilnya adalah seperti berikut:

Hasil percubaan menunjukkan bahawa model pra-latihan ULIP telah dapat mempelajari ciri berbilang modal yang bermakna antara imej dan awan titik 3D.

Anehnya, berbanding model 3D yang diperoleh semula yang lain, model 3D yang diperoleh semula pertama mempunyai rupa yang paling hampir dengan imej pertanyaan.

Contohnya, apabila kita menggunakan imej daripada jenis pesawat yang berbeza (pejuang dan pesawat) untuk mendapatkan semula (baris kedua dan ketiga), awan titik 3D terdekat yang diambil kekal Perbezaan halus dalam imej pertanyaan adalah terpelihara.

Berikut ialah objek 3D yang menjana teks berbilang sudut huraian Contoh. Kami mula-mula menjadikan objek 3D kepada imej 2D daripada satu set paparan, dan kemudian menggunakan model berbilang modal yang besar untuk menjana penerangan bagi semua imej yang dijana

ULIP-2 dalam ULIP Pada asasnya, gunakan model berbilang modal berskala besar untuk menjana penerangan bahasa sepadan yang menyeluruh untuk objek 3D, dengan itu mengumpul data pra-latihan berbilang mod berskala tanpa sebarang anotasi manual, menjadikan proses pra-latihan dan model terlatih lebih cekap dan dipertingkatkan kebolehsuaiannya.

Kaedah ULIP-2 termasuk menjana huraian bahasa berbilang sudut dan berbeza untuk setiap objek 3D, dan kemudian menggunakan penerangan ini untuk melatih model, supaya objek 3D, imej 2D, dan huraian bahasa boleh Penjajaran ruang ciri adalah konsisten.

Rangka kerja ini membolehkan penciptaan set data tri-modal yang besar tanpa anotasi manual, dengan itu menggunakan sepenuhnya potensi pra-latihan berbilang modal.

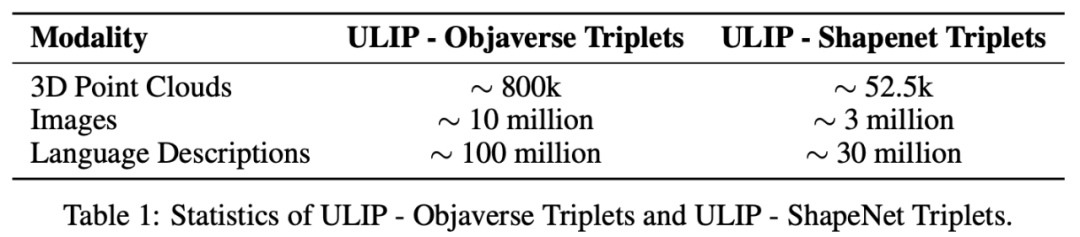

ULIP-2 juga mengeluarkan set data tiga mod berskala besar yang dijana: "ULIP - Objaverse Triplets" dan "ULIP - ShapeNet Triplets".

Sesetengah data statistik bagi dua set data tri-modal

Siri ULIP telah mencapai hasil yang menakjubkan dalam tugasan hiliran berbilang mod dan eksperimen penalaan halus pada ekspresi 3D, khususnya, pra-latihan dalam ULIP-2 boleh dicapai tanpa sebarang anotasi manual.

ULIP-2 mencapai peningkatan yang ketara (74.0% ketepatan 1 teratas) dalam tugas pengelasan sifar pukulan hiliran ModelNet40 dalam penanda aras ScanObjectNN dunia sebenar, ia mencapai ketepatan keseluruhan sebanyak 91.5% dicapai dengan hanya 1.4M parameter, menandakan kejayaan dalam pembelajaran perwakilan 3D berbilang mod berskala tanpa memerlukan anotasi 3D manual.

Kedua-dua kertas kerja menjalankan eksperimen ablasi terperinci.

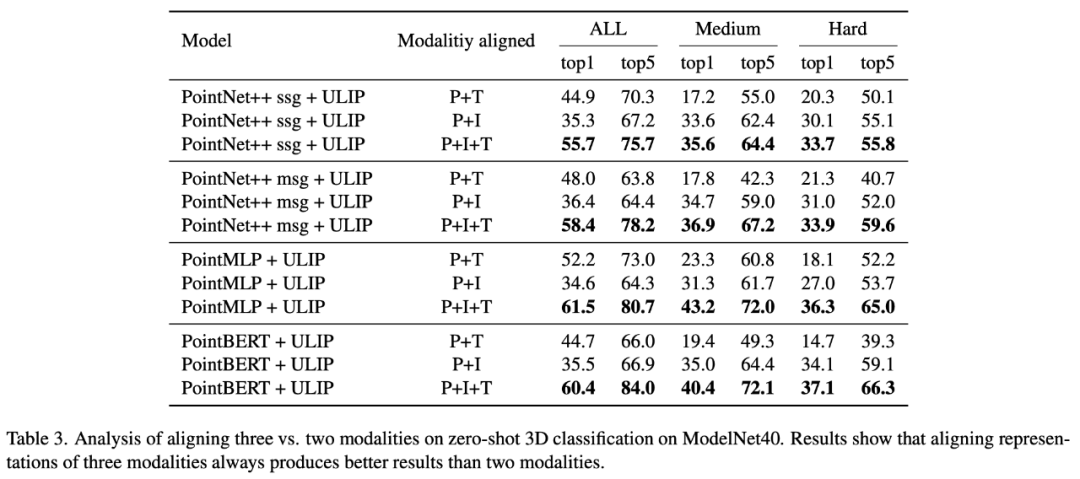

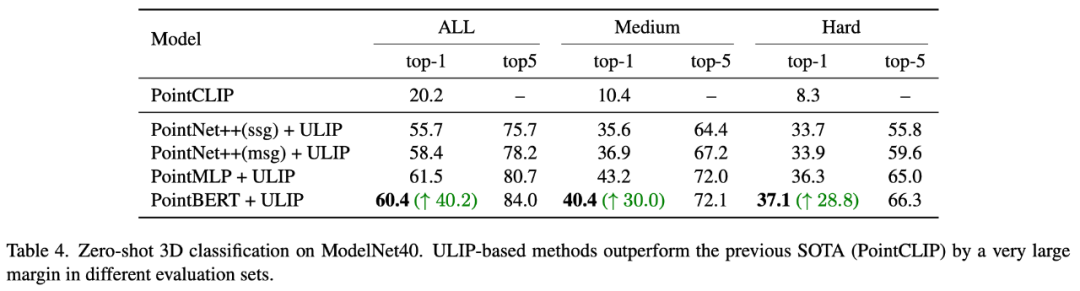

Dalam "ULIP: Mempelajari Perwakilan Bersatu Bahasa, Imej dan Awan Titik untuk Pemahaman 3D", memandangkan rangka kerja pra-latihan ULIP melibatkan penyertaan tiga modaliti, pengarang menggunakan eksperimen untuk meneroka sama ada ia adakah lebih baik untuk menjajarkan dua daripada mod atau menjajarkan ketiga-tiga mod Hasil percubaan adalah seperti berikut:

Seperti yang dapat dilihat daripada keputusan eksperimen, Dalam tulang belakang 3D yang berbeza, menjajarkan tiga modaliti adalah lebih baik daripada menjajarkan hanya dua modaliti, yang juga membuktikan rasionaliti rangka kerja pra-latihan ULIP.

Dalam "ULIP-2: Ke Arah Pra-latihan Multimodal Boleh Skala untuk Pemahaman 3D", penulis meneroka kesan model multimodal berskala besar yang berbeza pada rangka kerja pra-latihan adalah seperti berikut:

Hasil eksperimen dapat dilihat bahawa kesan pra-latihan rangka kerja ULIP-2 boleh dinaik taraf dengan penggunaan besar -model berbilang modal berskala Dan promosi mempunyai tahap pertumbuhan tertentu.

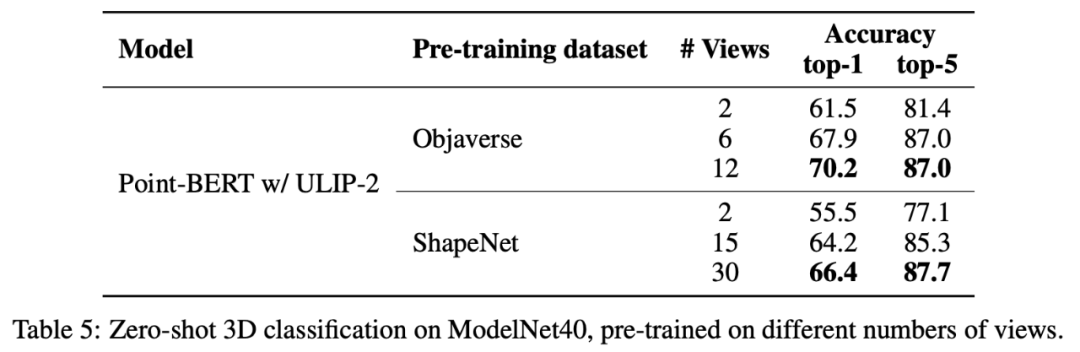

Dalam ULIP-2, penulis juga meneroka cara menggunakan bilangan paparan yang berbeza untuk menjana set data tri-modal akan mempengaruhi prestasi pra-latihan keseluruhan Hasil percubaan adalah seperti berikut :

Keputusan eksperimen menunjukkan bahawa apabila bilangan tontonan yang digunakan meningkat, kesan klasifikasi sifar tangkapan model pra-latihan juga akan bertambah.

Ini juga menyokong perkara dalam ULIP-2 bahawa huraian bahasa yang lebih komprehensif dan pelbagai akan memberi kesan positif pada pra-latihan pelbagai mod.

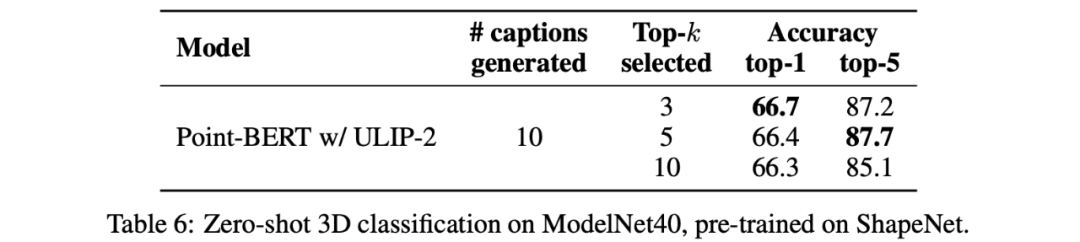

Di samping itu, ULIP-2 turut meneroka kesan penerangan bahasa bagi pelbagai jenis topk yang disusun mengikut CLIP pada pra-latihan berbilang modal Keputusan eksperimen adalah seperti berikut:

Hasil percubaan menunjukkan bahawa rangka kerja ULIP-2 mempunyai tahap keteguhan tertentu kepada topk yang berbeza digunakan sebagai tetapan lalai dalam kertas.

Projek ULIP (CVPR2023) dan ULIP-2 yang dikeluarkan bersama oleh Salesforce AI, Stanford University dan University of Texas di Austin sedang mengubah bidang Pemahaman 3D.

ULIP menjajarkan modaliti yang berbeza ke dalam ruang bersatu, mempertingkatkan pembelajaran ciri 3D dan mendayakan aplikasi rentas mod.

ULIP-2 telah dibangunkan lagi untuk menjana penerangan bahasa keseluruhan untuk objek 3D, mencipta dan membuka sumber sejumlah besar set data tiga mod, dan proses ini tidak memerlukan anotasi manual .

Projek ini menetapkan penanda aras baharu dalam pemahaman 3D, membuka jalan untuk masa depan di mana mesin benar-benar memahami dunia tiga dimensi kita.

Salesforce AI:

Le Xue (蛛乐), Mingfei Gao (高明飞), Chen Xing (Xingchen), Ning Yu (Yu Ning), Shu Zhang (张捍), Junnan Li (李君男), Caiming Xiong (Xiong Caiming), Ran Xu (Xu Ran), Juan Carlos niebles, Silvio Savarese.

Stanford University:

Prof. Silvio Savarese, Prof. Juan Carlos Niebles, Prof. Jiajun Wu(Wu Jiajun).

UT Austin:

Prof.

Atas ialah kandungan terperinci Tidak perlu melabel data, 'pemahaman 3D' memasuki era pra-latihan pelbagai modal! Siri ULIP adalah sumber terbuka sepenuhnya dan menyegarkan SOTA. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Apa yang perlu dilakukan jika fail chm tidak boleh dibuka

Apa yang perlu dilakukan jika fail chm tidak boleh dibuka

ubah suai ip

ubah suai ip

Cara menyelesaikan operasi tamat masa

Cara menyelesaikan operasi tamat masa

sistem Hongmeng

sistem Hongmeng

Bahasa apakah yang biasanya digunakan untuk menulis vscode?

Bahasa apakah yang biasanya digunakan untuk menulis vscode?

Apakah jenama telefon bimbit Nubia?

Apakah jenama telefon bimbit Nubia?

Bagaimana untuk menyelesaikan masalah yang tidak dapat disambungkan oleh teamviewer

Bagaimana untuk menyelesaikan masalah yang tidak dapat disambungkan oleh teamviewer

msvcp140.dll

msvcp140.dll